VR研究者の卵からみたprompt αU

特段読まなくてもよい前口上

こんにちは!初めましての人は初めまして。

個人での記事を久しぶりに書きます。

prompt αUに行ってきたので、今回は観測者兼VRを専門にするものとしてレビューしていきたいと思います。

できるだけ専門用語を使わずに平易に書いていこうと思います。ある程度の正確性や厳密性は落ちる可能性があることをご了承ください(訳:強い人は刺さないで)。

また、旅行直前に凸ったので20分くらいしかいられず恐らく見落としや勘違いがあるかもしれません。電車を間違えてバスを逃して集合場所まで全力疾走したのはまた別のお話….(28日に再び渋谷を訪れて4時間くらいかけてゆっくり周れました)

軽く自己紹介

VRの専門家とか書いておいてお前誰やねんと99%の人は思っていそうなので軽く自己紹介させてください。そんなの興味ねえという方は読み飛ばしてください。

2017年くらいからVTuberとVRの話題を追っていて、趣味と大学とインターンでVR/AR/MR関係の研究や開発をやっています。

今回のpromptの趣旨と同じですね(R&D=Research&Development=研究開発)。専門はバーチャルリアリティ、コンピュータグラフィックス、対話エージェントなどですが、これ以上細かく言うと身バレ、本名バレするのでこれくらいでw

花譜3rd ONE-MAN LIVE「不可解参(狂)」の時には有志によるフラスタ企画のAR部分のディレクションとプログラミングを担当しました。(noteのサムネも同じ技術で撮影しました)

#花譜#不可解参狂ファンアート pic.twitter.com/akmnWwTxBn

— lain (@lain_xr) August 24, 2022

また、5月にも連名で何か出るかも…

色んなデバイスをいじるのも好きで、Hololens2,Meta Quest2,LeapMotion,mocopiなどで遊んだり開発したりしてます。

あとはノリで上級VR技術者の資格を持っていたりします。(情報学徒/工学徒からしたらそこまで難しい試験ではないです。昔記事を書いたので興味ある人はどうぞ)

イベントでVRコンテンツやゲームの展示やアテンドもしたことがあるので、その辺の観点からもレビューしていきます。

長くなってしまいましたが、まあ一言でいうと多少はアカデミックにxRを語れるということです。

αUとは

そもそもprompt αUとは何でしょうか。今回はpromptのレビュー記事なので軽い解説にとどめますが、NFTやメタバースなど近年取り沙汰されるいくつかの技術を複数の企業が協力して提供していく、いくつかのサービスの総称のようです。詳しくはこの記事やこの動画をご覧ください。

KDDIの担当者がたまたま観測者だったために、実験的にαUの俎上に神椿IPを載せて、ちょっとだけインタラクティブ性(コンテンツと相互に反応があること。簡単なものだとボタンを押すと何かが起こるのもインタラクティブ)を付与した展覧会のようなものを開催したという流れのようです。

昨今の多くのVのライブやαUではリアル×バーチャルを謡っていますが、そもそも「バーチャル」と「リアル」は対立構造ではなく、むしろ相補的かつ(包含的ですらある)将来的に互いに融けあいその境界が薄れるべき概念であるので、ちゃんと言葉を使ってほしいなと思っていたりします。(研究者は言葉の使い方にうるさいのです)。

この辺の細かい話はいつかに譲るとして、VR学会の説明がとても良いのでVTuberに興味がある全人類は読んでほしいです。

prompt αU解説&レビュー

ここからはこの目で見てきた現地で使われていた技術を軽く解説しながら、感想を織り交ぜていこうと思います。※感想は個人のものであり所属団体の見解ではありません。(とりあえず保険を掛けておく)

基本的には動線順で書いていきます。

会期終了直前ではありますがめちゃくちゃネタバレを含みますことご注意ください。また会場は映像撮影禁止なので文字と画像だけでは十分に情報を伝えられないので気になった方はご自身で会場に足を運んでみましょう。3/31までが会期です。

2F AR illustration

エスカレーターで2回に上がるとまずは不可解参(想)やSingularity Liveなど今までのライブ映像がお出迎えします。映像自体にはと特段特別なことはありませんが、懐かしさがこみ上げてきます。

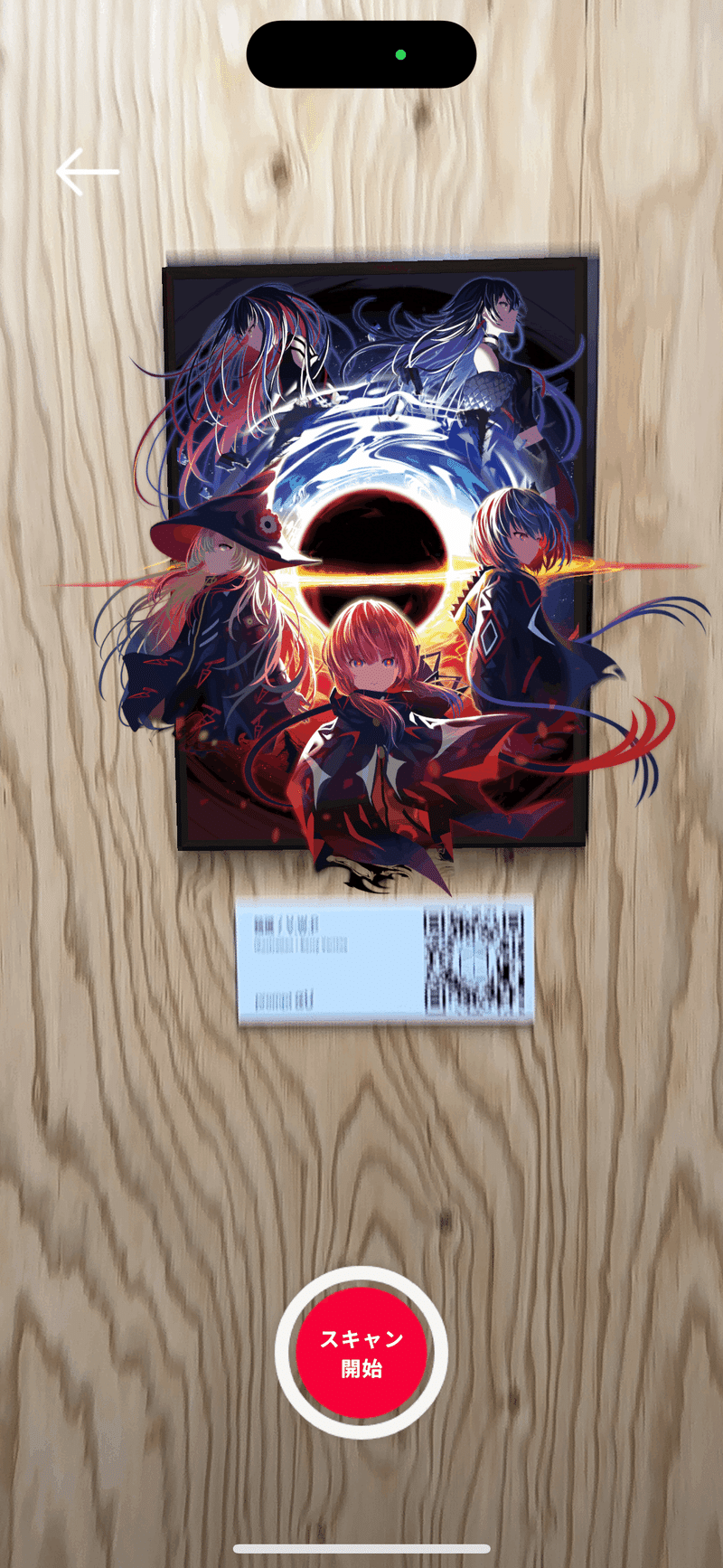

正面や左手に目を向けるとずらっと額縁に入ったイラストが並んでいます。イラストの下にはQRコードが添えられており、HoloModelsというアプリを通して手持ちのスマホを通してARコンテンツが楽しめるものでした。

実装は意外とシンプルでイラストの上にCGのイラストを重ねて泡など一部を動かしていました。イラストはいくつかのレイヤに分かれており、一部のレイヤーが動いていました。神椿関連で似たようなARコンテンツは実はあり、不可解参(狂)の別冊パンフではCOCOARというアプリをインストールしてイラストの特定の場所にスマホをかざすと画像が見られるというものです。

そのどちらもマーカを読み取ってコンテンツを重畳(重ね合わせる)させるマーカ型に分類されます。(ちなみに位置情報をARコンテンツ表示のトリガーとするロケーションベースARというものもあります。マーカ型よりは若干精度低め)。一度QRコードを読み取ったらQRコードを隠してもCGが表示され続けていたので一度素材をロードしたら相対位置を保ち続けるという実装のようです。10mくらい離れて見て見てもほぼ位置ずれせず表示されていたのはすごかったです。

現地(パンフのARもそうですが)のARの感想ですが、最初は「おぉ」となるものの、イラストの上に同じイラストを平面的に重ねているだけなので多角的な見方ができなくて少しもどかしかったです。3Dモデルをアニメ―ションさせろとまでは言いませんが、もう少し立体的に作るなり、イラストとは別の要素を表示させるなり、ARならではの体験が欲しかったです。そもそもイラストは額縁に入っていますが、ARは額というフレームにとらわれる必要はなく、例えばキャラクタが額から出てきている瞬間や、額の外に出ている瞬間、額を破壊する瞬間などを切り取ってみても面白そうです。

(28日追記:輪廻の円環などは枠を超えていてよかったです)

ただHolomodelだとそこまでの表現は難しいので無難に3Dモデルを置くのがよさそうですが、それだと後述のMRコンテンツと被りそうで難しいところではあります。

Digital Figure MR

何やら真っ白で台がいくつか置かれた部屋にはスタッフ数人とたくさんデバイスが鎮座していました。

おもむろにデバイスを装着すると、真っ白な空間に神椿市の風景が広がります。奥にはラプラスと魔女の姿が…(私が見た時は春ちゃんがいました)

(28日追記:メチ以外見られました✌)

prompt αU好評開催中!

— KAMITSUBAKI STUDIO (@kamitsubaki_jp) March 18, 2023

MRエリアで観覧できるヘッドセットゴーグル着用時のイメージ画像を公開。展覧会用にデザインされたデジタルフィギュアとらぷらす、そしてV.W.Pメンバーはランダムに出現。壁の外には神椿市が広がっております。

▼チケット販売はこちらhttps://t.co/G5jJYzPRHG#prompt_αU pic.twitter.com/UTy0OORifT

こちらはMeta社のMeta Quest Proというデバイスでなんと1台15万円以上もします(最近まで20万円以上だった)。

Quest ProはOculus QuestやHTC ViveのようにフルCGのVR空間に没入することもできますし、後述のNreal AirシリーズのようにAR表現もできます。カメラを通して外界の景色を見るため、ビデオシースルー方式に分類されます。(Hololensなどの直接光線を制御して結像させる方式は光学シースルー方式に分類されます)。

ちなみにそもそもMRはMixed Reality(複合現実)の略でARとVRの中間のような位置づけです。厳密な定義はありませんが、物理的な世界とデジタルな世界が融合するような表現にしばしば用いられます。

今回はQuest Proを通してどこかに存在する神椿市を覗くことができました。壁にいた狼みたいな動物(元ネタわからないけどResident Genesis関連なのかな)やラプラスはアニメーションしていて本当にそこに存在している感じがしました。

ただ突っ立って観察するのではなく、そこそこ広い空間を実際に歩き回れるのがよかったです。「穴」を通して異世界の広がりを感じさせるのもよかったです。

メタな話をすると10台くらいデバイスを用意することで充電しているデバイスと稼働させているデバイスでひっきりなしに来客を回せそうのがよさそうでした。

(細かいことを言うとラプラスが飛び回っていたり、魔女がもう少し動いていたらもっとよかったけど、そこまですると実在感高すぎて一生現実世界に返ってこられなさそう。)

最初訪れた時は気づかなかったんですが、魔女たちはこちらの方向に少し顔を向けてくれるんですね。Quest Proではアイトラッキングとフェイストラッキングができるので体験者の位置を目の位置から推定してそこに顔を向けさせるという実装をしていると思われます。姿勢がガチガチに固まった人形ではなく少しでも動きがあることで没入感や臨場感が段違いです。また彼女らが等身大で設置されていることで身長や質感が分かって楽しかったです。花譜ちゃんとジョチョシちっちゃいなとか、幸祜さんの髪つよそうとか。

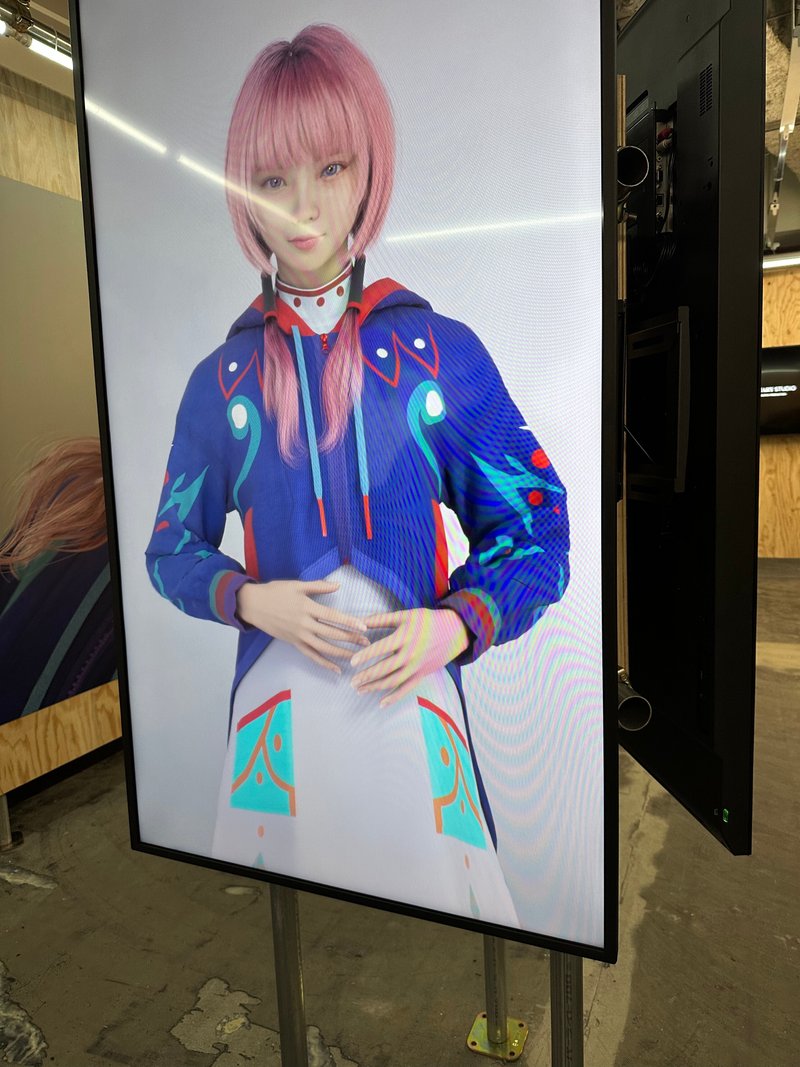

Virtual Human

花譜やte'resaをバーチャルヒューマン化したら?というコンセプトの展示です。どうやらte'resaの方は同位体のような存在のteresaAIとオリジンとして活動するELENAという2つの存在に分化し活動していくようですね。賛否両論ありますが、とりあえずは活動が終了せず良かったです。

バーチャルヒューマンは、デジタルヒューマンとも呼ばれ3DCGで作られた人間のことを言います。2019年に紅白で美空ひばりさんのAIが出演したり、ゲームエンジンであるUNREAL ENGINE(EPIC)がMetaHumanを発表したりして大きな話題となりました。バーチャルヒューマンは実在する人物を基にすることもありますし、実在しない人物を作り上げることもあります。

演者が存在することが多いVTuberとは違い、バーチャルヒューマンは自然言語処理を用いた対話システムを使った案内用エージェントやプロモーションなど実生活に近い存在としてよく起用されています。

こちらは推測ですが、KDDIはcohというバーチャルヒューマンプロジェクトを展開しておりその俎上に花譜やte'resaを載せているのではないかと思っています。

前述のとおり、プロモーション、ゲーム、映像、対話エージェント、歌唱とあらゆることに活用されているバーチャルヒューマンですが、今後神椿がどう展開していくのか楽しみです。神椿のアーティストはte'resaを除いてフォトリアルというより、アニメ調のルックであるし、バーチャルヒューマンはAIの文脈に乗せられることが多いので魔女たちをバーチャルヒューマンとして活動させるとなったらどう展開していくのか見ものです。恐らくその為のPoC(概念実証)が今回の展示なのでしょう。

AIという文脈に則れば可不などの同位体の方がバーチャルヒューマンとの親和性が高そうです。

展示会の案内をしてくれる可不や、スマホに常駐していてsiriのように会話をしてくれる狐子をいつか見て見たいですね。

KAMITSUBAKI VERSE

※RESIDENT GENESISについては全貌を把握しきれていないため書きません。というか書けません(誰か代わりに書いてくれてもいいのよ)

その代わり神椿が目指すメタバースについて書いていきます。

メタバースにも厳密な定義は存在せず、2021年に旧FaceBook社がMetaに社名変更することを発表してからは、誰もかれもがメタバースを連呼するようになりそれぞれが「おれのかんがえるさいきょうのめたばーす」を押し出し更に混迷を極めていきました。

KAMITSUBAKI STUDIOも例外でなく、メタバース事業やりますということを、メタバースとは本来全く関係ない別個の技術であるはずのブロックチェーンやNFTのことを長々と語りながら記事に認(したた)めていました。

色々記事を読んだり色んな人と話す限り、当時(そして今でも恐らくは)どのように展開していくのかが煮詰まっていなくてあのようなあいまいな書き口になったのだと思います。(それにしてももう少し言葉の使い方や文章構成は考えてほしかった)

VRChatなどのVRSNSやスマホを用いたスマホバースなどたくさんのメタバースプラットフォームがありますがどのような形になっていくのでしょう。プラットフォームはたくさんあれどIPを保有するメタバースプラットフォームは少ないのでうまい形になってくれればなと思います。

個人的にはVRChatに結構浸っているのでVRChatのようなVRHMDを使えるプラットフーム上で他の観測者と交流しながら魔女のライブが見れたら天寿を全うすることができるので是非やってほしいところですが、VRライブはHMD(ヘッドマウントディスプレイ:頭につけるディスプレイ)の充電の持ちと疲労の関係から開催予定は現状ないと明言されているのでしばらくは実現しなさそうです…

KDDIのすでにローンチされているサービスのαUメタバースではVTuberのライブ兼グリーティング会がすでに開催されているので、まずはそこで神椿が何かをするんじゃないかなと個人的に推測しています。これだけでも結構体験として面白い可能性があるので是非開催してほしいです。

3F Immersice Experience 「αU live」

こちらが今回の展示の目玉の一つなのではないでしょうか。

3Fが全て1つの展示となっています。3Fに上がってすぐ眼の前には大量のディスプレイがあり壮観です。

手前側は不可解弐の時のライブ映像が、奥側にはIMAGINARY WORLDの映像が、右手にはNreal Airを用いたARグラスによるライブが体験できます。

この展示ではどのような技術が使われているのか見ていきましょう。

一見するとスマホでライブで視点を自由に変えているだけに見えますが、ここでは割とすごいことをやってのけています。

実はこのライブ映像、スマホ側ではなくクラウド(サーバ)側でレンダリング(描画処理)を行っています(参考)。高精細な3Dの空間をリアルタイムにスマホでレンダリングするのは現状ほぼ不可能なため、視点をスマホ側で決め、その視点から見えるべき映像をサーバ側でリアルタイムに計算してその結果だけをスマホに送信してしまおうという賢い解決策を取っています。Google cloudとの連携が発表されていましたがここにその技術が使われています。

クラウドレンダリングの素晴らしいところは端末を問わないところです。iPhone7以下やAndroidには対応していないアプリなどがありますが、クラウドレンダリングを使うとスマホ側での映像処理がほとんどいらないので視点を動かすUIの応答処理さえできればスペックの低いスマホでも動作します。

自由視点によるメリットは何といっても推しを好きな画角で楽しめることです。現状のライブではカメラさんやスイッチャーによって決められたカメラワークでしか映像を見ることができません。しかし自由視点では、自分でカメラワークを決めて推しをアップで眺めたり引きの画角でVALISの全体のフォーメーションを確認することもできます。

しかしあまり自由に視点を動かせすぎてもモデルにカメラがめり込んで中が見えてしまったり、ローアングルにしすぎるとスカートの中が覗けてしまったりしますが、今回はちゃんとカメラの可動域に制限をかけていてこれらの事故を防ぐように作られていました。

今回の映像では(te'resaの方では特に)フレームレートが落ちてカクカクすることが結構ありましたが、これはレンダリングが間に合っていないわけではなく、あくまでサーバからクライアント(スマホ)に送るネットワーク速度がボトルネック(足枷)になっているようなのでこれに関しては神椿云々というよりKDDI(au)がんばれーという感じです。徐々に4Gから5Gへの移行が進んでいるので時間が解決してくれそうな気もします。

将来神椿がライブやるぞーと言ってスマホやHMD、ARグラス(ひょっとすると裸眼立体視で)などの思い思いの端末で好きな視点で自宅から神椿ライブを鑑賞する日が来るのを楽しみにしています。

自由視点によるライブは数年前からずっと見たかった景色なので見られて感動しています。(今年の研究テーマの案の1つだったのに先にKDDIにやられてしまって悔しい)

Metaverse Watch Concept

こちらの展示についてはいまだによくわかっていません。健康状態に同期したエージェントのPoCなのかな?裸眼立体ディスプレイを見せたいのか時計を見せたいのかどっちなんでしょう…

まあ確かに花譜ちゃんが腕時計の中にいて話しかけてきたらおもしそうです(そういう話ではない?)

使っていた裸眼立体ディスプレイは立派なものでSONY製で50万円近くします。原理は意外と単純でアイトラッキングをして、立体的に見えるよう目の位置に合わせてリアルタイムレンダリングをしています。そのため、一人しか立体映像を楽しめないのが欠点です。この技術の源流は30年前からあり(今とハードウェアは違うものの)Fish Tank Virutual Realityという論文でも似たようなことをしています。

終わりに

Pさんが大々的にR&Dを押し出していたのでつい研究者目線で見てしまいましたが、神椿によるR&DというよりはKDDIが今まで研究開発してきた成果を神椿と絡めてお披露目&ライブのPoCという雰囲気を感じました。自由視点意外あまり研究的な目新しさは感じませんでしたが、なんとなく神椿がやりたいことの一端が垣間見えた気がします。動線が分かりづらいとか、1m先に立ってくださいと書くくらいならテープ貼った方がはやいとか細かい指摘はたくさんありますが、ものによっては将来性を感じさせてくれたので、ぜひ言葉尻にとらわれず、不確かなものをこれからも実現してほしいなと思いました。

多少筆が乗ってから口になってしまう個所もありましたが基本的には応援していきたい所存です。(神椿FES初日の早朝にて)

この記事が気に入ったらサポートをしてみませんか?