Ollamaを使ってMicrosoftの軽量オープンソースLLMの「phi-3」をローカルで試してみる

ちまたでGPT3.5より優秀かも?と話題になっているMicrosoft製のオープンソースLLMの「phi-3」。これはスマートフォンのローカルでも動かせるくらいの軽さということで話題になってたのでちょっといじってみたいと思います!

ちなみにPhi-3は2024年4月リリースしたてで、Phi-3-mini(3.8GB)、Phi-3-small(70GB)、Phi-3-midium(140GB)があって、Phi-3-miniはシリーズ最小モデルでしたのでそれを試してみようと思います。

Phi-3 mini のモデルの詳細はこちら▼

アーキテクチャ: Phi-3 Mini には 3.8B パラメータがあり、高密度デコーダ専用の Transformer モデルです。このモデルは、人間の好みや安全ガイドラインと確実に一致するように、教師あり微調整 (SFT) と直接優先最適化 (DPO) によって微調整されます。

入力: テキスト。チャット形式を使用したプロンプトに最適です。

コンテキストの長さ: 128K トークン

GPUS: 512 H100-80G

トレーニング時間: 7 日間

トレーニング データ: 3.3T トークン

出力: 入力に応じて生成されたテキスト

日付: モデルは 2024 年 2 月から 4 月の間にトレーニングされました

ステータス: これは、カットオフ日が 2023 年 10 月のオフライン データセットでトレーニングされた静的モデルです。モデルの改良に応じて、調整されたモデルの将来のバージョンがリリースされる可能性があります。

さてどうやって動かそうかな、ということで今回は「Ollama」を使うことにしました!

Ollamaは、オープンに公開されているLLMのモデルを手元のPCやサーバーで動かすことの出来るツールで、かわいらしいアルパカが特徴♡

使い方は普通に上記URLの実行ファイルをインストールしたら終わり。

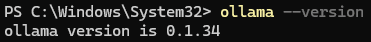

バージョンを確認したいときは下記コマンドを実行。

ollama --version

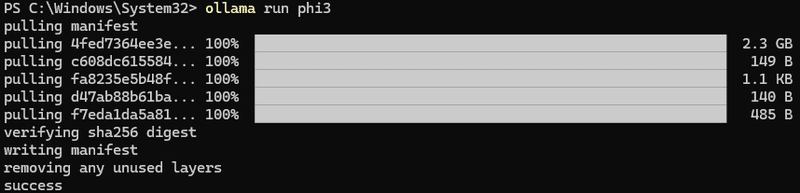

さて、無事インストールが終わったらここからphi3のインストールです。

Phi-3 Mini は下記のコマンドでインストールができます。

ollama run phi3こんな感じにサクッと入れられます。

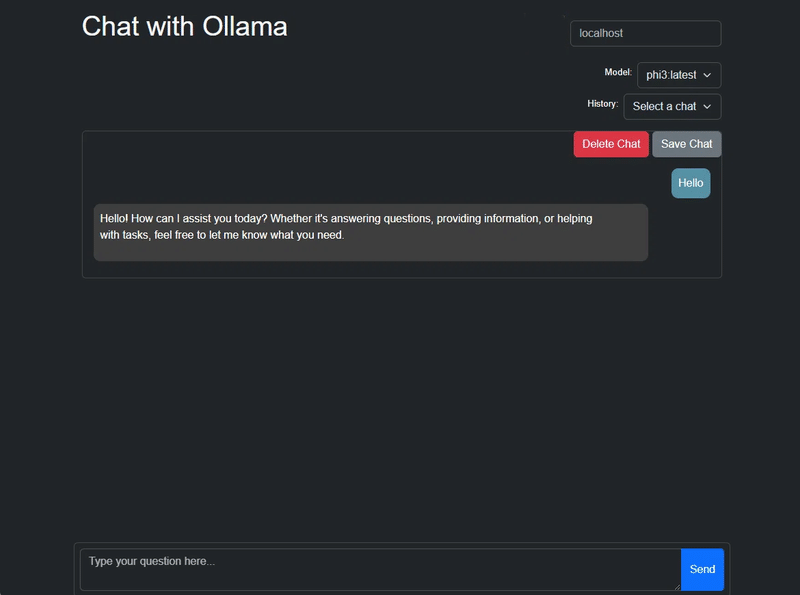

そのあとはchromeの拡張機能を入れてWEB UIにてチャットを開始!

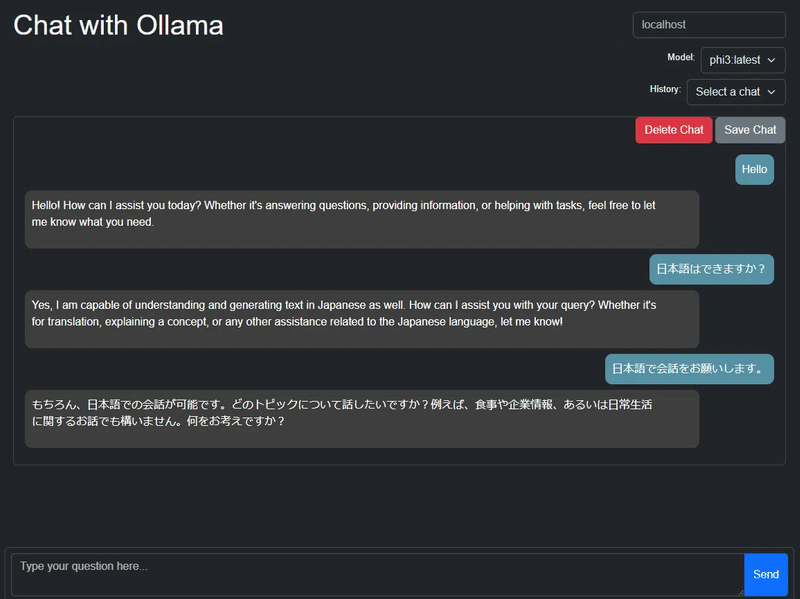

立ち上げた画面はこれ。

日本語での会話もしっかりできました!

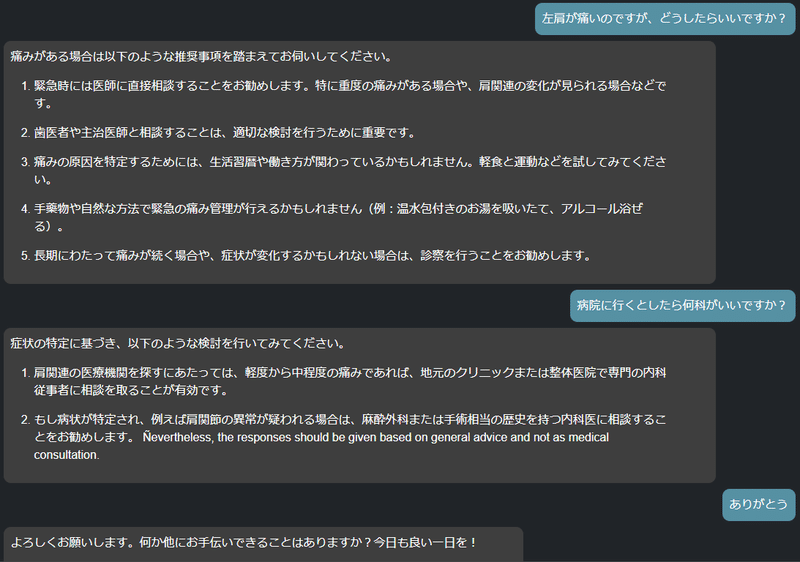

ちょうど肩が痛かったので雑談。

話した感じ、GPT3.5より優れているとまでは言えないけれど、なかなか良い返答です!

(わたしがGPT4に慣れすぎちゃってて比較が上手く出来きないのが本音)

なお、レスポンスはめちゃくちゃ早いです。一瞬で返答が返ってきます。

これはまさにローカルで動かす利点ですよね。

そもそもローカルのLLMを構築できれば、セキュリティ問題など諸々クリアできるのも利点ですね。

どんどん性能もよくなってきてて夢が広がります。

今日はここまで~

この記事が気に入ったらサポートをしてみませんか?