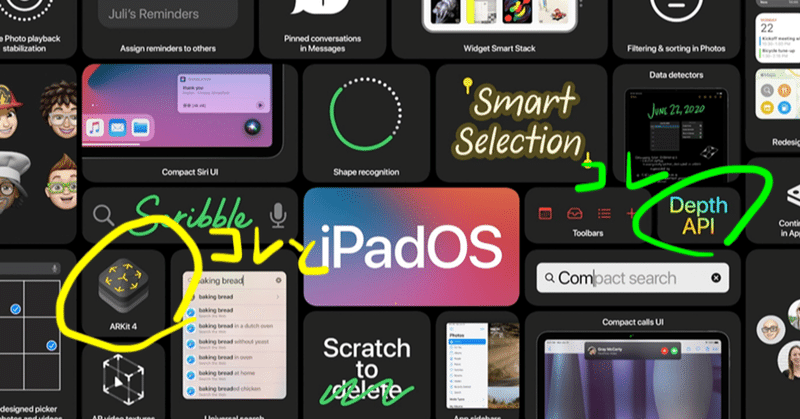

ARKit4 関連調査 その1

初のオンライン開催による WWDC2020。

Keynote内での発表はありませんでしたが、予想通りARKit4が発表されました。

ARKit4の主要機能

Depth API

今までARKitで深度マップが利用されていても、開発者側がその値を利用することは難しい状態でした。私はAVFoundation側から加工して取得したりしてました。APIの搭載により値を簡単に取得したり映像表現の切り替えが出来るようになったようです。(...多分です)

※LiDAR搭載端末のみ実行可能。

Location Anchors

都市全体や有名な建築物などをARAnchorとして判断し、特定の場所にAR表現が出来る。緯度経度指定による位置情報ベースでのAnchor追加も可能。もちろんユーザー間の共有も可能。

と書いてるので、Appleが用意した特定のARAnchorに合わせて各APP内でアクションをとる感じかな。めちゃくちゃ良くて面白い機能ですね。どはまりしそうです。

※A12以上搭載端末及び一部の国でのみ実行可能。

Expanded Face Tracking Support

今までA12以上のchipかつtrueDepthCameraがある端末でしか3人同時のFace Trackingが出来なかったけど、MLによってその制限を緩和し、trueDepthCameraがなくてもリアカメラがあれば出来るようになったようです。

Depthも取得出来るのかな?だとするとtrueDepthCameraいらなくなりますね。。

※A12以上搭載端末のみ実行可能。

他は、RealityKit、AirPodsのサラウンド、U1チップ、watchOSのジャイロ値連携などがARに利用出来そうで気になりました!

開発環境の用意

※Developer Programの登録と各種バックアップは完了している前提

Apple DeveloperサイトからBeta版 Software をダウンロードします。

Operating Systems:iOS 14 beta

Applications:Xcode 12 beta

iOS beta profileをiPhone内にコピーし実行。iPhoneのシステムバージョンが14.0になっていればOK。

Xcode beta ファイルを解凍して実行。Xcode-beta Version 12.0 beta (12A6159)のアプリケーションが実行出来るようになればOK。

容量大きいので両方完了するのになんだかんだ2時間くらいかかりました。

iOS14もXcode12も今のところ良い感じ。

本日からSession内容とSampleコードを確認していきます。

このマガジンの進め方

昨年同様に勉強目的でSamplerを作成しiOSの正式リリースと一緒に公開予定ですが、今年はその途中経過もメモとして残していこうと思いnoteに投稿することにしました。

一応AppleとのNDA契約上、Beta版の情報を一般公開することは禁じられているので、途中からは限定公開にします。(毎年公開例が出てしまってはいますが)

マガジンには定期的に投稿していく予定ですので、ご興味があってDeveloper Programに加入している方のみ記事を確認して頂けると幸いです。今回は準備編でした。

それでは進捗あり次第、また投稿します!

この記事が気に入ったらサポートをしてみませんか?