10万溶かして BQ に忠誠を誓った日

昨日に引き続き BQ アドカレに登場です!

枠が埋まっていなかったので、せっかくだから投稿することにしました!

(とあるコラボ撮影の一幕。一番左が私)

いつもは、データサイエンス VTuber として、統計、ML、DLと数学の動画を YouTube に投稿しています。

チャンネル登録よろしくお願いします(^^)

というわけで、 BQ で10万溶かしたけど、BQに忠誠を誓った話です。

超シンプルなので、超短いです。

いつものように、集計用のクエリを書いて、毎日定期実行することにしました。

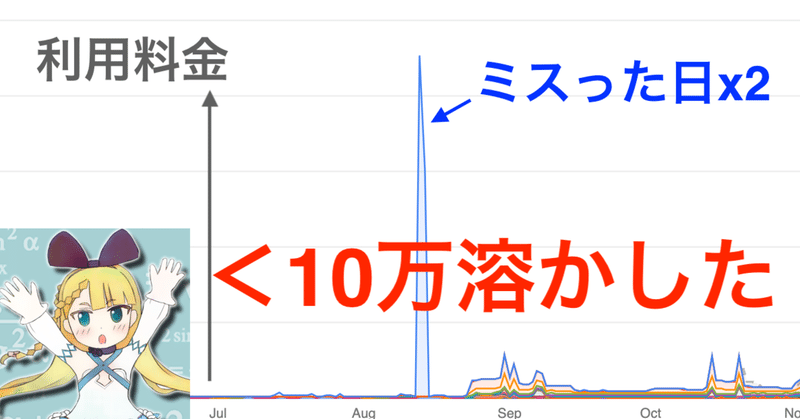

ですが、ミスが有り、 left join に使う table のデータが毎日重複して増えていくという現象が起こりました。

(1日目10行、2日目も同じ10行が増えて合計20行、3日目は30行……的な)

そのテーブルは、色々あって、集計中に5回 left join されています。

というわけで、4日目、4倍に膨れ上がったテーブルを5回 left join しているので、データ量が1024倍になってしまいました。

もう1つミスがあります。

要らなくなったデータを毎日破棄し、毎日再計算していたのですが、料金がかからない drop table ではなく、料金がかかる delete 文を使っていました。

なので、4日目、削除費用が通常の1000倍になりました。これで10万溶かしました。

(100%自分たちが悪いので、お金返してもらう請求もしませんでした)

なぜ4日目まで気づかなかったのか。

それは、たとえデータが1024倍になろうとも、処理時間は倍にもなってなかったからです。(2分→3分くらいの増え方でした。)

前日の時点で、データ量は243倍でしたが、普通に処理が終了したので、全く気づきませんでした。

ということは、、、!

BQ を使っている限りは、サービスが1000倍にグロースしても、なんの改修も不要では、、、、!??!??!????!?!?

可能な限り、全てのデータ分析は、 BQ で行おうと、心に強く思うのでした。

終わりに

昨日の記事が、実際、気合で BQ で階層ベイズの学習と推論を BQ 化した時の話です。

よかったら見てね!

まとめ

BQ はいいぞ。

チャンネル登録よろしくお願いします!

様式美

マスターの会社、 Atrae は積極採用中です!

BERT on kfp とかやってるし、本気の数理統計もやってるし、それぞれ半年かけて ML, DL 勉強会を(マスターが)やってて社内に citizen DS 生まれまくってるし、 Data Scientist, Data Engineer の活躍の場所が大量にあります!

よかったら Twitter フォローしてね!

この記事が気に入ったらサポートをしてみませんか?