【論文瞬読】大規模言語モデルの自己反省能力を高める新手法「Self-Contrast」

こんにちは!株式会社AI Nestです。今回は、大規模言語モデル(LLM)の反省能力に関する興味深い研究について紹介します。この研究は、LLMが自身の応答を自己修正する能力の限界を明らかにし、それを克服するための新しい戦略「Self-Contrast」を提案しています。

タイトル:Self-Contrast: Better Reflection Through Inconsistent Solving Perspectives

URL:https://arxiv.org/abs/2401.02009

所属:College of Computer Science and Technology, Zhejiang University OPPO Research Institute, China

著者:Wenqi Zhang, Yongliang Shen, Linjuan Wu, Qiuying Peng, Jun Wang, Yueting Zhuang, Weiming Lu

LLMの反省能力とその限界

LLMは、自然言語処理の分野で大きな話題となっています。しかし、その性能の高さとは裏腹に、LLMには自身の応答を自己修正する能力、つまり反省能力に限界があることが指摘されています。最近の研究によると、外部からのフィードバックがない場合、LLMは過去の応答を適切に修正することが難しいのだとか。

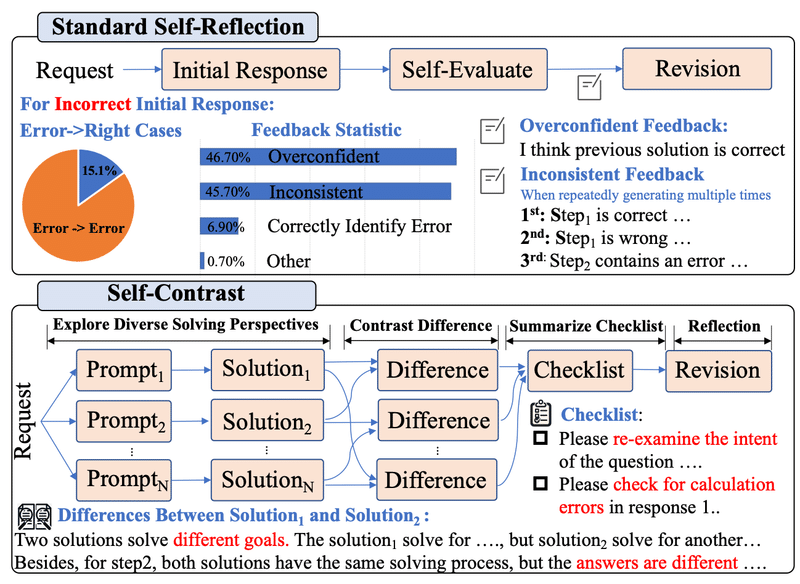

この問題の原因を探るために、研究者たちはLLMの自己評価の質に着目しました。その結果、LLMは自己評価の過程で過剰に自信を持ちすぎたり、一貫性のないフィードバックを提供したりすることが多いことが明らかになりました。つまり、単純な事後プロンプト戦略に頼るだけでは、LLMの自己修正は信頼できないというわけです。

上の図は、LLMの自己評価プロセスにおけるフィードバックの統計情報と、Self-Contrastの概要を示しています。LLMのフィードバックは、過剰に自信を持ちすぎていたり(46.7%)、一貫性がなかったり(45.7%)することが多いことがわかります。こうした問題を解決するために、Self-Contrastでは多様な視点から解を生成し、その違いを比較することで反省を促します。

Self-Contrastによる反省能力の向上

そこで、研究者たちは「Self-Contrast」という新しい戦略を考案しました。Self-Contrastは、LLMに複数の視点から問題解決をさせ、その違いを比較することで反省を促す手法です。

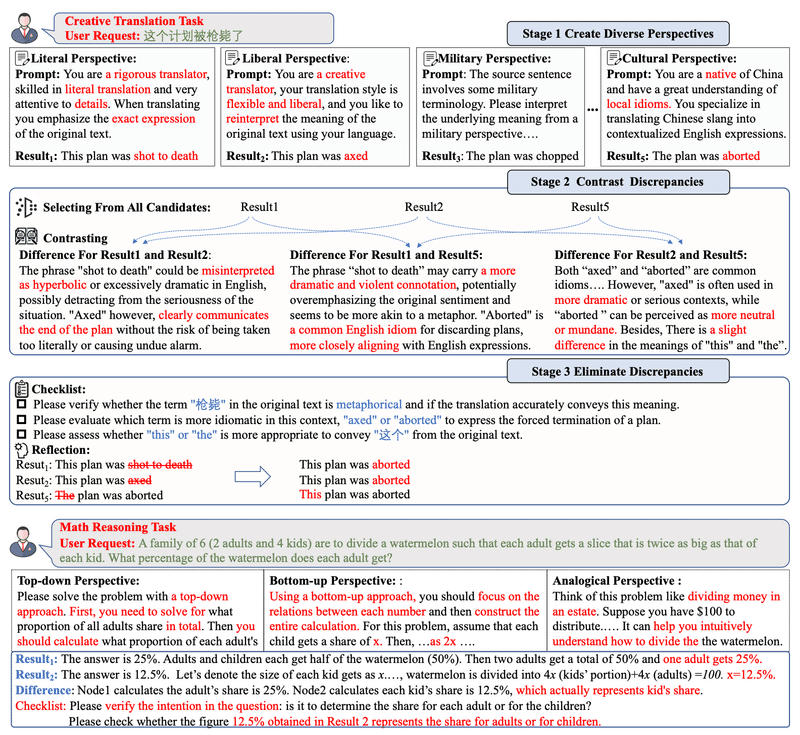

具体的には、上図に示す3つのステップを踏みます。

多様な視点の生成(Create Diverse Perspectives): LLMに複数の異なるプロンプトを生成させ、それぞれの視点から解を出力させます。

視点間の不一致の比較(Contrast Inter-Perspective Discrepancies): 出力された解の違いを比較し、チェックリストにまとめます。

不一致の解消(Eliminate Discrepancies): チェックリストを使って不一致を解消し、解を修正します。

この手法は、直接評価の限界を克服し、より信頼性の高い自己修正を可能にするというわけです。

実験結果と今後の展望

研究者たちは、Self-Contrastの有効性を数学的推論とクリエイティブな翻訳タスクで検証しました。

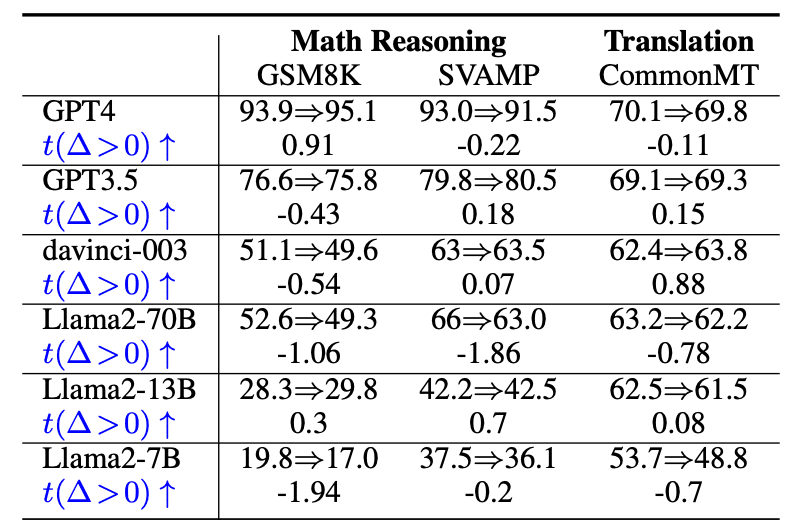

上の表は、複数のLLMとベンチマークを用いた、反省前後の性能比較を示しています。Self-Contrastは、従来の反省手法と比べて、安定した性能向上を達成していることがわかります。また、複数のLLMとベンチマークを用いた実験により、提案手法の一般性も確認されました。

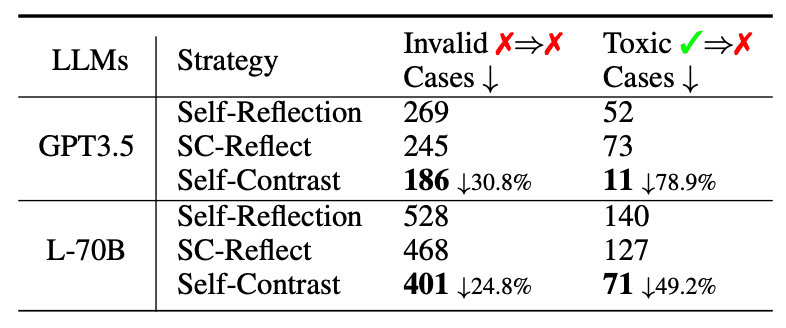

さらに、上の表から、Self-Contrastは無効な反省と有害な反省を大幅に減らすことができることがわかります。これは、Self-Contrastが反省能力を向上させる証拠となります。

ただし、Self-Contrastにも制約があります。小規模なLLMでは指示に従う能力が弱いため、アンサンブル戦略ほどの効果が得られないこともあるとか。また、実世界への適用可能性についても、さらなる検証が必要だそうです。

まとめ

LLMの反省能力という重要なトピックに新しい視点を提供したこの研究。Self-Contrastのアイデアは独創的で説得力があり、自然言語処理や人工知能の分野に大きく貢献するものだと評価できます。

今後、Self-Contrastのアイデアがさらに発展し、LLMの信頼性と性能の向上につながることを期待しています。みなさんも、この研究に触発されて、LLMの可能性について考えてみてはいかがでしょうか。

以上、大規模言語モデルの自己反省能力を高める新手法「Self-Contrast」についてお伝えしました。少しでもみなさんの興味を引くことができたなら嬉しいです。それでは、また次回お会いしましょう!