スマホARでユーザはどう情報を操作すべきか?|タッチ操作からの脱却とVUIの可能性

今回は2019年にスマホARで議論されるであろう、スマホARでの情報の操作方法について自分なりの考察をご紹介したいと思います。(この記事はAR Advent Calendarの18日目です。)

目次

・あまり議論されないスマホARの課題

・タッチ操作でのAR体験の難しさ

・コンピュータへの譲歩から解放されるARスタンダード時代

・VUIというフロンティア

・我々はまだVUIの使い方を知らない

あまり議論されないスマホARの課題

2018年のはじめに自分は「これからのスマホARアプリケーションに必要な3つの要素」というブログを書きました。

このブログの中で僕は2018年以降、以下の3つの要素が求められると述べています。

・ネットワーク接続されたAR空間

・「驚き」ではない価値の提供

・AR空間への簡単なアクセス

2018年に多くの便利なSDKやアプリが登場し、これらの要素を満たしたスマホARアプリもたくさん登場しました。スマホARのユーザー数も格段に増えてきています。

しかし自分の中では多くのスマホARにふれる中でまだスマホARに足りないが、あまり議論されていない課題があると個人的に思っています。

その一つがスマホARを利用中、ユーザーが情報をどのように入力し、操作するかという操作方法だと思っています。

タッチ操作でのAR体験の難しさ

ARで情報を表示する場合、3次元空間に配置することになります。また表示される情報やオブジェクトも立体的なものが多くなります。

一方でスマホに対して我々が起こすアクションは基本的にスクリーンをタッチする操作になります。

このタッチ操作はスマホ画面の奥に広がった3次元の空間、そこに配置された立体的な情報を操作するには相性が悪いと考えています。

タッチ操作は平面上の情報を選択したり、移動させたりすることには適していても、3次元空間上のものを選択したり、移動させたりするのは難しいです。

我々は長い間、スマホを使って平面上に情報を表示するアプリケーションの開発や使用に慣れすぎてしまったため、ARという三次元の情報を扱うテクノロジーを利用する際にも、どうしても今までのアプリ内での操作の延長線上で操作したくなってしまいます。

しかしARという、体験も情報の次元も新しいシステムの中では、我々はその情報とのインタラクションについても方法を変えていかなくてはならないと考えています。

コンピュータへの譲歩から解放されるARスタンダード時代

GUI(Graphical User Interface)が発明されたことにより我々はより視覚的にコンピューター上の情報を操作することが可能になりました。

その後、スマホの普及のなかでジェスチャーやタップ、スワイプなどより自然なNUI(Natural User Interface)によって、もっと直感的に情報を操作することが可能になりました。

しかし、それでも我々はまだコンピュータに情報の操作方法を譲歩しています。我々は本来、マウスを操作したり、画面を指で擦ったりする動作はコンピュータ以外とはしません。

ARで情報と接することが当たり前になった時代には従来我々がコンピューター側に譲歩して使用していたGUI/NUIに縛られず、まるで人と対話するかのように音声でコンピュータと対話し、まるで実物体を動かすように情報に触れることができるようになると考えています。

そもそもコンピュータとのインターフェースを意識せずに、より自然体にデジタル情報と触れ合えることこそがARの最終的な価値なのだと思います。

VUIというフロンティア

とはいえ、我々は2019年もまだまだスマホを多用することはほぼ明確で、スマホという閉じられた箱の中でAR体験を提供することが、多くのユーザーにAR体験を提供できる手段だと考えられます。

そんなスマホでもARと相性が良い操作方法を提供することが可能だと考えています。

その一つがVUI(Voice User Interface)です。

VUIも今年は躍進の年で、AmazonとGoogle Homeが一般家庭にどんどん普及し、米国では今年9月時点で24%の普及率を実現しています。

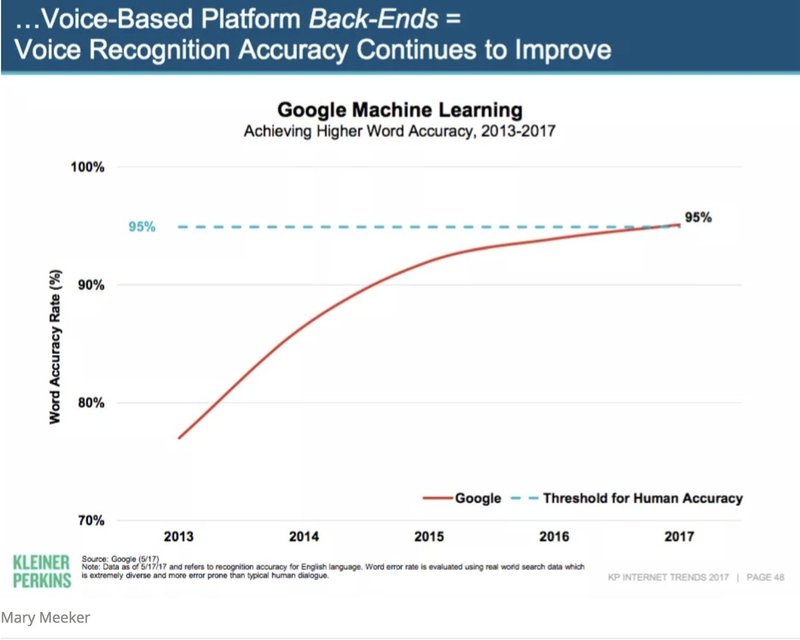

また認識精度も英語の認識精度はついに人間と互角、もしくは人間以上という精度を誇るようになってきたといいます。

技術的にVUIは使用に耐えうるものへと進化を遂げたタイミングで、かつスマホはSiriやGoogle Assistantの登場で人間が声で話しかける相手としても申し分ない相手になりました。

またVUIは情報の次元によらず使うことができます。(まだ技術的には難しい部分もありますが)コンピュータが文脈さえ理解できれば、人が発言した「それ」という言葉は平面上のある情報なのか、それともAR空間に配置された立体的ななにかなのかを認識することは可能です。

VUIはARで情報を操作する主流な方法の一つであり、これは現状のスマホARでも充分に実現できる手段なのではないかと考えています。

今年見たデモの中で最も興味深かった例をご紹介します。

KabaqというスタートアップはARKit登場時からフードショップのメニューをARで表示することが可能なARサービスを提供しています。

そのKabaqが今年こんなデモを発表しました。

ユーザーが「お腹が空いた」というとSiriがレストランの一覧を表示し、ユーザーがレストランを声で選択すると、ARでそのレストランのメニューを表示してくれます。

この間、ユーザーはタッチ操作はせず常に声で操作しています。

この動画はあくまでコンセプト動画になりますが、多くのヒントが隠されていると思っています。

もう一つ例をご紹介します。

こちらはARクラウドスタートアップの6D.aiが実施した6D.aiのSDKを使ったデモコンテストでの入賞作品です。

動画をみていただくとユーザーが発した言葉が立体的な文字になって出現しているのがわかります。

そしてその文字が地面につくと、実際にその単語がARで立体的に表現されます。(「rabbit」という発言すると実際にうさぎの3Dモデルが出現します)

それだけではなく、「Hide」など動詞をうさぎに対して発言するとその単語がうさぎにぶつかって、実際に木の陰に隠れます。

このようにまだ実用のものではないにしても、我々に示唆を与えてくれる例も出始めています。

我々はまだVUIの使い方を知らない

先日Techcrunchで紹介されていた翻訳記事の中でもVUIについて言及されていました。その中でGUIを操作するためのマウスが発明される前や、発明された時のことについて述べられています。

コンピューターマウスが発明される前に、それを欲しがっている人は当然いなかった。そして実際には、当初多くの人たちがそれまでに存在していなかったマウスに当惑していた。以前は操作するためにはビジュアルなアイコンではなくコマンドラインを使っていたからだ。

我々はマウス登場時にコマンドラインばかり使っていた人々と一緒で、GUIばかり使っていたため、まだ声の操作がどのように使われるべきなのかがわかっていないのです。

かくいう僕も残念ながら、確信の持てる使い方を知っているわけではありません。

ただ必ずここには答えがあると考えています。

2019年もまた多くのスマホARアプリが登場し、そのなかでVUIを使ったものもこれから多く登場すると思います。

それらのアプリの中からARでのVUIを使った情報操作の形として適切なものが発見できれば、スマホARがよりユーザーに受け入れられるものに進化していくのではないかと思っています。

自分自身も開発者として、2019年はユーザーがより使いやすいVUI + ARの体験を模索して行きたいと思っています。

最後に

弊社MESONではAR/VRがどのように我々の生活を変えるのかや事業をつくっていけるのかを試行錯誤しながら、継続的にTwitterや会社ブログで発信しています。

MESONのメンバーと一緒にAR/VRアプリを開発したいと思った方や企業様はぜひ弊社HPか私のTwitterからご連絡ください。

この記事が気に入ったらサポートをしてみませんか?