googleの画像解析機能とChatGPTで写真のタイトルを考えてもらう(ChatGPT部, 大城)

おはようございます、ChatGPT部(チャットGPT部)、部長の大城です。

私は常々ChatGPTの画像解析APIが公開したら世の中変わるのでは、と思っているのですが、その前にGoogleのVision AIがすでに結構すごかったので、先日撮影した写真をGoogleのAIで解析して、そのテキストを元にChatGPTにタイトルをつけてもらう実験をしてみようと思います。

対象の写真とGoogle Vision AIの紹介

先日、福岡で開催されてたボルドーワインの会ですね。

( なんか、写真で自分の顔みるとパンパンですね・・ )

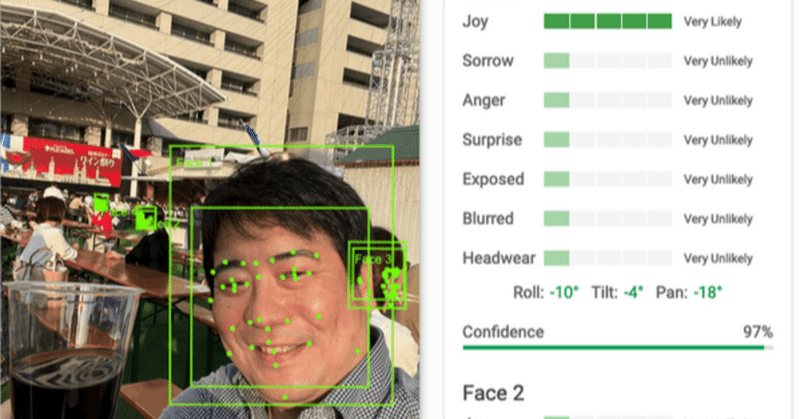

この画像を解析してみます。

以下、googleのVision AIです。サンプルとして、UI上で解析が可能です。

画像解析結果(抜粋)

写真をドラッグアンドドロップするだけで、ここまでいけます。

文字認識。いや、よくこの距離で読めますね・・。

表情。Joy(笑顔)が1番上にきてます。

何が映っているか。頭、スマイル、ビル、barwareはバー用品、drinkwareはカップとかみたいです。

位置情報。まぁこれはGPS付きのメタデータがあればAIじゃなくても行けます。

いや、写真を読ませたらもう一瞬でここまで解析できるなんて、ほんとすごい世の中になりました。

JSON出力 -> ChatGPTにinputでタイトル作成

なお、先ほどまでの解析データはJSON形式で出力が可能です。

(JSONはラベルと値をセットで持った、コンピュータが扱いやすい形式のデータセットです)

今回はJSONのデータが大きすぎるので、ChatGPTには全ては投入できないのですが、雑にJSONの断片を食わせて写真のタイトルを推測してもらう、という実験をしてみます。

プロンプトはこんな感じですね。

以下はgoogleのCloud vision AIにある写真を投入して解析した結果のJSONの断片です。 これらから推測されるシーンに対して、写真タイトルの案を表形式で出力してください。

▪️JSONの断片

(該当しそうな箇所のJSONのデータを雑にコピペ)

実行結果

いかがでしょうか。画像に写り込んだ福岡ボルドーワイン、という情報と、笑顔の表情を考慮したタイトルを作成しています。どれも状況を表していますね。

所感:進化はこれから、でも現時点でも十分すごい

今回の実験は、雑な断片的な情報のinputでしたが、これが本格的に利用する場合は例えば十分な背景知識のinput、また例えば二枚の写真をいれて、前後のつながりをストーリーとして推測させる、などの使い方もできるかもしれません。(この辺は追々実験してみたいなと思いました)

なお2023/5/23現在ではChatGPTの画像解析機能はまだ公開されていませんが、おそらくこのGoogleのVision AIを上回るのでは、と個人的には予想していますので、その時代に備える意味でもGoogleの画像解析AIを触ってみるのも良いのでは、と思っております。

(でも、現状でも十分組み合わせ方によっては実用的な気もしました)

それではみなさんもどうぞ良いChatGPTライフを・・! (大城)

この記事が気に入ったらサポートをしてみませんか?