GPTでの絵文字や変な文字での圧縮は無意味だと思う話

GPTのテキスト生成と圧縮の問題点

GPT(Generative Pre-trained Transformer)は、人間のテキストを学習し、自然な会話を生成する能力を持っています。ただ、絵文字や変な文字を使った圧縮については無意味に近いと個人的に思っています。

これは、GPTが圧縮された情報を復元する能力が限定的であるためなのと、絵文字での圧縮ではトークンを大して減らすことができない為です。(絵文字1つで2-3トークンを消費する)

GPTは、学習された情報をもとに推測を行い会話を生成するため、簡単に言えば人間と同じことをさせています。あなたは圧縮された文字列を見て意味が分かりますか?GPTも一緒です。ワカリマセン。

圧縮された情報を与えられても内容を正確に復元しないことが多いのです。

GPTの暗号化と復号化の不十分さ

GPTは、人間のテキストから学習している為、内部的に変換や暗号化が行われていません。また、暗号化や復号化のルールを指示しても、それを学習していないため理解できず、情報を守ることができません。

これは、GPTが人間の思考や理解部分を削除し、推測の部分に特化しているため、基礎知識が不足しているという性質が関係しています。

例えば、GPTに量の多い足し算を与えてみてください。

例えば下記のようなものです。

5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5+5=

この答えは120です。

Googleや電卓アプリで計算したり、手計算でも120と出るはずです。

しかし、ChatGPTは基礎の部分を知らない為、計算を内部で行わないので結果がぶれます。

効果的な圧縮方法の提案

絵文字や変な文字を使った圧縮は効果が微妙であることが分かりました。

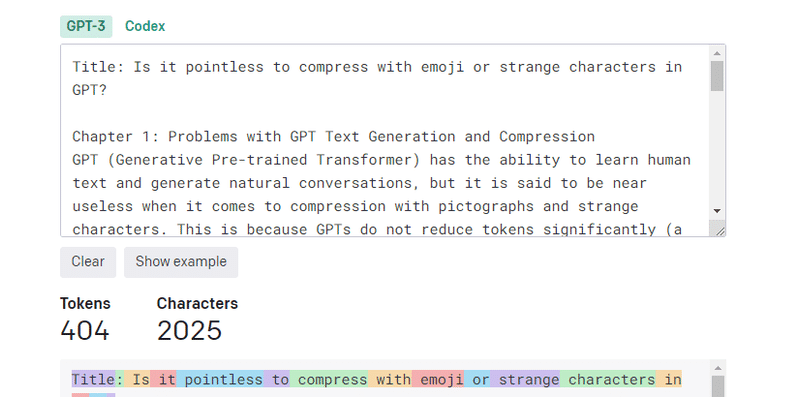

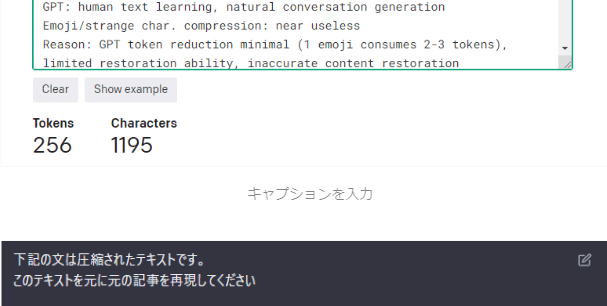

ではどのような手法が一番効果的なトークンの削減となるかですが、それは英語です。英語翻訳だけでも相当のトークン数の削減になります。

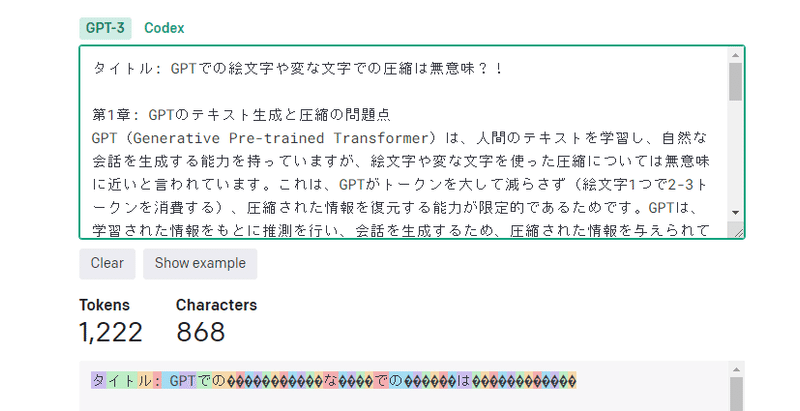

下記はこの記事の原文と英語翻訳後のテキストのトークン量です。

(GPT3基準なのでChatGPT3.5のトークン数とは誤差があります。)

画像を見ればわかると思いますが、英語にするだけで1/3の量にトークンを削減できます。態々意味の分からない圧縮語にするよりもほぼ復元可能な英語にするだけでこの量です。基本的にはこれでいいと思うんですが、さらに圧縮する方法も存在します。

ここから先は

この記事が気に入ったらサポートをしてみませんか?