言葉に依存しない検索は可能か?

ChatGPTを調べ物に使うといった用途にはじまり、BingやPerplexityといった、いわゆる大規模言語モデル(LLM)を採用した対話型AIを介した検索サービスが次々に登場しています。アルゴリズムの変化など、裏側の進化に比べて、ユーザインターフェイス(UI)自体には大きな変化がなかった検索エンジンにとって、新しい対話型UIはユーザの目にも新鮮に映りました。

ただ、対話型AIを介した検索であっても、これまでの検索と同じように「言葉」に縛られてしまうという側面があります。言葉にできないものは検索できないし、言葉にできたとしても、抽象的すぎると、正解に辿り着くのはかなり大変です。

今日のコンピュータのUIは、大別するとキーボードによってコマンドを入力することによってコンピュータを制御するCUI(Character User Interface)と、マウスなどのポインティングデバイスを使用して、視覚的に表現されたファイルやコマンドによって制御するGUI(Graphical User Interface)の2つがあります。(厳密には昨今SiriやAlexaといったVUI(Voice User Interface)といったものもありますが、これは音声認識/音声合成を介した広義でのCUIと捉えられるでしょう)

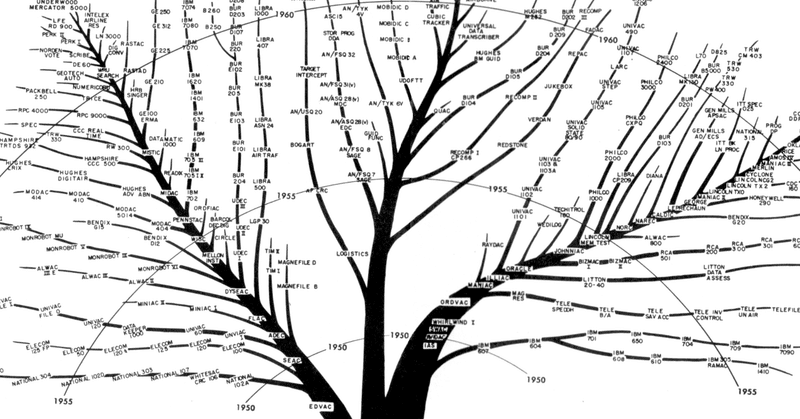

CUI、GUIそれぞれにメリット、デメリットはあるものの、歴史的に初期のコンピューターに搭載されていたCUIはコマンドやその文法を覚える必要があり一定のハードルがありましたが、MacやWindowsに代表されるようなGUIの登場によって、多くの人々がコンピューターを操作する機会を広げてきたという側面があります。

様々な操作がGUIとして視覚的な表現を与えられ多くの人々に使いやすさを提供している一方、なぜ「検索」という機能は、いまだに言葉に囚われ続けているのでしょうか。例えば、ずばり名前を思い出せないけど、雰囲気などは説明できる俳優の名前や、もっといえばいまだ名前が付いてないけれど他人と共有できるような「感じ」を検索するにはどうしたらよいでしょうか?

言葉以外で検索する方法

AI技術を活用しつつ、言葉以外の方法で、もっと直感的に検索を実現する方法は無いものでしょうか。

例えばGoogle LensやShazamは、画像認識技術や、音声フィンガープリントといった技術を利用して、画像と情報を紐づけたり、音と情報を紐づけることを可能にしています。

ただ、これらのソリューションは、あくまで調べたいモノが目の前にあることが前提になっており、姿形がないような抽象的なものを検索することには向いていません。

ここでの、「姿形がないような抽象的なもの」というのは、別に哲学的な概念や、感覚のことだけではなく、指し示す言葉を失念してしまった時の「あれ」も含みます。誰しも会話の中で一度や二度は「あれあれ、ほらあれ…」というやりとり、ありますよね。

例えば

「ほらあれ、なんだっけ、過去の音源のサンプリングをレーベルが公認したブレイクビーツのアルバムがブルーノートからでてたよね…?」

みたいなの話であれば、キーワードに辿り着くまでのいくつかの重要な情報が出ているので、割と簡単です。(ちなみに答えは、Madlibの"Shades of Blue"です)

あらゆるコンテンツに属性情報を与えて、単なるキーワード検索ではなく、「ほらあれ検索」を実現させるためのアプローチは、「セマンティック検索」などと呼ばれており、Googleなどにも既に実装されています。

一方で、例えば

「なんだっけ、あのPV 。2000年ごろだったと思うんだけど、フルCGで…当時のCGつってもレイトレっぽいツヤツヤしたサイバーな感じじゃなくてさ、ワイヤーフレームでもっとシンプルにまとめてる感じのやつなんだわ。しいていえばREZっぽいというか…」

というような、抽象度が高いものになってくるものになると、検索はかなり難しいでしょう。(ちなみに答えはケンイシイの"Awakening"のPVです)

上記二つの「ほらあれ」状態になるときの会話の例で気づくのは、人はぴったりとする説明ができないとき、補足情報や、類事例をあげるということです。ぴったり言い当てる言葉を見つけられないとき、その言葉につながるような文脈をなんとか手繰り寄せるためのヒントを提供しようとします。

この特性に注目すると、新しい検索の形が少しだけ見えてくる気がします。例えば言葉を入れるだけではなく、そこから浮かび上がる「意味のつながり」のネットワークを可視化するような、正解に近づくための文脈を見つけるサポートしてくれるようなツールによって、検索の言葉への依存量をもう少し軽くできるのではないでしょうか。

意味の空間を覗き込むための虫眼鏡

近年AIに言葉を理解させたり生成させたりする技術の根っこの部分に「言葉をベクトルとして表現する」という発想があります。これは「言葉をその周辺の言葉との関係性によって相対的に定義する」という非常に面白い考え方です。

あらゆる言葉をベクトル化することによって言葉を計算することが可能になる…ものすごくざっくり言うと、「言葉の距離」が測れるようになるわけです。例えば「犬」という単語の近くには「ペット」とか「散歩」という言葉が現れる。さらに、「東京タワー - 東京 + パリ = エッフェル塔」といった「言葉による計算」ができるようになる。とすれば、これは翻訳にも使えそうだ!とか、そもそも単語じゃなくて文章自体の距離を測ったらどうなる?などなど…色々な研究が進めていった結果、いい感じにAIと対話ができる(かのように見える)ところまで来たわけです。(より詳しく知りたい方はword2vec以降の自然言語処理技術の歴史を参照ください)

イメージしやすいように例えるなら、仮に「意味の空間」みたいなものがあると考えてみてください。(機械学習では、この概念を「特徴量空間」と呼びます)辞書に書かれている言葉も、未だ書かれていないこれから登場するかもしれない新しい概念も、すべてをどこかに配置することができる無限の多次元空間があるとします。この空間の中にプラネタリウムのように世界のあらゆる言葉がプロットされているイメージです。検索とは、この意味の空間に散らばる無数の星の中から複数の言葉や概念で絞り込みをかけたり、手繰り寄せたりするイメージです。

このメタファーこそ、言葉ベースではない、検索GUIの一つの可能性なのではないかと考えています。検索したいものをなんとなく指し示す言葉や、イメージなどを入力したら、意味の空間上に、入力した内容の近くにあると思われる情報や画像や映像や音声が星座のように次々と表示され、それを地図のようにブラウズしていくような感じです。

実はこのようなイメージの検索システムは、音の世界では既に導入が始まっています。DTMをやっている方はピンとくるかもしれませんが、例えばDAW上でドラムなどを打ち込む時に、バスドラムの音はこれで、スネアの音はこれで、ハイハットの音はこれで…というように自分で好みの音(ドラムのワンショットサンプルといいます)を組み合わせることができるのですが、サンプルの数が膨大で微妙に違う音が多くて選ぶのが大変だったりします。そこで、XLN Audio社のXOというソフトでは、すべてのワンショットサンプルを解析してこの特徴を二次元空間にマッピングすることで、この地図の中から好きな音が探せるようになっています。似ている音は近くにプロットされるので、もう少し違う音が欲しい、というときは今のポジションからやや離れた場所を探索すると、少し違う音が見つかる、といった具合です。

これは、「音」を周波数別パワーの時間変化という特徴量として捉え、これを二次元に落とし込むことで実現しています。この考え方を同様に「言葉」に置き換えたら…?上で書いた検索GUIのようなものがつくれるかもしれません。

とはいえ現実的にはこうしたUIを用意しても、検索したい内容によってフィットする場合とフィットしない場合があるでしょうから、現状GUIの中にもCUIで操作可能な「ターミナルモード」が用意されているように、既存の検索エンジンの中に「ビジュアルモード」としてこうしたGUI的な、AIの頭の中を覗き込むようなモードがあると、より検索は直感的で便利なもの、そしてなにより、より人間が主体的で、心楽しい体験となるかもしれません。

ところで、私は以前「曖昧なものを曖昧なまま検索する」体験を音楽検索の分野に生体信号を利用してチャレンジしたことがあります。micoというシステムで、特定のジャンルの音楽を試聴した時の脳波の特徴量を分類して登録しておき、ヘッドフォン装着時のユーザの脳波との近似値から音楽をレコメンドするというシステムです。選曲の納得度のフィードバックを与えて精度やパラメーターを調整していけば、最終的には気分にフィットする音楽がレコメンドできる…少なくともごく稀にiPodが起こす「神がかったシャッフル再生」の再現性を高めることができるんじゃないか、ということを考えていました。今はプロジェクトとしてはクローズしてしまいましたが、こうしたいわば「非言語検索」ともいうべき領域は、今後AIやBMIの研究がさらに進むことでさらに注目されていくのではないかと考えています。

この記事は、Dentsu Lab TokyoとBASSDRUMの共同プロジェクト「THE TECHNOLOGY REPORT」の活動の一環として書かれました。今回の特集は『検索』。編集チームがテーマに沿って書いたその他の記事は、こちらのマガジンから読むことができます。この記事の執筆者は、Dentsu Lab Tokyoの土屋泰洋です。

この記事が気に入ったらサポートをしてみませんか?