OpenAI Sora発表 (テキストだけで動画を生成)

私たちは、現実世界のインタラクションを必要とする問題を人々が解決できるようにするモデルをトレーニングすることを目的として、動いている物理世界を理解してシミュレーションできるように AI を教えています。

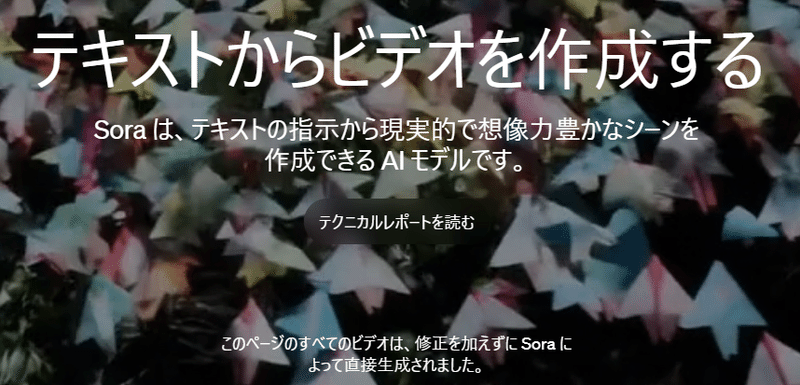

テキストからビデオへのモデルである Sora を紹介します。 Sora は、視覚的な品質とユーザーのプロンプトに従いながら、最長 1 分のビデオを生成できます。

はじめに

またOpenAIから衝撃の発表がありました。

これまでもText-To-Videoのサービスがありましたが、これはクオリティがすごいです。

もはやCGがいらなくなりそうですね。

がんばって現実のものに近づけるようにCGで努力してきたことが、AIによっていとも簡単に実現できる時代になってきました。

OpenAIのページをさっと抜粋しました。

Soraの説明

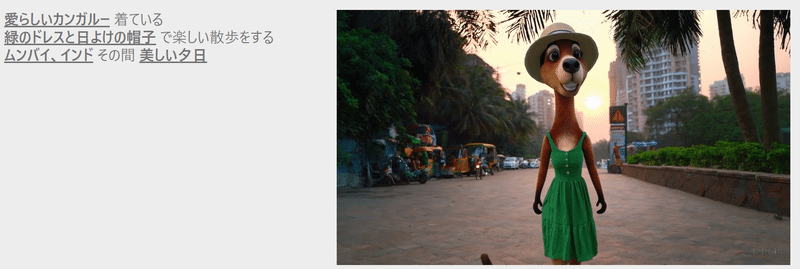

Text-To-Videoなので、テキストでプロンプトの指示をすると自動で動画が生成されます。

OpenAIのページに大量のサンプル動画がありました。

ビジュアルデータをパッチ化する

私たちは、インターネット規模のデータでトレーニングすることでジェネラリスト機能を獲得する大規模な言語モデルからインスピレーションを得ています。13、14LLM パラダイムの成功は、 コード、数学、さまざまな自然言語など、テキストの多様な形式をエレガントに統合するトークンの使用によって部分的に可能になります。この研究では、視覚データの生成モデルがそのような利点をどのように継承できるかを検討します。 LLM にはテキスト トークンがありますが、Sora にはビジュアルパッチがあります。パッチは、視覚データのモデルを効果的に表現することが以前に示されています。15、16、17、18パッチは、さまざまな種類のビデオや画像で生成モデルをトレーニングするための非常にスケーラブルで効果的な表現であることがわかりました。

ビデオ生成用のスケーリング トランスフォーマー

Sora はディフュージョンモデルです21、22、23、24、25;ノイズの多いパッチ (およびテキスト プロンプトなどの条件付け情報) が入力されると、元の「きれいな」パッチを予測するようにトレーニングされます。重要なのは、Sora は拡散トランスフォーマーであるということです。であるということです。26トランスフォーマーは、言語モデリング、13、14コンピュータビジョン、15、16、17、18そして画像生成。27、28、29

この研究では、拡散トランスがビデオ モデルとしても効果的に拡張されることがわかりました。以下に、トレーニングの進行に伴う固定シードと入力を含むビデオ サンプルの比較を示します。トレーニング コンピューティングが増加すると、サンプルの品質が著しく向上します。

可変の持続時間、解像度、アスペクト比

画像およびビデオ生成に対するこれまでのアプローチでは、通常、ビデオを標準サイズ (たとえば、解像度 256x256 の 4 秒ビデオ) にサイズ変更、クロップ、またはトリミングします。代わりに、ネイティブ サイズでデータをトレーニングすると、いくつかの利点が得られることがわかりました。

サンプリングの柔軟性

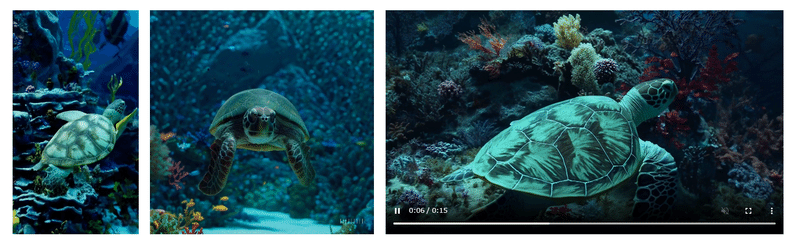

Sora は、ワイドスクリーン 1920x1080p ビデオ、垂直 1080x1920 ビデオ、およびその間のすべてのものをサンプリングできます。これにより、Sora はさまざまなデバイス向けのコンテンツをネイティブのアスペクト比で直接作成できるようになります。また、フル解像度で生成する前に、すべて同じモデルを使用して、より低いサイズでコンテンツのプロトタイプを迅速に作成することもできます。

フレームと構成の改善

ネイティブのアスペクト比でビデオをトレーニングすると、構図とフレーミングが改善されることが経験的にわかっています。すべてのトレーニング ビデオを正方形にトリミングするモデルのバージョンと Sora を比較します。これは、生成モデルをトレーニングする際の一般的な方法です。正方形のクロップでトレーニングされたモデル (左) は、被写体が部分的にしか表示されていないビデオを生成することがあります。比較すると、Sora (右) のビデオはフレーミングが改善されています。

言語理解

テキストからビデオへの生成システムをトレーニングするには、対応するテキスト キャプションを含む大量のビデオが必要です。 DALL・E 3で導入された再キャプション技術を応用しています。30ビデオに。まず、非常に説明的なキャプション モデルをトレーニングし、次にそれを使用してトレーニング セット内のすべてのビデオのテキスト キャプションを生成します。非常に説明的なビデオキャプションをトレーニングすると、ビデオの全体的な品質だけでなくテキストの忠実度も向上することがわかりました。

DALL・E 3 と同様に、GPT を活用して、短いユーザー プロンプトをより長い詳細なキャプションに変換し、ビデオ モデルに送信します。これにより、Sora はユーザーのプロンプトに正確に従う高品質のビデオを生成できるようになります。

画像やビデオによるプロンプト

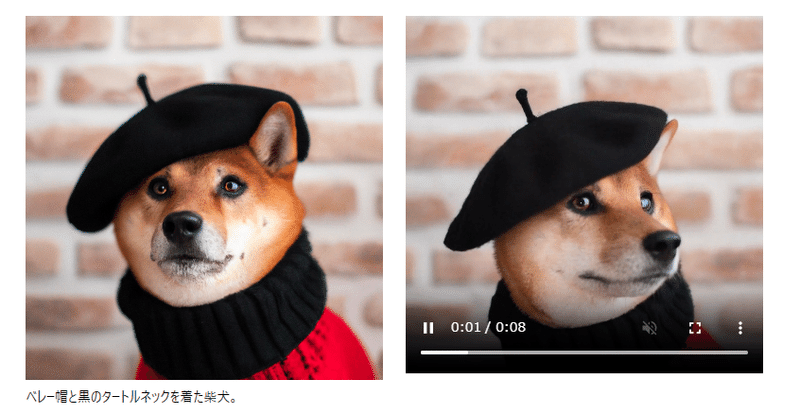

上記およびランディング ページのすべての結果には、テキストからビデオへの変換サンプルが表示されます。ただし、Sora は、既存の画像やビデオなど、他の入力を求めることもできます。この機能により、Sora は、完全にループするビデオの作成、静止画像のアニメーション化、ビデオの前後方向への拡張など、幅広い画像およびビデオ編集タスクを実行できるようになります。

DALL・E画像をアニメーション化する

Sora は、画像とプロンプトを入力として提供されるビデオを生成できます。以下に、DALL・E 2 に基づいて生成されたビデオの例を示します。31そしてDALL・E 330画像。

おわりに

まだリリースはされないようですが、Runwayよりクオリティが高そうなので利用できるようになるのが楽しみです。

参照情報

この記事が気に入ったらサポートをしてみませんか?