LIVE2D用フェイストラッキングソフト、結局どれが使われているの?※情報が古い記事です

こんばんは、フルスミです。

Vtuber用LIVE2Dモデリングのコツについてまとめるnoteの第一回目です。

週に2回投稿したいといっておきながら頻度が遅くてごめんね!

今回は基礎的な部分、Vtuberが使っているフェイストラッキングソフトウェアについてお話をします。まずこのへんから整理していかないと詳しいお話ができないので、最初は退屈な記事になるかも。

LIVE2Dをさわったことがある人向けの記事なので、わけのわからないパラメータ名とかなんとかの話をすることになります。「なんだかよく耳にするワードだなぁ」とか思いながら流し見してくれれば良いです。

ここでは日本基準ではなく、世界基準でどういったものが主流なのかについてお話をしていきます。なぜなら私が国外のクライアントを中心に活動しているからです。Vtuberブームが英語圏でめちゃくちゃ来ておるのですよ。流行ったきっかけとなったソフトウェアについても触れます。

1. FaceRig

みなさんご存知のFaceRig。VtuberでLIVE2Dといったらこれでしょう。

ルーマニアの Holotech Studios, Inc. から開発・販売されている、webカメラによるリアルタイムのフェイストラッキングソフトの先駆け的な存在です。もとは2Dモデルではなく3Dモデルを動かすソフトとして開発され、その後、LIVE2D SDK に対応しました。

現在、Steamで販売されており、本体が1,480円、LIVE2Dを導入できるようにするためのモジュールが398円、合計2,000円弱とウェブカメラがあれば機能を試すことができます。Animazeという後継ソフトウェア(後述)が出ていますが、FaceRigは少なくとも2021年初頭まで購入可能です。

以前はスマートフォンアプリが公開されていましたが、現在は公開されていません。

このソフトが日本のVtuberブームを巻き起こすきっかけとなりました。日本で最初にバーチャルYouTuberを名乗ったとされるのはキズナアイさんです。その後、個人で3Dモデルをトラッキングで動かし、バーチャルYouTuberを名乗る動画投稿者がバズりにバズり、「個人でできるならやってみよう!」の勢いでVtuberが増えに増えまくりました。

ただし、個人で3Dモデルを作れる・動かせる人はごくごく限られた人々でした。費用もスキルも高度なものが求められるためです。

それならば3Dではなく2Dで動かしてはどうか?と使われ始めたのがLIVE2DとFaceRigです。準備に必要なコストの低さ、当時の目新しさなどが相まってLIVE2DとFaceRigはVtuberブームの恩恵をそれはもうハチャメチャに受けることになります。2020年現在、LIVE2Dの使用目的の1/3がVtuber用途というデータがLIVE2D社よりリリースされました。残りは映像とかゲームとかです。

私がモデルを動かす際や、要件定義の基準にしているのはこのソフトです。先駆けとなって普及しまくったソフトウェアであり、日本ではもっとも知名度が高いVtuber向けソフトウェアだからです。

標準でトラッキングされるパラメータなどはこちらを参照

すいみんさんの記事はわかりやすいので助かります。

特徴的なのがスペシャルモーション・スペシャルアニメーションという、いわゆる表情差分やアニメーションが仕込める点です。

ここから技術的なお話です。

詳しくは省略しますが、「cc_キャラ名.cfg」というコンフィグファイルにパラメータ名や対応ボタンを記述することで、ZXCV, Shift+ZXCV の計8つのスペシャルアニメーション、QWERTYの計6種のスペシャルモーション、1種のアイドリングモーションを設定することができます。

設定方法は各自調べてください。めっちゃ出てきます。

私の作ったテンプレも置いておきます。

cc_キャラ名.cfg

//キャラ名 = Model Name//

//Toggle motions Press key QWERTY (end 1~6)//

set_special_action_anim キャラ名 'Toggle motion name' 1

set_special_action_anim キャラ名 'Toggle motion name' 2

//Idle motion//

set_idle_anim キャラ名 'Idle motion name'

//Press key Z,X,C,V,Shit+Z/X/C/V end(1~8)//

set_special_pose_param キャラ名 'ParamXxx' 0 1 1

set_special_pose_param キャラ名 'ParamXxx' 0 1 2

//ArmPositions (DefaultValue Maximam ClickPosition)//

set_arm_l_param キャラ名 'ParamArmL' 0 10 0

set_arm_r_param キャラ名 'ParamArmR' 0 10 0

//Avatar Poasitions (X, Y, Rate of magnification)//

set_cam_pos キャラ名 0.0 -1.4 0.6モーションの名前は「XXX.motion3.json」の「XXX」の部分だけでOK

わかりやすく説明すると、

スペシャルポーズ=特定の1つのパラメータ値を変更

スペシャルモーション=特定のモーション(motion3.json)を再生

アイドリングモーション=特定のモーション(motion3.json)のループ再生

こんな感じです。

アイドリングモーションは変な仕様があります。ループ時に設定してある値が0.2秒程度かけて基準値に戻るといったものです。それはまた別の記事で。

FaceRigが持っている特殊な仕様は、スペシャルモーションの再生後、フェードアウト値が0に設定されていれば、FaceRig標準のパラメータ名以外のパラメータの値が維持されるという点に尽きます。

この機能を使ったモデルが「GAOO」です。

🚀FaceRigがLive2D Cubism 4に対応🦊

— Live2D (@Live2D) September 13, 2019

Studio / Classic / Pro全てのバージョンでOW (Original Workflow)に対応!クリッピング表示が改善され、モーションのフェード時間もコントロール可能に!@live2dcs が制作した「GAOO」と「YUTAKA」もClassic / Proに特別バンドル!ぜひお試しください! pic.twitter.com/0lzEL5jOWK

動画を再生するとわかるように、このモデルはモーションの再生でオオカミに変身することができます。

モーション再生後にパラメータの最終値が維持されるのを最大限に活かしたモデルといえるでしょう。初めて見たときめちゃくちゃにビックリしました。ちなみにこのモデルのcfgファイルやmodel3.jsonファイルの中を見てもよくわからない部分があります。モデル説明文をどこで設定しているのかなど。

ちなみに、ParamFaceAngleXなどのトラッキングされる値などは最終値に関わらずトラッキング値で動くため、維持されません。ParamArmRなども、トラッキングこそされませんが標準パラメータなので基準値に戻ってしまいます。モーションの値を維持させたいときは、必ず標準以外のパラメータ名を設定しましょう。

だがしかし、モーションの最終値はソフトウェアによっては維持されたりされなかったりするから厄介なのです。

2. VTube Studio

国外でもっとも主流なソフトウェアです。

ドイツ在住のアーティストでありプログラマーの Denchi さんが個人開発・公開しているソフトウェアです。Unityで作られています。UIがきれい。

2019年の LIVE2D AWARD で技術賞を授与されていたのが記憶に新しいです。

ソフトウェアの発表にあたり、日本のLIVE2Dモデラーの作品をいくつか取り込んでいたり、色んな国の協力者がいるようです。

The app I've been working on, @VTubeStudio, is now released for iPhone, Mac and Windows! I'd be super happy if you give it a try! You can become a Virtual YouTuber directly on your iPhone or a connected PC/Mac. #Live2D #VTubeStudio pic.twitter.com/vB6NOvuMrH

— Denchi @ Iron Vertex (@DenchiSoft) June 2, 2020

こちら公式ツイッター。

ハッシュタグをつけた人をバンバンRTしているので見ているだけで楽しいです。

標準パラメーターや導入方法などについては公式でマニュアルが配布されているため割愛します。要望があれば記述しますが、まあ、どっかに書いてあると思います。

より詳しく知りたい人は公式Discordサーバーを見てください。

このソフトウェアのもっともたる特徴はスマートフォンを使ってトラッキングしている点です。webカメラは使いません。

あと基本無料です。スマホとパソコンの映像をWi-Fi経由でリンクさせるためにはアプリのPRO版を3,000円くらいで購入する必要があります。詳しくは後述。

最大のメリットは「パソコンの機能を圧迫しないこと」であり、FaceRigを起動するとそれだけでいっぱいいっぱいな低スペックパソコンや、FaceRigを起動しながらゲームするにはキツいミドルなパソコンでもVtuberモデルを使いながら配信やらゲームやらをすることができます。

これはとんでもないメリットです。そのぶん使える人、すなわちVtuberとして活動できる人の数に直結するためです。このシステムのおかげで数十万円するパソコンや機材を揃えずとも活動ができる、イラストやモデルに費用をかけることができる、すなわちLIVE2Dの仕事も増えたわけですね。

他にも超大きなメリットがあります。iOSのARKitという拡張現実機能が使えます。要するに、対応しているiOS機器があれば超高精度なフェイストラッキングを使ってぬるぬるなめらかに動くことができるわけです。

おかげさまでFaceRigくんが低精度だとか散々な言われようでした。そんなこと言うなよ!FaceRigくんがブームの基盤になっているんだぞ!オイ!と言いたくなりますね。ちなみに私はiOS機器を持っていないのでよくわかりません、いまだにFaceRig使ってるヤーイヤーイと言われたくないので肩を持っている次第です。FaceRigの検証のためにどれほどの時間を費やしたことか!!!まあそれはいいとして。

デメリットは「スマホが無いと使えない」ことです。

現状、webカメラだけでトラッキングすることができないので、スッとモデルを試すのが困難です。配信するときもスマホのカメラ向かないといけないので、物理的な配置に工夫が必要になります。みんなどうやって配信しているのか気になります。

それと、androidは目パチのトラッキングをしません。自動まばたきになります。これはパソコン側でandroid用かiOS用かの設定をいじることができます。LIVE2Dモデリングを仕事にしている人はスマホがなくても設定できます。微調整や検証をしたかったら、クライアントと同じ機器を用意しましょう。このためだけにiOS機器ほしいなとずっと思ってます。

無料でダウンロードできますが、有料のPRO版(25-30USD)では以下のことができます。

- スマートフォンからVTube Studioのロゴを削除

- 1分以上、PC / Macに顔のトラッキングデータをストリーム

- マネタイズされたストリーム、スーパーチャットなどを含む任意の商業目的

フリー版では1分以下しかパソコンで試せないわけですね。動作確認程度でしょうか。あとはロゴの削除と、商用利用が可能になるわけです。

マニュアルはこちら(英語です)

ここから技術的なお話です。

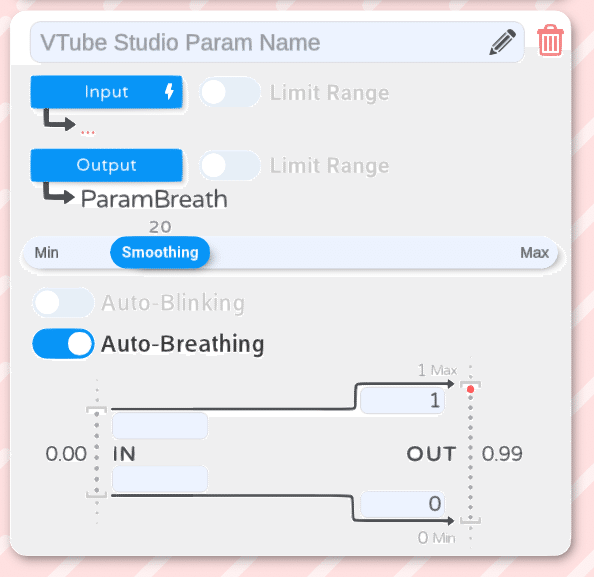

VTube Studio(VTS)では、標準で呼吸(ParamBreath)が動作しません。手動で紐付けする必要があります。

やり方を簡単にご紹介します。

設定画面でプラスボタンを押して、インプットは空っぽのまま、アウトプットにParamBreathを入れ、自動呼吸をオンにします。そうするとFaceRigのように自動でParamBreathが0~1を行ったり来たりします。5秒くらいで設定できるので簡単ですね。

FaceRigでZXCVとかに対応していたスペシャルアニメーションは、そのままだと使えません。exp3.jsonファイルとして書き出し、設定する必要があります。やり方はこちら

要するに、ZXCVとかに割り当てていたパラメータをオンにした1フレームのモーション(motion3.json)を作って、それをViewerに入れて表情モーション(exp3.json)に変換するだけです。

FaceRigの仕様に慣れていると地味に面倒な作業ですが、他のソフトやゲームとかだとこうやって表情設定しているので、実はかなり基礎的な部分です。configで指定するのがおかしいとか言わないの!

これの良いところは「数が無制限」である点です。設定できる数が無制限です。FaceRigだと8つだったのが、500個くらい設定しても大丈夫です。あと他のソフトに流用可能です。nizimaのプレビューファイルとか。

exp3.jsonは重ねが可能です。ZXCVの重ねと同じような感覚で重ねることができます。リセットするためのキーも設定可能です。

同じくモーションも無制限に設定可能です。なんとアイドリングモーションも複数設定可能で、任意で切り替えが可能です。

ただし、モーションは一部挙動が異なります。

VTube Studio ではパラメータの最終値が維持されません。(Version 1.4.0)

つまり、モデル「GAOO」のような変身モーションが使えません。これは個人的にかなりの痛手で、いまだにFaceRigを使っている理由の1つです。

Discordで開発者に問い合わせしたところ、「要望を多くもらっており、維持されるようにアップデートするつもりです」との回答をいただきました。バージョンアップで変わるかもしれません。

こういう柔軟さは個人開発の良いところだよね。

3. PrPrLive

bilibili(ビリビリ動画)を使う人が主に使っているソフトウェアです。

無料です。かなり頻繁にアップデートが行われています。

2020年5月14日に 1-reality という開発者からリリースされました。

すごいのは、ノーマルマップを適用して光源配置ができる点です。2Dを擬似的に3Dに見せる技術です。使いみちはいまいちわかりません。たぶん私のクリエイター魂みたいなのが足りていないのだと思うので、工夫次第でどうにでもなるソフトなのかな。

UIがむずかしいです。開発者向けなのかな。

正直、あんまりわかっていないのですが、FaceRigのconfigファイルなどをある程度そのまま使うことができます。Shift+ZXCVは動いてないかな。

こちらもexp3.jsonや、motion3.jsonを無制限に設定できると聞きました。できるらしいです。

使い心地ですが、FaceRigよりもトラッキング精度が低いのかな?と思っています。簡単にトラッキングが外れる気がします。目玉のトラッキング精度が低いとも言われています。

あんまりPrPrLive用途の依頼を受けたことがないので詳しく検証していませんが、ものすごい頻度でアプデがされているので期待しても良いのかな?と様子見をしています。

「ピュアピュアライブ」「ピリピリライブ」など呼ばれていますが、正式名称は「ペロペロライブ」だった気がします。

4. Animaze

FaceRigの後継ソフトです。

現在は早期アクセスソフトウェアです。

Webカメラのトラッキング範囲がめちゃくちゃ広いです。真横を向いてもトラッキングを維持してくれます。

Animaze Editor という専用のエディットソフトを使って調整する必要があるのですが、なんだかよくわかりません。

まあ、アーリーアクセス版だし。ベータ版だし。

とりあえず開発支援ということで年パス買ったりしましたが、

しばらくはFaceRigでいいんじゃないかな!

webカメラにしてはものすごい精度であるとは感じました。

その他は様子見です。がんばって検証したところでベータ版なので大きく仕様が変わるので。安定したら記述します。

今回は以上です。

とりあえずFaceRigとVTSを抑えておけばいいと思います。

ニッチなものとしては、個人的には2DRなんかが好きです。

Vtuber市場はトラッキングソフトがあってこそです。

善良なユーザーでありましょう。一時的な良し悪しでアレコレ言うのは控えましょうね。開発応援しています。

この記事が気に入ったらサポートをしてみませんか?