airoboros: GPT-4で作成した学習データで微調整した大規模言語モデル(ほぼgpt-3.5-turbo)

Self-Instructの手法でGPT-4を使用して生成された学習データを使って、ファインチューニングされたLlaMA-13b/7bモデルが公表されていました。

モデルの概要

Self-Instructの手法でgpt-4、またはgpt-3.5-turboを用いて、人間が生成したシードを含まず学習データセットを作成(OpenAIライセンスの対象)

airoboros-gpt4

airoboros-gpt3.5-turbo

gpt-4で作成されたトレーニングデータで、LlaMa-13b および7bをファインチューニング

モデルの利用は、研究用途にのみに限定

学習データには、意図的に脱獄スクリプトを使用して生成されたデータも含む(いくつかの不適切なプロンプトのみ手動で削除)

ファインチューニングは、FastChatモジュールを用いて実施。13bモデルはA100 80GB x8 約40時間で完了

ともかく試食してみます

Text-generation-webuiでお手軽に試してみます。Text-generation-webui のインストールは1クリックで簡単です。

また、重みファイルは、webuiのモデルタブからリポジトリ名(jondurbin/airoboros-13b-gpt4)を入力してダウンロードした後、読み込みオプションを設定して読み込みます。

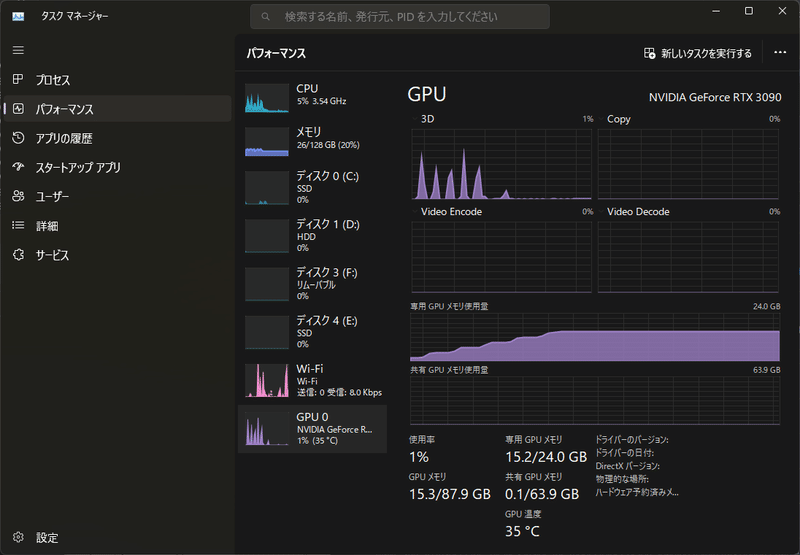

実行環境:windows11 RTX 3090

量子化オプション:load-in-8bit

パラメータプリセット:LLaMA-Precise

プロンプトテンプレート:Vicuna-1.1形式

試食の感想

全体的にとても自然な応答が出来ている印象です。

実験結果で示されたようにVicuna-13b-1.1と比べて、確かに品質が向上しているように感じられます。

データセットは英語のみのようなので、主に英語の応答が改善されているのだと思いますが、日本語の返答の品質も向上しているような気もします。(気のせいかもしれません。)

まとめ

短時間のファインチューニングで、表面的かもしれないものの、性能が追い付かれてしまうのは、OpenAIも心中穏やかではないと思います。

ほぼgpt-3.5は攻略した感じもするので、次の目標はgpt-4でしょうか…。

推測ですが、OpenAI社が2023年中に計画を公表している、「安くて早い gpt-4」は、OpenAI社内の次期 gpt-5? の蒸留で、gpt-4並みの性能を引き出した軽量モデルを "gpt-4ブランド" で売り出す感じなのでしょうか。興味が尽きません。

現場からは以上です。

この記事が気に入ったらサポートをしてみませんか?