無料から始める歌モノDTM(第21回)【調声編③<歌声>その2・音価音高】

はじめに

はじめましての方ははじめまして。ご存知の方はいらっしゃいませ。

ノートPCとフリー(無料)ツールで歌モノDTM曲を制作しております、

金田ひとみ

と申します。

前回からの連投です。一気読みされている方は小休止を。

改めて基礎回を未読の方は、一読をオススメします。かなり長いですが、私の調声の方針になります↓

【調声編】全体の流れです↓

<歌声>:音声、音価・音高、トランジェント・アタック等について

<発音>:子音・母音、フォルマント、ピッチガチャ、ブレス等について

<抑揚>:ビブラート、コブシ、シャクリ、フォール等について

<効果>:エフェクター、ハモ等について

順番はDTMer/ボカロPに馴染みやすいであろう、DAWでの曲制作順に則っています。

前回が<歌声>音声についてでしたので、今回は音価・音高についてです。曲制作での「ノート打ち込み」に相当します。

今後はできるだけ実際の画像や音を聴きながら進めていきます。

また科学的・理論的なアプローチも増えていきますので、しばらくは前提条件や定義の説明も挟みますが何卒お付き合いくださいませ。

音価・音高

基礎回で少し解説した音価と音高について改めて解説します。

先に理解しやすい音高からです。

音高(ピッチ)

音高はそのまんま、音の高さです。

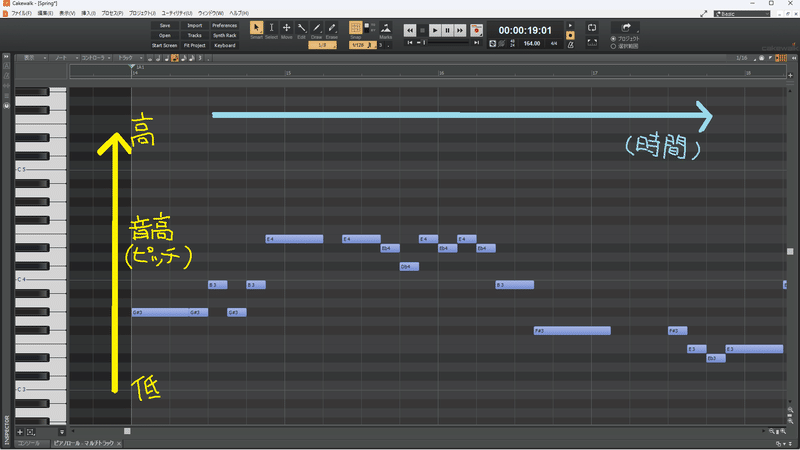

曲制作で言うところのピアノロールに打ち込むノートの縦方向の位置です。位置が高い、上に行くほど高い音になります。当たり前ですね。

で、当たり前ではあるんですがこういった用語や定義は統一しておきます。

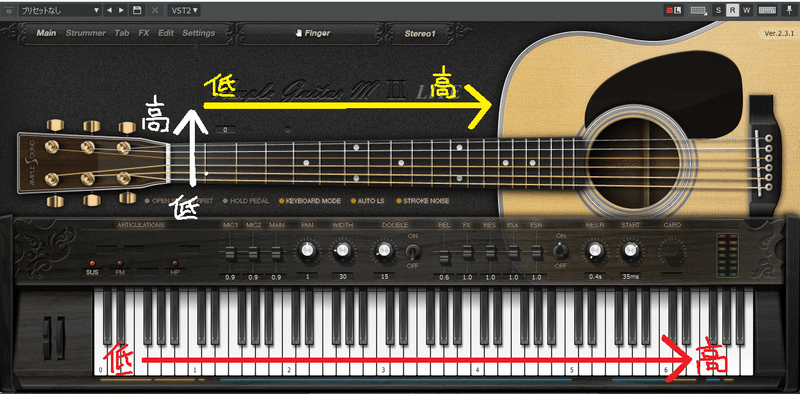

例えばピアノの鍵盤なら現実では向かって右側ほど高い音です。上画像の左側に表示されているピアノの鍵盤を、現実でこの向きに置くことはまず無いです。

ギターならコード表やプラグイン音源で表示されるインターフェイスの上側(1弦側)、そして右側に行くほど高い音です。

ギターの構え方としては下側(同じく1弦側)に行くほど高い音でコード表やインターフェイスとは上下が逆。

(ギターの場合、違う弦で同じ高さの音が出せるのでややこしいですが。あと左利き用で左右逆向きのギターもあります。)

下にピアノ鍵盤も表示されています。

音源プラグインのインターフェイスとは真逆。

何を今さらとは思うでしょうが、科学的・理論的なアプローチをするときは前提が違うと違う結果になりますので注意です。

もう一点、音高の事を英語でピッチと呼びます。

以降、英語などで用語が定着しているものや機能や操作が一般化しているものは、そちらの用語を優先して使います。

こういった最低限の決まり事を共有していないと、何をやってるのか、何の話をしているのかワケが分からなくなりますので明確にしておきます。

ピッチについて注意点として確認しておいていただきたいのは、音名、階名、音階(スケール)、音程(インターバル)と、今回の音高(ピッチ)はそれぞれ別物だということです。

【調声編】を読まれているということは音楽用語や概念のざっくりした知識はあるという前提で話を進めますので、詳しくは楽典解説などをご覧ください。

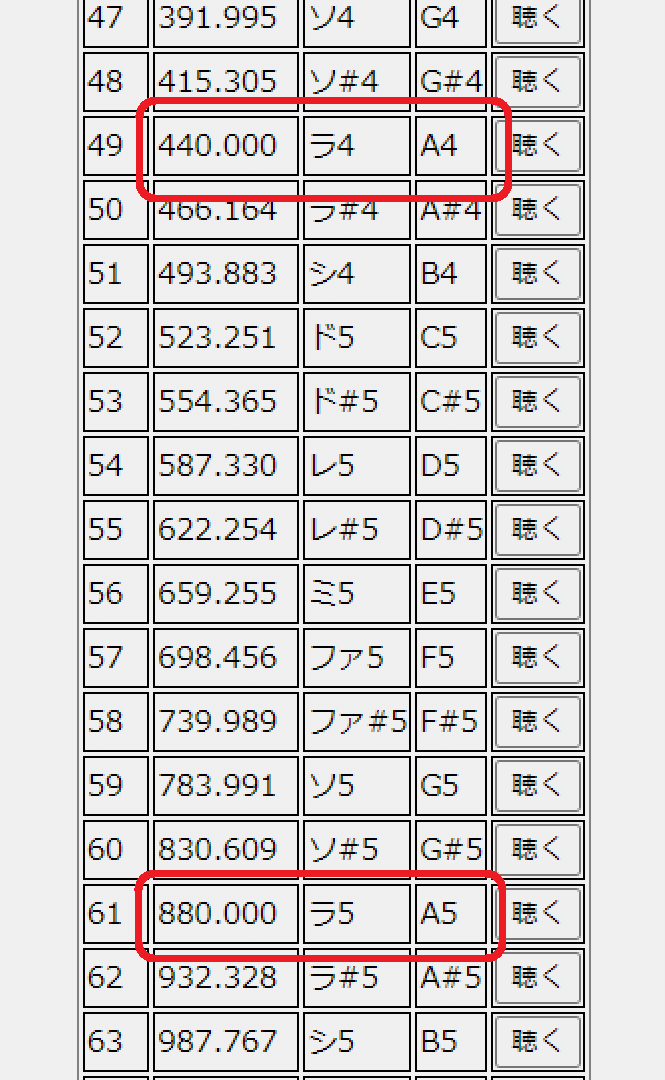

ピッチの話をする時はひとくちに「ラ」の音と言っても、例えば「ラ4/A4」と「ラ5/A5」では周波数で「440Hz」と「880Hz」の違いがあって別の音です。国際的な取り決めです。

(https://tomari.org/main/java/oto.html)

男声と女声では同じキーの曲でも最初からオクターブ違うメロディーを指しているかもしれません。一曲中でもAメロは低音中心でサビは高音に跳ね上がるかもしれません。となると得意な音域や調声すべきピッチは変わってきます。

楽器音にイコライザー等エフェクターを掛けるときにカットしたりブーストしたりする音域が変わるのと同じく、歌声という音を調整していくのが調声なので、音源つまりシンガーの得意音域やメロディーのピッチごとに調声の仕方が変わるのは当然です。

いずれ解説するテクニックの「ピッチガチャ」はこのことを理解していないと運任せにの沼に落ちます。

一応こんな感じでその都度、定義やこの【調声編】での決まり事を確認しておきます。

「音高=ピッチとはピアノロールのノートの縦方向の位置に相当し、上に行くほど音が高く(周波数が高く)なる」です。

シンガーによって声質や声色を特徴づける音域や、得意な音域、癖の出やすい音域などはそれぞれ違いますので個別の周波数そのものでの解説は極力しませんが、どうしても解説上、説明が必要な場合はその場での再定義をします。

音価

もう一つが音価です。

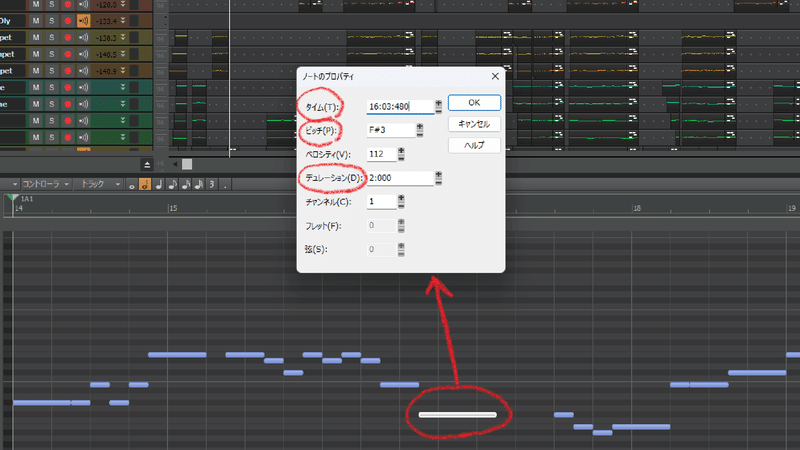

今のところ、ノートの長さ=デュレーションとそのノートを打ち込む横方向の位置=タイムとして対応させておいてください。

単音で見るとデュレーションだけですが、歌声が乗っかるメロディーは前後の音と連続した時間的流れを持ちますのでタイムも含みます。

CakeWalkではピアノロールのノートをダブルクリックすることでプロパティを確認できます。

この音はタイム16:03:480、ピッチF♯3、デュレーション2:000とわかります。

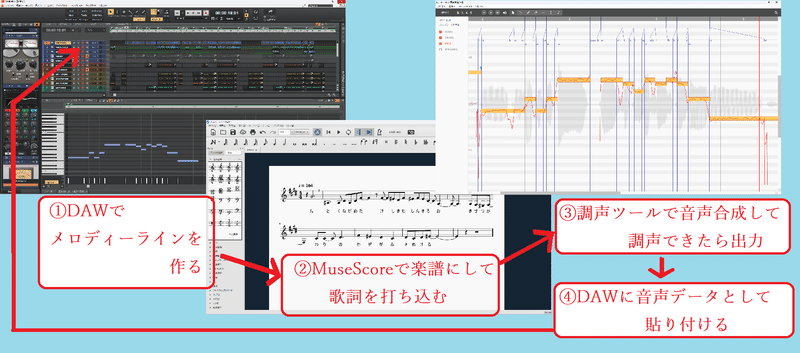

実際NEUTRINOに歌わせるときは、一旦メロディーラインをDAW上で作り、それを楽譜ソフトのMuseScoreに読み込ませて音符に歌詞を乗せ、それから調声ツールで音声合成するという手順で、ノートと歌声は連動しています。

具体的なやり方そのものは【ツール編】で解説しましたので割愛します。

一応NEUTRINOで音声合成する手順図を描いておきました。⇣

①DAWでメロディーラインを作る

②MuseScoreで楽譜にして歌詞を打ち込む

③調声ツールで音声合成して調声できたら出力

④DAWに音声データとして貼り付ける

というのがNEUTRINOでの手順です。

有料の歌声ソフトや最近のものだと、DAWを扱うのと同じように直感的な操作で調声までできるものもあります。

使い方そのものはソフトごとの説明書や解説をお読みください。

歌声とピアノロールのズレ

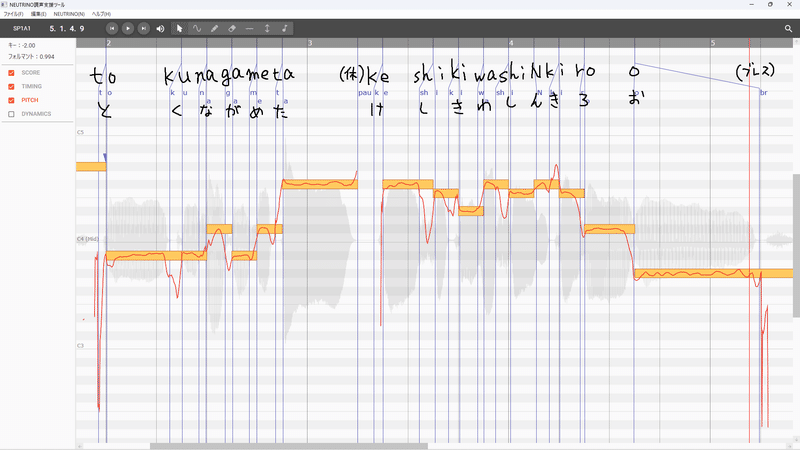

さて、それでは実際のNEUTRINO調整支援ツール画面を見ていきます。

具体例として取り上げる曲は基礎回で制作中と言っていた曲、

31曲目『風待ちダンドリオン』(めろう)から持ってきます↓

1番Aメロの最初の歌詞、

「遠く眺めた景色は蜃気楼」

の部分です。

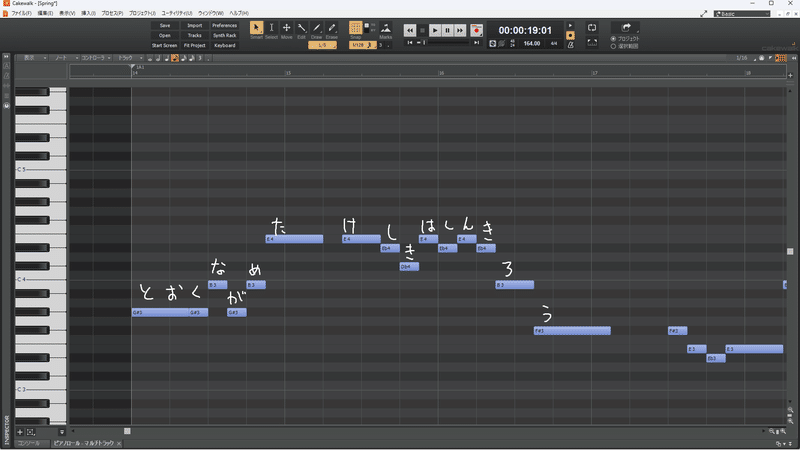

下画像の順に1つ目が元のDAW(CakeWalk)のピアノロールとノート、

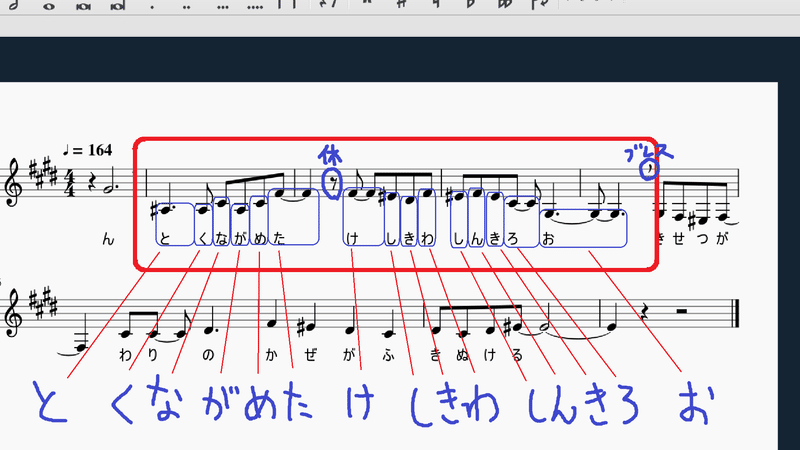

2つ目がMuseScoreの楽譜と音符、

3つ目が調声ツールの操作画面です。

手書き文字が対応する予定の歌詞。

五線譜一段目赤枠が同じ個所。

手書き文字が実際の発音タイミング。

DAWのノート、楽譜の音符、調声ツールのノートの高さと長さは基本的にはそのまま対応しています。2つ目の楽譜が読めない方でも音符の高さと長さが連動しているなぁ、くらいは判別できるかと思います。私自身楽譜がスラスラ読めるわけではありません。

前項目で定義をやたら回りくどく説明したのはこういった比較をする時のためです。

ソフトやツールごとに上下左右なんかがころころ入れ替わっていたりしたら、そのたびに説明し直さないといけません。場合によっては入れ替わっていることに気づかないまま進めてしまって、途中でワケがわからなくなる時があります。

私が参考にしている専門的な論文やレポートなんかでもたまにあります。専門家には当たり前なグラフなんかが一般人には不親切なことはあるあるです。

コチラ↓のような縦向きのピアノロールもよく見かけますね。

(バッハの年齢ごとの有名曲の再現。ただのバッハ好き。

横方向がピッチ、縦方向が時間。サムネは横方向が年齢という意味では時間(笑)。

たとえ90度右⤵に傾けたとしても、ピッチ方向は上下逆になります。)

「基本的にはそのまま対応」としたのは、厳密には変わっている部分があるからです。<歌声>回では扱いませんが気になる方もいらっしゃるかもしれませんので先に軽く触れておきます。

まずDAWの手書き歌詞とMuseScoreの楽譜の音符に当てはめた文字が違います。これが<発音>で扱う内容に関わってきます。

また楽譜では冒頭にDAWには無い「ん」が入った音符があります。これはブレス用に別個に入力した音符です。

細かいところでは楽譜の時点でDAWに入力したピッチより全音(2半音)全体が上がっています。それを調声ツール上のキー変更で全音(2半音)下げてフォルマントを0.994に調節してから出力しています。これがピッチガチャです。

<発音>回ではこういったテクニックが登場することになります。

さて、

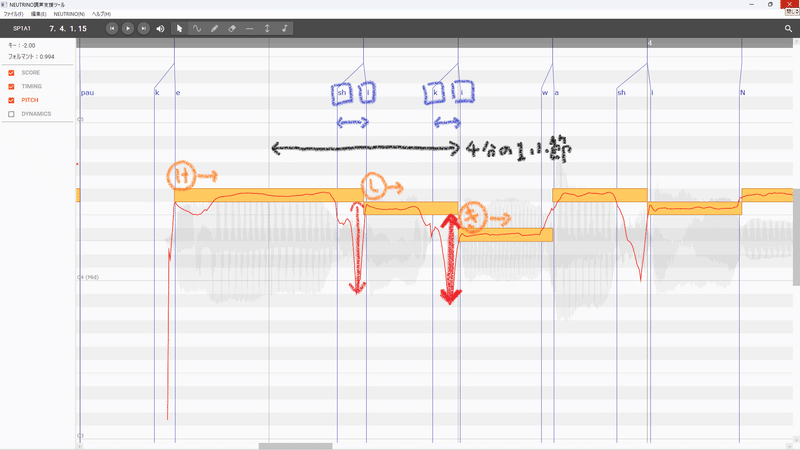

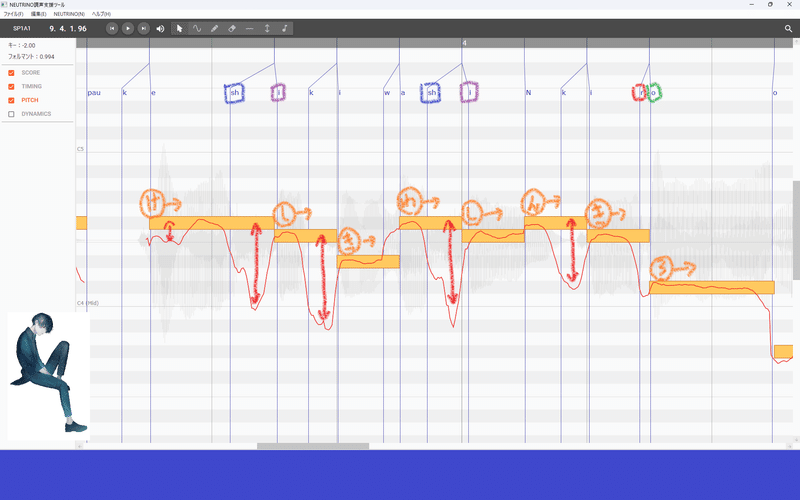

3つ目の調声ツールの画像が小さいので、歌声の特徴がよく出ている歌詞の「景色(けしき)」の部分を拡大します。基礎回で挙げたのと同じ画像です。

黄色い横棒がノート、

細く波打つ横向きの赤線がピッチ、

細い直線の縦向きの青線が各子音と母音の発音が始まるタイミング。

基礎回でも解説した通り、よくよく見てみるとDAWに対応している黄色いノートと、赤線のピッチや青線の発音タイミングはあちこちでズレています。

「け」の後半はピッチがノートから大幅に外れて下がっています。手書き赤矢印のF♯~CやBくらいまでがっつり。

音程で言うと3全音分(6~7半音分)くらい。

そして手書き黄色丸で示した実際の「し」の発音。

子音[Sh]は「け」のノートの後半、ちょうどピッチが下がり始めた位置に被るように始まっています。

さらに母音[i]までは小節の長さから逆算して約0.1秒(100ms)程度は間隔があります。手書き青矢印で示した間隔です。

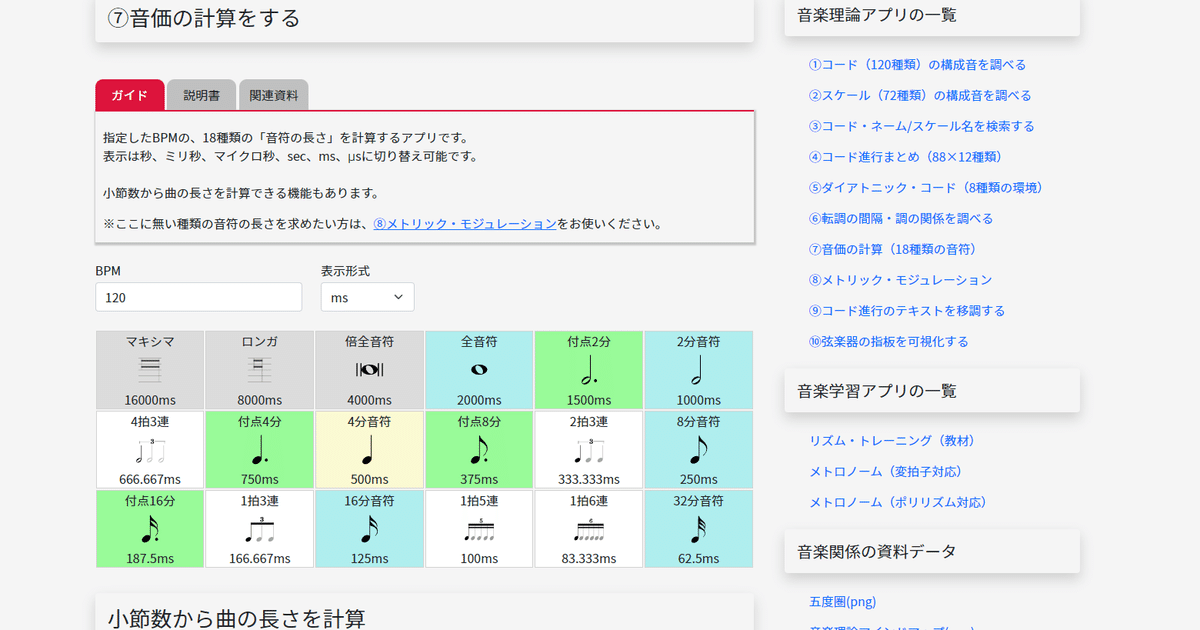

音価の逆算は以下サイトを利用しています↓

この部分だけ聴いてみます。

(SoundCloudを利用します。)

違和感ないですね。

でも画像で見た時の黄色のノートと実際の発音はピッチもタイミングもズレがある。

実は声というのはキッチリとノート通りに揃っているわけではないのです。

ズレの正体

このDAW打ち込んだノートや楽譜の音符と、調声ツールに表示されたピッチや発音タイミングとはズレがあるのに実際の歌声は合っている不思議な現象、意識して見たり聞いたりしたことはあるでしょうか?

「表示上そうなっているだけで、実はノートの高さや長さ通りに発声してるんでしょ?」と疑念のある方のために、テンポを2分の1スロー再生にしたものも用意してみました。

ゆっくりにして聴けばもしかしたら、一瞬音痴になったり早く歌っていたりしていると気づくかもしれません。

単純に半分の再生速度にするとオクターブ下がってしまうので、音が飛び飛びにはなっていますが、ピッチはそのままになるようにしています。

どうやら「し」が極端に音痴になったり、特別早く発音されている感じはないですね。

(音が飛び飛びになる理由は、周波数の高さ(Hz、ヘルツ)がピッチを決定するからです。周波数の細かさともいえます。

前項目で説明した同じ「ラ/A」でも1オクターブ違えば違うピッチという話と関係してます。抜けた音をエフェクター加工等で擬似的に補うことはできますが、今回の話題とは別なので割愛します。)

テンポや音域を変えて生成してみる

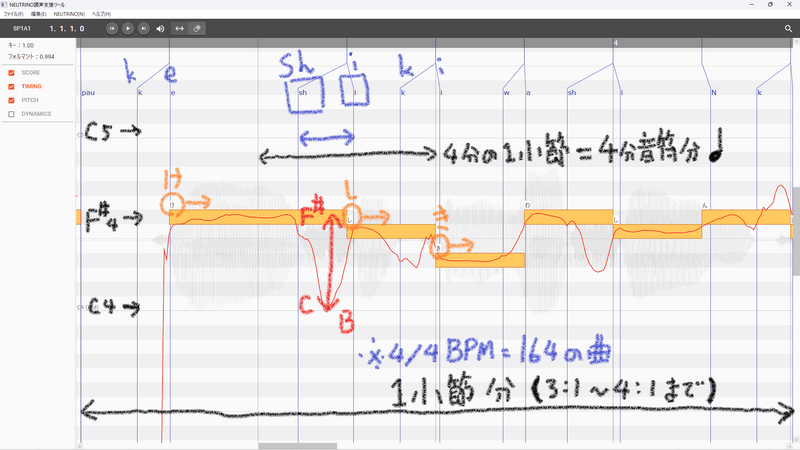

この曲は4/4BPM=164で制作しています。

今度は試しに上記再生速度と同じ早さになるように、初めから2分の1のBPM=82で音声合成してみます。MuseScore上でBPM=82に書き換えてエクスポート。再度調声ツールで音声合成。

キーやフォルマントは同じ設定のままです。

画像を確認すると、BPMを2分の1で生成した場合は「し」[Sh][i]だけでなく「き」[k][i]でも大幅にピッチが落ちていますね。

また子音と母音の間隔が小節の長さに対しては短く見えます。1小節にかかる時間が2倍になるので相対的にそう見えるだけで、実際の子音と母音の間隔は逆算してみるとそれほど変わらず100msくらいです。

聴いてみましょう。

テンポはゆっくりですが、発声自体はそこまで違和感ありません。

元とはピッチのズレ方が変わっているけれど、ただのスロー再生とは違う、ちゃんとテンポに合わせた生成がされているということです。

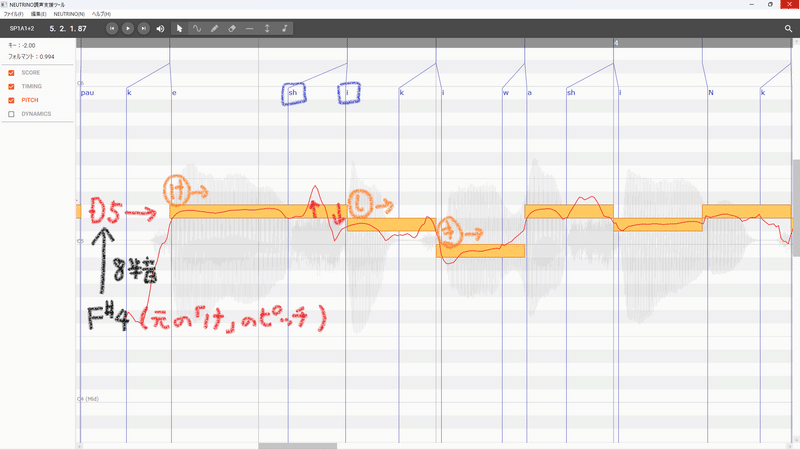

次はBPM=164に戻して8半音上(半オクターブちょっと上)に全体のピッチを上げたものを生成してみます。

MuseScoreで音符を全選択して矢印キーを上に8回押すだけ。そして調声ツールで再合成。

(ちなみにこのパートでは8半音上くらいが限界で1オクターブ(12半音)上だと生成可能な音域を越えてしまってエラーが出てしまい生成できませんでした。画像外の音符が生成可能音域を越えているようです。AIシンガーで再現できる人の声じゃないって判定なんですかね(笑) ボカロ系なら超高音もいけるかもしれません。)

元の「け」がF♯4だったのがD5まで上がっています。

画像で見ると今度はピッチの上下の仕方がまったく変わっていますね。

元は「し」の[sh]~[i]間で大幅にピッチ落ちていたのが、8半音上だと一旦少し上がって少し下がるという赤矢印のピッチ変化になっています。

あとはわずかに母音[i]のタイミングが早くなっている。

こちらも聴いてみましょう。

声は高くなりましたがピッチのズレの違和感はありません。

やはり音域に合わせた生成がされているということです。

それと声が高いからか、原曲の大人っぽく落ち着いた感じから可愛くて元気な感じが増しています。めろうさんの歌声だとは判別できるので声質はほぼ変わらず、声色が変わっている感じです。

ピッチ変化の仕方が変わっているということは癖も変わっていると考えられます。

基礎回など何度か例に出した東北きりたんの無調声の自作品『レモンキャンディー』において作曲段階から調声が始まっていると言ったのは、このテンポや音域よって発音タイミングやピッチの変化の仕方が変わるからです。それに声色にも影響する。

きりたんのような癖のある歌声の場合特に、その癖が思っていたのとは別方向に強調されたりしてしまいます。癖を特徴づけるズレの原因やポイントもわからないまま、いきなり強引に調声していくのは無謀です。

癖の少ないといわれるめろうさんですら上掲のように、テンポや音域が変わると発音タイミングやピッチのズレ方に変化が生じます。

そして声色も癖も変わってきます。

逆に言えばこの変化の傾向を把握していくと調声の自由度が増すということです。

さて、

見てきたように打ち込まれたノートと実際の発音タイミングやピッチのズレは、テンポや音域による変化の仕方に違いはあれども必ず発生するようです。

ということはむしろズレがあることでナチュラルな発声に影響を与えている可能性が高いですね。

そこでズレの正体を調べるために、わざとピッチや発音タイミングをノートぴったりに合わせてみましょう。

結構ヒドイことになります(笑)

ピッチをノート通りに生成してみる

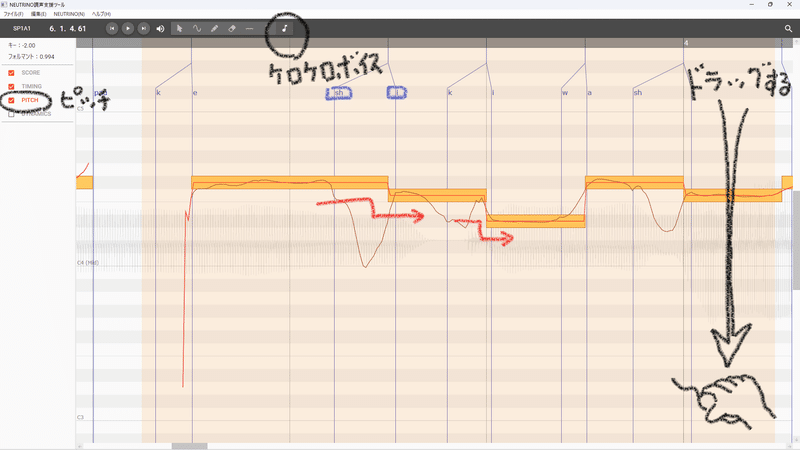

まずは試しにピッチをノート通りに調声してみます。

調声ツール左側の「PITCH」チェックボックスを欄を選んでチェックを入れ、次に上側ツールバーの一番右の♪アイコン「kerokero」(ケロケロボイス機能)を選択。なんとケロケロボイスツールは選択した範囲のピッチをノート上ピッタリに一気に変更できます。

範囲を選択してグググッと下向きか上向きに限界までドラッグすると、ピッチを示す赤線がほぼノートの中心にぴったり揃います。

元のピッチデータは茶色の線として残っています。

で、聴いてみます。

どことなく全体的にロボットのような感じが……。

「景色」の部分はそれほどでもないですが、そのあとに続く「蜃気楼」の「ろーおー」と伸ばす部分は音価が長いぶん気づきやすいのか、明らかにロボットボイスのような機械音声感が顕著です。

こういった歌声聴いたことありますでしょうか?

SEKAI NO OWARI『RPG』の頭サビなんかは特に分かりやすいです。

当然ですが、ボーカルのFukaseさんご本人が自力でこの声を出しているわけではないでしょう。できたらスゲー(笑) 頭サビ以降はナチュラルな人間の声で歌ってます。おそらくはエフェクターを駆使して実際の発声とは違う歌声に加工しています。まさに調声。ナチュラルとは逆方向ですが。

ピッチを極端に調声するとこんな風に人間のナチュラルな発声とはかけ離れた音になります。

「し」の子音[sh]が発音されているわずか100ms程度、ほか子音ではそれ以下の場合すらあるほんの数十ms程度のピッチ変化が、ナチュラルな発声に一役買っているようです。

なぜズレる?

今度は発音タイミングをノート通りに生成、

とその前に、ズレの原因を先に明かしておきます。

というか明かすも何もないんですがそれは、

歌声は人体から出る

からです。今回は本当に当たり前の話が多いですね。

人間の身体は機械のように「0か1か」「ONかOFFか」で決められるようなデジタルな仕組みではなく、なめらかに連続するアナログな物体です。

歌声に関わる発声器官といえば、口や舌や声帯などがすぐ思い浮かぶわけですが、それ以外にも肺や気道、横隔膜、腹筋背筋やら鼻腔、歯、唇などの形、頬やあごの筋肉など人体のあらゆるところが発声に絡んでいます。

それらが複雑に絡んでなめらかに動きながら歌声を出しているわけで、デジタルに一瞬で「口が開いた」「口が閉じた」みたいな動き方をしているわけではありません。

口の開き方も開く速度も、そこに送られる息の強さや量もアナログな時間的変化を伴います。それもほんの数ミリ秒といったごく短い間に。

調声ではこの人間に聴き分けられるかどうかギリギリの時間中に起こっているピッチ変化などを操作していくことになります。

ピッチを初め他の波形データも無理矢理ノート通りに合わせると、画像で見たようなカクカクしたデジタルな変化になって、機械音声のようになってしまうんですね。

あとはどのくらいなめらかにするのが適切なのか、そのズレの傾向をつかんでいけば調声のレベルアップに繋がります。

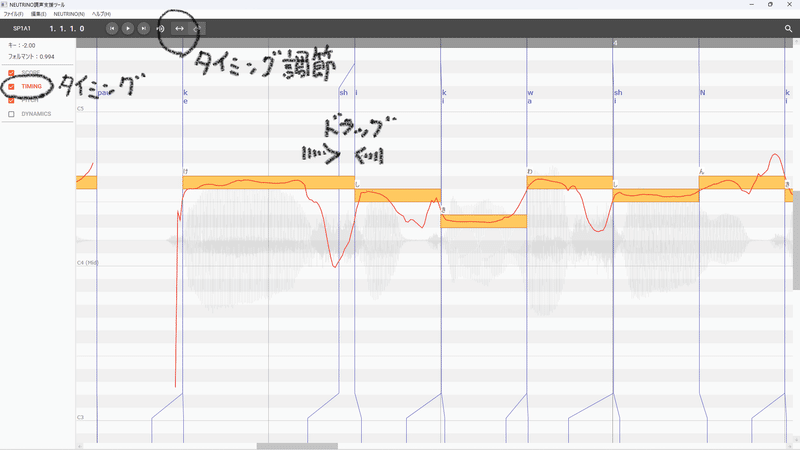

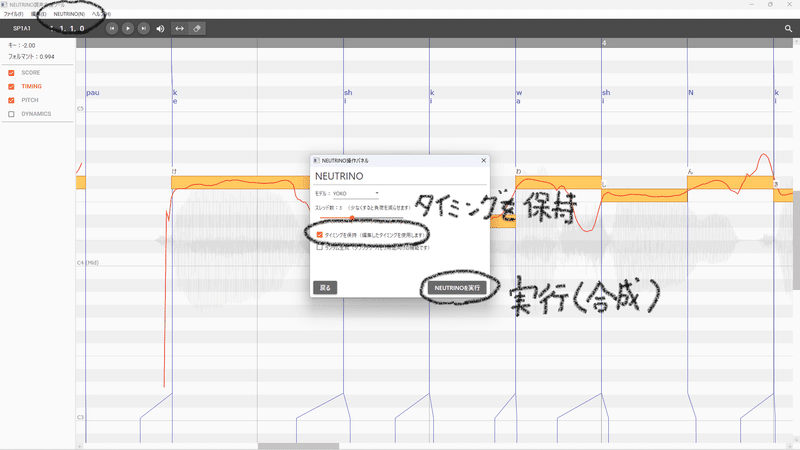

発音タイミングをノート通りに生成してみる

では今度は発音タイミングをノート通りにしてみます。

ちょっと操作が面倒にはなります。

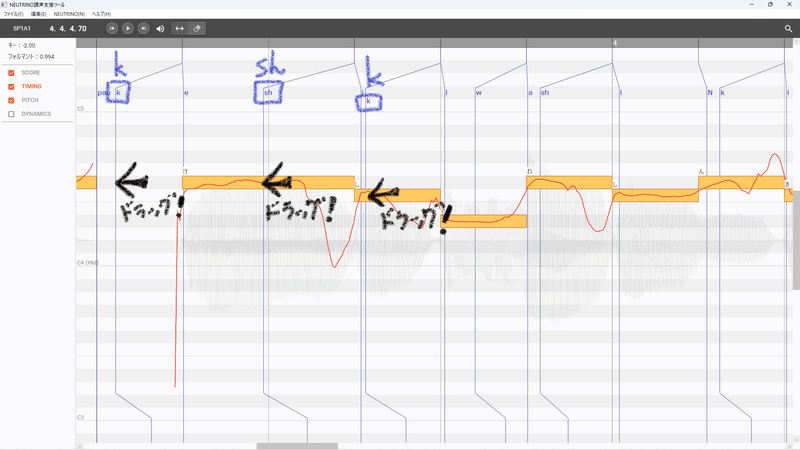

調声ツール左側の「TIMING」チェックボックスを欄を選んでチェックを入れ、次に上側ツールバーの左、タイミング調整機能の「↔(両矢印)」アイコン(Move left and rightとポップアップされます)を選択。

タイミングを示す青線をドラッグできるようになりますので、各歌詞のノートに対応する位置まで、わざと子音も母音もピッタリドラッグして合わせてみます。

すべてのタイミングをノートにピッタリ合わせたら、一から合成をし直します。

その際、「タイミングを保持」のチェックボックスを入れたまま合成します。

では聴いてみましょう。

コレハヒドイ。もはや普通の日本語のていを成していませんね。

例として挙げるのは少々はばかられますが、耳の不自由な方が発音する時のような子音の不明瞭さがあるようです。

母音とタイミングを合わせた結果、子音を決定する成分が上手く発音されなくなっていることが原因のようです。

発音タイミングをノートから外してみる

上2つの具体例はノートにピッタリ合わせたわけですが、反対にノートから外した場合どうなるか試してみます。

……が、ピッチのほうは外すと音痴になるのは当然ですね。

「ドレミ~」のピッチで歌うべきところで「レミファ~」のピッチで歌えばそりゃ音痴です。ですのでピッチを外した具体例はわざわざ挙げません。

もう一方の発音タイミングのほうをノートから大幅に外してみましょう。

子音も母音も外してしまうと音価(タイムもデュレーションも)が全部ズレてわかりにくいので、子音のタイミングのみをおよそ倍になるくらいに早めに発音させてみます。

なんというか舌っ足らずな感じになっていますね。

子音が前のめりになった分、手前の母音の発声時間、いわばデュレーションが短くなってしまっています。しかも促音(小さい「っ」)とは違って発声そのものを止めるわけではなく、次の子音を無理矢理発声しようとしているので違和感があるんですね。

子音と母音の間隔は近過ぎてもダメ、離れ過ぎてもダメだということがわかりました。

では適度な離れ具合やノートに対してどのくらい?というのがあるのでしょうか。

実は以前、別の記事ですでに触れています。

子音と母音とノートの音価の離れ具合

以前【作詞編】で仮歌を歌わせるのに「ラ行」がやりやすいと紹介しました。

ラ行は発音タイミングが早めなので、あとでちゃんと歌詞にした時とのズレが少ないです。

アタックタイミングがはっきりする「タタタ」などタ行もありですが、AIシンガーによっては「たー」が「た⤵あ⤴」のようにこぶしっぽい上がり方をすることがあります。

パ行やサ行だと逆に、短い音の連続で次の発声に間に合わないこともあります。

このへんは音声学を調べたり実際に発声してみると分かるのですが、人間が声を出す時は舌や唇などの動きで息の流れを阻害することで色んな音を出しています。

ラ行は舌先を上の歯の裏側などに当ててから素早く離す発音で、唇を使ったパ行や歯を使ったサ行などに比べて素早い発音が可能です。

「ラ行」は発音タイミングが早く、「サ行」は発声に間に合わないことがあると紹介しています。

実際に画像で見てみましょう。

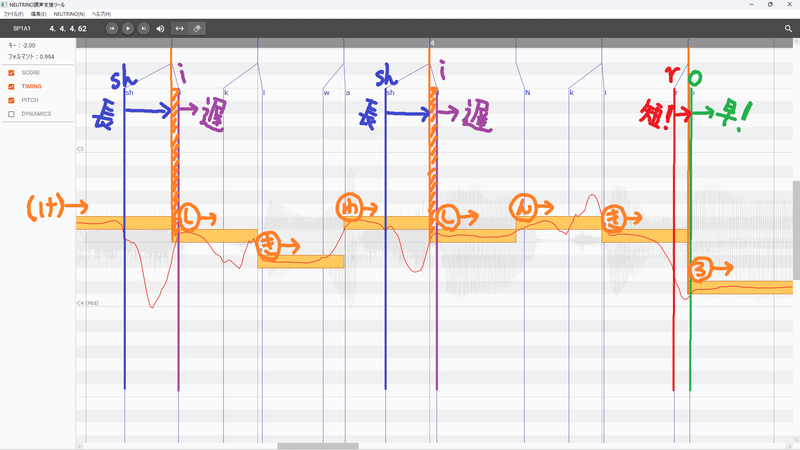

元々の「♪景色は蜃気楼」(けしきわしんきろ)と歌っている箇所です↓

サ行とラ行の違いが一目瞭然です。

「し」の子音[sh]を青、母音[i]を紫、

「ろ」の子音[r]を赤、母音[o]を緑、

縦線でそれぞれタイミングをマーカーしています。

[sh]から[i]までの青矢印と[r]から[o]までの赤矢印を比較すると長さが全然違います。[sh](青)→[i](紫)間に比べ、[r](赤)→[o](緑)間は3分の1ほどの長さしかありません。[sh][i]間が約100msくらいだったので、[r][o]間は30ms程度でしょうか。

またオレンジの縦線は歌詞に対応するノート開始タイミング、DAWで打ち込んだノートのタイムです。

母音[i](紫)はノートの開始タイミングよりオレンジの斜線分ほどわずかに遅れて発音されています。おそらく15ms程度。

対して母音[o](緑)はオレンジのノート開始タイミングとほぼ同時に発音されています。この拡大率では緑とオレンジの縦線マーカーがほぼ被ってます。

「し」(サ行)と「ろ」(ラ行)以外の他の発音も検証していくと、上のような特徴は各行ごとに似た傾向が見られることがわかります。

例えば上画像だと「わ」(ワ行、ウォも似た発音です)も発音が早くタイミングも近い。「き」(カ行)は中間くらい。

画像外も調べてみると、ガ行タ行ナ行などがやや早い部類、パ行マ行は中間からやや遅め。ア行は子音が無いのでノート開始タイミングとほぼ同時の場合が多いようです。

(母音や前後の発音の影響もあるので絶対ではないです。

また「ふ」「ファ」のようなハ行の仲間とされていても、音声学上は子音が違うものもあります。)

他の歌詞パートなども確認して五十音全体で比較すると、やはり「ラ行」が特に早く「サ行」が一番遅い傾向ありました。

そこでこれらの比較から以下のような法則が考えられます。

「サ行」

子音の発音タイミングが早めで、長さが無いとサ行だと判別しにくい。

母音はノートの開始タイミングより遅れがち。

「ラ行」

子音は短くてもラ行だと判別できる。

母音はノートの開始タイミングとほぼ同時。

発音の行ごとにいわば音価(タイムとデュレーション)が変わってくるということですね。

「サ行」と「ラ行」は特にその差が大きい。

ということはナチュラルな調声を目指すなら、子音と母音の間隔を「サ行」で短くしたり「ラ行」で長くしたりすると不自然になるということがわかります。

ラ行とサ行の小話

各行・各発音の詳細はまた<発音>回で見ていきますが、そのハシリでちょっと寄り道します。

【作詞編】よりずっと前から考察していた、鼻歌や仮歌に関することの自分なりの回答です。

どうやら鼻歌や仮歌は「ラ行」が歌いやすいし歌わせやすい。

それは「ラ行」が、思い浮かんだメロディーと実際の発声のズレが少ないから直感的に対応できる、

そして仮歌が歌わせやすいのは、DAW上で入力されたノートと合成音声のタイミングのズレが少ないからではないかと考えています。

「サ行」だと感覚とのズレが大きくなります。実際はほんの数ミリ~数十ミリ秒の差なんですがそれが意外と大きな影響を与えているようです。

また【作詞編④】で「スキャット」について書きましたが、スキャットによく使われる子音を挙げてみると

「ラララ」「ルルル」などラ行、

「Ah」「Uh」「Oh」などア行、

「Wow」「ウェイ」などワ行(Wの発音)

などの発音タイミングが早くてズレの少ない発声を使ったものが特に多く、

パ行など遅め発音でも「パララ」や、

単体では早くても連続だと発音しにくいタ行を「タラリラ」など

ラ行と組み合わせるパターンが多いことに気づきます。

「トゥトゥトゥ」「ハフホ」などタ行・ハ行系統だけの場合は、連続した素早いスキャットではなく「トゥートゥートゥー」「ハッフッホー」のように長音や促音の組み合わせが多いようです。

また「ふふふーん」と表現されるいかにもな鼻歌は、実際の「ふ」の発音ではなく口をつぐんだハミングです。息は口ではなくまさしく鼻から出ています。

問題のサ行の場合、近い系統で「シャ」の「シャララン」などラ行との組み合わせパターンはありますが、「サスソ」のようなサ行単体のスキャットはまず聴くことがありません。「ススス」なんかだと息の漏れる音が大きくて、歌声として聴けたものではないです(笑)

おそらく鼻歌もスキャットも無意識に発音しやすい音を選んでいるのではないかと思われます。

ついでにサ行とラ行で少し面白い実験をしてみましょう。

サ行とラ行の発音タイミングのズレを、歌声ソフトではなく人体で体験することができます。

それではサ行からは「さ」、ラ行から「ら」を使ってみましょうか。

①「さら」と②「らさ」をそれぞれ、ご自身で発声を素早く繰り返してみてください。

どちらも母音は[a/あ]で唇をくっつける必要のない発音なので、口を開きっぱなしで言えるはずです。

①「さら、さら、さら、さら……」

②「らさ、らさ、らさ、らさ……」

どうですか?

「さ」と「ら」が入れ替わって連続しているだけなのに、なぜか①「さら、さら……」は言いやすく②「らさ、らさ……」は舌がもつれるような感じがあると思います。

人によっては②「らさ、らさ……」がいつの間にか①の「さら、さら……」になっていたり、②が「らっさ、らっさ……」と促音「っ」が入ったような発声になってしまうかもしれません。

それは上で検証した特徴が無意識で影響しているからだと思われます。

②「らさ」の場合、後の「さ」をはっきりを発声しようとすると早めに子音[s]を開始して母音[a]の開始まで長く時間を取らざるを得ない。なので舌がもつれたり、時間を確保しようと促音のような間が入ったりしてしまうようです。実際は「っ」ではなく子音[s]の歯と歯の間から空気が漏れる音(歯擦音)が入っています。

①の「さら」もどんどんペースを速くしていくと「さぁ、さぁ……」のように「ら」の子音[r]の発声が曖昧になります。「さ」が遅過ぎるせいで、「ら」の子音[r]が喰われて母音[a]だけ残るみたいですね。

どうにか「ら」をはっきり発音しようとすると②と同じく「さらっ、さらっ……」と促音のような歯擦音が入ります。

それでは調声の話に戻ります。

こういった各行や各発音ごとの子音と母音の離れ具合やノートとのズレの特徴が、ぼんやりとでも分かってくると、なぜナチュラルに聴こえたり聴こえなかったりするのかその原因がわかってくるようになります。

そしてここから先はシンガーの歌い方の特徴や癖によります。

同じサ行やラ行だからといって、傾向はあれど一概にすべてのシンガーが同じ発音タイミングになるわけではありません。

「らさらさ」で舌がもつれる人もいれば「らっさらっさ」と対応する人もいるし、「さぁさぁ」と曖昧に発声する人もいれば「さらっさらっ」とはっきり発音する人もいるみたいなもんです。

ただし、歌声ソフトに選ばれる歌手や声優さんは声のプロですので、正確な発声を身に付けた上で、ご自身の出せる声質、声色、癖などを意識した状態で録音されていることだと思いますので、舌がもつれた声など収録するはずもありません。

というわけで、ここからはそんな歌い方や癖がどんなふうにピッチやタイミングの違いとして出てくるのか、シンガーごとの違いを見てみましょう。

同じ歌詞を別のシンガーに歌わせてみる

まずはNEUTRINOオリジナルキャラでも一番癖が強いであろうセブンちゃん。

キーやフォルマント設定は変えずにそのまま音声合成したものです。

明らかにピッチの乱高下が激しいですね。

しょっぱなの「け」からピッチが上がってますし、「けしき」の「し」は落ちているのに、「しんきろー」の「し」は逆に8半音くらい跳ね上がっています。前後の流れによっても変わるんですね。

ただそれでも、発音タイミングの傾向はやはり「し」と「ろ」では同じように遅れたり早かったりしています。

聴いてみましょうか。

一応、心しておいたほうが良いです。めっちゃウルサイ(笑)

元気良すぎ! めろうさんがやる気ないように感じるくらい(泣)

曲調としてはありっちゃありですね。結局は好みです。

次はもうひとりNEUTRINOオリジナルキャラで唯一の男性、ナクモくん。

全体的にピッチが下がっている部分が多いです。

歌い出しの「け」や「しんきろー」の「し」はセブンちゃんとは真逆にピッチが下から上がってくるようになっています。

変化のカーブ自体はギザギザしたセブンちゃんに比べると緩やかですが、それでもめろうさんと比べると下がり方が激しいです。

それと、やはり「し」や「ろ」の発音タイミングは他のシンガーとも同様の傾向がみられます。

歌を聴いてみましょう。

そこそこパワフルでロックバンドグループのシンガーって感じですね。

ところどころ入る自然なビブラートもあります。

ただ女声音域で作曲した曲なので後半はやや息がきつそうですし、おそらくこのままサビまで行くと、とてもじゃないけれど普通の男声では歌えないでしょう。不自然な裏声になると思います。

ですので作曲段階でキーから変えないといけません。

となると、他の楽器類の音域も変わってきますし、ギターやベースであれば運指も変わってしまいます。そもそも音域の関係で使えない楽器も出てくるかも。ほぼゼロから打ち込み直すレベルです。

調声どうこうの話ではないですね。

やはり作曲段階から調声は始まっています。

ピッチ+音価(発音タイミング)がすべてではない

ところで、めろうさんにしろセブンちゃんにしろナクモくんにしろ、ピッチはそれぞれ特徴が目に見えて判別できましたが、発音タイミングはどうでしたか?

わずかな違いはありますが、ほとんど同じような傾向だったと思います。

それがナチュラルな発声に繋がっているので、調声で極端にいじることはそうそう無いということです。

それなのに声のパワフルさや声色の特徴、感情表現はかなり違いましたね。

何が違うのでしょう。

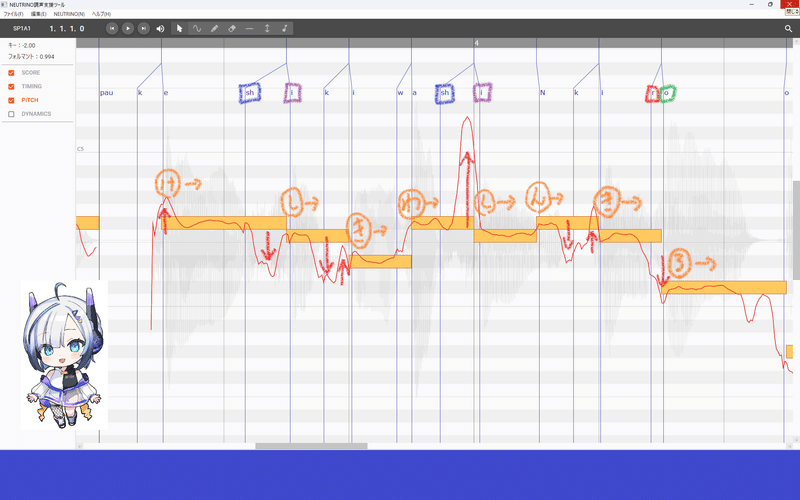

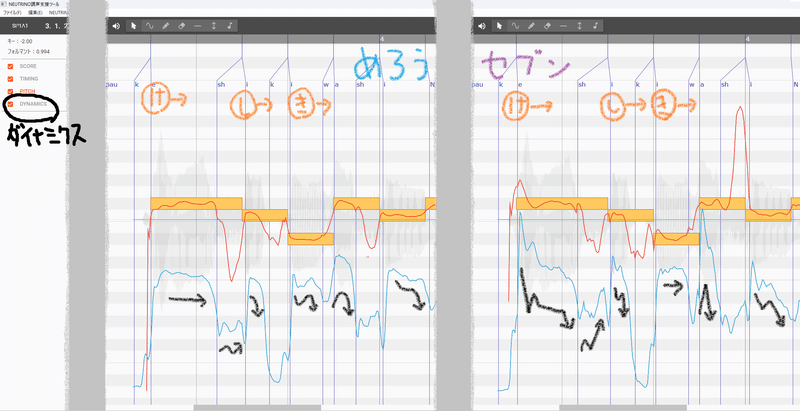

比較しやすいめろうさんとセブンちゃんの調声ツール画面を並べて見ます。

左がめろうさん、右がセブンちゃんの同じ「けしき」の箇所です。

並べると発音タイミングはそれほどではないですが、ピッチ変化の違いはかなりあることが改めてわかります。

それとお気づきでしょうが、表示されるデータを増やしています。

調声ツールの左にDYNAMICS(ダイナミクス)という項目があります。

そこにチェックを入れると、下側にピッチとは違う水色の波線が出てきます。これが音圧、つまり音のパワフルさに関わってきます。

手書きの黒線でおおまかなダイナミクスの流れを描き加えています。

全体的に緩やかに変化しているめろうさんに比べて、セブンちゃんのほうはピッチと同じくギザギザでかなり乱高下している。

めろうさんの落ち着いた優しい感じと、セブンちゃんのパンチのある元気な感じの差はもしかしたらこの差が……。

結び&次回予告

と、面白くなってきたところで今回は区切ります!

とっくに1万字超えてしまった。

今回はDAWでの曲制作におけるノートの打ち込みに相当する部分でした。

今回の内容でDAW上のノートのピッチと音価と歌声は

連動してはいるけれどぴったり合っているわけではない、

ということがご理解いただければ充分です。

むしろそのズレがナチュラルな発声の第一歩です。

ピッチについては【調声編】後半の<抑揚>の回で改めて取り上げていくことになります。

さすがにケロケロボイスだけでは解説が不十分ですからね。

どんなピッチ変化がコブシ、シャクリ、フォール、そして花形のビブラートに繋がっているのか、まず今回の内容でピッチがいじれることと、いじることによって癖が変わることを覚えておいてください。

音価つまり発音タイミングや子音・母音については、今回の内容ですらまだまだ大まかな概要レベルです。

詳しく突き詰めていくとガチの音声学になってしまいますし、私の知識と所持ツールでは解説に限界がありますが、改めて<発音>の回で出来る限り取り上げていくことになります。

発音タイミングは基本的には歌声ソフトやシンガーの音源の性能に依るところが大きいです。ですのでナチュラルな発声という意味では極端にいじることは少ない。下手にいじって不自然になることも……。

でも、曲のテンポに応じた適切な発音タイミングを知らないと、速過ぎて発声が間に合わなかったり、遅過ぎてねちっこく歌ってしまったりということが起こり得ます。

逆にタイミングが調整できると知っていれば、本来それほど得意ではないテンポの曲なんかでも調声で対応できるということです。

また今回はまだ取り上げなかったブレスや休符にも音価があります。

息継ぎやハシリやタメが全くない歌声はやはりどこか機械的で不自然です。発音タイミングは、ナチュラルさや表現力をアップさせるなら避けて通れない調声の要素になってきます。

そして次回は、落ち着いた優しさやパンチのある元気良さなどキャラクターを特徴付けるダイナミクス、そしてそれに絡む歌声のアタックやトランジェントの要素について解説していきます。

今回がノートのピッチと音価なので、次回はいわばベロシティです。

しかし単純な音量(ボリューム)変化ではない。

また扱いの難しい今回の発音タイミングと次回のダイナミクスを押さえておかないと、<発音>回で扱う予定の「です」「ます」などの語尾で母音が消失するナチュラルな発声や、子音単体オンパレードのカタカナ英語や外来語の調声に手が付けられません。

なかなかの道のりですが、少しずつ積み重ねていきましょう。

それではまた次回。

(できる限り早めに……がんばるぞい。)

Thank you for reading!

この記事が気に入ったらサポートをしてみませんか?