Air Street Capital社のState Of AI Report 2023を読む(9)

昨年(2022年)の11月のChatGPTの登場で俄にAIが話題になってますが、この技術は突然現れたわけではなく、かなり昔から研究は続けられた結果が今日に至ってる、と考えるべきです。

今のAIは第3世代、と呼ぶ人も多く、思えばLISP, Prologといったルールベースの言語を学んだ時代もほのかに思い出します。(個人の思い出)

今のAIを語る上で、その原点と呼ばれる、Transformer Modelと呼ばれる技術があります。この技術は、2017年に発表された、"Attention is All You Need" と呼ばれる論文で定義された、ディープラーニングのアーキテクチャです。

ご興味がある方はこの論文や、さらにFoundation Modelの提唱に発展させているスタンフォード大学のこの論文を読解いただければ内容は理解できると思いますが、大方の人には難解ですのでいくつか日本語訳して優しく解説してくれてる記事を参照したいただければ良いと思います。(けっこういっぱいあります)

どうも大事なのは、"Attention" と呼ばれるキーワードで、自然言語を処理する際に、入力される文章の中で大事な言葉が何なのか、ということに注目できるようにその大事な言葉に重みづけ (Attention) をつける手法だそうです。

我々が写真を見るときに、その写真の一番大事なアイテム(被写体など)に注目するのと同じように、コンピュータに注目すべき大事なポイントを教えてあげる、ということによって、自然語処理が非常に効率よく処理できるようになる、ということがこの論文の画期的なところだそうです。

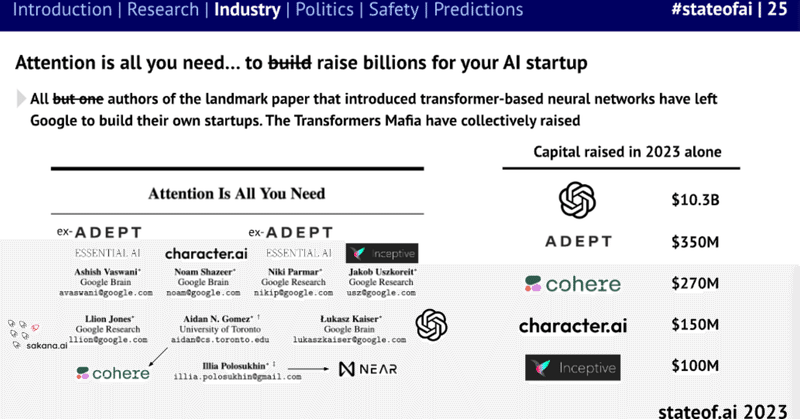

もっと大事なのは、この論文の執筆者がほぼGoogleの研究者で、このTransformerの技術はいずれGoogleの中でGoogle Translateで採用されたり、BERTの母体になったりしてますが、興味深いのは、この論文の執筆者は全員既にGoogleを退社して、それぞれAI系のスタートアップとして独立していて、巨額の出資を受けている、という点だ、ということがレポートで報告されてます。

どんな斬新で革命的な技術も、地味な研究から端を発している一例だと思いますが、それをどう発展し続けるか、ということが一番大事で、そのためにも一箇所にとどまるのではなく、新しいニーズ、異なる環境に常に飛び込み続けることができるのが米国のIT業界の原動力なのかもしれません。

この記事が気に入ったらサポートをしてみませんか?