Ubuntu環境とMacOSでOpen Interpreterで行った実験

実行環境情報

$ lsb_release -a

No LSB modules are available.

Distributor ID: Ubuntu

Description: Ubuntu 22.04.2 LTS

Release: 22.04

Codename: jammy

$ uname -srvmpio

Linux 6.2.0-32-generic #32~22.04.1-Ubuntu SMP PREEMPT_DYNAMIC Fri Aug 18 10:40:13 UTC 2 x86_64 x86_64 x86_64 GNU/Linux

$ sudo lshw -class processor

*-cpu

詳細: CPU

製品: Intel(R) Core(TM) i9-7900X CPU @ 3.30GHz

ベンダー: Intel Corp.

物理ID: 57

バス情報: cpu@0

バージョン: 6.85.4

スロット: LGA 2066 R4

サイズ: 1200MHz

容量: 4300MHz

幅: 64 bits

クロック: 100MHz

$ lspci | grep -i nvidia

17:00.0 VGA compatible controller: NVIDIA Corporation GP104 [GeForce GTX 1070] (rev a1)

17:00.1 Audio device: NVIDIA Corporation GP104 High Definition Audio Controller (rev a1)

65:00.0 VGA compatible controller: NVIDIA Corporation GA102 [GeForce RTX 3090] (rev a1)

65:00.1 Audio device: NVIDIA Corporation GA102 High Definition Audio Controller (rev a1)

Open-Interpreter インストール

conda create -n interpreter python=3.11

conda activate interpreter

pip install open-interpreter

set FORCE_CMAKE=1

set CMAKE_ARGS='-DLLAMA_CUBLAS=on'

pip install llama-cpp-python --force-reinstall --upgrade --no-cache-dir -vv

起動

$ interpreter --localローカルモードで動かすので必要なパラメーターを選択

codellamaのパラメーター数を選択させられるので私は34Bを選択しましたQualityはHigh GPUは使用するYで回答します

Open Interpreter will use Code Llama for local execution. Use your arrow keys to

set up the model.

[?] Parameter count (smaller is faster, larger is more capable): 34B

7B

13B

> 34B

[?] Quality (lower is faster, higher is more capable): Low | Size: 14.21 GB, RAM[?] Quality (lower is faster, higher is more capable): Medium | Size: 20.22 GB, [?] Quality (lower is faster, higher is more capable): High | Size: 35.79 GB, RAM usage: 38.29 GB.21 GB, RAM usage: 16.71 GB

Low | Size: 14.21 GB, RAM usage: 16.71 GB

Medium | Size: 20.22 GB, RAM usage: 22.72 GB

> High | Size: 35.79 GB, RAM usage: 38.29 GB

[?] Use GPU? (Large models might crash on GPU, but will run more quickly) (...: Y

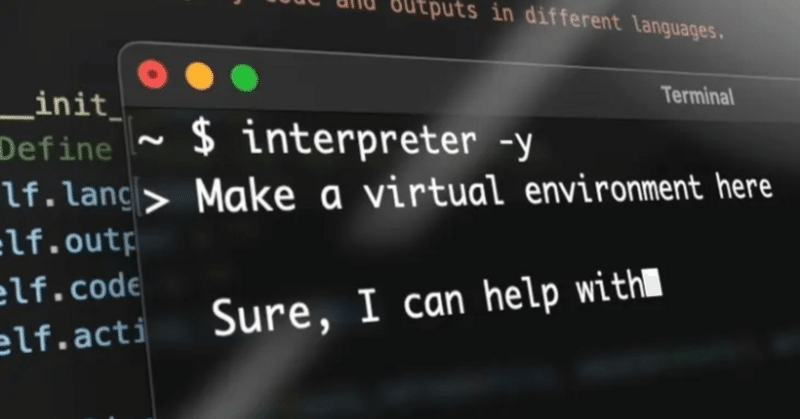

適当にやってほしいことを入力するとコードを作ってくれて実行していいか確認されます

interpreter -y --localとかで実行していたら確認をすっ飛ばして全部やってくれる模様

まだ色々やらないと分かりませんが

当然GPT3.5とかと比較してもcodellama34Bはそれほど汎用性に優れている訳ではない感じがします。私はやってませんがGPT4に接続して実行するモードがあるので本当にユーザーの実用性やメリットを考えるならGPT4のAPIを使用して完全にAI専用のマシンを使って開発したりすると仕事が爆速で完了して神の様なコードとプロダクトが作れたりするのかも知れません。

もうちょっと遊んで面白いことがあったら情報更新します

追記:Macの場合も概ね同様の手順で起動できた。

LinuxもMacも前提としてconda環境がインストール済みの環境でのインストール手順です。

実行環境:Mac OS 13.4.1 (c)(22F770820d)

インストール

conda create -n openinterpreter python=3.11.4

conda activate openinterpreter

pip install open-interpreter

pip uninstall llama-cpp-python -y

CMAKE_ARGS="-DLLAMA_METAL=on" FORCE_CMAKE=1 pip install -U llama-cpp-python --no-cache-dir

pip install 'llama-cpp-python[server]'起動

お天気情報をスクレイプするコードを書いてもらいましたがbeautiful soup 4は自分でインストールしてねと言われます。

この辺GPT4なら自分でやってもらえそうですね

参考

https://github.com/KillianLucas/open-interpreter/blob/main/docs/GPU.md

open-interpreter/docs/MACOS.md at main · KillianLucas/open-interpreter (github.com)

この記事が気に入ったらサポートをしてみませんか?