マーケターの皆様、質問があります。データってそんなに万能ですか?

なんだか偉そうなタイトルを掲げてしまい、大変申し訳ございません。まずは謝罪させてください。

かれこれ3年ぐらい前から気になっていたのですが、どうしても表現できる言葉を持ち合わせていなくて、ずっとモヤモヤしておりました。

が、自分の疑問を表現できる適切な言葉が一向に浮かんできませんので、以前からずっと感じていた疑問をとりあえずnoteに記そうと思い立ちました。

改めて、失礼を承知で、こんな質問をさせて下さい。

Q.マーケターの皆様、質問があります。

データってそんなに万能ですか。それでマーケティングのための仮説って浮かびますか。無理してませんか。仮説が浮かば無い=ダメなマーケターみたいな烙印に、「なんでやねん!」って言うべきじゃないですか。

現在におけるマーケティングの現状

先週、電通イージス・ネットワークが「2019年は、世界のデジタル広告費が広告費シェアの41.8%を占め、テレビ広告を引き離す」というプレスを発表していました。

電通の「日本の広告費2018」を読む限り、今のところテレビとネットの二強時代ですが、早晩そうなるのでしょう。

2020年には、ネットがテレビを追い抜くのではないでしょうか。

振り返ってみると、私が新卒で入社した頃の2007年はアドテク勃興前で、インターネット広告を活用したマーケティングは、そのままネットマーケティングなんて呼ばれていた記憶があります。

こんな状況、全く予想できませんでした。

いつしかネットマーケティングからデジタルマーケティングと呼ばれるようになり、「インターネット広告はテレビを追い抜くね」と言われるようになったのは、いつ頃でしょうか。恐らくアドテクが日本国内に輸入されて、本格的に浸透した2012〜13年頃だったでしょうか。

デジタルマーケティングの定義については、以下の「顧客を知るためのデータマネジメントプラットフォーム」が参考になります。6年前くらいでしょうか、当時は夢中になって何度も読み返しました。

筆者が考えるデジタルマーケティングとは、「デジタル施策によって得られるデータを活用して、マス、リアルを含めたマーケティング全体を最適化する試み」と言える。

従来のマーケティングは、主にマスマーケティングとダイレクトマーケティングに分けられる。そして、コミュニケーションメディアであり販売チャネルでもあるインターネットを使ったオンラインマーケティングやネットワーケティングと呼ばれるものは、ダイレクトマーケティングの中にあって、ネットの世界を最適化するものであった。

しかし、「デジタルマーケティング」は、単にネットの最適化を目指すだけではない。マス、デジタル、リアルのすべての接点におけるマーケティングコミュニケーションと、商品開発、価格戦略、チャネル戦略すべての最適化のために行われる活動である。

※太線は松本による。以降も同じ。

デジタル施策とは何もインターネットに限らないのです。ネットマーケティング≠デジタルマーケティングだと考えるべきでしょうか。手段より上位の包括的な概念が「デジタルマーケティング」を指すかもしれません。

いまやIoT・スマホの浸透によって、「マス、デジタル、リアルのすべての接点」においてデジタル施策を遂行できる環境が整っています。すべからく殆どのマーケティングはデジタルマーケティングが内包すると考えられます。

それにしても「データを活用する」とは少しザックリな意見です。その内容については、ページをめくると詳細が書かれています。

たとえば、何百万人というレベルでの行動(リアルな消費行動履歴、ネットでの行動履歴など)を分析することで、特定の商品カテゴリーへの関心を顕在化し、購買行動の予兆を浮き彫りにできる可能性がある。

自動車や住宅のような比較的自己関与が高い商品カテゴリーでは、関心をもつ人(ユーザー)を特定していく手法は有効だが、比較的自己関与が低い衝動的購買型の商品カテゴリーでは、購買対象者は広く、むしろ購買衝動がどんな時に起こるかを分析したほうがよい。衝動の起こるパターン分析から、その予兆を見出し、予兆が起きたタイミングにコミュニケーションできる仕組みをつくることで大きな効果が得られるようになる。

(略)

このようにマススケールでのワントゥワンマーケティングを実現するためにベースとなる仕組み、それがDMP(データマネジメントプラットフォーム)である。

僕の記憶が確かならば、この本を前後してデジタルマーケティング業界に空前のDMPバブルが発生し、猫も杓子もCookieSyncでした。今ではさらに進化してCDPバブルが訪れているようです。

DMPを活用したセグメント配信、DSPと連動した新規顧客獲得、プライベートDMPを活用した顧客分析、CRM/POSと連動した購買分析、SFA/MAと連動したリード獲得…。

色んな試みが各所で行われたと記憶しています。連携しましたPRや始めましたPRだけでもMarkezineに取り上げられ、「すげぇ!」「いいな!」「うちも何かやらないと!」と思っていました。

データはすごい! データは価値がある! データで何でもわかる!

そんな風に思っていたこともありました。

データサイエンスの重要性を痛感して大学院で"学び直し"を始めてから、データなんて全然凄くない、数字そのものには価値が無いと気付きました。

私はデータに対して勝手に過信していたのです。

過信①データは意味がついて初めて価値を持つ

先日、こんなtweetをしました。

データ分析する人のほとんどが、この絵を見て「これはウサギだ」と勝手に解釈して手を動かし始める。納品間近になって「このアヒルはね」と言われて焦る。同じデータを見ていても認識が違うなんてしょっちゅうある。データ項目まで書かれているのに、意味が違うなんてことも…。 pic.twitter.com/lBMzHZbo7P

— 松本健太郎 (@matsuken0716) June 14, 2019

このウサギにもアヒルにも見える画像について、諸隈元シュタインさんという方のtweetで「歴史が古い話」だと知りました。なんか何も分からずtweetしてすいません…。

これが元ネタ

— 諸隈元シュタイン (@moroQma) March 11, 2019

ドイツの風刺雑誌に載ったこの絵「Kaninchen und Ente」を、米国の政治誌が転載し、それを心理学者J.Jastrowが「rabbit and duck」と紹介

ドイツ語のEnteには「鴨」の意味もあるため、ヴィトゲンシュタインがこの絵のアスペクトの一面をアヒルではなく、カモ"として"見ていた可能性もある pic.twitter.com/k1GkdOokVC

話を本題に戻します。

データ=数字というのは大嘘で、数字を定義するラベル、表頭表側が全てだと考えています。データ=数字+国語(意味付け)だと思っています。

十数年前ドツボに落ちた経験があります。某アクセス解析ツールの滞在時間データです。

あるWEBサイトの分析をしていて、1ページあたりの平均滞在時間の長さに着目しました。確か4分ぐらいだったでしょうか。やっぱり長いな〜さすがインターネットだな〜と思っていたのですが、よくよく調べてみると「ただし直帰数は除く」とありました。

そりゃそうで、タグで計測しているんだから、ページAを見た時間、ページBを見た時間、その差分が「滞在時間」になります。どのツールもだいたいそうなっているでしょう。そういえば営業の人と「直帰数含めて滞在時間を出せ」と言われて喧嘩になりましたっけ。

問題は直帰率が平均95%超で、大半のユーザーの滞在時間を計れていない点にありました。残念ながら「4分」の意味が瞬時に変わってしまいました。

ちゃんと調べていない私がダメなのですが、「数字について考える前に、指標の定義、測り方を理解してから数字を見ないといけない。数字自体に意味は無いんだ」と実感しました。それがデータに興味を持ったキッカケでもあります。

過信②今あるデータは全てではない

2018年2月に刊行した「誤解だらかの人工知能」にも挿入したエピソードなのですが、エイブラハム・ウォルドの話が凄く好きです。

彼は第二次世界大戦当時、米軍のために、効率的な魚雷の発射法やミサイルの空力効率などの分析に従事していました。そんなある日、爆撃機を強化する装甲が必要な場所の、優先順位を考える任務に就くことになりました。

空軍が手間をかけて、無事に帰還した爆撃機の破損状況を調べていたため必要なデータは揃っていました。爆撃機の損傷には明確なパターンがあり、その多くは翼も胴体も蜂の巣のように穴が開いていましたが、コックピットと尾翼にはその傾向がありませんでした。

その当時のデータは現存していませんが、だいたいこんな感じだったというイメージ図が語り継がれて残っているみたいです。Twitter上で何年かに1度バズってる以下図。赤が破損状況です。

『ワシが小学生の頃はエアコンなんぞ無かったが、現にこうして生きておる。エアコンなんざ不要じゃ』

— エリック (@eroric) July 19, 2018

みたいな論理を展開されている方にご覧頂きたい図があります。赤点はWW2で帰還した爆撃機が被弾した場所を示しているそうです。 pic.twitter.com/AHgdAmNlz4

ちなみにミリオタ界隈では「これ爆撃機じゃない」らしいです。そうか、ごめんなぁ。許してやったら(↑)どうや(↓)。

ウォルドは今手元にあるデータが「帰還した爆撃機のデータ」のみであり、「帰還しなかった爆撃機のデータ」が含まれていないことに気付いたため「むしろ被弾していない箇所の装甲」を要請したそうです。

被弾していない箇所のデータが手元にある=被弾すると帰って来れないからデータが手元にない、という洞察です。

このエピソードは「生存者バイアス」として語られていますが、分析の観点から考えても強い示唆を得られます。

今あるデータが全てとは限らないのです。むしろ不足している場合が多い。どれだけ分析の目的がはっきりしていたとしても、結論に至らない可能性があるのです。

今度、ある媒体で「データから"真実"を読み解くスキル」という連載を始めるのですが、事前の下調べで「有効求人倍率」を調査していました。

データ上は有効求人倍率(全体)、有効求人倍率(除パート)、有効求人倍率(正社員)と3種類あります。ところが調べてみると雇用形態は正社員、パートタイマー以外にも、アルバイト、契約社員、期間工、労働者派遣事業(登録型派遣、常用型派遣)、請負、嘱託と様々あります。

なぜ有効求人倍率はこの3種類なのか? パートとアルバイトの違いは何なんだ? なぜ各雇用形態単位の有効求人倍率が作られていないんだ? 疑問が尽きませんでした。

何があるかを知る以上に、全体を俯瞰して「何が作られていないか」を知れば、データの作り手の「思惑」や「計測現場の実情」が浮かんできます。

■過信③検証は出来ても仮説は浮かばない

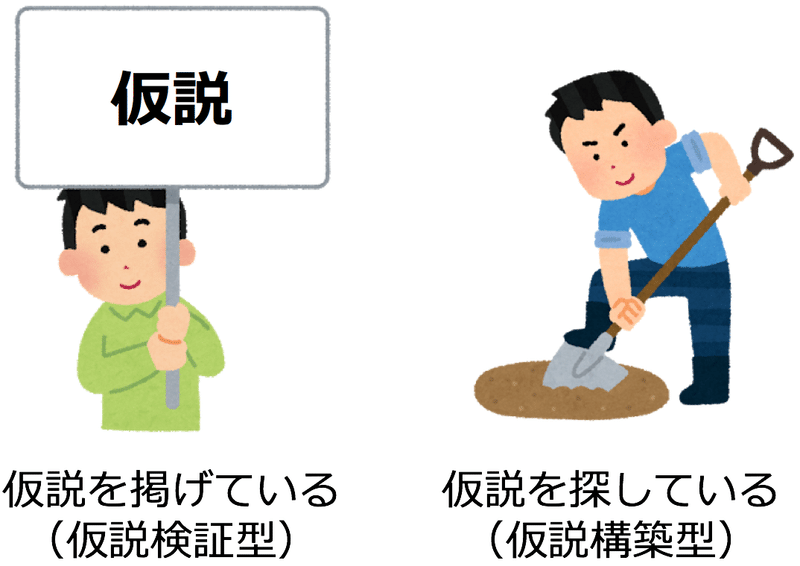

データ分析は2種類に分けられると思っています。仮説検証型と仮説構築型です。「Exploratory Data Analysis」と「Confirmatory Data Analysis」の違いと言えるでしょうか。

私は、検証すべき仮説が分かっている=見えている状況(仮説検証型)と、検証すべき仮説を探している=見えていない状況(仮説構築型)と置換して考えています。

ちなみにマーケティングリサーチも、どちらかに分類されると考えます。そして定量・訂正含めて仮説検証型が多い。調査モニターに「こんな商品イケてる?」と聞く定量調査か、「これ触ってみて」と完成品を見せるFGIが大半を占めていると思います。

分析も同様に「仮説検証型」が多いと思います。もう仮説は浮かんでいて、それをデータで分析したい、と。ただ、その「仮説」自体がデータ分析をする前から怪しくて「それ破綻してません?」と見直すと、仮説から作り直す場合も多々ありますが。

DMPに蓄積された消費者データをとりあえずクラスタリングして、クラスタ単位で広告配信をするだけなら「仮説検証型」タイプの分析です。

しかし、その手前の「どんなクラスタを作るか?」という仮説がなかなか浮かばなくて困るのです。まぁ最初は性・年代・職業・趣味嗜好で良いかもしれません。けど、そこから先が続かない。いっそAIに任してしまって「理由は分からないけど、こうしたら良いってなりました」と言えれば潔いんですけどね。

「仮説」を探してデータの海に航海して、そのままメンタルをやられて海に沈んでいった人を数人、私は知っています…。

殆どのDMPプロジェクトが上手くいかなかったのは、仮説構築の責任をデータサイエンティストに任せてしまったからではないか、と思う機会はあります。顧客の不完全な出所不明のデータをポチポチ眺めているだけで、勝手に膨大な仮説がワーッと浮かぶなんて有り得ないわけで。

思い出すだけでもトラウマなんですが、数年前、あるブランドサイトの分析報告会で「ブランド名指定で直帰率が30%台で、かなり低いと思う」とデジマチームとキャッキャしていたら「お客様がブランド名指定でご来店されているのに、どうして帰るんだ!ありえないじゃないか!」とブランドマネージャーから突然罵声を浴びせられまして、正直その瞬間からの記憶がございません。検索クエリがまだ分かった時代の話ですけども。

「その理由を教えろ!」と言われた記憶は残っています。今ある手元のデータだけで何とか取り繕ったはずですが、結局納得頂けず、その後で相当炎上したはずです。

ブランド名指定でWEBサイトに訪れたのに直帰した理由。その仮説を効果測定ツールのデータだけで考えるのって、結構力技じゃないですか?

それができる人がいたとして(数名浮かびますが)、仮説を見つけるロジック自体を体系立てて説明できた機会はありません。それじゃあ産業としては成り立たないですよね。

集めたデータでどれくらい仮説生まれましたっけ?

DMP以降、デジタルマーケティング界隈では「とにかくデータを集めよう」という流れが加速しています。ビッグデータと相まって、「大量のデータを読み解くツール」が爆誕しています。

何のためにデータ集めているかを考えると、仮説を検証するためと、仮説を構築するためなんですが、DMPやその他ツールを使ってどんな筋の良い仮説を作れたでしょうか。

例えば以下のnoteでは、明治プロピオヨーグルトR-1(ドリンクタイプ)の売上増のために、健康対策しないといけないんだけど自覚が無い人として「2019年に子供がセンター試験(大学受験)に受験する親」という仮説を見つけました。そういう仮説って、今のDMPで作れるんでしょうか?

マス広告データ、ネット広告データ、3rdPartyDMPデータ、ソーシャルリスニングデータ、アクセス解析データ、CRMデータ、リアルプロモーションデータ、とにかく色んなデータを統合して、そこから「2019年に子供がセンター試験(大学受験)に受験する親」という仮説を生み出すジャンプのロジックをむしろ知りたい。

検証のためだけなら、そんなにデータ集める必要ありますか? 検証すべき範囲のデータだけで十分じゃないでしょうか?

冒頭に紹介した書籍の帯に「ビッグデータをゴミの山にしない」と書かれていて、今なら違和感を覚えます。ビッグデータは金脈でも何でも無くて、目的無きデータはすべからくゴミだと思うんですよ。

なるほど、とりあえず集めてみたデータを掘り返すと、中には砂金のような優れたアイデアが発見されるかもしれません。でもそのために何人のエンジニアが心を壊し、何百万という金をかけているのでしょうか。そんなバクチで良いんでしたっけ? 人も金も、大義のためには止むを得ませんか?

ましてや、とりあえず集めたデータは、欠けてるし、いざ分析しようものなら「無いデータばかり」だと気付くのです。

データサイエンスビジネス界隈で、特に機会学習界隈で「質の高いデータが大事」とは良く言いますが、それって既存のDMPから作れた経験ってどれくらいありますか? 購買履歴ぐらいではありませんか? 違ってたらすいません。

全ては、DMPから作れて、かつ顧客が増えて、売上も伸びる仮説のイメージが湧かない私が悪いのです。そんな脆弱なデータの海に飛び込んで、皆さんどんな仮説を作られているというのでしょうか。

(内容がまとまっていません。未完。だけど、もう公開しちゃいます)

1本書くのに、だいたい3〜5営業日くらいかかっています。良かったら缶コーヒー1本のサポートをお願いします。