結局のところLLMとは何なのか?ChatGPTに聞いてみた。

最近はChatGPT(Copilotなども含め)がないと仕事がはかどらないような体になってきました。ChatGPTがいるのといないのでは、文章やコードを書く作業時間は少なく見積もっても2倍ぐらいは違いが出るような気がします。例えば、コード全体の設計や、サンプルコードを書いてもらう、はたまたデバッグしてもらう、などの作業自体も効率化されましたが、それらに付随する調べ物の時間がとにかく減ったような感じます。

そんなわけで、ぐっと身近になったChatGPTの内部構造が知りたくなりました。せっかくなのでChatGPTに手伝ってもらい、理解度を上げる作業も効率化してみます。

まずやったこと

LLMはTransformerが重要である、といううっすらとした理解はあったのですが、まずはTransformerについて詳しく書かれた論文を読んでみようと思います。(と言いつつも読むのはChatGPTです)

今回の論文は「Attention is all you need」です。論文を実際に読んでみたい方はリンクから飛んでみてください。

わたしは、ChatGPTに要約してもらいました。

この論文「Attention Is All You Need」は、自己注意(Self-Attention)のみに基づく新しいネットワークアーキテクチャであるTransformerを提案しています。従来のリカレントや畳み込みニューラルネットワークを用いたシーケンス変換モデルとは異なり、Transformerは再帰や畳み込みを使用せず、完全に注意メカニズムに依存しています。このモデルは、特に機械翻訳タスクで優れた性能を発揮し、より少ないトレーニング時間で新たな最先端を達成しています。また、英語構文解析タスクにも適用し、優れた結果を得ています。

なるほど。論文のタイトルにもある通り、Attention(注意)がアーキテクチャ上も重要な概念なのだということがわかりました。

ただ、ざっくり丸投げしたので、ざっくりした回答しかもらえませんでした。論文をまったく読んでないので、論文の構成と内容を聞いてみます。

論文「Attention Is All You Need」は以下のように構成されています:

1. 導入: 自己注意(Self-Attention)とTransformerモデルの概要説明。

2. 背景: 従来のシーケンス変換モデルと問題点の説明。

3. Transformerモデル: モデルの構造と自己注意メカニズムの詳細。

4. 実験: 機械翻訳と英語構文解析でのTransformerの性能評価。

5. 結果: 実験による結果と比較分析。

6. 関連研究: 関連する研究との比較。

7. 結論: 研究の要約と今後の研究に向けた展望。

論文の各セクションでは、新しいモデルの特徴、利点、および従来のモデルとの比較が詳細に説明されています。また、実験結果に基づく分析を通じて、Transformerの性能とその有効性が示されています。

ほうほう、、、TransformerモデルとAttentionについて理解をするためには、1と3を掘り下げるのが良さそうだなぁ。と感じられる素晴らしい回答をChatGPTさんは提供してくれています。

Transformerモデルについてもう少し細かく知りたいですねぇ。

Transformerモデルの部分では、主に以下の要素について説明されています:

1. 自己注意機構(Self-Attention Mechanism): これは、シーケンス内の異なる位置にある要素間の関連性を計算するメカニズムです。Transformerは、このメカニズムを用いて、入力シーケンスの異なる部分間の関係を効率的に捉えます。

2. 位置エンコーディング(Positional Encoding): トークンの順序情報を保持するために、Transformerは位置エンコーディングを使用します。これにより、モデルは単語の位置関係も学習できます。

3. エンコーダーとデコーダー(Encoder and Decoder): Transformerモデルは、エンコーダーとデコーダーのスタックで構成されています。エンコーダーは入力シーケンスを処理し、デコーダーは出力シーケンスを生成します。両者は自己注意と位置エンコーディングを利用して動作します。

4. 多頭注意(Multi-Head Attention): これは、異なる表現サブスペースで自己注意を並列に実行することにより、異なる視点から情報を集めることができます。

これらの要素によって、Transformerは効率的な学習と正確なシーケンス変換を実現します。

もうちょっと詳しくAttentionについて知りたいですね。

アテンション(Attention)メカニズムは、特定の情報に焦点を当てるための技術です。ニューラルネットワークでは、特に重要または関連性の高い入力データの部分に「注意」を集中させることで、性能を向上させます。

アテンションの重要性は、特に言語処理タスクで顕著です。例えば、文章内の特定の単語やフレーズに焦点を当てることで、文脈をより正確に捉え、意味を理解することが可能になります。

アテンションがなければ、ネットワークは入力データの全体に均等に注意を払う必要があり、特に長いシーケンスや複雑なデータにおいて、重要な情報を見逃すリスクが高くなります。その結果、性能が低下する可能性があります。

なるほど。重要な情報に集中するためにAttentionを向けるということか。つまり、重要度のフラグやタグみたいなイメージなのかなぁ。ということで、確認の為に聞いて見ます。

いぇーい!理解があってたぞ!

調子にのって、重要度をどうやって見つけるのかを聞いてみます。

ChatGPTの回答 いいえ、ちがいます!

げ、、、撃沈

でも、要素間の関係性を数学的に計算する、というところが重要なポイントだということはわかりました。

ここで立て続けに、関係性についてと、要素間の相関度について聞いてみます。

難しい話になって来ました。

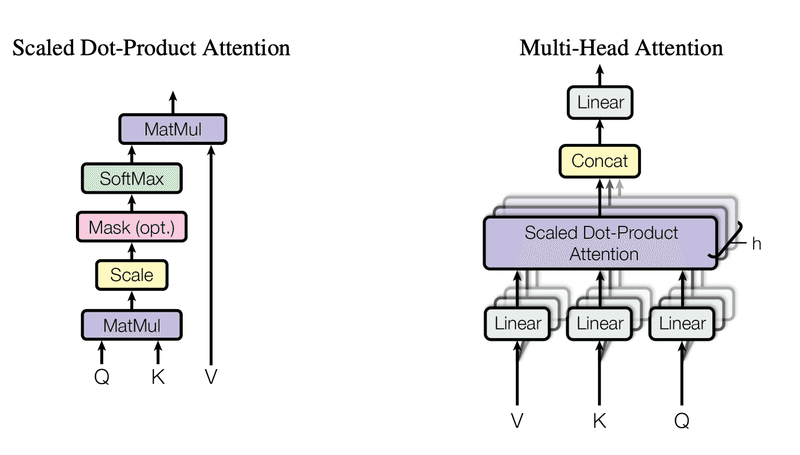

ここで論文を見てみると、こんなイラストがありました。Qがクエリで、Kがキーで、Vがバリューですね、きっと。

2つのアプローチがあるようで、論文内の章でいうと以下の部分で詳しく説明されていました。

3.2.1 Scaled Dot-Product Attention

3.2.2 Multi-Head Attention

それぞれの章をChatGPTに日本語にしてもらいました。難しいことが書かれていますが、要は一つのやり方で一回だけやるのがScaled Dot-Product Attentionで、異なるやり方で複数回やるって結果をまとめるのがMulti-Head Attention、ということのようです。(ちなみにChatGPTに確認したところ、あってます、と回答をもらいました)

論文内の「3.2.1 Scaled Dot-Product Attention」セクションでは、"Scaled Dot-Product Attention"について説明されています。このアテンションでは、クエリとキーは同じ次元dkを持ち、バリューは次元dvを持ちます。クエリと全キーとのドット積を計算し、それを√dkで割り、ソフトマックス関数を適用してバリューの重みを求めます。実際には、クエリ、キー、バリューを行列Q、K、Vにまとめて計算します。このアテンションは、高度に最適化された行列乗算コードを使用して実装されるため、実践的には速く、効率的です。dkが大きい場合には、ドット積が大きくなりすぎ、ソフトマックス関数が非常に小さい勾配を持つ領域に押し出されるため、ドット積を√1/dkでスケーリングします。

「3.2.2 Multi-Head Attention」セクションでは、マルチヘッドアテンションについて説明しています。このアプローチでは、一つのアテンション機能を用いる代わりに、クエリ、キー、バリューをh回異なる線形射影でdk、dk、dvの次元に変換します。これらの変換されたバージョンで並行してアテンション機能を実行し、dv次元の出力を得て、最終的な値を得るために再び結合し、射影します。マルチヘッドアテンションにより、モデルは異なる表現サブスペースの情報に同時に注目できます。この研究では、h = 8の並列アテンション層(ヘッド)を使用し、各ヘッドではdk = dv = dmodel/h = 64の次元を使用しています。各ヘッドの次元が減少しているため、全体の計算コストは通常の単一ヘッドアテンションと同様です。

しかし、この一文がとても気になります。

各ヘッドの次元が減少しているため、全体の計算コストは通常の単一ヘッドアテンションと同様です。

複数回の計算をするのになぜ計算コストが単一ヘッドアテンションと同様になるのでしょうか。聞いてみましょう。

なるほど。Multi-head Attentionを使う上で、Scaled Dot-Product Attentionが必要になるということですね。わかりやすい。そして、このMulti-Head AttentionがChatGPTの柔軟かつ正確な回答につながってるように思いました。これは、Multi-Head Attentionをもう少し深掘って行く必要がありあそうですね。

一旦、今日はこの辺にしておきましょうかね。しかしChatGPTはいろいろな使い方ができますが、一人で読書会や勉強会をやっているような効果もあるなんて、すごすぎます。

この記事が気に入ったらサポートをしてみませんか?