トランスフォーマーの論文を読む①要約

以前に紹介した論文の読み方に従って、トランスフォーマーの論文である「Attention Is All You Need」を読んでみます。

Googleブレインの研究者だったAshish Vaswaniらによるよるこの論文は、BERT、GPTなどの多数の派生言語モデルを生み出すもとになっており、言語モデルに興味がある人ならその名前を知らない人はいないぐらいに有名です。

主な目的としては、アテンション機構と呼ばれる文章から文脈を読み取る仕組みを理解することです。そのため実験結果の詳細などには触れません。いくつかの記事に分けて論文を読みながら解説します。

まず要約を読む

まず、論文「Attention is All You Need」の構造ですが、以下のようなセクションに分かれています。

要約(Abstract)

導入(Introduction)

背景(Background)

モデルの構造(Model Architecture)

なぜ自己アテンションなのか(Why Self-Attention)

訓練(Training)

結果(Results)

結論(Conclusion)

論文の読み方で解説したように、よくある論文の構造を持っています。

そこでまずは、要約でこの論文が主張していることを理解していきましょう。さまざまなキーワードが登場します。

機械翻訳モデル

広く使用されているシーケンス変換モデルは、エンコーダとデコーダを含む複雑な回帰または畳み込みニューラルネットワークに基づいています

The dominant sequence transduction models are based on complex recurrent or convolutional neural networks that include an encoder and a decoder.

人工知能と機械学習の文脈において、シーケンス変換モデル(sequence transduction models)とは、あるデータ シーケンスを別のデータ シーケンスに変換するために使用されるモデルの一種です。 モデルは入力シーケンス (ある言語の文など) を受け取り、それを出力シーケンス (別の言語で翻訳された文など) に変換します。この論文では、英語からドイツ語やフランス語に翻訳する機械翻訳のことを指しています。

複雑な回帰や畳み込み

この論文が出版された当時の2017年のことで、もちろんBERTもGPTもありません。エンコーダ・デコーダによる機械翻訳モデルでは、リカレントニューラルネットワーク(RNN)や畳み込みニューラルネットワーク(CNN)がよく使われていました。

なので、RNNやCNNがどのように言語モデルで使われていたのかを知っているとより背景がわかりやすいでしょう。特にRNNは言語モデルでよく使われていたので知っておいて損はないです。こちらに簡単な解説があるので必要に応じて参照してください。

ただし、論文を読みながら知らないことに出会っても最初は深掘りせずに通り過ぎて概要を掴む方が良いです。PDFで読んでいるのならハイライトなどでマークしておいて後で調べようぐらいの気持ちで進めます。しかし、あまりにも知らないことばが登場するようでしたら、一旦読むのを諦めるか、ブログなどを参考にして少し理解を深めてから戻ったほうが読む効率が上がることもあります。

なお、ここで注目して欲しいのは「複雑な回帰または畳み込みニューラルネットワーク」と言っているところです。この論文で扱うトランスフォーマーはもっとシンプルだと言いたいかのようです。その気持ちは、論文のタイトル「Attention Is All You Need」に込められています。これについてはおいおい明らかになります。

エンコーダ・デコーダ

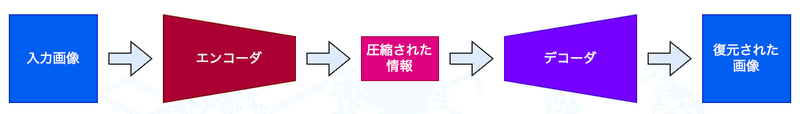

エンコーダ・デコーダのパターンは、さまざまな用途で登場します。例えば、変分オートエンコーダやノイズ除去オートエンコーダなどがよく知られています。これらは、画像処理を行うものなので入力と出力が画像データになっています。

ポイントなのは、画像からエンコーダが抽出した重要な情報(特徴量)をもとに、デコーダが画像を生成するというパターンです。

これを機械翻訳で考えると、ある言語(例えば英語)の文章からエンコーダが抽出した重要な情報(文脈)をもとに、デコーダが同じ内容を異なる言語(例えばフランス語)の文章として生成することになります。

ここまで、まだ一文しか読んでいません。次に進みましょう。

アテンション機構

要約は、こう続きます。

最も性能が高いモデルは、アテンション機構を通じてエンコーダとデコーダを接続しています。

The best performing models also connect the encoder and decoder through an attention mechanism.

つまり、エンコーダ・デコーダによる機械翻訳モデルでも、より性能が高いモデルはアテンション機構を使っているものだということを強調しています。

我々は、アテンション機構のみに基づいた新しいシンプルなネットワークアーキテクチャであるTransformerを提案します。これは、回帰と畳み込みを完全に排除しています。

We propose a new simple network architecture, the Transformer, based solely on attention mechanisms, dispensing with recurrence and convolutions entirely.

ここでトランスフォーマーの名前が登場します。また、トランスフォーマーがシンプルであると論文の著者たちが主張している理由も明らかになりました。

回帰や畳み込みは複雑になるだけで実は必要がない。エンコーダ・デコーダとアテンション機構があれば良い、つまり「Attention Is All You Need」(アテンションが全て、それだけが必要)ということです。

論文の主張

「アテンションが全て」を裏付けるように、次のように述べています。

二つの機械翻訳タスクにおける実験は、これらのモデルが品質において優れており、より並列化可能であり、訓練にかかる時間が大幅に少ないことを示しています。

Experiments on two machine translation tasks show these models to be superior in quality.

ここでは、機械翻訳の性能が高いことだけでなく、(GPUによる)並列処理が可能で、訓練にかかる次回が大幅に減少したと主張しています。

なお、RNNでは、文章の中のトークン(名詞や動詞などの基本的要素に分解したもの)を順番に処理していくので、複数のトークンを同時に処理することができません。また、CNNでも文章に畳み込みのカーネルを適用する部分をずらしながら文脈を抽出していくので基本的には順番に処理することになります。つまり、RNNもCNNも、文章の連続性や文脈を理解するために、入力されるトークンの順序に依存しています。

つまり、トランスフォーマーはよりシンプルで訓練も比較的速く終わり、性能も良いと主張しています。当時の言語モデル研究者であれば、これは読むべき新しい情報があると思うでしょう。

主張の裏付け

そして実験結果の概要が論文の主張の裏付けとして説明されます。

我々のモデルは、WMT 2014の英語からドイツ語への翻訳タスクで28.4 BLEUを達成し、アンサンブルを含む既存の最高結果を2 BLEU以上上回りました。また、WMT 2014の英語からフランス語への翻訳タスクでは、8つのGPUで3.5日間トレーニングした後、41.8という新しいシングルモデルの最先端BLEUスコアを確立しました。これは、文献中の最高のモデルのトレーニングコストのほんの一部です。

Our model achieves 28.4 BLEU on the WMT 2014 Englishto-German translation task, improving over the existing best results, including ensembles, by over 2 BLEU. On the WMT 2014 English-to-French translation task, our model establishes a new single-model state-of-the-art BLEU score of 41.8 after training for 3.5 days on eight GPUs, a small fraction of the training costs of the best models from the literature.

また、WMT 2014は、"Workshop on Statistical Machine Translation 2014"の略で、2014年に行われた統計的機械翻訳に関する国際ワークショップです。このイベントでは、様々な研究機関や企業からの参加者が、機械翻訳システムの性能を評価するためのコンペティションに参加しました。WMTでは毎年、特定の翻訳タスクが設定され、それらに対する最新の翻訳モデルや技術が競われます。WMT 2014は、その年のコンペティションであり、特に英語からドイツ語、英語からフランス語への翻訳タスクが注目されました。これらのタスクでは、機械翻訳システムの性能がBLEUスコアという指標を用いて評価されます。

なお、BLEUは機械翻訳モデルを評価するための手法で、こちらで解説しています。

それにしても、8つのGPUを3日半も使うところのどこが高速なのかとツッコミを入れたくなるかもしれません。もちろん、これらの数値の凄さは、それまでの既存のモデルからの結果と比較しないとわかりません。おそらく言語モデルを研究している人ならピンとくるのでしょうが、そうでなければとりあえずそういうものかと受け止めるぐらいの問題ありません。

要約の結び

要約は次のように結ばれています。

我々は、Transformerが他のタスクにも良く適用できることを示しました。これは、トレーニングデータが豊富な場合と限られた場合の両方で、英語の構成成分解析に成功裏に応用されました。

We show that the Transformer generalizes well to other tasks by applying it successfully to English constituency parsing both with large and limited training data.

この文は、Transformerモデルが特定のタスク(この場合は機械翻訳)に限定されず、他の言語処理のタスクにも効果的に適用できることを主張しています。

具体的には、英語の構成成分解析(文の構文構造を解析するタスク)にTransformerモデルを適用し、トレーニングデータが豊富な場合と限られた場合の両方で良い結果が得られたことを示しています。これにより、Transformerが多様なNLP(自然言語処理)タスクに汎用的に使える可能性を示唆しています。

つまり、これもシンプルでアテンションだけを必要とするトランスフォーマーの威力を主張しているわけです。

この要約を読むと言語モデルに興味ある当時の研究者なら絶対に読み進めたいと思ったことでしょう。

次回予告

この調子で読み進めましょう。次は、結論から先に読んでいきます。

お楽しみに!

この記事が気に入ったらサポートをしてみませんか?