トランスフォーマーの自己アテンションの理解⑤エンコーダ・デコーダ

本シリーズの記事リスト

第一弾 トークン数値化の歴史

第二弾 回帰による文脈伝搬

第三弾 レコメンダーと内積

第四弾 位置エンコーディング

第五弾 エンコーダ・デコーダ

第六弾 クエリとキーとバリュー

第七弾 エンコーダ・ブロックの詳細

第八弾 デコーダ・ブロックの詳細

この記事では、トランスフォーマーで翻訳をする際の枠組みであるエンコーダ・デコーダを解説します。翻訳モデルであるトランスフォーマーの全体像を掴むことで後々に解説するアテンションの詳細を理解する手助けになります。木を見るよりまず森を見ることで、全体の見通しをよくするのが目的です。

では、さっそく始めましょう。

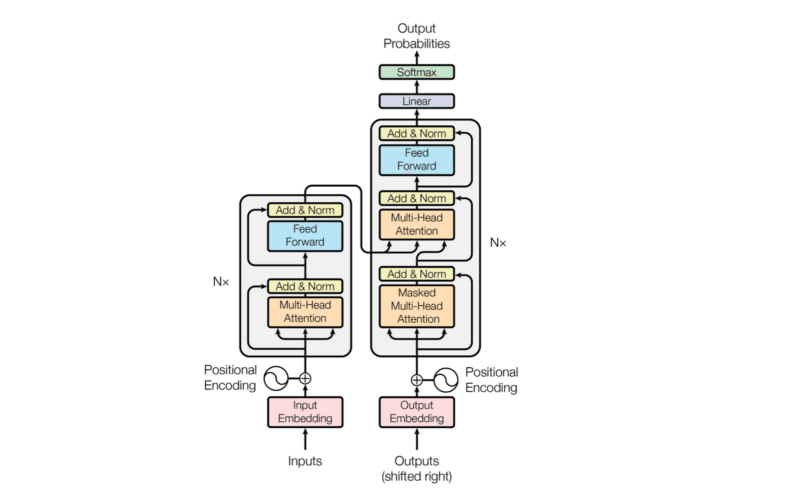

トランスフォーマーの全体図

以下は、トランスフォーマーの論文「Attention Is All You Need」の一番最初の図です。これはエンコーダ・デコーダの構造を示しています。

Google Brainの研究者であるAshish Vaswaniらによって発表された論文ですが、彼らは冒頭でこう述べています。

We propose a new simple network architecture, the Transformer, based solely on attention mechanisms, dispensing with recurrence and convolutions entirely.

私たちは、アテンションメカニズムのみに基づいて、回帰や畳み込みを完全に不要にする、新しいシンプルなネットワークアーキテクチャであるトランスフォーマーを提案します。

一見すると、とても複雑な構造を持つトランスフォーマーのことを「シンプルな」と言っていますが、これは「回帰や畳み込みを完全に不要にする」ことを指しています。

しかし、何の背景知識を持たずに、上図を見て「シンプルな」と思う人は少ないでしょう。

なので、この記事では上記の図がある程度シンプルに見えてくることを目指して、トランスフォーマーのエンコーダ・デコーダの大枠を解説します。

この記事が気に入ったらサポートをしてみませんか?