AIについて語る時 -(2)大いなるAIの力には、大いなる責任が伴う

鉄腕アトムは中に人間が入ってないので、当然、AI。ドラえもんも、アラレちゃんも、キューティー・ハニーも、ロボコンもAI(古くて御免、最近の知らないので)。日本作品に登場するAIは、大抵、正義の味方か人間の友達って設定で、結構賢く、可愛いとか、お茶目とか、好印象なのが多い。一方、ハリウッド映画では、ターミネーターはもちろん、ロボコップの敵方ロボット最悪だし、2004年公開の「I, Robot」も追いかけてくるロボット軍団怖すぎだし、インターステラーに出てくるロボットはお馬鹿だし、スターウォーズだってR2やC3PO、BB-8なんかは味方だけどお馬鹿で、大量に登場するクローン連中は殺戮マシーンだし、エクス・マキナも最後裏切るし、 ・・・と、裏切り、お馬鹿、殺人鬼ってのが定番の印象あり。

映画やアニメの世界と同様、日本メディアが取り上げるAIの話題は、ソフトバンクのPepperや小型の人形・ぬいぐるみのAIロボット、ホテルの受付で働く恐竜型ロボットに、ソニーのAIBO復活やら、AIが作曲したぞ~、小説書いたで~、著作権どうすんねん、等々、わりと平和な話題が多い。一方、欧米では、無人殺戮兵器やAIに雇用が奪われる問題や、AI使った汚い金融取引、中国政府のAIによる超監視国家化など、暗~い話題が頻繁に取り沙汰されている。

AI脅威論を訴える知識人が増えてきたのは2014年頃か?例えば、ケンブリッジの故ステファン・ホーキング教授は、

『強力なAIの創造は、文明の歴史において最大の出来事に成り得るだろう。或いは、最悪の出来事に。今は分からない。我々は AIに大いに助けられることになるのか、排除されるのか、或いは、破滅させられるのか』

という趣旨の発言を様々なメディアやイベントで繰り返し、テスラ・モーターズやスペースXの創業者、イーロン・マスク氏も頻繁に警鐘を鳴らしている。

『AIは人類の文明にとって実在する根源的なリスクだ。私は人々がそれをきちんと理解しているとは思えない』

2015年7月には、非営利組織のFuture of Life Instituteが国連宛の公開書簡としてAI兵器開発禁止を訴えるメッセージを発表、ホーキング博士、イーロン・マスク氏、スティーブ・ウォズニアック氏(アップル共同創業者)ら多くの著名人、コンピュータ・サイエンティスト、ロボット工学の研究者らが署名。

さらに、2016年4月のG7では「AI開発原則」及び「AI開発ガイドライン」策定に向け、OECD等の国際機関が協力しながら議論していくことが合意。2017年9月には、国連地域間犯罪司法研究所(UNICRI)が、人工知能を監視し潜在的脅威を予測するCenter for Artificial Intelligence and Robotics (CAIR)を設立すると発表。

そんな折、今年2月に韓国の技術系トップの大学、KAISTの学長が軍需産業大手と共同で、自律兵器を含むAI軍事技術の研究所設立を発表。世界中の著名なAI研究者から非難を浴び、同研究所のみならず、同大学との全ての付き合いをボイコットするよう呼びかける運動が始まった。その後、同学長がロボット兵器は開発しないと確約、ボイコット運動は沈静化に向かったようだが・・・。

一方、今やハイテク業界のシンボルとなったイーロン・マスク氏は、政府や国際機関は、AIの研究開発に何らかの規制をすべきと主張。それに対し、潜在的な脅威があることに関しては同調していたビル・ゲイツ氏やスティーブ・ウォズニアック氏らは反対の立場を取り、「テスラはAIで遅れてるから、他社のAI研究開発の足を引っ張るために規制云々、言ってんだろ」的な論調まで登場、規制に関しては、今後もすったもんだが続くだろう(そもそも、ソフトウェアであるAIの研究開発に規制作ったところで機能するだろうか?中露などの軍の研究所が規制に従うだろうか?)

AIによる殺人兵器の問題と並び、頻繁に取り沙汰されるのが、AIに雇用を奪われるという問題。労働人口減少が続く日本では、むしろAIの力を借りないと経済を維持できないという論調もあるが、まだ人口減少に直面していない諸外国では、雇用維持が大きな社会問題。AIが職を奪う将来を見据えてベーシックインカムやら、企業がAIを労働力として使うならば、それに税金をかけるべき、って議論もかなり真剣にされ始めている。

今のところ、欧米メディアが取り上げる脅威は、兵器と雇用に関するものが多いが、AIは既にビジネスを中心に社会の隅々に浸透してきており、大きな効果/成果と共に大きな潜在的脅威も入り込み始めている。例えば、最近のテレビやウェブのニュースサイトをどう思うだろうか?思わず「はぁ?」と声に出てしまうくらい、どうでもいい、くだらないニュースが延々と続き、社会的に重要だと思われるニュースの扱いが、日々、低下してきたと感じないだろうか?視聴率や広告効果が高くなるよう、統計解析やちょっとしたAI的なものを使って優先順位を決めてニュースを配信しているからだろうが、今後、AIが本格導入され、機械学習によって、さらなる収益向上が追求されると、どんなことが起こり得るだろうか?ニュースを配信する企業の売上を伸ばすために、AIによる優先順位決定が、結果的に社会/人々を誘導・洗脳し始める可能性だってある。

例えば、AIが広告収入を上げるべくディープラーニングを遂行した結果、衆院選では○○党が勝利した方が自社ニュースサイトの広告収入が上がる、という法則をAIが文字通り『人知れず』発見した場合、○○党が勝利するような偏向報道(あるいは、洗脳活動)を『人知れず』始めるかもしれない。さらには、暴動や戦争が起こった方が売上が伸びるという統計的な偏りがあれば、AIは学習によって、『人知れず』暴動や戦争を煽動するようなニュース配信に努め始めるかもしれない。

"We tend to overestimate the effect of a technology in the short run and underestimate the effect in the long run. – Amara's Law"

(我々は技術の影響を短期的には過大評価し、長期的には過小評価する傾向がある − アマラの法則)

ディープラーニングなどのニューラルネットワーク系の学習では『非線形』なるものが使われる。何やら数学臭がするが、数学には立ち入らず、科学者/技術者が抱くイメージだけ共有したい。いいイメージは、従来法(線形)では、できなかったことができるかも、という魔法のイメージだ。

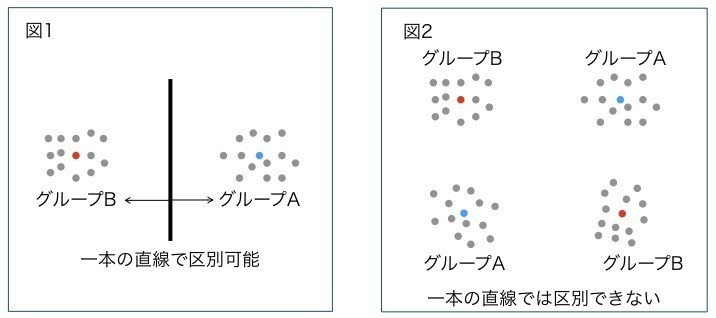

図で示そう。図1のようにグループAとBがある時に、一本だけ線を引いて2つのグループに分ける方法を考える。例えば、右側の点ほど「背の高い人」で、左側の点ほど「背の低い人」をプロットして表示したものとする。「背の高い人」のグループ(A)と、「背の低い人」のグループ(B)を『線形』で区別する方法とは、おおざっぱに言えば『直線』を引いて2つのグループに分けることを言う。図1の場合は簡単、真ん中に『直線』を引けば、その線より右が「背の高い人」のグループ(A)、左が「背の低い人」のグループ(B)として分けられる。

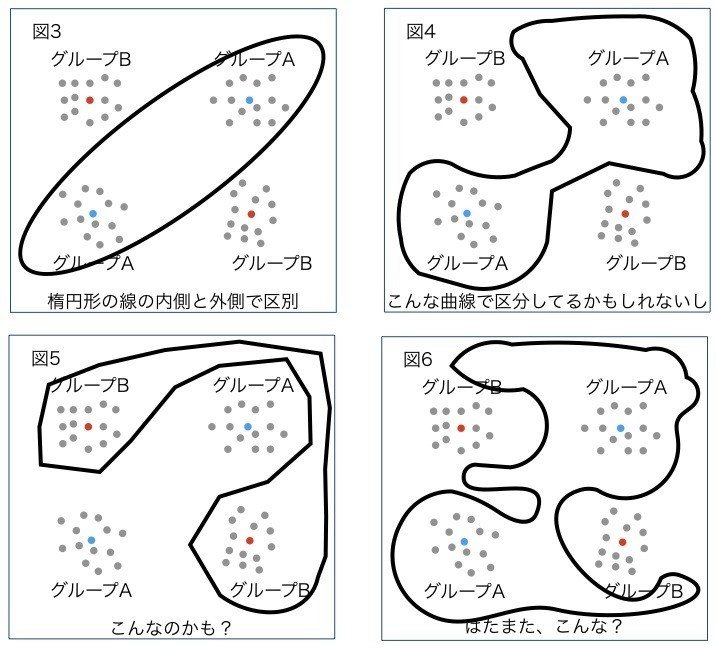

次に、左右の意味はそのままに、これに加えて、上に行けば行くほど「体重の重い人」、下に行けば行くほど「体重の軽い人」としよう。図2のような分布になったとする。つまり、中肉の人のグループ(A)は右上と左下に分布し、それ以外(痩せ型あるいは太り型)のグループ(B)は左上と右下に分布する。この場合、この2つのグループを一本だけ線を引いて区別することができるだろうか?直線を引く、つまり、『線形』ではできない。ところが、ニューラルネットワークなどの『非線形』を使うと一本の線で区別できてしまう。例えば、図3のような楕円形の線(曲線)を引き、楕円の内側が中肉のグループ、外側をそれ以外のグループ、と分けることができる。あるいは、図4や図5、図6のようなイビツな『曲線』で囲んでも分類できる。

『非線形』を使うと今までできなかったことができてしまう。これは、素晴らしいことだ。ディープラーニングなどでは膨大なデータから、解析できない非線形関数というのを何度も何度も使ってデータから学習し、『非線形』の解を生み出す。上記の例では、区別のための曲線を生み出す。それが、どんな曲線なのか分からないが、とにかく区別するという「目先の目標」は達成できるのだ。

問題は、・・・どうやって目標を達成しているのか、一般には分からないのだ。善良で思慮深い科学者/技術者は、自分が構築した技術が人々や社会に害を及ぼさないかを真剣に考えるので、その詳細を説明できないことに否定的なイメージを抱く。このように『非線形』に対して、善良で思慮深い科学者/技術者は、できなかったことができる、という肯定的イメージと共に、説明責任の観点から否定的イメージも抱いている。

でも、責任感や倫理観が欠如したエセ科学者/技術者は、「だって、AIってブラックボックスじゃねえか。何が起こるか分からなかったんだよ。こうなったのは、俺のせいじゃねえ」とハナから責任逃れの手段として「分からない」ことをむしろ肯定的に捉えるかもしれない。

既存のCMをディープラーニングで学習することで、制作中のCMの効果を放送前に判定できるそうだ。それが、一体、どんな基準で判定しているのか、よく分からなくても。チープでジャンキーなリズムに、エロくて下劣な映像、ニヒルで自虐的なセリフに効果がある、という基準で判定してるのかもしれないのだが、とりあえず、目先の目標は達成できる(それでいいのか?)。売れるゲームを制作するためにディープラーニングを使えば、より残忍で暴力的で、さらに時事ニュースに反応して、ある特定の人々への差別を助長するゲームを誘導するかもしれない(いいの?)。人間と比べてAI様はストレートだ。遠慮なく、人間の本性を突いてくれる。日々、学習を深め、さらに醜い人間の本性を刺激する方向へ誘うかもしれない。

IBMのAIシステム、Watsonは強力な自然言語処理能力(普通の文章を解析してコンピュータで利用できるような構造的なデータへ変換、データベース化する処理)を備え、人間が到底読み込めない膨大なデータを使って推論などの目的を果たしている。ガン治療への応用が有名だが、ガンの変異や生命のメカニズムに関する膨大な知識を持ち、加えて2千万件を超える腫瘍に関する膨大な量の論文を読み込み、自然言語処理をして知識を集めている。患者のガンの変異データを入力すると、持っている膨大な知識を駆使して推論し、抗がん剤の候補とその標的とする遺伝子を提案、既に東大を含め、世界中の先進医療機関の現場で成果を上げている。その膨大な情報へのアクセスゆえ、人間の医師では、とても気が付かないような抗がん剤の候補を挙げることができる。

2020年には、毎日、40x10の21乗バイト(40ゼタバイト)のデータが新しく生成されるそうだ(※IBMの調査)。自然言語処理の技術でインターネットから膨大なデータを自動で収集、ディープラーニングで学習する試みが始まっているが、そうなると、一体、どんなデータで学習しているのかすらも分からない。

「風が吹けば桶屋が儲かる」という小話をご存知だろう。一見、全然、関係なさそうな事象の間でも、巡り巡って影響を受けるという話だ。「大量のデータをディープラーニングで学習することで、今まで人間では思いもしなかったビジネスの法則を発見し、御社の業績向上へ繋げます」というのは、AI技術を売りにする企業が使うセールストークだが、このフレーズを聞くと、ある米国人医師の話を思い出す。10年くらい昔だが、循環器系医療機器の大手メーカーのトップが、ある牛肉の生産者団体の会長を兼任していた。一見、何の脈絡もない人選だが、医師は怒っていた。

「この生産者団体は、牛に大量のコーンを与えて急成長させることを推奨している団体だ。そうやって飼育された牛肉を食べると循環器系の疾病率が上がるというデータが示されているのに。つまり、コイツら疾病率を上げることで自分達の収益を上げようとしてるのさ」

例えば、製薬会社の経営支援AIが、一見、関係なさそうな会社へ出資することを奨励した。何故だか分からないが、人間なら気付きもしないビジネス成功の法則があり、その会社へ出資することが同社の業績向上につながると推論している。「ディープラーニングで我々人間が思いもよらなかった知識を得たんだ!」ということで、経営陣はAIに従って出資し、実際、数年後、同社の売上は急拡大した。後になって、出資先の事業によって、同社の薬を必要とする人々が大量に生まれてしまった、というオチは避けたいところだ。

AIを使うことで「人間では思いもよらなかった新たな法則」を発見できる可能性は大いにあり得る。同時に、そこには大きなブラックボックスが生まれ、「人間では思いもよらなかった新たな弊害」が発生する可能性もある。長期的な社会の発展、健全性を無視し、エゴ丸出しで短期的な利益を追求するエセ科学者/技術者/経営者によるAI活用には大きな不安を感じるが、悪意はなくても、正しい知識・思慮を欠いた人材によるAI活用も、成果と共に悲惨な副作用を招く恐れがある。

OpenAI等のオープンソースを含め、多数のツールが生まれ、AIの素養が全然無くても、ディープラーニングなどを使える世の中になった。そこそこ金があれば、AmazonやGoogleなどの巨大設備をクラウドで利用したり、あるいは、NVIDIAなどのハードウェアを使って、高性能な計算資源も手に入る。「我が社は、AIの専門家集団」と銘打って、実は一人もAIの専門家が居らず、AI「ツール」の専門家ばかりの会社も多い(日本だけでなく、シリコンバレーでも)。”Fake it till you make it(できるまで、できるふりをしろ)” という格言があるが、新しい技術がブームになる時は「我が社は、○○の専門家集団」と ”Fake it till you make it” する企業がたくさん登場するのは、これまで繰り返されてきた。

ただ、どういう論理で目標を達成しているのか、時にどんなデータを使っているのかさえ分からないAI(主にディープラーニング)を利用する場合には、使う側に、より大きな思慮深さと責任が求められよう。AIは大いなるベネフィットと同時に大いなる脅威をももたらす。

ネガティブな論調になってしまったが、私自身はAI推進派だ。AIの研究開発に下手な制限を加え、ならず者国家やテロリストに技術的な優位性を築かれてしまったら、それこそ、どうしようもなくなる。誤解を恐れずに言えば、人類は原発をやめることはできるかもしれないが、AIの進歩は止められないと思う。第三次世界大戦とか、惑星が衝突したとか、地球が壊滅的な状況にならない限り。AIを使うにあたっての正しい知識・思慮深さって何なのか、例えば、こういう議論も、もっとされるべきだと思う。

With Great Power Comes Great Responsibility - Uncle Ben, Spider-Man

(大いなる力には、大いなる責任が伴う)

この記事が気に入ったらサポートをしてみませんか?