人工知能の"欺き"方

人工知能の応用が自動運転、音声認識、医療、翻訳、会計処理などいろいろな分野で盛んに研究されてきているわけだが、同じように、人工知能を騙して誤判断をさせる手法とその対策法についても注目されている。人工知能の安全性を担保するために不可欠な研究分野だ。

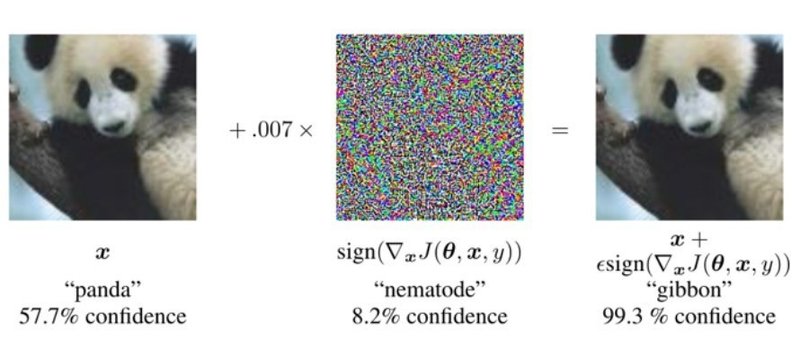

たとえば、人間にはパンダにしか見えないが、人工知能は99%の確率でテナガザル(gibbon)と誤認識する画像サンプルを作れてしまう。パンダのラベルがついた正解画像があり、その画像の各ピクセルにノイズを載せていくとする。ノイズをうまく選ぶと、強い確信度でテナガザルと誤認識するサンプルが作れてしまう。(引用元はこちら)

同様に、人間にとっては識別不能な画像を、人工知能に誤認識させる手法も有名だ。進化的アルゴリズムを使い、人工知能を騙す画像を生成する。以下は結果の一例。我々人間にとってはどうみても、"comic book" "digital clock" "soccer ball" には見えないのだけど、人工知能は99.12%の確信度で"コミック" "デジタル時計" "サッカーボール"と誤認識する。(論文はこちら)

こんなに簡単に人工知能を騙せるなら、実世界での運用は危険過ぎるのでは?と考えてしまう。だが、実際には攻撃者は人工知能の内側には入れないため、インプットデータに不自然なノイズを乗っけて細工することはできないし、周囲のコンテキスト(自動運転なら、違うアングルから連続的に画像を取得したり、GPSも併用する)から総合的判断ができるため、攻撃を成功させるのは容易ではない。

人工知能の新しい騙し方

最近、人工知能を騙す新しい攻撃手法に関する面白い論文が出てきた。

Robust Physical-World Attacks on Machine Learning Models

https://arxiv.org/abs/1707.08945

解説記事

Slight Street Sign Modifications Can Completely Fool Machine Learning Algorithms

人工知能にインプットされるデータに細工が出来ないのならば、実際の物理空間を人工知能の判断が困難になるように構成すれば騙すことが出来るのでは、というアイデアだ。

↑設置場所や角度に微妙な差を加えることで、STOPの標識を速度制限の標識と、右折の標識をSTOPの標識と誤認させることが出来たという。

しかし、論文を見る限り分類・評価につかっている人工知能の作り方がかなり怪しい。教師データがかなり少ないし、ニューラルネットの規模も小さく、まともな精度の分類器で評価できていると思えず信憑性には疑問が残る。

サイバーセキュリティのゆくえ

上の論文は怪しい気がするのだけど、今後のAIの発展について深い示唆があると感じた。それは、人工知能へのハッキングがサイバーセキュリティの新しい主戦場になりそうだ、という事だ。光ディスクのコピーコントロール技術が出る度、ハッカーがそれをあっさりクラックするように、"新しい手法が発見されAIを欺く"→"対策される"→"また新しい手法が...." といういたちごっこになることが想定される。

そんな事情を鑑みると、人工知能モデルの防御策について研究する分野は今後重要性がどんどん高まっていくと思う。

こんぴゅです! 外苑前から皆様に役立つテックな話題をお届けしております。もし100円でもサポいただければ励みになります。記事もグレードアップします。何卒よろしくお願いいたします