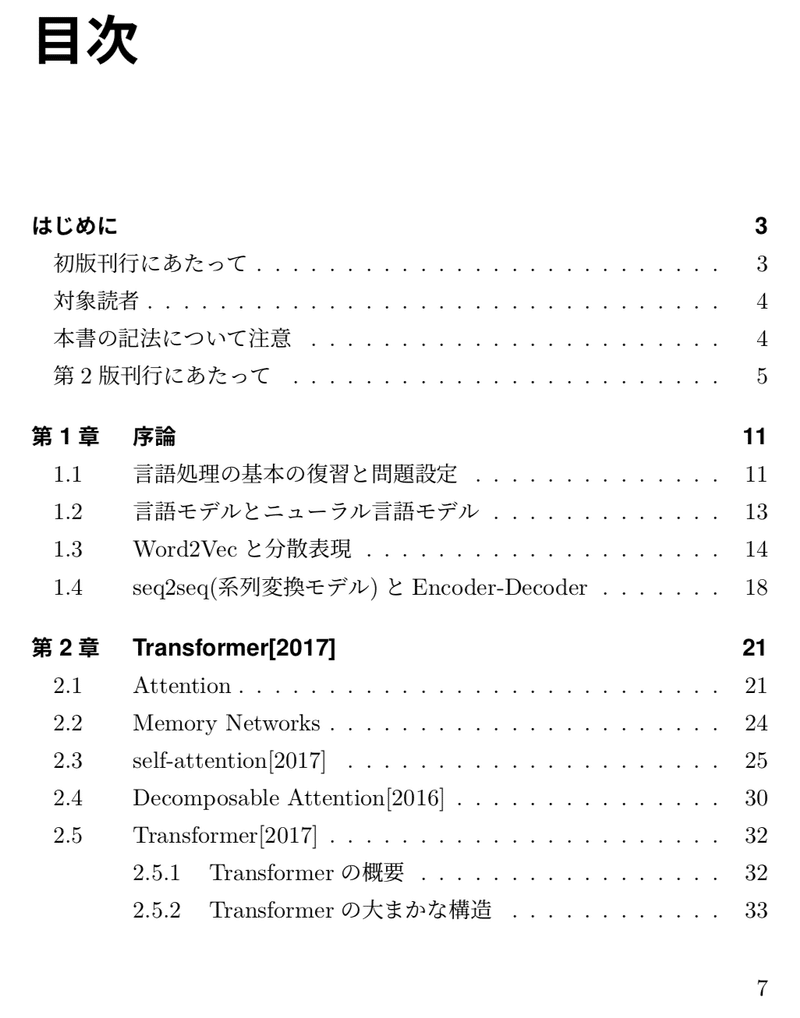

【累計200部突破!】BERT・XLNetに学ぶ、言語処理における事前学習(第3版 電子書籍 136ページ)

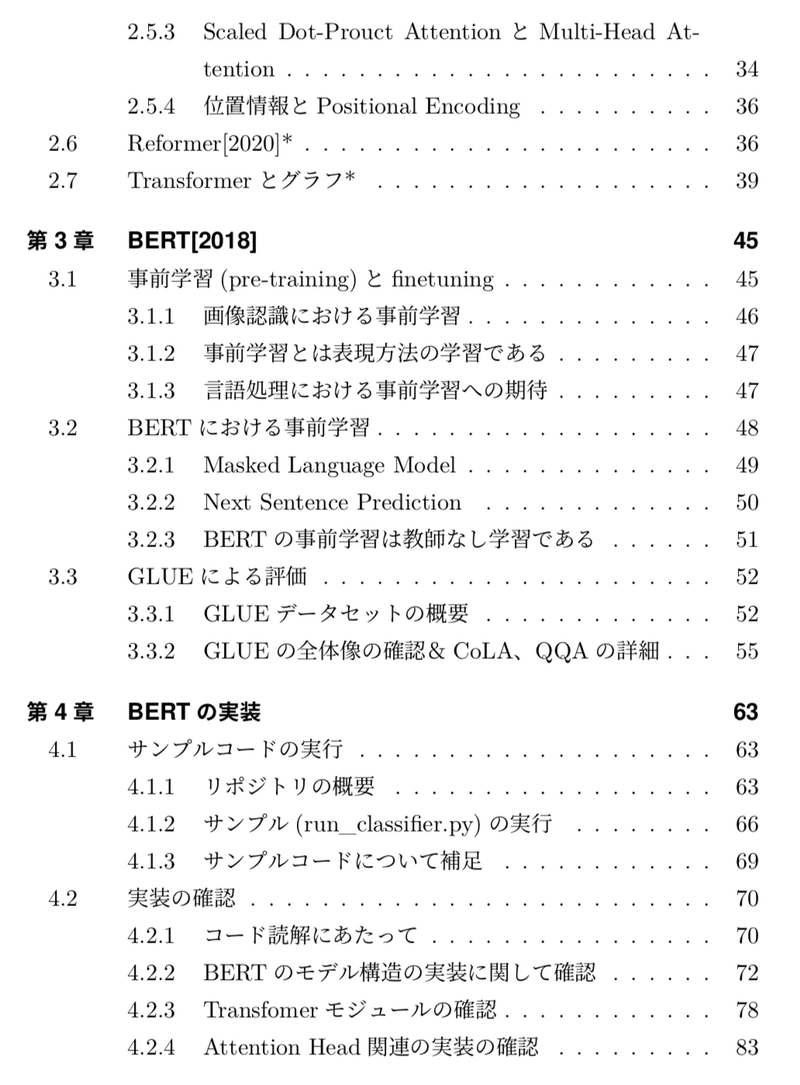

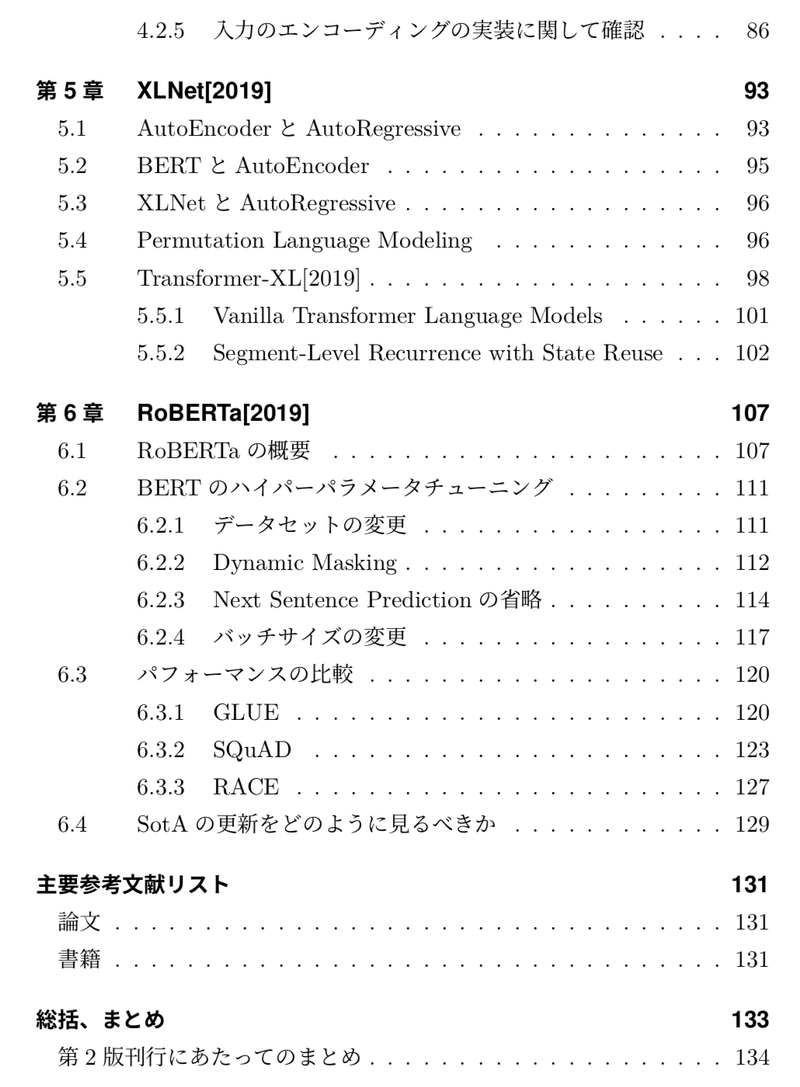

近年話題のBERT・XLNetなどの言語処理における事前学習モデルについて取り扱っています。論文や著者に近しい出展の実装など、極力一次ソースを元に言語処理の基本的な内容も加筆しながらまとめた形になります。事前知識に自信のない方は下記を先にご検討いただけたら良いのではと思います。

第2版の刊行にあたって、第2章の記述の大幅の見直しを行いました。具体的にはself-attentionに関する研究[2017]、Decomposable Attention[2016]、Reformer[2020]を追記し、Transformerがより多面的に理解できるように加筆を行いました。

【第3版追記】 第3版の刊行にあたって、TransformerのGraph Neural Networkとの関連性について2-7節に追記を行いました。

ここから先は

298字

/

1ファイル

¥ 1,600

この記事が気に入ったらサポートをしてみませんか?