なぜAIは突然、自ら考え始めたのか?

今回は、なぜ大規模言語モデルがこれほど強力なのかについて話しましょう。

現在最も人気のあるいくつかの生成型AI、ChatGPTや絵を描くAIを含む、その背後には「大規模言語モデル(Large Language Models、略してLLM)」があります。これはAGI(汎用人工知能)への技術的道のりでもあります。

論理的ChatGPT

まず例を挙げてみましょう。ChatGPTに「野球のバットは人の耳に隠せますか?」と尋ねると、できないと答えます。人の耳は非常に小さく、野球のバットのサイズや形状は耳に収めることができる範囲を超えているからです……とても論理的です。

次に、「なぜ如意棒を孫悟空の耳に隠せるのか?」と尋ねると、それは架空の話であり、如意棒の形状やサイズは自由に変えられるからだと答えます……

よく考えてみると、これらの回答は非常に素晴らしいものです。多くの人は言語モデルが経験に基づいており、単語間の関連性に基づいてのみ答えを出すことができ、本当の意味で考える能力はないと言います……しかし、これらの質疑応答を見ると、ChatGPTには考える能力があると言えます。

野球のバットが人の耳に隠せるかどうかについて記事を書く人はいるでしょうか?ChatGPTが答えを出せたのは、以前にこのような議論を聞いたことがあるからではなく、ある程度の推論ができるからです。野球のバットと耳の相対的なサイズを考慮し、金箍棒と孫悟空が架空のものであることを知っています。

これらの思考はどのようにして得られたのでしょうか?

想像もしていなかったかもしれませんが、これらの能力は開発者が設計したものではありません。

開発者は言語モデルに各種物体のサイズを理解させることを求めず、どの内容が架空のものかを知るための設定もしていません。このようなルールは挙げればキリがなく、それは行き詰まりを意味します。

ChatGPTの背後にある言語モデル、GPTは、完全に自己学習によってこれらの思考能力を手に入れました。そしてその他にも、挙げたらきりがないほどの能力を持っています。開発者でさえ、それがどれほど多くの思考能力を持っているかを正確には説明できません。

言語モデルがこのような魔法のような能力を持つ主な理由は、それが十分に大きいからです。

「大きな」モデル

GPT-3は1750億のパラメータを持っています。Metaは最近、650億のパラメータを持つ新しい言語モデルLLaMAを発表しました。Googleは2022年4月にPaLMという5400億のパラメータを持つ言語モデルを発表しました。それ以前には、1.6兆のパラメータを持つ言語モデルも発表しています。OpenAIのCEOであるサム・アルトマン(Sam Altman)によると、GPT-4のパラメータはGPT-3よりも多くないとのことですが、多くの人がGPT-5のパラメータはGPT-3の100倍になります。

これは今日になって初めて可能になったことです。以前は、計算能力は言うまでもなく、トレーニングモデルのコーパスを保存するためのコストだけでも天文学的な数字でした。1981年には1GBのストレージコストは10万ドルでしたが、1990年には9000ドルに下がり、現在では数セントです。今日のAI科学が過去と比べて進歩した点を挙げるとすれば、コンピュータハードウェアの条件が最大の進歩です。

今日私たちが行っているのは「大きな」モデルです。

大きさが違います。もちろん言語モデルには多くの巧妙な設計がありますが、特に何度も言及されているトランスフォーマーは、最も重要なアーキテクチャ技術の一つです。しかし、主な違いは大きさにあります。モデルが十分に大きく、トレーニング用のコーパスが十分に多く、トレーニング時間が十分に長い場合、いくつかの魔法のような現象が起こります。

2021年、OpenAIの研究者たちは、ニューラルネットワークのトレーニング中に意外な発見をしました。

例えば、あなたが生徒に即興演説を教えているとします。彼は何もできませんので、多くの既存の素材を見つけて彼に模倣させます。トレーニングの初期段階では、彼はこれらの素材をうまく模倣することもできず、言葉に詰まりながら文を作ることができません。トレーニングが深まるにつれて、彼は既存のスピーチをよく模倣するようになり、ほとんど間違いを犯さなくなります。しかし、練習していない新しいトピックを彼に与えると、うまく話せません。そこで、あなたは彼に続けて練習させます。

続けて練習することに意味がないように思えます。なぜなら、今では模倣する限り彼はすべてうまく話せるようになり、本当に即興で演説することができないからです。しかし、あなたは動じず、彼に練習を続けさせます。

そうして練習を続けていると、ある日突然、彼が即興演説ができるようになったことに驚きます!どんなトピックでも、彼はその場で創作して上手に演説できるようになりました!

このプロセスは下の図に示されています——

赤い曲線はトレーニングを、緑色の曲線は生成的なパフォーマンスを表しています。トレーニングが1000ステップ、あるいは1万ステップに達すると、モデルはトレーニング問題に対して非常に良いパフォーマンスを示しますが、生成的な問題に対してはほとんど能力がありません。10万ステップに達すると、モデルはトレーニング問題に対して完璧な成績を示し、生成的な問題にもパフォーマンスを示し始めます。100万ステップに達すると、モデルは生成的な問題に対してほぼ100%の精度を達成します。

これは量の変化が質の変化を生むことを意味します。研究者はこの現象を「グロッキング(Grokking)」と呼んでいます。

質の変化

グロッキングとは、いったい何が起こったのでしょうか?

焦らずに、もう一つ例を挙げてみましょう。ChatGPTには「少数サンプル学習(Few-Shot Learning)」と呼ばれる重要な能力があります。つまり、1つか2つの例を与えるだけで、それを学習して意図を理解し、類似の出力を提供できるのです。

例えば、私がChatGPTに例題を出して、小学校の数学問題をいくつか出してもらうように依頼します。私の例題は「Aさんには3つのリンゴがあります。お母さんが彼にさらに2つのリンゴを与えました。彼は今、何個のリンゴを持っていますか?」というものです。ChatGPTはすぐに5つの問題を出し、すべてがこのスタイルでした——例えば「Aさんには5本のペンがあります。彼は3本のペンを贈りました。彼には何本のペンが残っていますか?」といった問題です。

まるで対句のようです。少数サンプル学習は重要な能力であり、この能力を利用してChatGPTに多くのことを手伝ってもらうことができます。では、この能力はどのようにして生まれたのでしょうか?

それは、より多くのパラメータとトレーニングから来ています。以下の図を見てください——

この図は、GPT-2とGPT-3モデルの進化を示しています。パラメータが多ければ多いほど、少数サンプル学習の能力が強くなります。

そして、少数サンプル学習はその中の一つに過ぎません。他にも多くの能力があり、大きくなればなるほど、それらが現れます。

創発(そうはつ)

この現象は、科学者が以前から言っていた「創発(Emergence)」と実は同じです。創発とは、複雑なシステムがある程度の複雑さに達すると、システムの要素が単純に積み重ねられたものを超える、自己組織化された現象が発生することを意味します。たとえば、個々のアリは非常に愚かですが、アリの群れは非常に賢いです。各消費者は自由ですが、市場全体はまるで秩序があるかのように見えます。各神経細胞は単純ですが、脳は意識を生み出します……

幸いなことに、大規模言語モデルも、予想外の様々な能力が涌現します。

2022年8月、Google Brainの研究者が発表した論文は、大規模言語モデルのいくつかの涌現能力に特に焦点を当てています。これには、少数サンプル学習、突然の加減算の学習、突然の大規模な多任務言語理解の学習、分類学習などが含まれます……これらの能力はモデルのパラメータが1000億を超えると現れ始めます——

もう一度強調しますが、研究者はこれらの能力をモデルに意図的に植え付けたわけではありません。これらの能力はモデルが自ら見つけ出したものです。

まるで子どもが成長すると、親の予想を超えることがよくあります。

思考の連鎖

もちろん、モデルを適切に設計することも重要です。トランスフォーマーアーキテクチャは非常に重要で、モデルが単語間の関係を発見することを可能にします——どのような関係であっても、距離が遠くても恐れません。しかし、トランスフォーマーを発明した研究者は、それがこれほど多くの新しい能力をもたらすとは思っていませんでした。

事後分析によると、新しい能力の涌現の鍵となるメカニズムは「思考の連鎖(Chain-of-Thought)」と呼ばれています。

簡単に言うと、思考の連鎖とは、モデルが何かを聞いた後に、それに関連するさまざまな事柄をぶつぶつと自分自身に言いながら、一つずつ述べることです。

たとえば、「夏」という言葉をモデルに言うと、「夏は日差しが明るい季節で、人々は海辺で泳いだり、屋外でピクニックを楽しんだりできます……」などと答えます。

思考の連鎖は、言語モデルに思考能力を与える方法は何でしょうか?例えば、前に話した野球のバットの問題を考えてみましょう。モデルが野球のバットについて聞くと、自分自身で野球のバットのさまざまな側面について語り始めます。その中にはサイズも含まれます。そして、質問に「耳に入れる」という言葉が含まれているため、サイズは注目すべき特性です。耳についても同様です……モデルは両者のサイズの特性を比較し、それらが反対であると判断し、入れられないと結論づけます。

思考過程を言語で記述できる限り、言語モデルにはその思考能力があります。

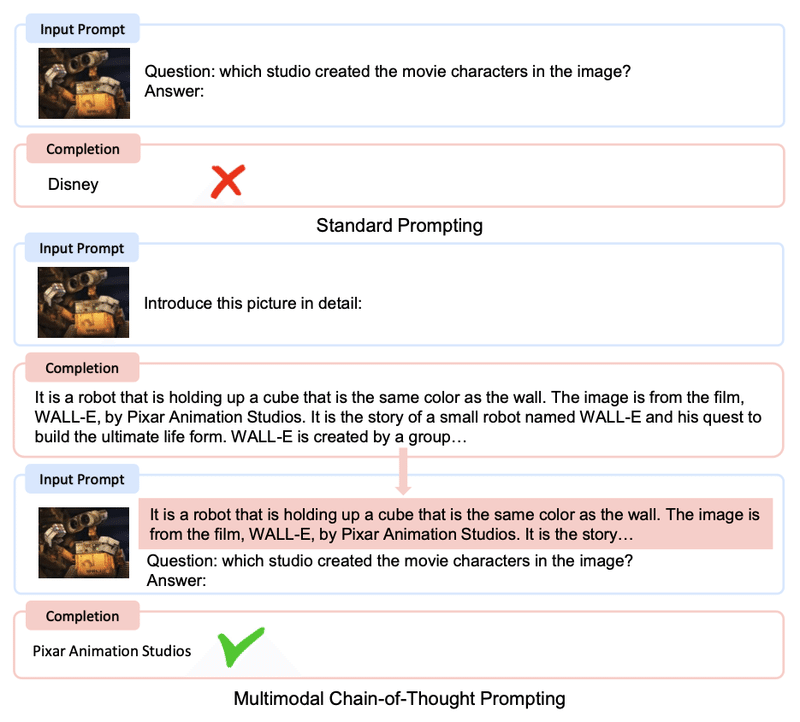

もう一つの実験を見てみましょう——

ピクサー映画「ウォーリー」のスチル写真をモデルに見せ、そのキャラクターを作った制作会社はどこかと尋ねます。思考の連鎖がなければ、モデルは間違った回答をします。

思考の連鎖をどのように使用しますか?まず、モデルに写真を詳細に説明させることができます。「写真には、ロボットが手にキューブを持っており、その写真は『ウォーリー』からのもので、その映画はピクサーが制作した……」と言います。この時点で、あなたがちょうど言った内容を簡単に繰り返し、再びそのキャラクターを作った制作会社はどこかと尋ねると、正しい答えが得られます。

このように、モデルに質問に答える前に毎回考えさせるように設定すれば、それは自動的に思考の連鎖を使用し、思考能力を持つことになります。

ある分析によると、思考の連鎖は、モデルをプログラミングトレーニングする際の副産物である可能性があります。現在のGPTはプログラマーのプログラミングを手伝うことができます。プログラミングトレーニングを受ける前には、思考の連鎖がありませんでした。おそらくプログラミングトレーニングでは、モデルがある機能がどのように実装されるかを最初から最後まで追跡する必要があり、2つの遠く離れたものを結びつけることができるようになる必要があります。このようなトレーニングにより、モデルは自発的に思考の連鎖を生み出しました。

マルチモーダル大規模言語モデル

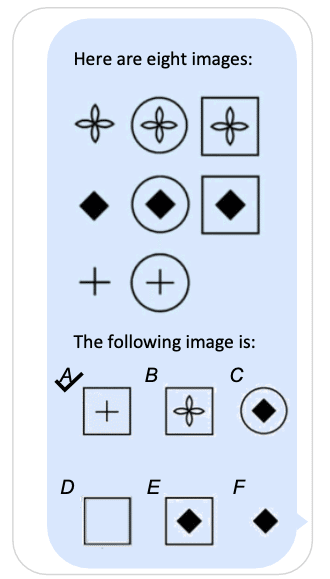

2月27日に、Microsoftは「マルチモーダル大規模言語モデル(multimodal large language model、MLLM)」と呼ばれる自社の新しい言語モデルについての論文を発表しました。そのコードネームはKOSMOS-1です。

マルチモーダルとは何でしょうか?ChatGPTはテキストのみを入力として受け付けます。マルチモーダルでは、画像、音声、ビデオを入力として受け付けることができます。その原理は、すべてのメディアを言語に変換し、それを言語モデルで処理することです。マルチモーダルモデルは、以下のような「画像を見てルールを見つける」IQテストの問題を解くことができます——

前述の「ウォーリー」のスチル写真の例は、この論文からのものであり、画像を見て話す思考の連鎖を示しています。論文には、私にとってかなり驚くべき例が含まれています——

鴨とウサギのように見える画像をモデルに見せ、これは何かと尋ねます。モデルは、これは鴨だと答えます。これは鴨ではないと言うと、再度推測してみてくださいと言います。モデルは、これはウサギのようだと言います。なぜかと尋ねると、画像にウサギの耳があるからだと答えます。

この思考過程は人間と全く同じではないでしょうか?

三つの境界

荀子の「勧学」にある一節を引用すると、AIの能力の3つの境界を描写するのにぴったりです——

第一の境界は「土を積み上げて山を成し、風雨を引き起こす」です。十分なパラメータと一定のトレーニングが蓄積されれば、ある程度のことができるようになります。例えば、AlphaGoが囲碁をするように。

第二の境界は「水を積み上げて深みを成し、蛟龍が生まれる」です。モデルがさらに大きくなると、予想外の驚くべき機能が涌き出てきます。たとえば、AlphaZeroが人間のやり方に従わずに囲碁をする、大規模言語モデルの思考の連鎖などです。

第三の境界は「善を積み上げて徳を成し、神明が自然に得られ、聖心が備わる」です。これがAGIです。自我を持ち、さらには道徳感を持つようになります……

古今東西、多くの人が「勧学」を読んできましたが、実際に荀子の要求に従って学んだ人は何人いるでしょうか……しかし、今、AIは確かに聞き入れています。学習材料を与えれば、本当に学びます。

最後

グロッキングと創発により、AIは現在、推論、類推、少数サンプル学習など、思考能力を含む多くの能力を獲得しています。

以前にAIに関して行われたさまざまな仮定——AIは経験に全面的に依存し、本当に考えることはなく、創造力がない、そして「AIができるのは言語で表現できることだけ」という仮定を再考する必要があります。今では、思考の連鎖を通じてAIがこのような思考レベルに達することができるなら、人間はどのように考えるのでしょうか?私たちの脳も意識的または無意識的に思考の連鎖を使用しているのではないでしょうか?もしそうなら、人間の脳とAIの本質的な違いは何でしょうか?

これらの質問はすべて、全く新しい答えを求めています。

次回は、AIの能力の限界について話しましょう。

この記事が気に入ったらサポートをしてみませんか?