ビデオとオーディオのクロック同期

動画のライブ配信において、ビデオとオーディオの同期は避けて通れない問題です。ビデオとオーディオの同期は、時間経過とともにビデオとオーディオの同期がずれることを防ぐためのクロック同期の話と、ビデオ機材内部で発生する遅延量にオーディオの遅延量を合わせる「リップシンク」の話がありますが、今回は前者について、一般的な同期方法とLive Extremeの違いについて説明します。

SDI規格とオーディオ・エンベッダ

オーディオ畑の人にはあまり馴染みがないかもしれませんが、動画のライブ配信現場におけるビデオ機器 (カメラ、スイッチャー、エンコーダーなど) 間の伝送には「SDI (Serial Digital Interface)」が用いられることが一般的です。これはBNCケーブル一本で非圧縮のデジタル映像信号とともに、8chのデジタル音声信号 (AES/EBU) を伝送できる規格となっています。

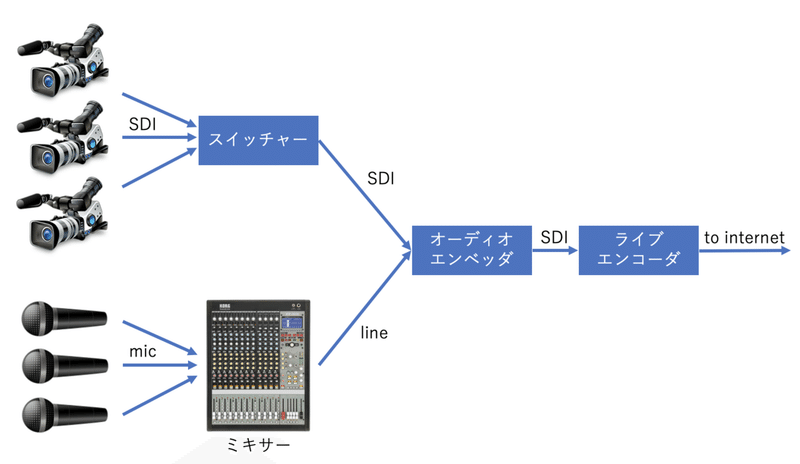

下記に一般的なライブ動画配信システムの構成例を示します。

収録段階においては、映像と音声は完全に別系統で扱われ、それぞれスイッチング/ミキシングされます。これをライブ配信するとなると、エンコード前のどこかの段階で、SDI映像信号の中に音声を多重化する必要があります。この役割を担うのが「オーディオ・エンベッダ」と呼ばれる装置で、単体機としても販売されていますが、スイッチャーやライブ・エンコーダーの一機能 (オーディオ入力端子) として提供されている場合もあります。

オーディオ・クロックのジッタ量と音質の関係

ビデオ信号にオーディオ信号を多重化するには、両者をクロック単位で同期させる必要がありますが、デジタル・オーディオの品質はオーディオ・クロックの精度によって大きく左右されることに留意しなくてはなりません。

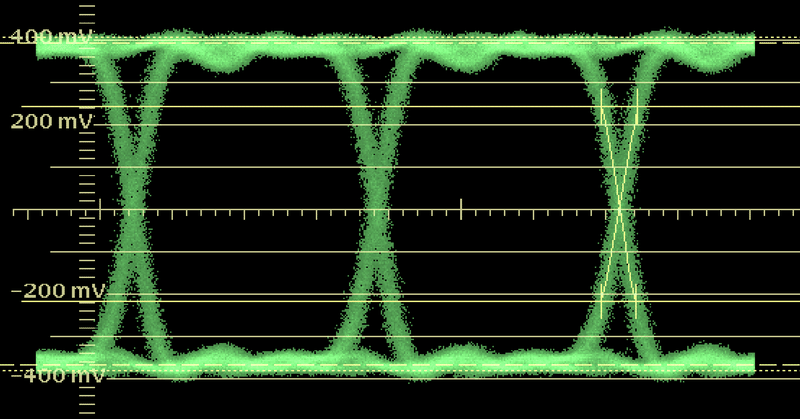

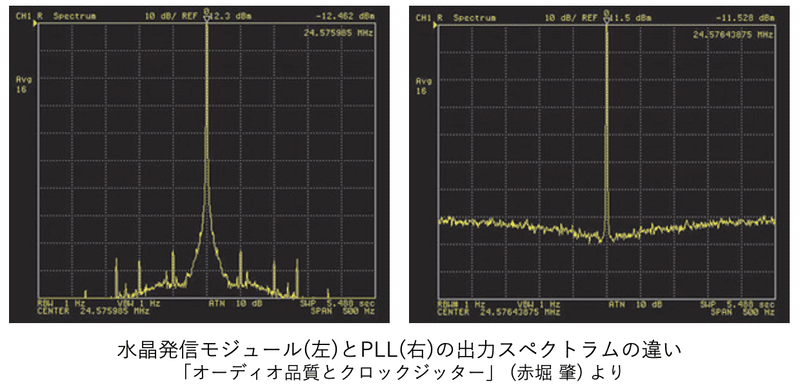

一般に、クロックのジッタ量が大きくなると、高調波歪みやノイズ量を表す「THD+N」特性が劣化することが知られています。通常、オーディオ機器に要求されるマスター・クロックのジッタ量は数十~200psで、中には1psのジッタ量を切る内蔵クロック性能を売りにした機器まで存在しています。

一方、SDI規格で許容される「タイミング・ジッタ」量は670ps程度と、上記とは一桁違っており、オーディオのクロック同期ソースとして適切とは言えません。動画配信において音質を重視するのであれば、いかにオーディオ・クロックをビデオ・クロックから分離するかが重要となります。

[参考] クロック・ジッタと音質の関係については、以下のサイトが大変参考になります。

ビデオ・クロックとオーディオ・クロックの同期

このセクションでは、ビデオ・デバイスとオーディオ・デバイスの同期方法とその音質について考えてみます。

なお、ビデオとオーディオの同期方法として、映像機器にTime Codeを使って記録し、ポスプロ (編集段階) で時間軸を合わせる、ということもよく行われていますが、ここではライブ配信に焦点を絞り、あくまでもクロック同期(Genlock / Word Sync)させる方法について取り上げます。

(1) オーディオ・マスター構成

オーディオ品質を最優先として考えた場合、以下のようにオーディオ・デバイスのクロックをマスターとして、ビデオ・クロックを生成するのが最も理想的と言えます。これはビデオ・クロックの影響をオーディオ機材が受けない唯一の構成です。

しかし、映像制作が主体となる配信現場では、かなりイレギュラーな配線であり、この構成が実現できない外的要因は多々存在します。

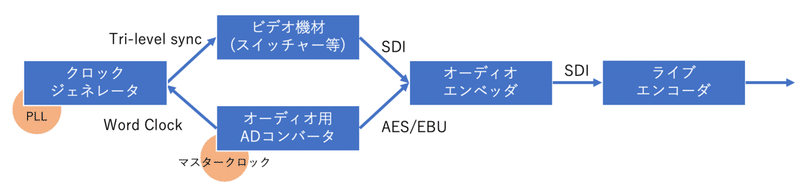

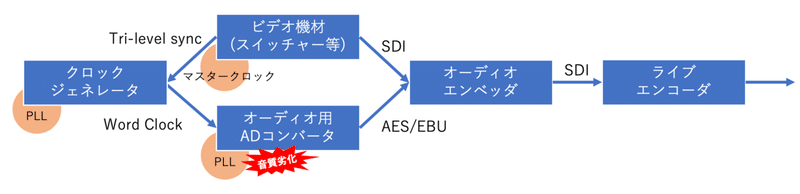

(2) 外部マスター構成

次は共通の外部マスタークロック・ジェネレータから、オーディオ・クロックとビデオ・クロックをそれぞれ生成し、各機材を同期させるという方法です。

こちらは高品位なマスタークロック・ジェネレータを使用することで、ある程度オーディオ品質を担保することができます。ただし、オーディオ用ADコンバータ内で PLL (Phase Locked Loop) という同期回路が使われることとなり、前述のオーディオ・マスター構成に比べジッタ量が増えることは避けられません。

また、ビデオ機材によっては外部クロックにGENLOCKできない仕様のものがあり、そもそもこの構成を取れない可能性があります。

(3) ビデオ・マスター構成 (その1)

上記のような事情もあり、結局のところ、ビデオにオーディオを同期させるという方法が一般的なわけですが、これはビデオ信号に含まれるジッタがオーディオ機材に影響を与えることになり、音質的には不利な構成と言えます。

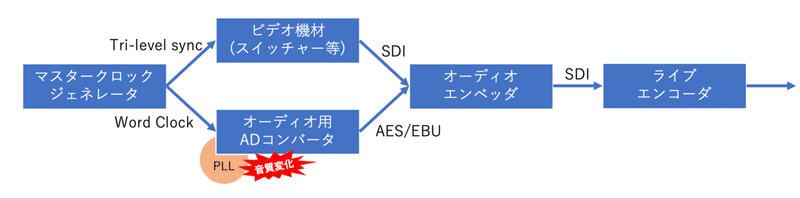

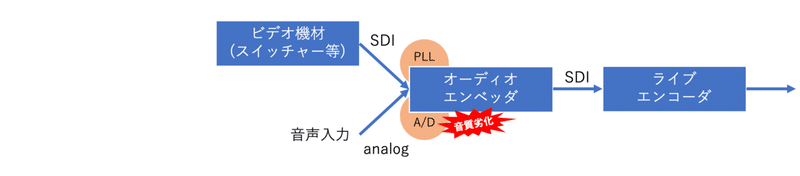

(4) ビデオ・マスター構成 (その2)

下図のように、オーディオ・エンベッダ (スイッチャーやライブ・エンコーダー内蔵のものを含む) にアナログ入力した場合も状況としてはビデオ・マスター構成と同等で、ビデオ信号に含まれるジッタがオーディオ機材に影響を与えることになります。

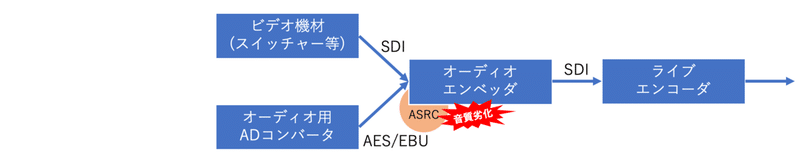

(5) 非同期構成

非同期のビデオ信号とデジタル音声信号をオーディオ・エンベッダに入力した場合は、オーディオ・エンベッダ内部で ASRC (Asynchronous Sample Rate Converter) が映像と音声のクロックの違いを補正するように働くことになります。

この構成だとASRCによってビデオ信号のジッタの影響は受けなくなることになりますが、ASRCという一種の LPF (低域通過フィルタ) を通過することになり、結局のところ音質の劣化は避けられません。

Live Extremeの「オーディオ・ファースト」同期

Live Extreme Encoderは、映像入力としてSDIまたはHDMI、音声入力としてASIO対応の外部オーディオ・インターフェイスを使用することが可能です。これは、Live Extreme Encoder自体がオーディオ・エンベッダの役割を果たしていることになりますが、入力される映像と音声がクロック同期している必要はありません。むしろ特別な事情がない限り、オーディオ入力デバイス (ADコンバータ) は内蔵クロックで自走させることを推奨しています。

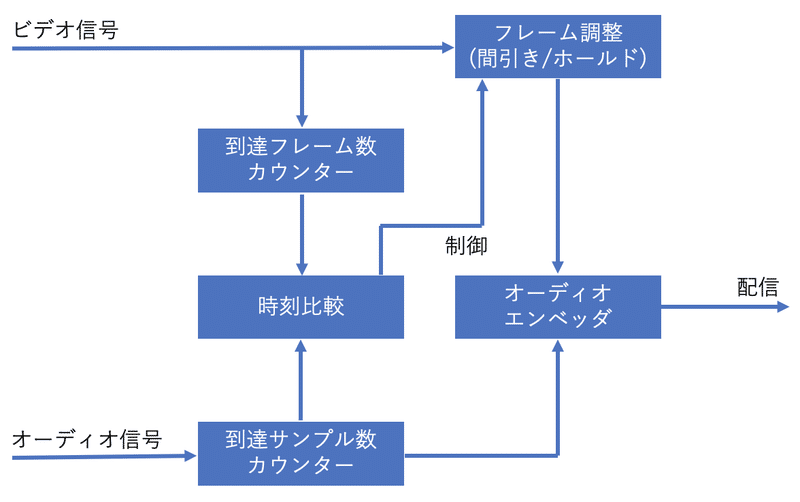

Live Extreme Encoderは、キャプチャされたビデオ信号のフレーム数とオーディオ信号のサンプル数を常に監視しており、両者に映像1フレーム分以上の差異が認められた時に、映像のフレームを間引き、または追加 (ホールド) します。これにより映像と音声の同期が保たれるようになるのですが、注目すべきは音声側の信号が同期処理によって全く影響されない点で、A/Dされた信号がビット・パーフェクト (無劣化) で配信されることになります。

これは、映像に音声を合わせるのではなく、音声に映像を合わせている状態であり、Live Extremeの同期方法が「オーディオ・ファースト」と呼ばれている理由です。

音質については、前述の理想的な「(1) オーディオ・マスター構成」と同等となりますが、Live Extremeの場合は、

・高価なクロック・ジェネレータが不要

・収録現場でのクロック線の引き回しが不要

など、音質面以外でのメリットもあります。

以上、ビデオとオーディオの同期方法について見てきました。次回は各種ロスレス・オーディオ・コーデックについて掘り下げてみようと思います。

この記事が気に入ったらサポートをしてみませんか?