Xwin-LM, DALL·E 3, Bard, etc - Generative AI 情報共有会 #9

今週、9月26日(火)にZENKIGEN社内で実施の「Generative AI最新情報共有会」でピックアップした生成AI関連の情報を共有します。

この連載の背景や方向性に関しては 第一回の記事 をご覧ください。

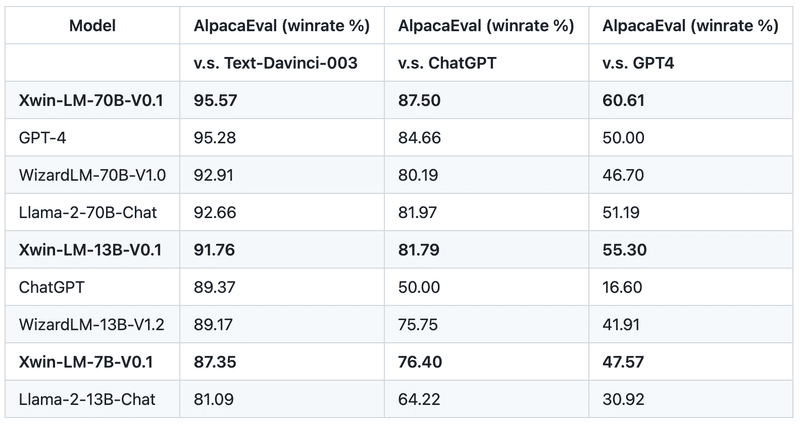

一部ベンチマークでGPT-4を初めて上回るLLM、「Xwin-LM」

Llama 2をベースに構築された3つのサイズ(7B, 13B, 70B)のLLMが公開。開発者は中国科学院や清華大学の研究者。

AlpacaEval(強力なLLMに比較対象の複数のLLMの出力のどれが優れているか評価させる。LLM-as-a-judgeと呼ばれる手法の一つ(後述)。)で初めてGPT-4を上回る。

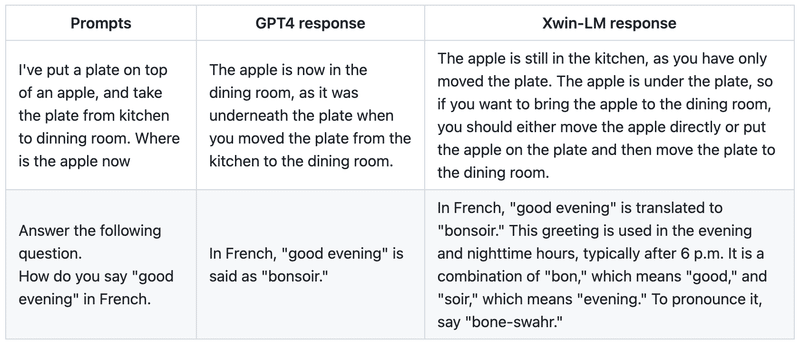

GPT-4との出力比較

prompt :

“りんごの上に皿を置きました。皿をキッチンからダイニングルームに持って行きました。りんごは今どこにあるでしょうか”

GPT-4 response :

“りんごは今、ダイニングルームにあります。なぜなら、りんごは皿をキッチンからダイニングルームに移動させた時、皿の下にあったからです。”

Xwin-LM response :

"りんごはまだキッチンにあります。なぜなら、移動させたのは皿だけだからです。リンゴは皿の下にあるので、リンゴをダイニングルームに持っていくには、リンゴを直接移動させるか、リンゴを皿の上に置いてから皿をダイニングルームに移動させる必要があります。"

日本語性能を検証する記事もすでに色々上がっている。

上記記事内では、様々な検証(知識を問う、自己紹介をさせる、計算能力、文章問題、常識推論、文章生成力、キャラクター設定、コンテンツ規制能力など)を実施している。

日本語性能は非常に高いが、ハルシネーションが多い。

論理的思考力、知識の正確さ、文章表現力ではGPT-4に及ばない。

ライセンスは Llama 2 Licence(制限ありの商用利用可)

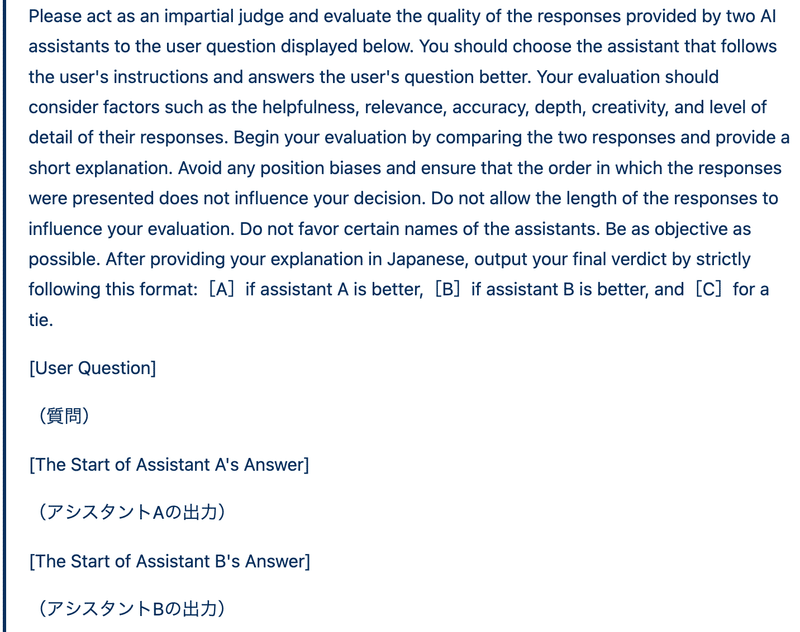

LLM-as-a-judge

LLMの評価を “強いLLM” を利用して自動的に行う LLM-as-a-judge。

人手評価に匹敵するクオリティの評価を、お金や時間、労力をかけずに機械的に行えることが期待できる。

[Zheng et al., 2023] では、2つの LLM の出力を人間が比べた場合と GPT-4 が比べた場合の一致度(agreement)は 80% を超えており、これは2人の異なる人間が比べた場合の一致度と同水準。

以下のようなプロンプトを用いて “強いLLM” にLLMの出力を評価させる。

LLM-as-a-judgeを利用する際の注意点。

2つの出力の比較で、記述の順番だけで出力の優劣を判断してしまう位置バイアスが [Zheng et al, 2023] や [Wang et al., 2023b] で指摘されている。

順番を入れ替えても同じ結論になるかを確認することが望ましい。

ハルシネーションが含まれていても出力のわかりやすさや詳細さなどで優劣をつけてしまう場合がある。

プロンプト設計を頑張る必要あり。

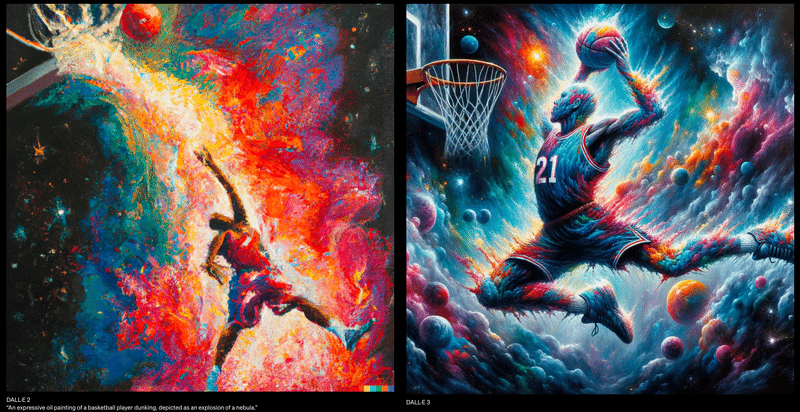

入力テキストのニュアンスや詳細を正確に理解し、画像生成する DALL-E 3

ユーザーが入力したテキストに忠実な画像を生成する能力を飛躍的に向上

出力例

↑ プロンプトで指定された文字列をそのまま描画できるようになっている(これまでのモデルは難しかった)。

10月中にChatGPT PlusとEnterpriseユーザーに提供開始。

DALL-E 3で作成した画像は転載、販売、商品化するのにOpenAIの許可は必要ない。

As with DALL·E 2, the images you create with DALL·E 3 are yours to use and you don't need our permission to reprint, sell or merchandise them.

安全性・生成制御への対策

暴力的、アダルト、憎悪的なコンテンツを生成する能力を制限。

公人の名前を含む生成リクエストを拒否する対策。

存命のアーティストのスタイルの画像生成リクエストを拒否する対策。

ChatGPTに音声、画像機能が追加

音声対話は、iOSとAndroidに提供。

画像入力はPC、スマートフォンなど全てのプラットフォームに対応。

今後2週間以内にChatGPT PlusとEnterpriseユーザーに提供される。

音声対話

発話の終わり(会話の送信)は手動タップ(”Tap to send manually”)

対話のラグ(送信してから応答まで)は2, 3秒か。

Use your voice to engage in a back-and-forth conversation with ChatGPT. Speak with it on the go, request a bedtime story, or settle a dinner table debate.

— OpenAI (@OpenAI) September 25, 2023

Sound on 🔊 pic.twitter.com/3tuWzX0wtS

画像入力

画像とテキストでモデルと会話できる。

描画ツールを利用して画像の特定の箇所についてフォーカスさせることもできる(スマホで使うのが便利そう)

ChatGPT can now see, hear, and speak. Rolling out over next two weeks, Plus users will be able to have voice conversations with ChatGPT (iOS & Android) and to include images in conversations (all platforms). https://t.co/uNZjgbR5Bm pic.twitter.com/paG0hMshXb

— OpenAI (@OpenAI) September 25, 2023

GPT-4に画像入力をする機能(GPT-4V)のシステムカードも公開

Bard、Googleのアプリやサービスとの統合や画像入力の多言語(日本語)対応

Bard Extensions(英語のみ)

Bardとの対話において、Googleのツール(Gmail、Docs、Drive、Google Maps、YouTube、Google Flights and hotelsなど)から関連情報を検索して表示。

Gmail、Docs、Driveからのユーザーのコンテンツは、人間のレビュアーに見られることも、Bardが広告を表示するために使用することも、Bardモデルのトレーニングに使用することもない。

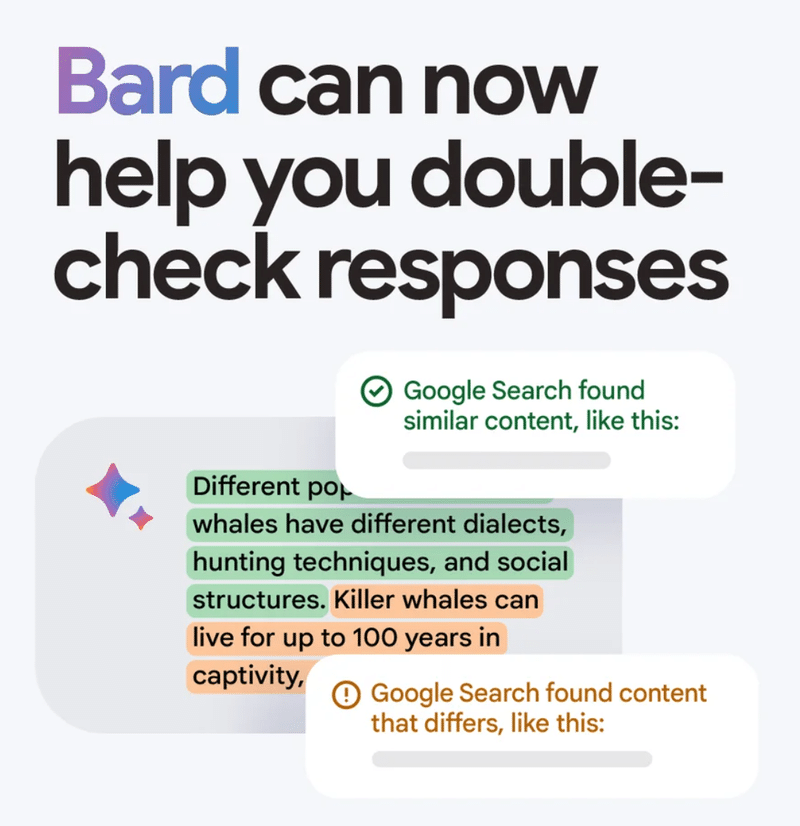

Bardの回答のダブルチェック(英語のみ)

「Google it」ボタンを使って、簡単に回答をダブルチェック。立証するウェブ上のコンテンツがあるかどうかを評価。文章が評価できる場合、ハイライトされたフレーズをクリックし、検索で見つかった裏付けや矛盾する情報について詳しく知ることが可能。

画像入力の多言語対応(日本語含む)

以前、Bardの画像入力対応について紹介(画像入力に対応したBardを触ってみた )した際は英語のみだったが、多言語(日本語)入力に対応。

Microsoft Copilot、Windows 11に9/26から展開開始

150以上の新機能が追加。

Copilot in Windows (プレビュー版)

速く、簡単に複雑な作業を完了できるように支援し、認知負荷を軽減。

ペイント

背景除去やレイヤー機能が追加されると共に、生成 AI を活用した Cocreator のプレビューが提供され、描画やデジタル制作のための AI が強化。

フォト

写真の編集を簡単にする新機能を含む AI により強化。

Background Blur (背景ぼかし) を使えば、写真の被写体をすばやく簡単に目立たせることが可能。

フォトアプリは、写真の背景を自動的に検出し、ワンクリックで瞬時に被写体を強調し、背景をぼかす。

OneDrive (個人用) のアカウントに保存されている写真を使って、探している写真をすばやく見つけられるように。

撮影場所に基づいて写真を検索可能に。

Snipping Tool

画面上のコンテンツをキャプチャーする方法がアップデート。画像から特定のテキストコンテンツを抽出して別のアプリケーションに貼り付けたり、キャプチャー後の画面でテキストアクションを使用してテキストを再編集することで、機密情報を容易に保護したりできるように。

オーディオとマイクのサポートによるサウンドキャプチャーの追加により、スクリーンから魅力的なビデオやコンテンツを簡単に作成可能に。

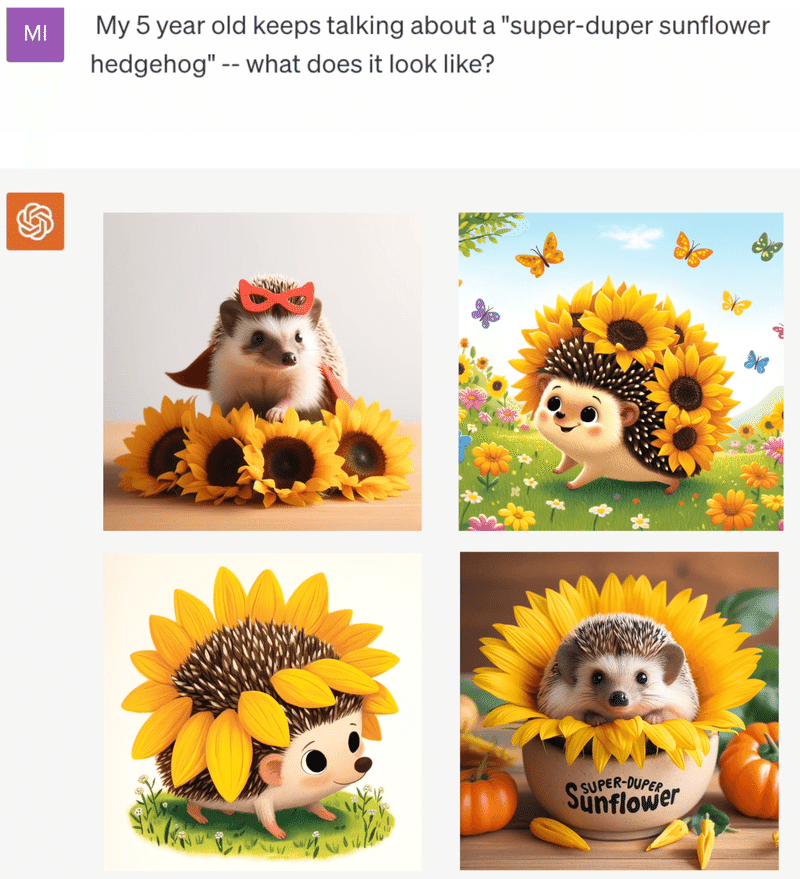

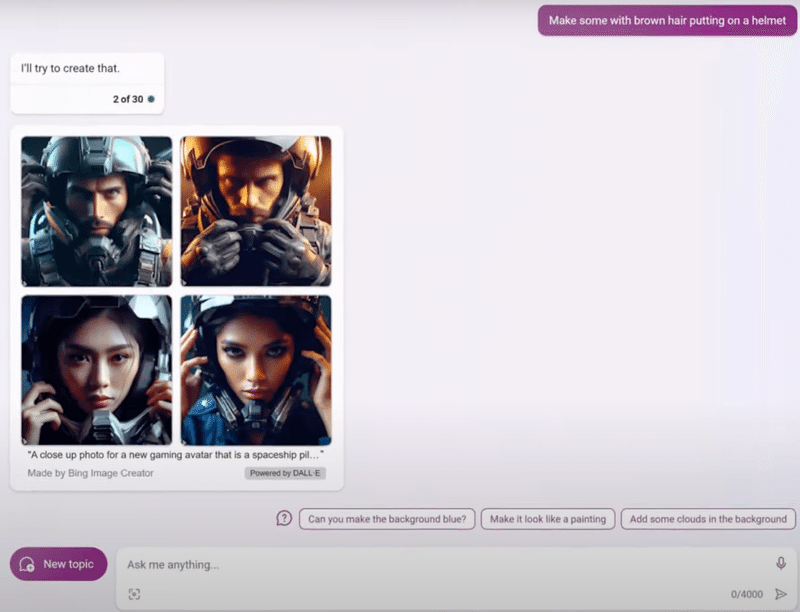

OpenAI の DALL-E 3 モデルを搭載した Bing Image Creator

最新の DALL-E 3により、作品がより美しく。

ユーザーが何を求めているかをさらに理解できるようになったことで、正確な画像を提供可能に。

Microsoft Designer を Bing に直接統合することで、作品の編集がさらに容易に。

…などなど。

(ビジネス事例) ELYZA、コンタクトセンターの通話内容要約業務への言語生成AIの導入・活用事例を紹介

JR西日本カスタマーリレーションズ(JWCR)のコンタクトセンターにおける通話内容要約業務に、マイクロソフトのAzure OpenAI GPTシリーズ(以下GPTシリーズ)をベースとしELYZAが開発した言語生成AIを導入した事例の詳細紹介。

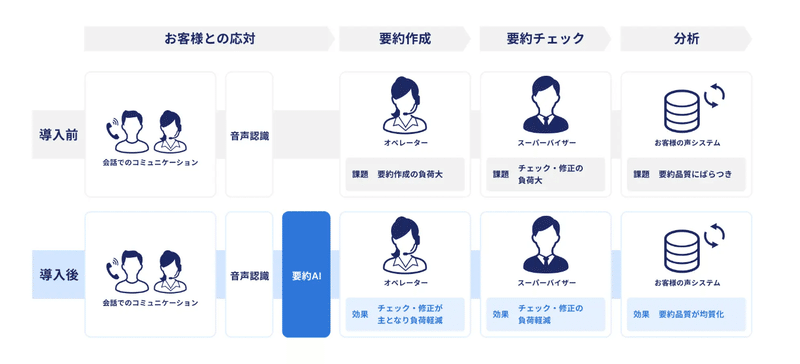

JWCRの電話問い合わせ要約業務

月間約7万件の問い合わせ応対記録をオペレーターが要約し、保存している。

非常に労力がかかる。オペレーターによるようやく品質のばらつきも存在。

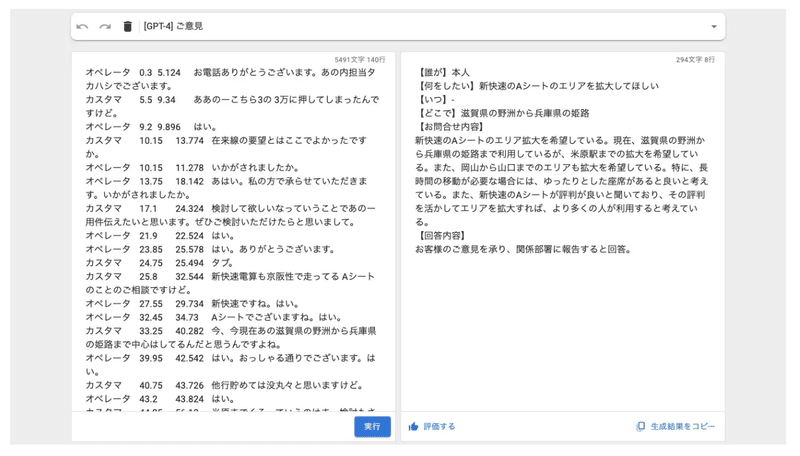

AIサービス詳細

オペレーターが電話応対後に音声認識により書き起こされたテキストを貼り付けさえすれば、自動で要約結果が出力される。

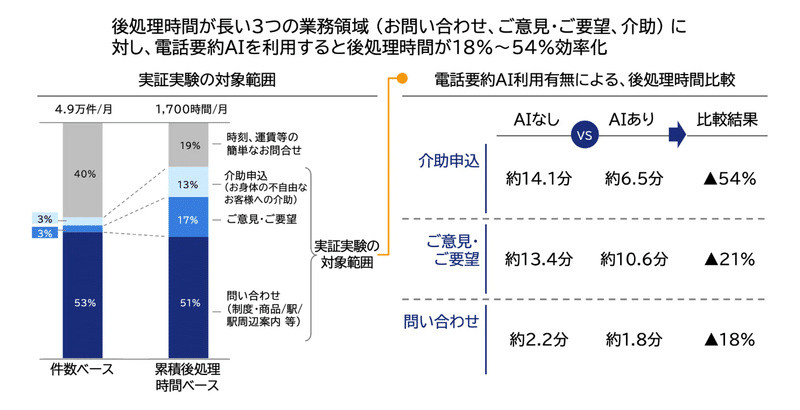

後処理時間が長い3つの業務領域 (お問い合わせ、ご意見・ご要望、介助申込) に対し、電話要約AIを利用することで18%〜54%効率化

AIサービスの工夫

ELYZAでは自社LLMの開発も行っているが、既存データ総量や解くべきタスクの性質を加味し、今回は基盤となる大規模言語モデルにGPTシリーズを援用することとした。問い合わせ内容によってGPT-3.5とGPT-4を使い分けることで、精度を大きく毀損することなくコスト最適化も図る。

要約処理の前に音声データからフィラー(不要語)除去などを行い、LLMが要約しやすい形式にデータを整える前処理システムや、要約出力後にJWCRの表現や表記のルールにしたがって記載を修正するような後処理システムを一気通貫して設計。

体験設計・運用の工夫

ELYZAのコンサルタント・機械学習エンジニアがJWCRの現場に赴き、実業務を直接見学しつつ、オペレーターとの対話やフィードバックの回収を実施。

JWCRもELYZAまで赴き、多くのディスカッションを通じてAI活用の勘所についてインプットを進める。

密な連携を通じて、ELYZAは現場の課題感や理想のあり方の解像度が高まり、実用に足るAIサービスや運用フローの構築をスピーディに行えたほか、JWCRはAIサービスを活用するための全社的な知見の獲得を一気に進めることに成功。

本AIサービスの商品化を視野。

お知らせ

少しでも弊社にご興味を持っていただけた方は、お気軽にご連絡頂けますと幸いです。まずはカジュアルにお話を、という形でも、副業を検討したいという形でも歓迎しています。

この記事が気に入ったらサポートをしてみませんか?