ローカルLLMを動かすOllamaのインストール方法

Ollamaというツールを使えばローカル環境でLLMを動かすことができます。

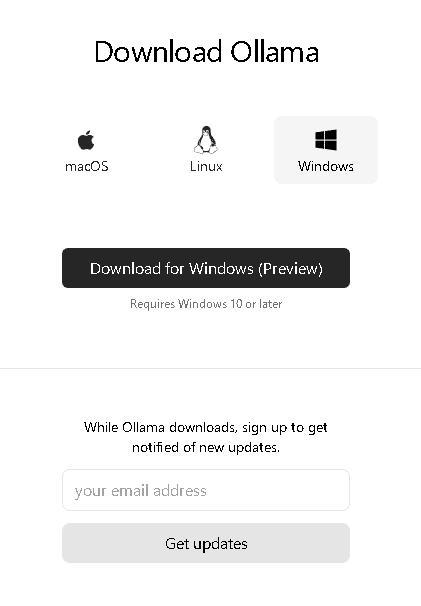

Windows版だけではなく、MacOSやLinux版もありますので、各自の環境に合わせてインストールすることができます。

Ollamaは、Windows環境をインストールしてみましょう。

"Download for Windows (Preview)"と書いてあるところをクリックするとexeファイルがダウンロードできます。

そのEXEファイルを実行すればインストールが始まります。

インストールが終わりましたら、コマンドプロンプトで下記を実行して、Ollamaがインストールされたかどうかを確認しましょう。

ollama --help次のように、ヘルプ画面が表示されます。

(venv) D:\Python>ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.※2024/05/03追記

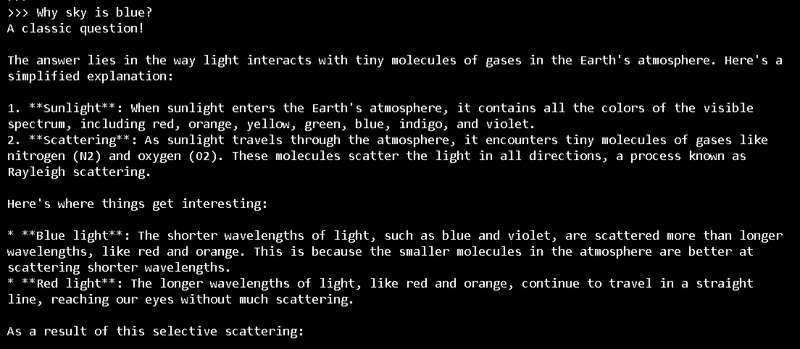

次に、ローカルLLMをダウンロードして試してみましょう。今回は、llama3の8Bモデルをダウンロードします。

ollama run llama3初回だとllama3のダウンロードが始まり、終わりましたらsuccessと表示されるので、何か聞いてみましょう。今回は"Why sky is blue?"と聞きました。

GUI版が良いという人は、LM Studioというツールがありますので、以前書いた記事を参考にしてみてください。

この記事が気に入ったらサポートをしてみませんか?