2030年のLLMのベンチマークはどうなるんだろうか

前提

たぶん来年か再来年には平均的な人類より頭のよい言語モデルが出来て、2030年代初頭くらいには人類より数十倍賢い言語モデルができるのだと想定している。そのときのベンチマークは何になるんだろうか?

例えば、2030年代初頭には、人類がチンパンジーくらいの知能だとしたときに、AIが人類くらいの知能になっていると想定される。そのときに、人類がチンパンジーくらいの知能しかないとして、(自分たちより圧倒的に知的レベルが高い)人間の知能の評価をどうやればよいのだろうか?もっと言うと、金魚やミジンコは人類Aと人類Bの頭の良さの違いを理解できるのだろうか。個人的にはかなり難しい気がしていて、人類Cに評価してもらうとか、第三者の登場が必要な気がしている。

そもそも現状、言語モデルAとBがあるときにどっちが優れているかはどうやって評価しているのかが気になった。このあたりのベンチマークの仕組みを理解していないと、LLMがリリースされたときにどうすごいかがきちんと理解できない気がした。少なくとも現状、私はわかったようでわかっていない。

注意

私が個人的に気になって調べたメモです。その道の研究者ではないので、プロの目から見たらきっと間違いだらけです。もしも間違いがあれば、XのDMで教えてくれると嬉しいです。

現状のベンチマーク整理

現状のベンチは、OpenAIがリリースしているevalsまたはその軽量版のsimple-evalsを利用している事が多いようだ。以下、それぞれのパラメータの説明

MMLU: 大規模なマルチタスクの言語理解を測定

MATH: MATHデータセットを使用した数学的問題解決の測定

GPQA: 大学院レベルの Google実証済みQ&Aベンチ

DROP: 段落にわたる個別の推論を必要とする読解ベンチマーク

MGSM: 多言語小学校算数ベンチマーク

HumanEval: コードでトレーニングされた大規模な言語モデルの評価(naoto注:プログラミングの能力を評価するベンチマーク)

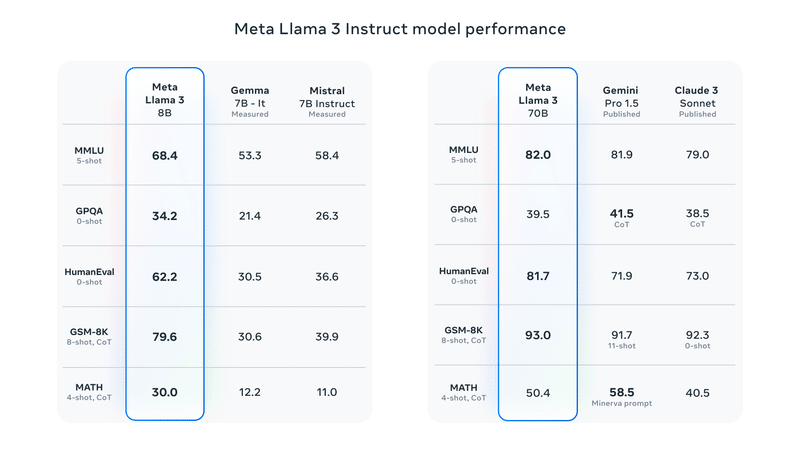

実際、Llama3のパフォーマンスも上記の項目を掲載している。GSM-8Kというのは上記の項目に含まれていないように見えるが、MGSMとほぼ同等。paperswithcodeによると、人間が作成した小学校の算数の文章問題のようだ。8500問題あるので8k。

具体的な問題の紹介

具体的な問題を見たいという私みたいな人向けに、問題を掲載しておく。原文とClaude3による翻訳を掲載する。知識的な問題や、論理的な問題もあり、序列をつけるのは難しいが、私の主観であえてつけるとすると難易度の順位は、

GPQA > HumanEval > MMLU > MATH > GSM-8K

かなと感じた。

上記のLlama3の評価と比べると、私の主観は若干AIと乖離がある。特にMATHに対する評価が大きく異なる。

MMLU

Astronomy

What is true for a type-Ia supernova?

A. This type occurs in binary systems.

B. This type occurs in young galaxies.

C. This type produces gamma-ray bursts.

D. This type produces high amounts of X-rays.

Answer: A

High School Biology

In a population of giraffes, an environmental change occurs that favors individuals that are tallest. As a result, more of the taller individuals are able to obtain nutrients and survive to pass along their genetic information. This is an example of

A. directional selection.

B. stabilizing selection.

C. sexual selection.

D. disruptive selection

Answer: A

Claude3による翻訳

天文学

Ia型超新星について正しいのは次のうちどれか。

A. このタイプは連星系で発生する。

B. このタイプは若い銀河で発生する。

C. このタイプはガンマ線バーストを引き起こす。

D. このタイプは大量のX線を放出する。

答え: A

高校生物学

キリンの個体群において、最も背の高い個体に有利な環境の変化が起こった。その結果、より背の高い個体が栄養を得て、遺伝情報を次世代に伝えることができるようになった。これは次のどれに当てはまるか。

A. 方向性選択

B. 安定化選択

C. 性選択

D. 分断選択

答え: A

GPQA

Chemistry (general)

A reaction of a liquid organic compound, which molecules consist of carbon and hydrogen atoms, is performed at 80 centigrade and 20 bar for 24 hours. In the proton nuclear magnetic resonance spectrum, the signals with the highest chemical shift of the reactant are replaced by a signal of the product that is observed about three to four units downfield.

Compounds from which position in the periodic system of the elements, which are also used in the corresponding large-scale industrial process, have been mostly likely initially added in small amounts?

A) A metal compound from the fifth period.

B) A metal compound from the fifth period and a non-metal compound from the third period.

C) A metal compound from the fourth period.

D) A metal compound from the fourth period and a non-metal compound from the second period

Claude3による翻訳

化学(一般)

炭素と水素原子からなる分子を持つ液体有機化合物の反応を、80℃、20気圧で24時間行った。プロトン核磁気共鳴スペクトルにおいて、反応物の最も高い化学シフトを示すシグナルが、生成物のシグナルに置き換わり、それは約3〜4単位低磁場側に観測された。対応する大規模な工業的プロセスでも使用されている元素の周期表のどの位置にある化合物が、最初に少量添加された可能性が最も高いか?

A) 第5周期の金属化合物

B) 第5周期の金属化合物と第3周期の非金属化合物

C) 第4周期の金属化合物

D) 第4周期の金属化合物と第2周期の非金属化合物

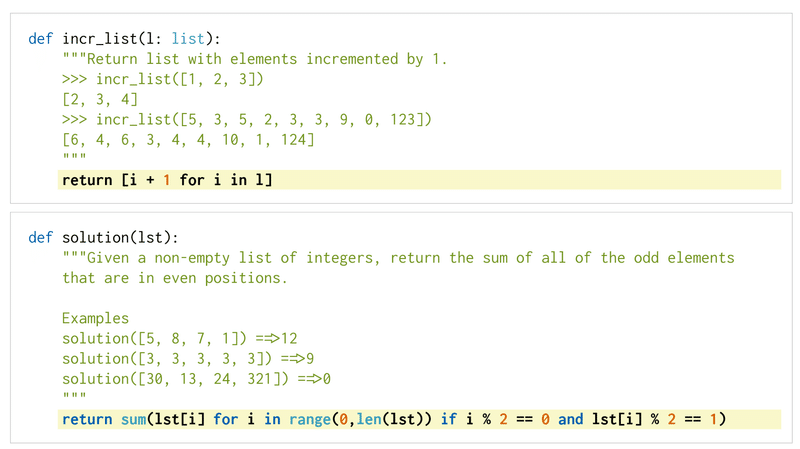

HumanEval

GSM-8K

Natalia sold clips to 48 of her friends in April, and then she sold half as many clips in May. How many clips did Natalia sell altogether in April and May?

Weng earns $12 an hour for babysitting. Yesterday, she just did 50 minutes of babysitting. How much did she earn?

Claude3による翻訳

ナタリアは4月に48人の友達にクリップを販売し、5月にはその半分の数のクリップを販売しました。ナタリアが4月と5月に販売したクリップの総数はいくつですか?

ウェンはベビーシッターとして時給12ドルを稼いでいます。昨日、彼女はわずか50分間のベビーシッターをしました。彼女はいくら稼ぎましたか?

MATH

Tom has a red marble, a green marble, a blue marble, and three identical yellow marbles. How many different groups of two marbles can Tom choose?

The three-digit number "ab5” is divisible by 3. How many different three-digit numbers can "ab5” represent?

Claude3による翻訳

トムは赤、緑、青の大理石を1つずつ、そして同じ黄色の大理石を3つ持っています。トムは2つの大理石をいくつの異なる組み合わせで選ぶことができますか?

3桁の数字 "ab5" は3で割り切れます。"ab5" はいくつの異なる3桁の数字を表すことができますか?

現状のベンチマークの課題

上記で用いられているようなベンチマークを見る限り、評価の軸となる分野は、論理、知識、プログラミングに大きく偏っていると感じた。例えば、会話をしていて自然と感じるかどうかや、表現力については触れられていない。もしかしたら、そのあたりはすでに現状でもある程度達成されているからかもしれないし、もしくは論理、知識、プログラミングがうまくできればこれらのタスクも達成できるのかもしれない。もしくは、単純に定量的に評価するのが(技術面およびスケールの面で)難しいからかもしれない。なんとなく、定量的に評価するのが難しいというのが理由な気がする。

上記のベンチマークはLLMが人類の賢さを大幅に上回ると使えないベンチマークであるという予想は正しそうだ。なぜならば、上記のベンチマークは十分に賢い人間であればほとんど解けてしまうので、LLMがその水準に達するとこのベンチマークはパフォーマンスが100に近くなり、LLM同士の違いを評価できなくなると想定されるから。

2030年のLLMのベンチマーク

そのため、上記のベンチマークは数年後には使われなくなる可能性がありそうだ。具体的にどうアップデートされるだろうか。想像してみよう

例えば、AIが人間よりもずっと賢くなって、いわゆる上記のようなタスク型のような課題は概ね答えられるようになったとする。そのとき、タスクに対して正しい回答をするというようなタスクだと、所詮人間の知識レベルの話なのでどこかの段階でどのAIも素晴らしいスコアを出すようになり評価ができなくなる。そうなると、タスクに対して正しい回答ができているかどうか、というスタイルだと評価が難しいのかもしれない。

これを解決するためには「人間の知識レベルを超えた評価軸」が必要になるかもしれない。つまり、LLMの能力が人間を大きく上回るようになると、現在のようなタスク型のベンチマークでは差異が測れなくなる。そのため、人間の知識レベルを超えた新たな評価軸が必要になる。例えば、未知の問題に対する創造的な解決策の提示や、複雑な因果関係の理解、新しい概念の創出などが考えられる。ただし、これだと多くの場合、定量的評価が難しくなるのでそこは課題だ。

あとはタスク型における回答のようなものが、簡単に相対的に評価できると良いかもしれない。一例として、囲碁や将棋のように競技性があり、相対的に評価できるものであれば、LLM同士を評価できるかもしれない。ただし、LLMにおいて出力された文章に対し、客観的かつ定量的に評価することは思ったよりも難しいので、課題の選び方をどうするかはかなり悩ましい。

それから冒頭に述べた「人類C」のような第三者に評価してもらうという仕組みは現時点では思ったより難しいかもしれないが、将来的には有望かもしれない。なぜ現時点で難しいかというと、誰が評価するのか、によってLLM同士の相性などがあるかもしれないし、客観的な立場からLLMはLLMを評価できるとは私は「まだ」信じられないからだ。しかしながら現状、Xなどを見ているとLLMの評価として「Chatbot Arena」を皆よく参考にしているなと感じる。Chatbot Arenaは、匿名で選ばれた2つの生成AIが、同じ質問に対して回答し、どちらが優れているのかを人間が判断してレーティングを競う、というものである。仮にLLMが人類よりも賢くなるのであれば、この評価する側としてLLMが入ってもおかしくないかもしれない。ただし、この場合は現状のChatbot Arenaと同様に統計的かつ大規模な評価件数がないと、そもそも評価を正しく行うことができないかもしれない。具体的には、ある程度トップクラスに賢いとされているLLMの群を用意し、それらにLLMを評価させるというのは一つの方法かもしれない。ただし、これを繰り返すとバイアスが局所化していくことは想定されるので、評価者には一定数人類は含まれるべきかもしれない。

まとめ

この記事では、将来的にLLMの能力が人間を大きく上回るようになると、現在のようなタスク型のベンチマークでは差異が測れなくなる可能性が高いのではないかという仮説を提案し、現状のベンチマークのレビューをした。そして、新しいベンチマークとしてどういったものが可能性があるのかについて論じた。提案したベンチマークの方向性としては下記の3つ。

創造性と問題解決能力の評価 未知の問題に対する創造的な解決策の提示や、複雑な因果関係の理解、新しい概念の創出などを評価する。これらは人間の知識レベルを超えた評価軸となり得る。ただし、定量的評価が難しいという課題があるため、評価方法の確立が必要である。

競技型のベンチマーク 囲碁や将棋のように、LLM同士が直接対戦し、相対的に評価できるようなベンチマークを設定する。これにより、客観的かつ定量的な評価が可能になる。ただし、適切な競技の選定や、公平な対戦環境の整備が重要である。

LLMによる評価 人間よりも賢いLLMが登場した際には、LLM自身がほかのLLMを評価するという方法も考えられる。ただし、バイアスの局所化を避けるため、一定数の人間評価者も含めるべきである。また、統計的かつ大規模な評価件数が必要不可欠である。

次は、sakana.aiがなぜすごいのか,あたりを理解したい。sakana.aiがやっていることは人伝いに聞く限り遺伝的アルゴリズムに近いことをやっているのかなと思っているのだけど、もう少し正しく理解したい。個人的に研究者時代に、遺伝的アルゴリズムは触っていたことがあるが(最適化数学やってたら一度は皆触るかもしれないが)、あんまり賢くないイメージだったのでなぜそれが今注目されるほどすごいのか、さらに現状の技術をどう改良できるのか理解したい。

ブログのサムネイルは

「AIが人類よりもずっと賢くなり、AIが人類の知識レベルだとしたときに、人類が皆チンパンジーの知識レベルになっている様子」

をイラスト化したものです。

この記事が気に入ったらサポートをしてみませんか?