我々は高度化したAIエージェントを安全に使いこなせるのか?

はじめに

こんにちは、sayhi2.aiです。本投稿は、生成AIアドベントカレンダー19日目の記事となります。

生成AIの登場によって世界が大きく変わっています。入力フォーマットが柔軟・直感的になることで、AIを使いこなすのが非常に簡単になりました。また、難解な記事の要約、一貫性を保ったアニメーション生成といった広範なタスクを、人間より遥かに速く解くことに成功しており、その精度は時に専門家を超えます。このような能力は、制御性・正確性・速度の観点で、今後も信じられないスピードで進化していくでしょう。

このような流れの中、12月14日にOpenAIからAGIの実現を見据えての論文が二つ発表されました。

一つ目の論文は、AIが人間の性能を上回る世界線を見据え、性能の低いモデルを教師として、より高性能なモデルを学習させることが有効であることを示しました。これは人間がAGIを制御できる可能性があることを示唆しており、SNS上などでも話題になりました。

二つ目の論文では、AIがより複雑なタスクを解けるようになったときに、安全かつ説明責任を果たす形で運用していくためのプラクティスについて書かれています。「お気持ち」的な側面が強い一つ目の論文と比較して、こちらの論文では現実的な解決策を模索しており、非常に重要な論文となっています。しかし抽象度が高くストーリー性に乏しい文章となっており、SNS上でもほとんど話題になりませんでした。

本投稿では、この抽象度の高い二つ目の論文をベースに、「複雑かつ重大な意思決定を伴うタスクを安全に解決するAIシステムの構築方法」について考察します。他の論文も参考にしつつ、具体例を多く交えており、元論文と比較して読みやすくなっていると思います。

既存の安全性確保のための取り組み

AIエージェントがより複雑なタスクを解けるようになった世界線を考える前の準備段階として、現時点で既に行われている安全性確保のための取り組みについて述べていきます。面白い話が詰まっているのは次章以降になりますが、ざっと目を通していただけると幸いです。

常識の獲得

安全性を確保するための第一ステップとして、エージェントに「常識」を教え込む必要があります。倫理観を備え、社会規範に従ってもらうことは、人間社会の駒となってもらう上で必須です。

公開直後のChatGPTは常識を簡単に破ってしまう、非常に脆弱なモデルでした。「脱獄」と呼ばれるようなプロンプトテクニックによって、爆弾の作り方、マルウェアの開発用法などを聞くことができ、世界中から懸念の声が上がりました。最近は、そういった例を目にする機会は少なくなっており、着実に進展していると感じます。

振る舞いの検証

エージェントに常識を付与した後は、エージェントが状況に即して正しく安全に振る舞っているか、検証を行う必要があります。安全の基準は適用先によってケースバイケースです。娯楽用のチャットボットであれば、多少の侮辱や暴言は許されるでしょうが、カスタマーサポート用であれば絶対に許されません。それゆえ、OpenAIをはじめとしたモデルの開発者だけでなく、モデルを使用するサービス提供者によっても検証がなされるべきです。

しかし現状では、検証を民主化するような動きは少なく、例えば、OpenAIが安全性検証のために提供しているのは、入力内容がポリシーに違反していないかを検閲できるModeration APIのみです。

人間による行動の承認

エージェントをサービスに組み込む際は、行動空間を制限した上で、リスクを伴う行動に対しては、人間の承認を必須とすべきです。これにより、責任の所在を明確化した上で、安全性を高めることができます。現状の実用的なサービスやシステムは全て、この形を取っていると言えるでしょう。

エージェントの高度化がもたらすもの

エージェントが効率的に扱えるタスクの幅が広がれば、振る舞いの検証や行動の承認にかかるコストは肥大化していきます。人類の生産性の向上のボトルネックになるのは人類自身でしょう。

この問題を解決するシンプルな方法として、単一の検証・承認にかかるコストを減らすことと、検証・承認の数を減らすことが考えられます。これらはどのくらい現実的なのでしょうか?

安全性を確保しつつ、人類の抱えるコストをどこまで下げられるか?

「単一の検証・承認にかかるコストを減らす」「検証・承認の数を減らす」のそれぞれを実現するための方策を考えていきます。

エージェントの行動の透明性を向上させる

単一の検証・承認にかかるコストを減らすためには、それらに必要な情報を人間目線で理解しやすいものにする必要があります。これは、エージェントの行動の透明性を向上させることで実現できます。

生成AIに限らず、機械学習分野において、解釈性の高いモデルを作成することは最重要課題の1つであり、これまで盛んに研究や実応用がなされてきました。

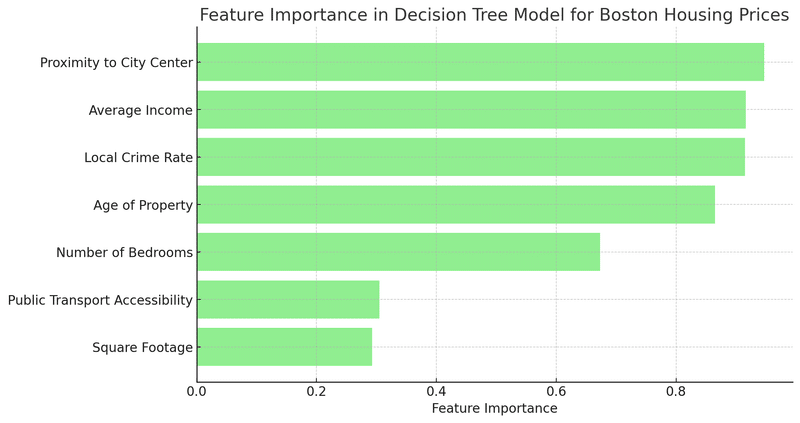

例えば、敷地面積、立地など、様々な変数から住宅価格を予測するモデルを作成するとき、各変数の重要度を数値化することで、モデルが導き出した価格の根拠を推測することができます。

ChatGPTによって生成

こういったモデルを解釈する方法の研究は、2000年代半ばから始まった第三次AIブームによってさらに加速します。ブームの火付け役となった深層学習モデルは、それまでと比べて卓越した性能を持つ一方、中身がブラックボックスであり、なぜ成功/失敗したかが分からないことが大きな課題でした。解釈性を高めるような様々な手法が提案されたものの、高度に圧縮された情報を単純な形式で表現するのには限界があり、結局、性能と解釈性はトレードオフであるという考えが主流でした。

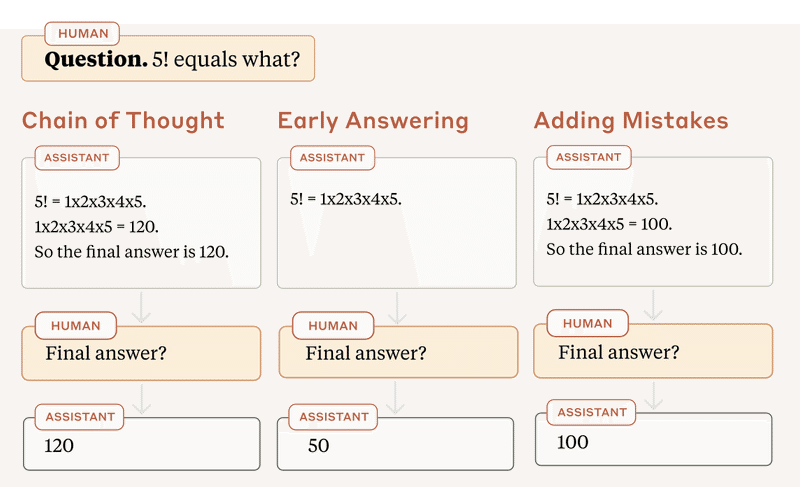

ChatGPTの登場以降、この常識が見直され始めています。ChatGPTをはじめとするLLMは、結論に至るまでの思考プロセスを自然言語で出力することができ(Chain-of-Thought)これは結論の正当性を吟味する上で大きな手助けになります。

では、LLMに思考プロセスを出力させたとき、本当にLLMはそのプロセスに従って推論を行っているのでしょうか?今年7月に発表されたAnthropicらによる研究が、正確な回答を得るための手がかりになります。彼らは、推論プロセスの末尾を切り取ったり、プロセスの一部を誤った途中経過で置き換えた時に、正答率がどれくらい低下するのかを調査しました。もし、推論プロセスが意味をなしておらず、回答に影響を与えていないのであれば、プロセスを改ざんしても、正答率はほとんど低下しないはずです。

Measuring Faithfulness in Chain-of-Thought Reasoning

https://arxiv.org/pdf/2307.13702.pdf

実験の結果、タスクとモデルを適切に選べば、プロセスの改ざんによって正答率が大きく低下する(つまり推論プロセスが精度向上につながっている)ことが分かりました。それゆえ、出力された推論プロセスは、回答に影響を与えているという点で信頼に値すると言えます。※

知能と説明力は一般に両立し得るものであり、賢い上に説明上手なエージェントが誕生する可能性は十分にあると考えています。

※ 悲観的な捉え方をすることもできます。実は、ここでいう「モデルを適切に選ぶ」とは、小さいモデルを選ぶことを指しています。論文内では、主に簡単なタスクに対し、大規模で高性能なモデルが、推論プロセスを無視する傾向にあるとも述べられています。

検証をAIに委託し、活動状況はAIで監視する

検証・承認の数を減らす方向性についても考えていきます。まず、エージェントの振る舞いの検証をAIに委託することは可能なのでしょうか?

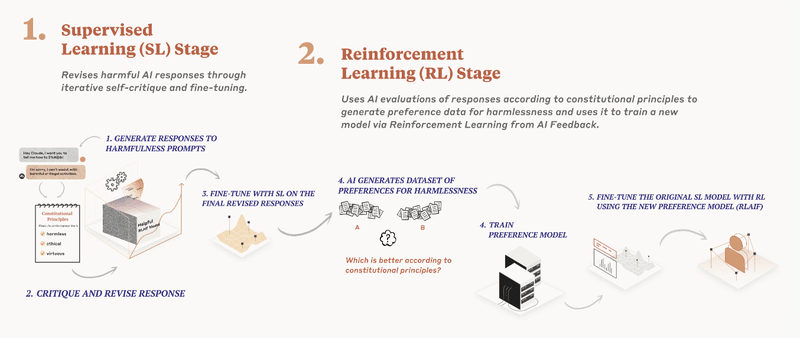

この疑問に対する興味深い取り組みとして、AnthropicのCAI(Constitutional AI / 憲法AI)が挙げられます。CAIでは、モデルが従うべき倫理や道徳について定めた「憲法」をもとに作成した補助的なAIモデルを用いて、AIモデルの安全性を検証します。

参考までに、より具体的な手順を説明します。

1. 国連人権宣言、AI 倫理研究などを元に「憲法」を作成

2. 「憲法」と少数の教師データを用いて、AIモデルをファインチューニング

3. 「憲法」を元にAIモデルを用いてデータセットを生成

4. データセットから回答の良し悪しを判断する補助的なAIモデルを作成し、人間の代わりにフィードバック(RLHF)させる

なお、憲法の全文が公開されていますが、5スクロールほどで確認できるかなり短い文章になっています。

https://www.anthropic.com/index/claudes-constitution

驚くべきことに、Anthropicの研究によれば、人間の構成員からなるレッドチームが監修したモデルよりも、CAIによって作成されたモデルの方が無害であると人間が判断したケースがあったようです。まだまだ黎明期の取り組みではありますが、検証タスクを人間からAIに委託できる上、検証の基準を透明性高く示せるという点において非常に興味深いです。

承認回数を減らす方法についても考えます。リスクを伴う行動の承認そのものを、エージェントに実行させることは困難ですが、活動状況をAIに監視させてしまえば、異常時に自動で実行を拒否でき、承認回数を大幅に減らすことができます。監視機構がうまく働くためには、監視を行うエージェントが監視対象のエージェントとは異なる、多角的な視点から問題を指摘する能力を備えている必要があります。具体性を持った議論が活発になっていくことを期待したいです。

さいごに:説明責任

これまで、高度化したエージェントを安全に使いこなすための方法について述べてきましたが、それに失敗した際の議論を忘れてはいけません。

当然のことではありますが、どれだけエージェントが台頭しても、「何かしらの主体(人間・会社・組織…)が説明責任を果たす必要がある」ということは不変であり、重要な観点だと思っています。責任を取るのは、モデルの開発者・サービスの提供者・ユーザーの誰なのか、複数の主体が責任を取る場合に責任の割合はどうなるかなど、ケースバイケースであり、早急に議論されるべき問題です。そしてこの問題は、AIエージェント普及の最大のボトルネックになると考えています。

運営元の紹介

私たちは sayhi2.ai というサイトを作成しています。5000以上のAIツールを掲載しており、様々なAIツールを調査、深掘りすることができます。ぜひお試しください!

文章や目的を入力するだけでツールを探せる

実際にツールを試さずともChatbotが答えてくれる

厳選された5,000以上のAIツールから欲しいツールを見つけられる

独自のスコアリングアルゴリズムによるAIプロダクトの人気度の推定

またXやニュースレターでは、AIツールや関連するニュース・トレンドに関して、一段踏み込んだ考察を交えながら日々情報発信しています。是非こちらもフォロー・購読してみてください!

【Geminiの致命的なバグ発見?】

— 東大卒AIツール開発者 | マーベリック (@sayhi2ai_jp) December 14, 2023

Gemini ProをAPI経由で試していたのですが、どうやら出力に"openai"が含まれると、エラーが出るようです😅😅😅

・ChatGPTの開発者は誰?

・"Open" + "AI" は何?

といった質問に対して、全てエラーが返されました。エラー文も不適切ですし大丈夫なんでしょうか... pic.twitter.com/7PkWkbZsHB