GM(ゼネラルモーターズ )が事故を防止・回避するために実践しているPredictive Analyticsの中身とは?

一般社団法人ウェブ解析士協会の江尻会長に連れていってもらい、ラスベガスのMARKETING ANALYTICS SUMMITに参加しています。これは西海岸でも非常に大きなマーケティングのカンファレンスになります。今回の記事では、PREDICTIVE ANALYTICS SUMMITの中でのGMのMeltemさんの講演を書き起こしていきます。書き起こしだけではなく、日本語翻訳をするのにこの記事ではチャレンジしていきます。

--------以下、書き起こし--------

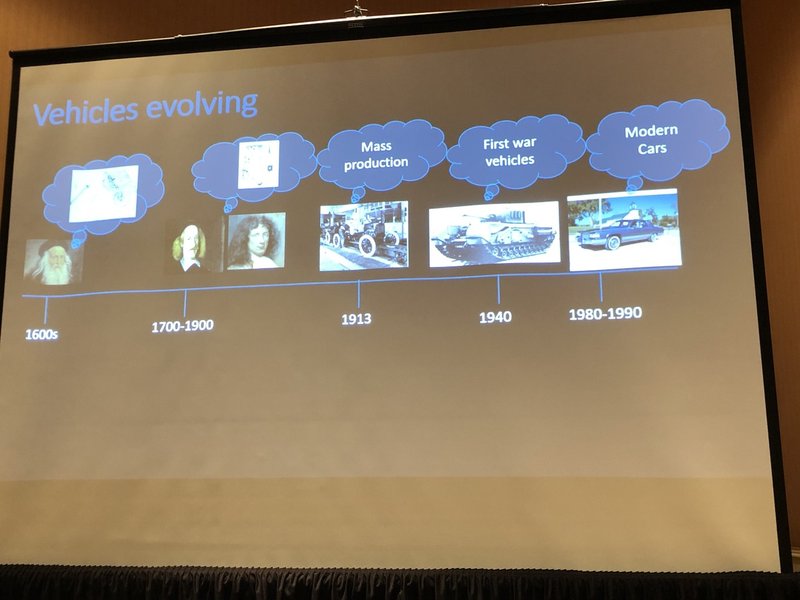

車の進化

車は1600年代から進化を続けてきました。1913年にマスプロダクションとして多くの人に使われるようになり、1940年には戦争用として、1980-1990年にモダンカーとして成立するようになりました。

1965年の未来の自動車に関する動画を見てみましょう。カーナビのようなものが登場したり、自動運転技術が登場していたりします。また、ダッシュボードがあり、車の中の様子がグラフで表示されています。アイスクリームを車の中で食べるシーンも。

そして、このほとんどが実現しつつあります。そうですね。アイスクリームを冷蔵する技術を除けば。

(会場爆笑)

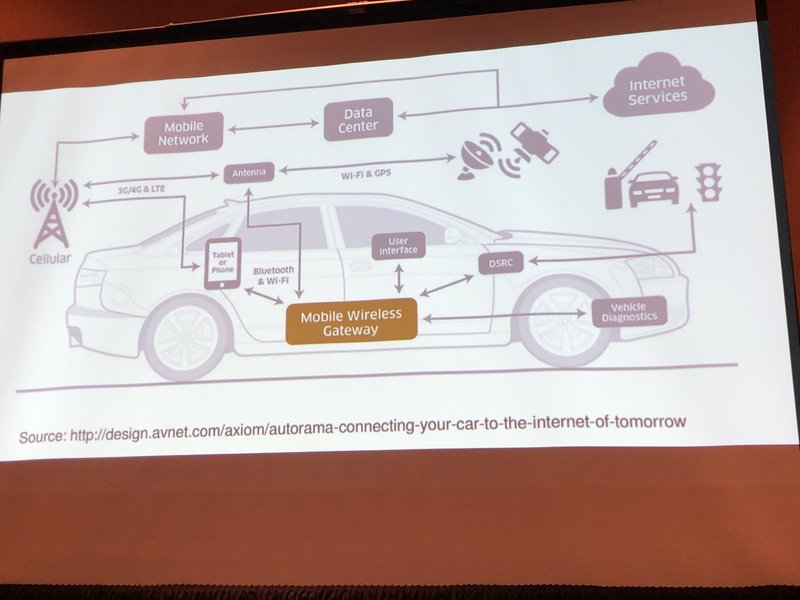

こんな風に車はすでにインターネットとつながり、動くようになっています。2018年でセンサーがキャッチしているデータは25GB/時間になっております。これはNetFilxの4倍なんです。

こういた情報はエンジニアにより、安全に大切に使われています。

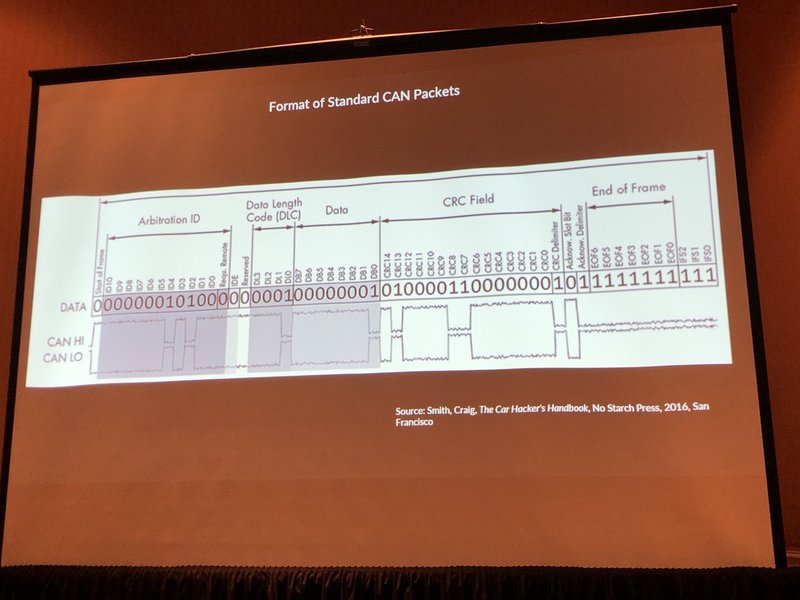

昔のデータのやりとりはこんな感じでした。

これがStandard CAN Packetsです。

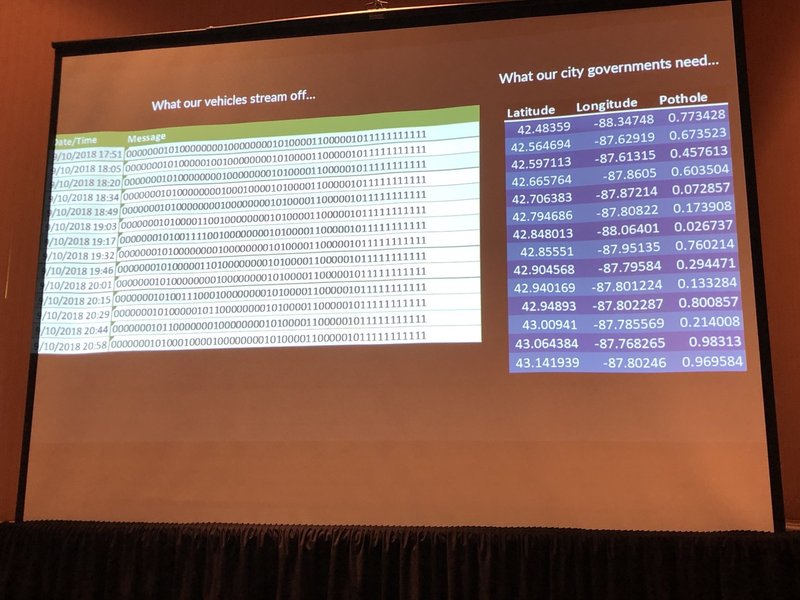

今はさらに変わりました。左が今私たちが実際に受け取っている情報で、右が政府が欲しい位置情報です。では、こういった情報をどのようにして、AIや機械学習に活かしているんでしょうか?

GEでは、センサー情報、ストレージに関するクラウドテクノロジー、AI・機械学習の3つを元に(Re)Cognition Technologyを作っています。全てを人に返し、そのデータの全てを技術に返しています。

では、そもそもなぜ、私たちはコネクテッドデータを必要としていたのでしょうか。GEでは、以下の4つを実現したいと感が会えているからです。

・クラッシュなし

・混雑なし

・排出なし

・歩行者の体験

これらを実現するにはどうしたらいいでしょうか?

人は目的があり、認識をして、そのあと、知覚しています。

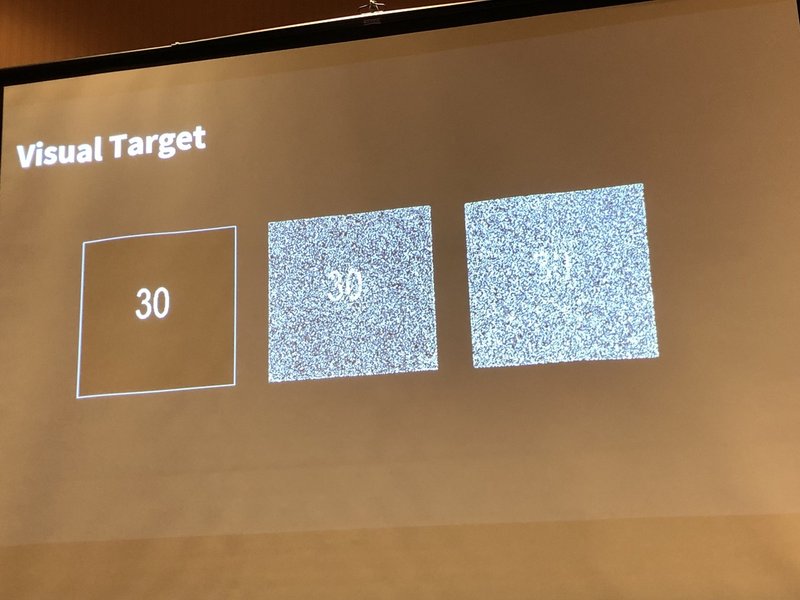

画像についてはどのように認識するでしょうか。どのくらい、明快に見えているか、解像度がそれぞれ違いますよね。

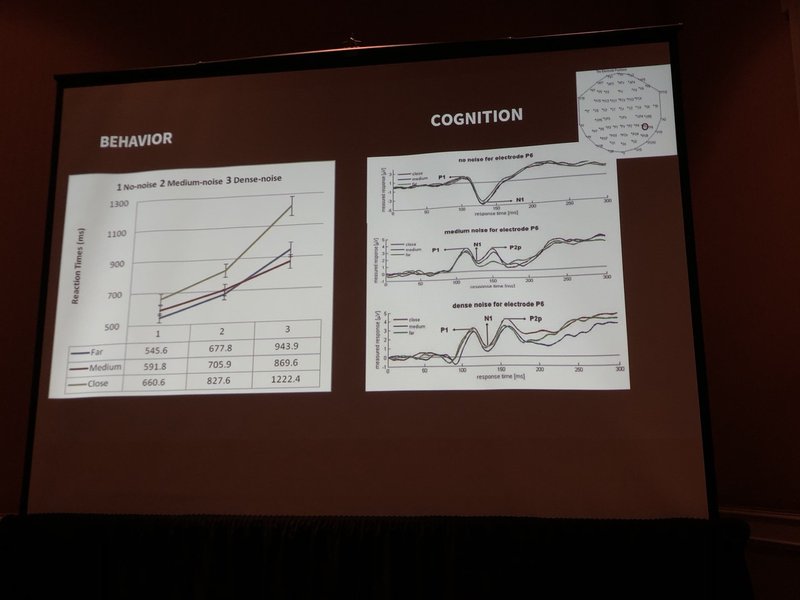

例えば、人間の場合、周りの音がするかしないか、によってやってくる車へのリアクションが変わってしまいます。うるさいと気づきづらいということです。ただ、COGNITIONの場合、ほぼそのあたりは変わりませんでした。

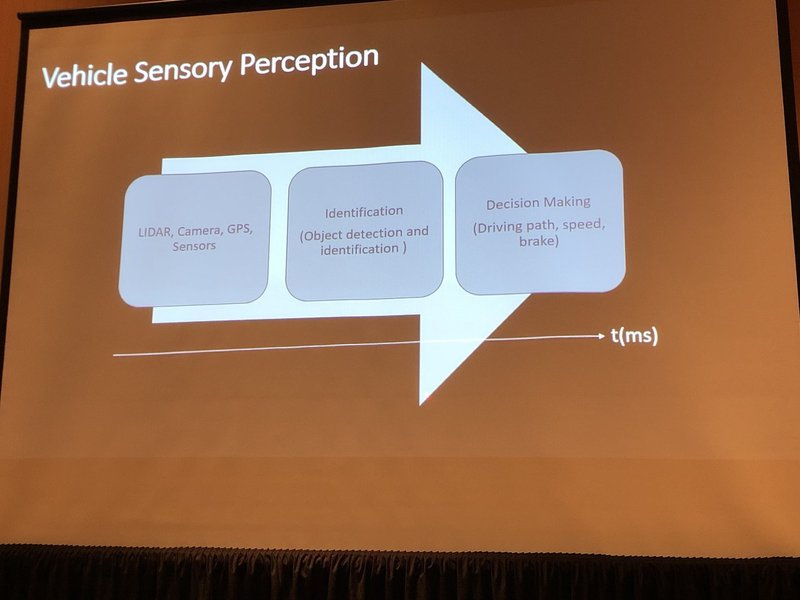

最初は、LIDAR、カメラやGDPです。そのあと、検出技術、最後はドライブのルートやスピード、ブレーキの作動になります。これをAIの場合、どうやるかというと・・・

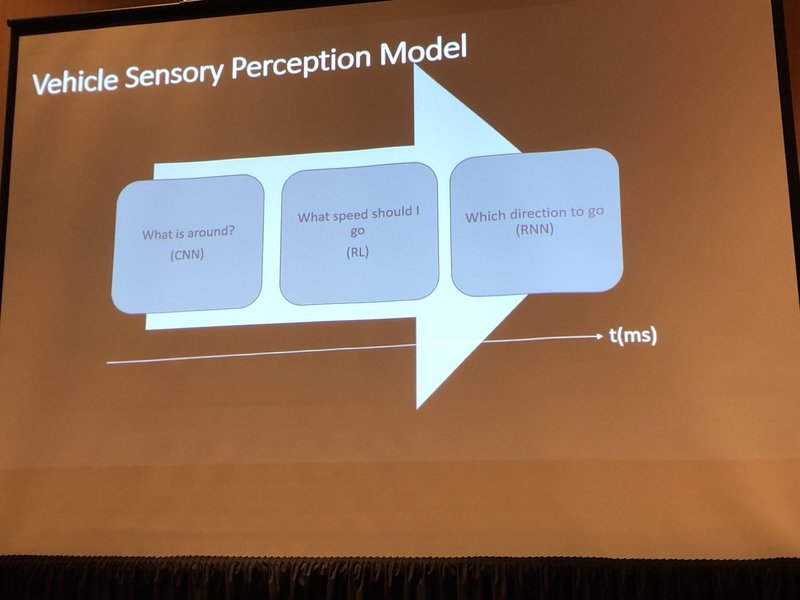

こうなります。CNN(畳み込みニューラルネットワーク)でまず何がまわりにあるか認識し、Reinforcement learning(強化学習)でどのくらいのスピードで移動するか、調べ、どこにいくべきかをRNN(回帰型ニューラルネットワーク)で実装します。

現実にはRNN(回帰型ニューラルネットワーク)までには至っていません。

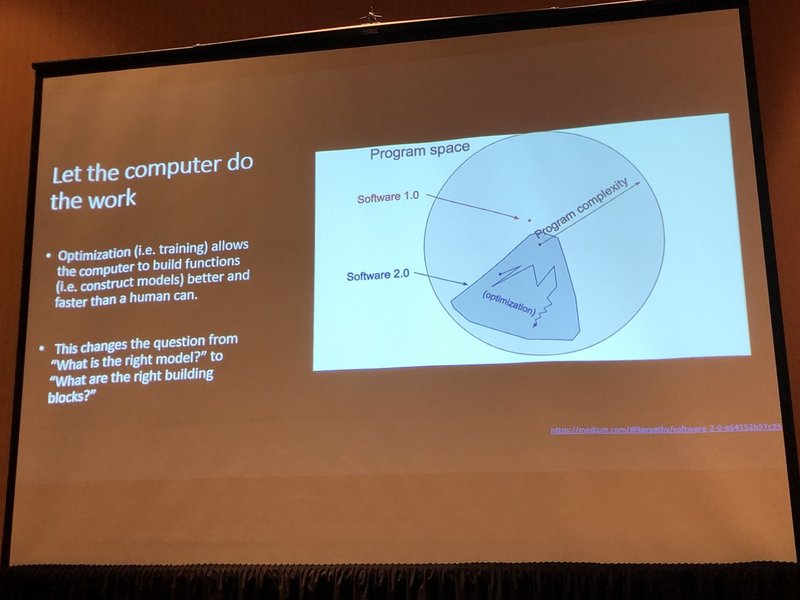

そこでコンピューターにもっと仕事をしてもらいましょう。これによって人間よりもよくしかも素早く最適化をしてくれます。(トレーニングなど)

”正しいモデルは何か”という質問から”正しいビルディングブロックは何か”という質問に変えるはずです。

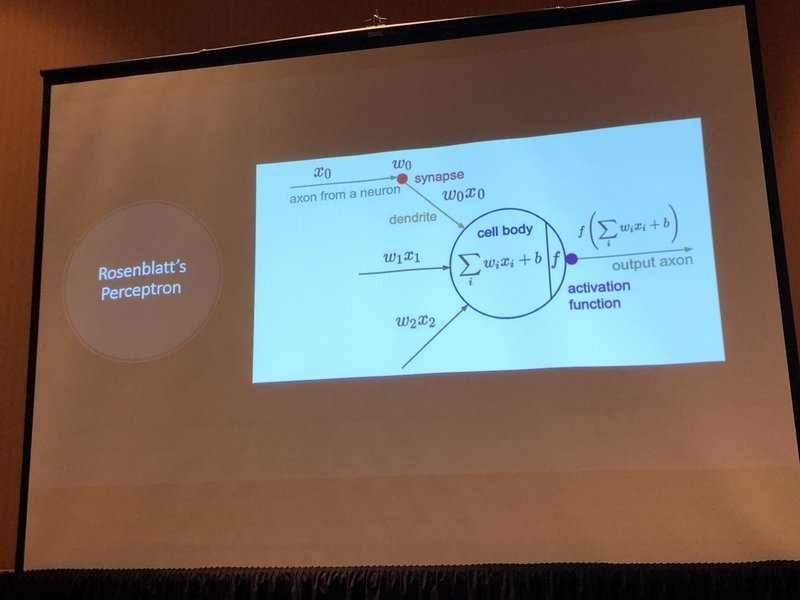

ローゼンブラットのパーセプトロンを紹介します。視覚と脳の機能をモデル化したものであり、パターン認識を行います。シンプルなネットワークでありながら学習能力を持つのが特徴で、現在の機械学習アルゴリズムの基礎となっています。

こういったことを通じて、未来の車づくりを現実のものにしていきます。

サポートされた費用は、また別のカンファレンス参加費などに当てようと思います。