ユーザー主導の創造性:InstanceDiffusionで画像中の各要素を自由自在に操る

InstanceDiffusionは、BAIR、UCバークレー、およびGenAI、Metaが共同で開発した新しい技術であり、テキストから画像への生成プロセスに革命をもたらします。この技術は、インスタンスレベルでの前例のない制御を可能にし、ユーザーが画像の各詳細を精密に指定できるようにすることで、画像生成の可能性を大きく広げます。

インスタンスレベル制御の革新性

InstanceDiffusionは、画像生成プロセスにおいてユーザーが画像内の個々のオブジェクト(インスタンス)の位置、サイズ、外観などを具体的にコントロールできる能力を提供します。これにより、ユーザーは一般的な説明から離れ、画像内の細かい要素に至るまで、自分のイメージに完全に合った画像を作り出すことができます。

論文:

GitHub:

公式ぺージ:https://people.eecs.berkeley.edu/~xdwang/projects/InstDiff/

主な特徴と技術

インスタンスレベルの制御:画像内の各インスタンスに対する細かい調整が可能です。これは、オブジェクトの位置、大きさ、外観のカスタマイズを意味します。

自由形式の言語記述:ユーザーは自由な形式でテキストを使って、インスタンスの具体的な特徴を定義できます。これには、色、サイズ、テクスチャなどが含まれます。

柔軟な位置指定:点、スクリブル、境界ボックス、インスタンスセグメンテーションマスクなど、さまざまな方法でインスタンスの位置を指定することが可能です。

技術改善のポイント

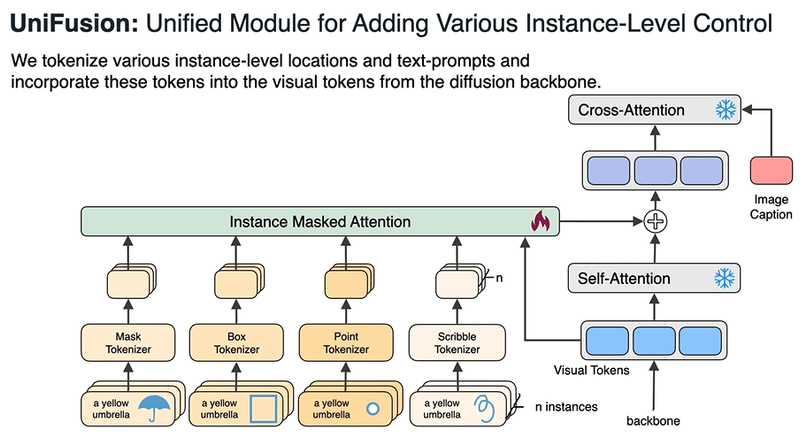

UniFusionブロック:テキストから画像モデルへのインスタンスレベル条件を統合し、インスタンスごとに特定の要求を理解し、それに応じた画像を生成します。

ScaleUブロック:画像の忠実度を改善し、ユーザーが指定したレイアウト条件に基づいて精密に画像を生成する能力を強化します。

多インスタンスサンプラー:複数のインスタンスが含まれる場合に、それぞれの条件を個別に処理し、インスタンス間での情報の混乱を防ぎます。

実用例

ユーザーが「窓辺に座る猫と、空に浮かぶ雲」のような具体的なシーンを想像する場合、InstanceDiffusionはその詳細な指示に基づき、猫の色やサイズ、雲の種類や位置など、指定された要素を正確に反映した画像を生成することができます。これにより、従来の画像生成技術では不可能だった高度にカスタマイズされたビジュアルコンテンツの制作が可能になります。

結論

InstanceDiffusionは、画像生成の自由度とクオリティを飛躍的に向上させる技術です。ユーザーが細部にわたって指定した通りの画像を生成できることで、創造性の限界を押し広げ、画像生成領域に新たな地平を開きます。これにより、デザイナー、アーティスト、クリエイティブなコンテンツ制作者にとって、無限の可能性が広がっています。

この記事が気に入ったらサポートをしてみませんか?