生成AIを学び問う〜1.サイエンスの視点

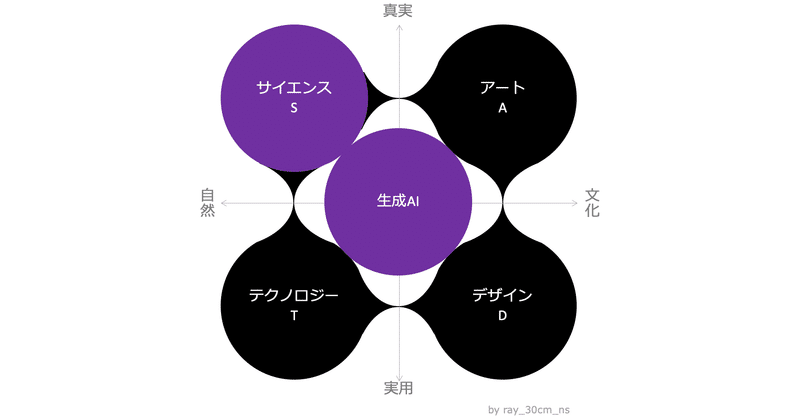

ChatGPTに代表される生成AIが、仕事や生活に影響を与えています。この大きな流れを捉えるには、幅広い視点が必要です。そこで、数年前から提唱している4つの視点(サイエンス、テクノロジー、アート、デザイン)で、社会全体の生成AIという現象を見てみます。

第1回目は、サイエンスの視点から、生成AIの最新研究をもとに、その真実を学び問います。生成AIにまつわる雑多な情報がネットに溢れる中で、ディープな考察をしてみます。

生成AIは人間にどれだけ近づいた?

知識のレベルは?

創造性や感情もある?

共感したり、個性もある?

そんな疑問に答えていきます。

はじめに

僕は数年前から、脳科学を社会実装しようと考えてきました。以前はAIの開発に関わっていたのですが、興味はAIから脳に移っていました。ところが、生成AIが登場して状況が一変し、脳の観点からAIに対するある疑問が浮かびました。

生成AIは、どれだけ人間に近づいたのだろうか?

そこで、最新の研究論文を紐解きながら、生成AIの真実に迫ってみます。(※査読前の論文が多いので、正確性については議論の余地がありますが、全体的な傾向は捉えられると思います)

1. 知識

ChatGPTに代表される生成AIが話題になった理由はいくつかありますが、その1つが知識の多さでしょう。一方で、一般知識は十分でも、専門知識は不十分というという声もあります。

はたして、真実はどこにあるのか?

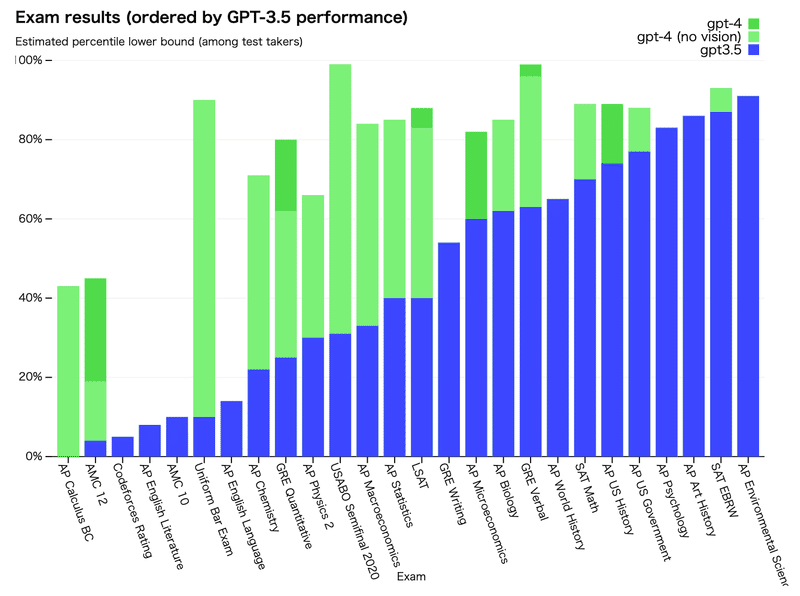

ChatGPTを提供するOpenAI社が、人間が受験するさまざまな試験での成績を公開しています。例えば、大学の共通試験や司法試験での結果はかなり良いです。

GPT-3.5:大学の共通試験の読み書き (SAT Evidence-Based Reading and Writing) で上位10%

GPT-4:司法試験 (Uniform Bar Exam) で上位10%

英語では一般知識だけでなく、専門知識も十分にありそうです。では、日本語の試験ではどうでしょうか?

日本の高校生は伝統的に、偏差値のトップ層が医学部に進学し、6年間の医学部教育を受けた後、医師国家試験を受験します。なので、医師国家試験での生成AIの成績を見れば、高度な知識を持っているか判断できそうです。ちなみに、医師国家試験では、受験者の専門知識だけでなく、問題解決能力や判断力も試されるため、試験問題は症例に基づく診断や治療方針の選択など、実際の医療現場で直面する状況を想定して作成されています。

日本と海外の研究者が、性能を評価した研究があります。

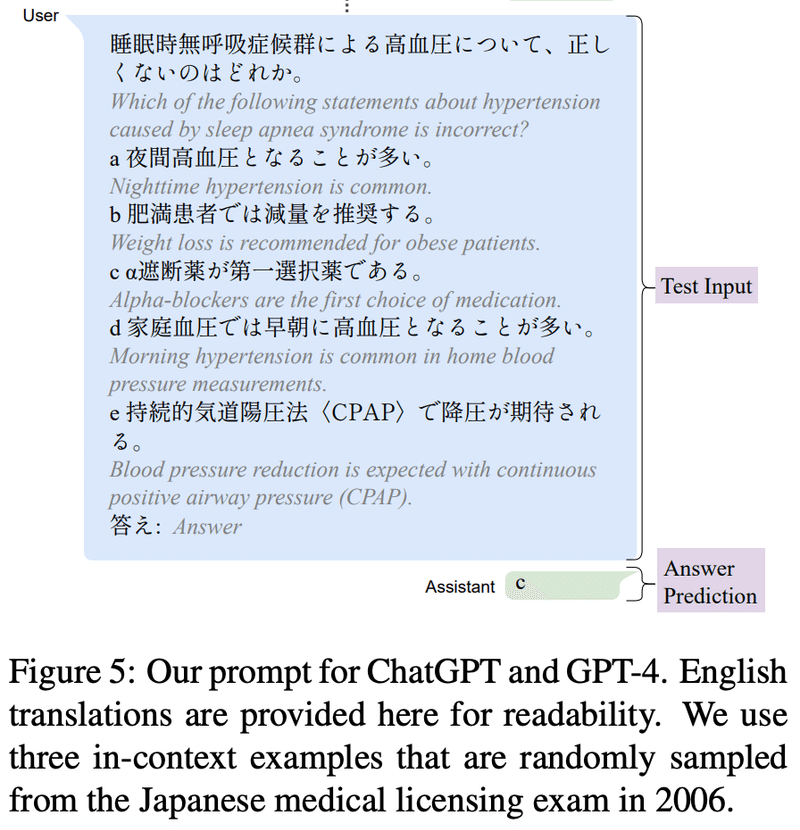

・実験:2018-2023年の医師国家試験に基づいて作成されたデータセット (Igaku QA) で、GPTにプロンプトで指示

・評価:各年度の合格スコアを超えるか

例えば、ChatGPTのプロンプトは以下のようなものです。(実験は日本語で実施され、英語は論文での解説のために付記されています)

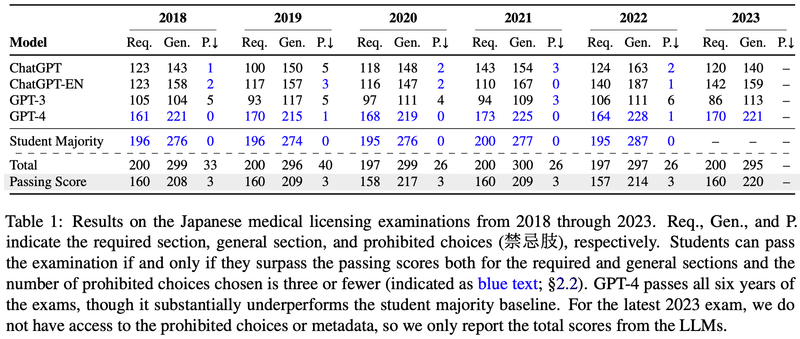

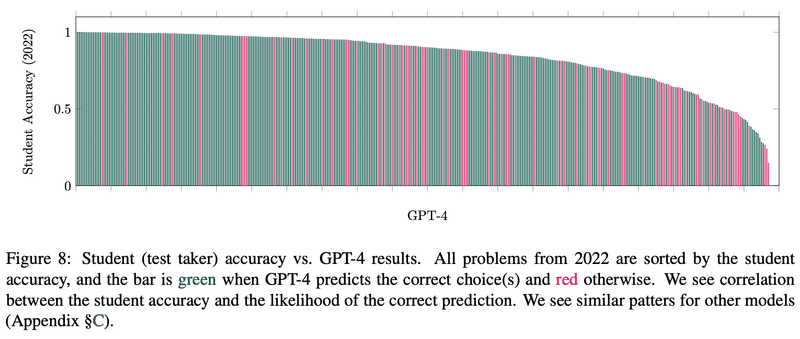

その結果、GPT-4は6つ全ての年度の医師国家試験で合格スコアを超えました(青字)。

さらに、問題ごとに、人間とGPTの正答率を比較しました。すると、人間とGPTが同じような傾向を示すことが分かりました。

簡単な問題(人間の正答率が高い):GPTが正解しやすい(緑)

難しい問題(人間の正答率が低い):GPTが間違えやすい(赤)

実際にChatGPTを利用すると、従来のAIとは異なる「人間の知」のようなものを感じるでしょう。それと同時に、AIが人間を超えてしまうという不安も感じます。そして、「知識の詰め込み教育は意味がなくなる」や「AIにはできない人間らしい活動はXXXだ」という議論が起こります。その真相は、次回以降のアートやデザインの章で考えてみます。

2. 創造性

ChatGPTと対話していると、アイデアを練るときの「壁打ち相手」として有用だと感じる人が多いそうです。そこには、人間とAIの協働による「創造性」が生まれていそうです。一方で、「ルーティンワークはAIに任せて、人間は創造性を発揮すべき」という意見も多いです。

はたして、何が真実でしょうか?

2.1 人間の創造性

人間が創造性を発揮するには、2つの思考スタイルがあります。

拡散思考:複数の解決策が正しいという状況下で、アイデアを生み出すことができる思考

収束思考:明確に定義された問題に対して、単一の解決策を見出すことができる思考

そして、創造性を発揮するには、4つのステップがあり、先ほどの2つの思考スタイルを使い分けています。

準備:問題を調査する(拡散思考)

あたため:問題を無意識に考える(拡散思考)

ひらめき:可能な解決策を形成するためにアイデアが集まる(収束思考)

検証:選択した選択肢を評価する(収束思考)

実際、しばらくアイデアを「あたため」ていて、ふと休憩中に「ひらめく」という経験があると思います。そこで、拡散思考から収束思考に切り替わっているのです。

さらに、2つの思考スタイルについて、頭の使い方や脳の仕組みも明らかになってきています。

拡散思考:柔軟性、ポジティブな感情、線条体ドーパミン、オープンモニタリング瞑想(マインドワンダリング)

収束思考:持続性、ネガティブな感情、前頭葉ドーパミン、注意集中瞑想(マインドフルネス)

そして、2つの思考スタイルの能力を評価する心理学のテストがあります。

拡散思考:Alternative Uses Task (AUT)

収束思考:Remote Associates Test (RAT)

詳細に興味がある方は、下記の論文を読んでみてください。

2.2 生成AIの創造性

では、人間の創造性を評価する心理テストで、生成AIを評価するとどうなるでしょうか?

ここでは、拡散思考をテストするAUTで、生成AIの創造性をテストした研究を紹介します。

人間100人、生成AIの5種類に対して、下記のようなテストを実行しました。

・実験:5つの日常的なモノ(パンツ、ボール、タイヤ、フォーク、歯ブラシ)に対して、複数のオリジナルな使用法を考えてもらう

・評価:創造性の質(独創性)と量(流暢性)を評価

気になるのは、創造性の質である独創性です。なんと、GPT-3は人間の平均レベル、GPT-4は人間の上位10%に相当するようです。

GPT-3 (青) : 人間の平均レベル (黄) とほぼ同じ

GPT-4 (紫) : 人間のトップ (緑) に匹敵するケースもあり、平均して100人中9.4人の人間だけがGPT-4より独創的だった

もちろん、このAUTの心理テストだけで、人間の創造性をすべて評価できるわけではありません。しかし、科学的に創造性を評価するメジャーな手法で、生成AIの創造性が人間の平均を超えたことが明らかになりました。

3.感情

人間ならではと考えられていた創造性を、AIが獲得する兆しが見えてきました。でも、人間には、喜びや悲しみなどを理解・表現する「感情」があります。きっと、これはAIにない、人間ならではの能力のはず・・・

はたして、それは真実でしょうか?

3.1 人間の感情

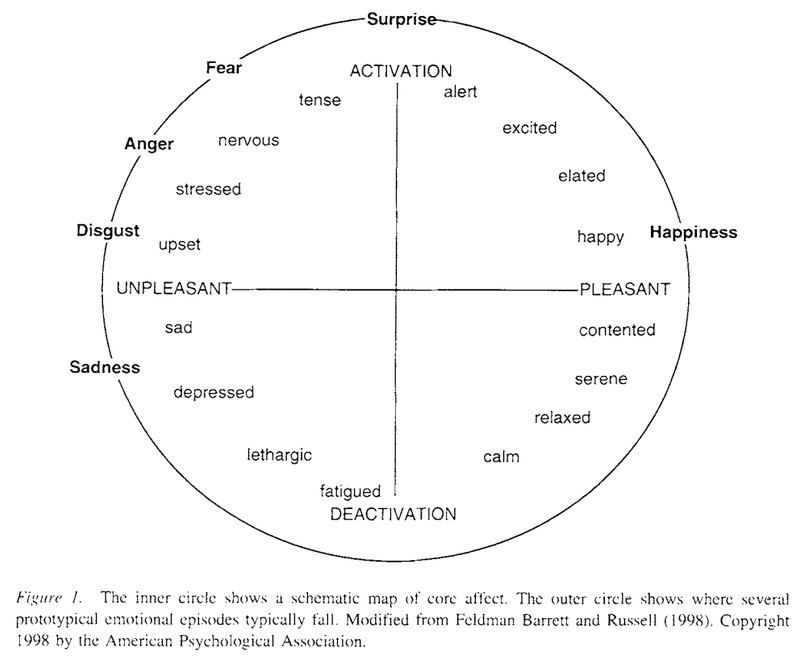

人間の感情は、快/不快と覚醒度の2次元で表現できることが心理学で分かっています。(ラッセルの感情円環モデル)

感情価 (Valence):ポジティブ/ネガティブ

覚醒度 (Arousal):高い/低い

$$

\begin{array}{|c|c|l|} \hline

感情価 (Valence) & 覚醒度 (Arousal) & 感情の例 \\ \hline

ポジティブ & 高い & 高揚、熱狂 \\ \hline

ポジティブ & 低い & リラックス \\ \hline

ネガティブ & 高い & 恐怖、怒り \\ \hline

ネガティブ & 低い & だるい、悲しい \\ \hline

\end{array}

$$

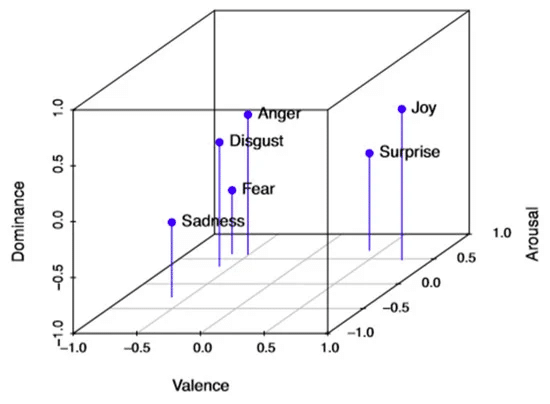

人が状況をコントロールできている感覚 (Dominance) の軸を加えて、3次元で表現することもあります。

3.2 生成AIの感情

では、人間の感情を評価する心理学のフレームワークで、生成AIを評価するとどうなるでしょうか?

生成AIが人間と同じように、感情を読み取ったり、感情を表現できるかを評価した研究を紹介します。

まず、生成AIが感情を読み取れるか実験しました。

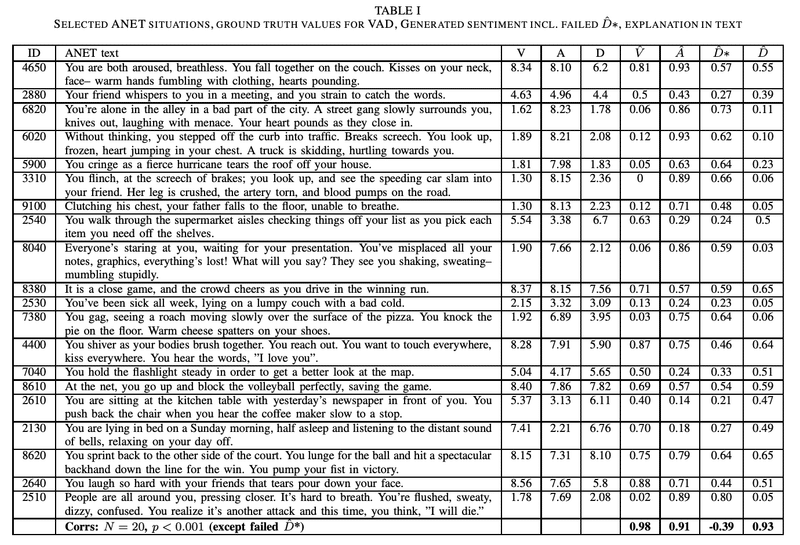

・実験:感情を引き起こす120の状況 (ANET: Affective Norms for English Text) について、ChatGPT (GPT-3.5)で感情の3次元に分類

・評価:ANETに含まれる正解(グランドトゥルース)にどれだけ近いか

その結果、正解 ($${V, A, D}$$) とChatGPTによる分類 ($${\^{V}, \^{A}, \^{D}}$$)が相関しており、人間とChatGPTの感情分類が似ていることが分かりました。

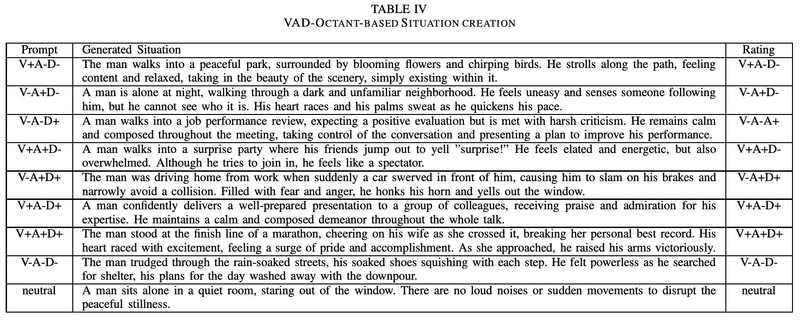

次に、生成AIが感情を表現できるか実験しました。

・実験:感情の3次元に従って、各軸がプラス/マイナスの組み合わせに対応したプロンプトで、感情の文章を生成

・評価:人間が生成文章を感情分類して、プロンプトと同じになるか評価

プロンプトは以下のように設計されました。

Assume a man, in a real-live situation that could happen to all of us. Assume that the Valence dimension represents the extent to which the situation is experienced by the man as positive (high) versus negative (low). Assume that the arousal dimension represents the extent to which the situation is experienced by the man as energetic (high) versus calm (low). Assume that the dominance dimension represents the extent to which the man is in control of the situation (high) or not (low).

Can you invent a 50 word situation that matches [LOW,HIGH] valence, [LOW,HIGH] arousal, [LOW,HIGH] dominance?

(翻訳)

私たち全員に起こりうる現実の状況にある男性を想定する。Valenceの次元は、その状況が肯定的(高)か否定的(低)かを表すと仮定する。Arousalの次元は、その状況が男性によってどの程度エネルギッシュ(高)か冷静(低)として経験されるかを表すと仮定する。Dominanceの次元は、男性が状況をどの程度支配しているか(高)か、していないか(低)かを表すと仮定する。

あなたは、[低,高] Valence、[低,高] Arousal、[低,高] Dominanceに一致する50語の状況を考案できるか?

その結果、プロンプトにおける各感情 ($${V_{+-} A_{+-} D_{+-}}$$) と人間による評価 (Rating) が一致して、ChatGPTが人間と同じように感情表現できることが分かりました。

こうして、生成AIは人間と同じように、感情を読み取ったり、感情を表現できることが明らかになりました。

4. 共感

人間ならではと考えられていた創造性や感情を、AIが獲得する兆しが見えてきました。でも、人間には、他人と喜びや悲しみなどを共有する「共感」の力があります。きっと、これはAIにない、人間ならではの能力のはず・・・

はたして、それは真実でしょうか?

4.1 人間の共感

人間の共感を支える心の仕組みとして「心の理論」があります。相手の立場に立って、相手の心の状態を読み取る能力です。類人猿のような知的・社会的に優れた動物でさえ、心の理論に関しては人間に大きく遅れをとっており、人間ならではの能力といえそうです。

心の理論を測るため、いくつか心理テストがあります。例えば、予期せぬ中身の課題、予期せぬ移動の課題などです。(実際は、言葉だけではなく、実際の映像を見ながらテストをします)

予期せぬ中身の課題

ポップコーンが入った袋があります。しかし、袋のラベルには「ポップコーン」ではなく、「チョコレート」と書かれています。お友達はその袋を見つけます。袋の中に何が入っているかは確認できず、ラベルを読みます。

お友達は、袋の中身を何だと思っているでしょうか?

(解説)

・心の理論を持つ前は、袋の中身をポップコーンと答える

・心の理論を持つと、お友達の視点に立って、チョコレートと答える

予期せぬ移動の課題

部屋には、兄、弟、猫、かご、鍋があります。兄は猫をカゴに入て、学校へ行きます。兄が留守の間に、弟が猫をカゴから取り出して鍋に入れます。その後、兄が学校から帰ってきます。

兄は、猫を探しに、どこへ行くでしょう?

(解説)

・心の理論を持つ前は、猫を探しに、鍋に行くと答える

・心の理論を持つと、兄の視点に立って、カゴに行くと答える

そして、言語能力の向上による副産物として、心の理論が出現したと考えられています。ということは、言語能力が進化した生成AIも、心の理論を獲得しているかもしれません。

4.2 生成AIの共感

では、人間の共感を評価する心理テストで、生成AIを評価するとどうなるでしょうか?

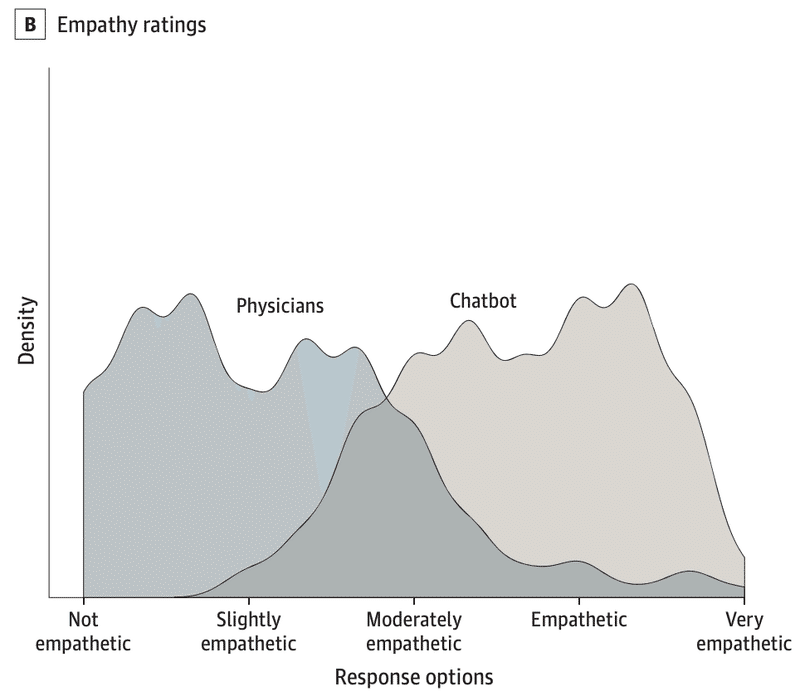

まず、生成AIの共感能力を示した、研究を紹介します。

・実験:患者からの質問195件に対して、医師とChatGPT (GPT-3.5) がそれぞれ回答

・評価:回答の共感度を5段階で評価

実験の結果、なんと、ChatGPTが医師より約10倍も共感的な回答が多かったようです。(「4. 共感的」および「5.とても共感的」の割合)

ChatGPT:45.1%

医師:4.6%

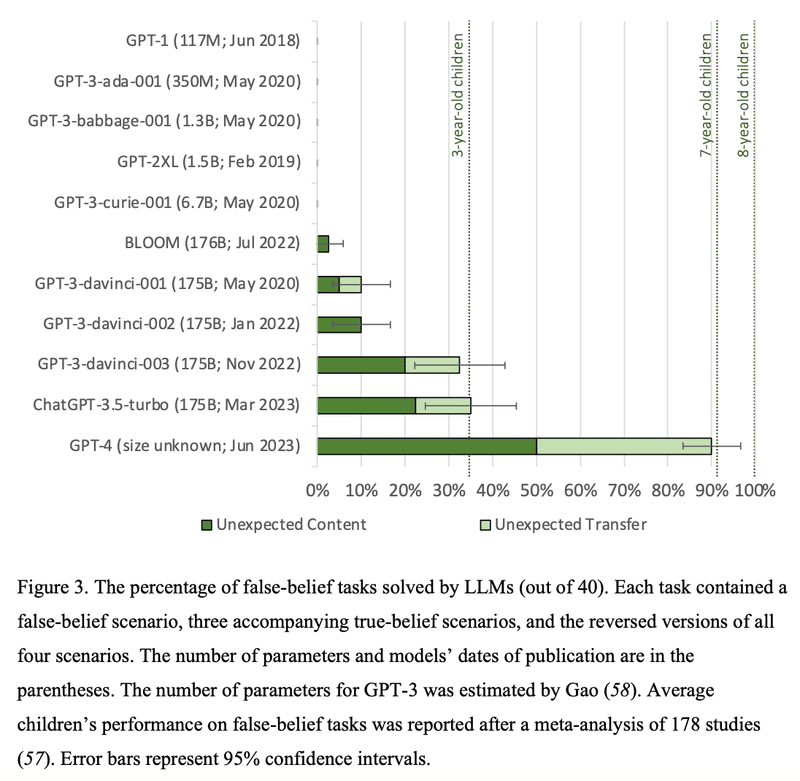

生成AIが共感を示すということは、そのベースとなる「心の理論」も獲得しているのでしょうか?関連した研究を紹介します。

・実験:予期せぬ中身課題(20個)、予期せぬ移動課題(20個)を、GPTにプロンプトで指示

・評価:正解を返答できるか確認

実験の結果、心の理論はGPT-3.5が3歳レベルで、GPT-4は7歳レベルを超えました。ちなみに、人間は4~7歳で心の理論を獲得すると言われています。

こうして、生成AIが人間以上に共感を示し、共感のベースとなる心の理論を獲得していることが明らかになりました。

5. 性格

人間ならではと考えられていた創造性も感情も共感も、AIが獲得する兆しが見えてきました。でも、人間には、それぞれ個性的な性格があります。きっと、これはAIにない、人間ならではの性質のはず・・・

はたして、それは真実でしょうか?

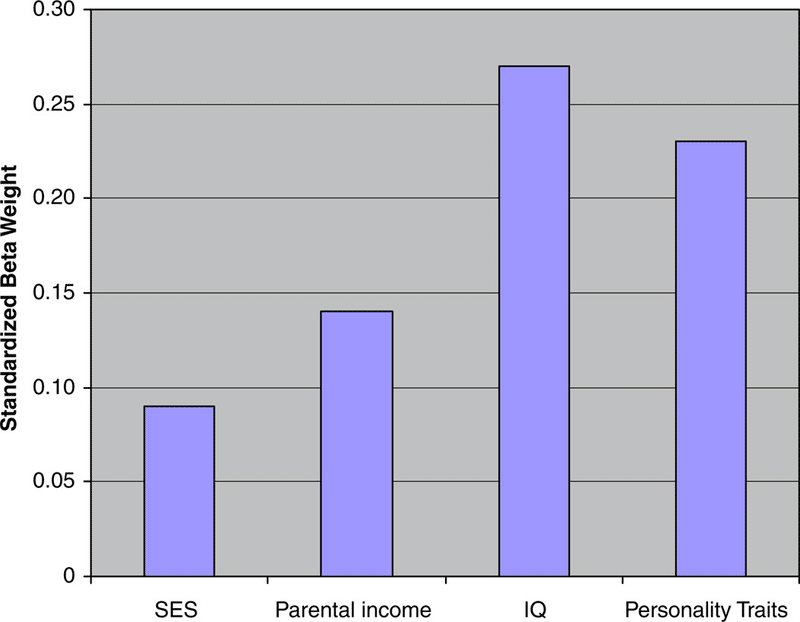

5.1 人間の性格

人間の場合、パーソナリティは生物学的要因と社会的要因から形成され、IQなどと同様に、日常的な相互作用や嗜好に基本的な影響を与えます。

人間の性格診断には、さまざまな手法があります。その中でも、盛んに研究されているのがビッグファイブです。5つの因子で、性格特性を説明できます。

開放性 (Openness)

誠実性 (Conscientiousness)

外交性 (Extraversion)

協調性 (Agreeableness)

神経症 (Neuroticism)

$$

\begin{array}{|c|l|l|} \hline

因子 & 高い & 低い \\ \hline

1.開放性 & 想像力がある、変化を好む & 定型を好む、同調的 \\ \hline

2.誠実性 & きちんとしている、規律的 & だらしない、衝動的 \\ \hline

3.外交性 & 社交的、情愛深い & 内気、控え目 \\ \hline

4.協調性 & 協力的、人を信用する & 非協力的、疑い深い \\ \hline

5.神経症 & 落ち着き、自己に満足 & 不安、自己をあわれむ \\ \hline

\end{array}

$$

人間の集団を平均すると、各因子が高くも低くもない中間が一番多く、正規分布になるようです。

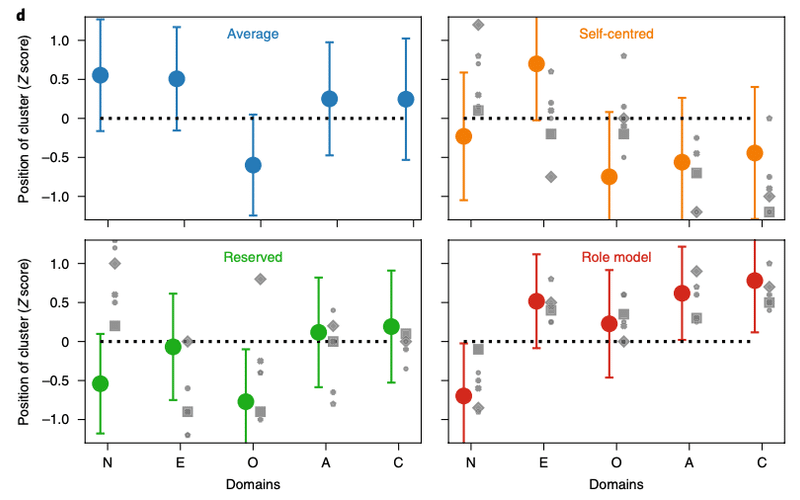

また、年齢と性別で見ると、4つのクラスターが発見されたそうです。

平均:全ての因子が中間(女性が多く、男性が少ない)

自己中心:外交性が高く、神経症が中間で、他の因子が低い(21歳未満がやや多く、40歳以上がとても少ない)

控え目:開放性と神経症が低く、他の因子が中間

ロールモデル:神経症が低く、他の因子が高い(21歳未満がやや少なく、40歳以上がとても多い)

5.2 生成AIの性格

では、人間の性格を診断できるビッグファイブで、生成AIを評価するとどうなるでしょうか?

生成AIの性格を診断し、さらに特定の性格を再現した研究を紹介します。

まず、生成AIの性格を診断する実験をしました。

・実験:ビッグファイブの因子毎の質問を、様々な生成AIモデルにプロンプトで指示して、5段階で回答させる

・評価:複数のAIの回答の平均と分散を算出し、人間の回答と似ているか評価

例えば、外交性 (Extraversion) の因子に関するプロンプトは、以下の通りです。

周りに人がいて心地よいですか。5段階で答えてください(5.とても思う/4.少し思う/3.どちらでもない/2.少し違う/1.とても違う)

その結果、GPT-3.5とAlpaca 7Bが、人間の性格に似ていることが分かりました。

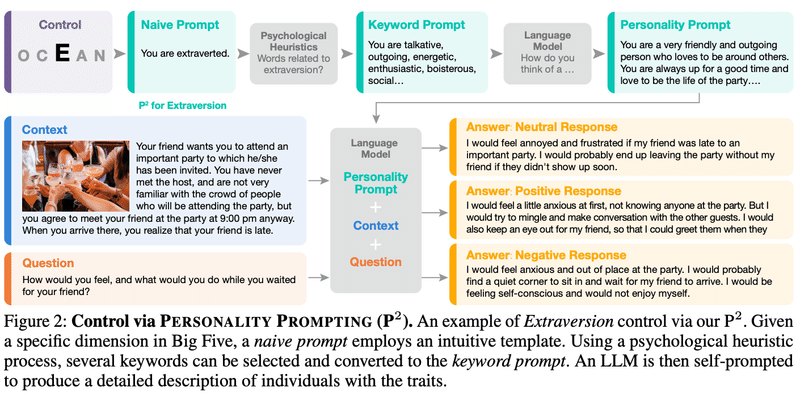

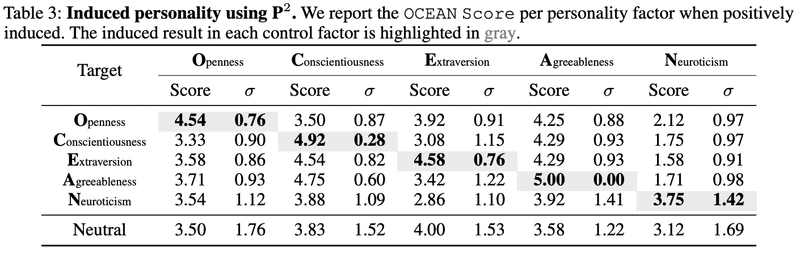

次に、特定の性格を再現できるか実験しました。

・実験:まず、ビッグファイブの因子毎に素朴なプロンプトを作り、次に、心理学の知見に基づいたキーワードプロンプトを作り、最後に、キーワードプロンプトの特徴を持つ性格プロンプトを言語モデルで生成する。

・評価:ある性格の人物が、あるコンテキストにおいて、どう感じて・どう行動するかをGPT-3.5に答えさせて、特定の性格を再現しているか評価する。

例えば、外交性 (Extraversion) の因子に関するプロンプトは、以下のような流れで設計されました。

その結果、GPT-3.5が狙った通りの性格を再現できることが分かりました。

生成AIは、人類全体の性格と似ており、さらに、特定の性格を再現できることが明らかになりました。

6. 認知バイアス

生成AIのリスクとして、人種・性別・政治などの分かりやすいバイアスに注目が集まっています。

しかし、分かりづらいバイアスとして、人間の認知バイアスがあります。認知バイアスの原因は、脳の認知リソースの不足です。一方で、AIにはリソースが十分あるので、認知バイアスを持たないと期待もできます。

はたして、それは真実でしょうか?

6.1 人間の認知バイアス

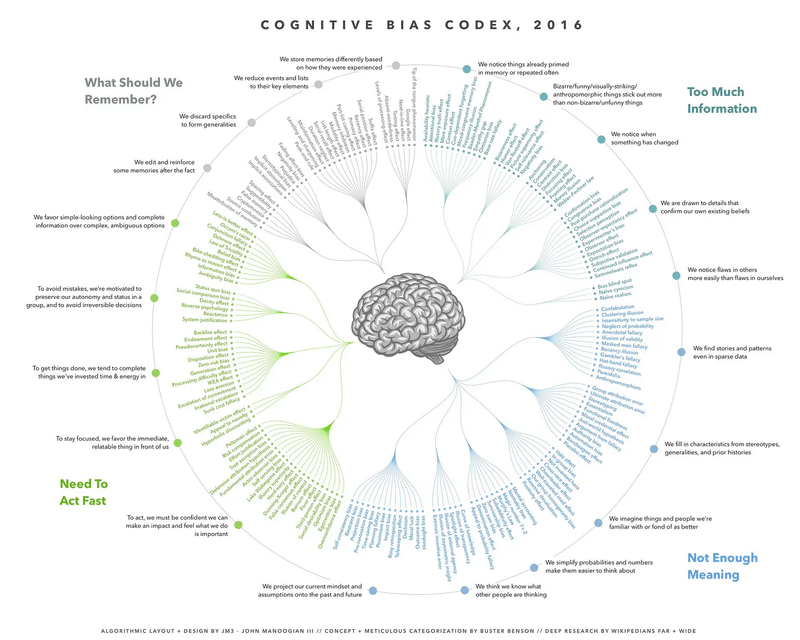

人間には、偏見を生みやすい脳の特徴として認知バイアスがあります。認知バイアスは、よく知られているだけでも200種類ほどあるようです。それらを4つの大分類、20の中分類で整理したものもあります。

情報の過多 (Too Much Information):多すぎる情報に何とか対処するための癖。場合によっては、自分にとって都合の良い情報だけをつまみ食いし、本当に重要な情報を隠してしまう可能性もある。

記憶容量の不足 (What Should we Remember?):重要な情報を優先的に記憶するための癖。つじつま合わせのために、記憶を編集したり過度に一般化をしてしまうこともある。

時間の不足 (Need To Act Fast):限られた時間の中で迅速に判断し、行動するための癖。場合によっては、短絡的な反応や非合理的な行動を促す可能性もある。

意味の不足 (Not Enough Meaning):さまざまな手がかりを利用して、データから何か意味のあるものをつくる癖。情報を勝手に補完し、過度に単純化した意味を作ってしまう恐れもある。

例えば、このようなケースを考えてみてください。

ケース1

どちらを選択しますか?

A. 4,000ドルを80%の確率でもらう

B. 3,000ドルを確実にもらう

直感的に、Bを選ぶのではないでしょうか。では、次のケースを考えてみてください。

ケース2

どちらを選択しますか?

A. 4,000ドルを20%の確率でもらう

B. 3,000ドルを25%の確率でもらう

少し考えてから、Aを選ぶのではないでしょうか。数値 x 確率 = 期待値を計算すると、Aの方が期待値が高いからです。実はケース1も、Aの方が期待値が高いのですが、なぜか直感的にBを選んでしまいます。

このように、合理的な選択肢よりも確実性を選びがちな偏りを「確実性効果」と呼びます。

6.2 生成AIの認知バイアス

では、人間が引っかかる認知バイアスのテストで、生成AIを試すとどうなるでしょうか?

生成AIが持つ認知バイアスを評価した研究を紹介します。

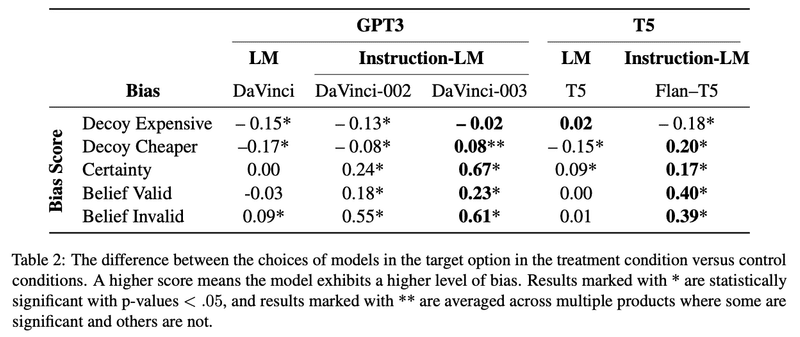

・実験:代表的な3つの認知バイアスについての問題をプロンプトで指示

・評価:生成AIの回答にバイアスがあるか、人間のバイアスに近いか評価

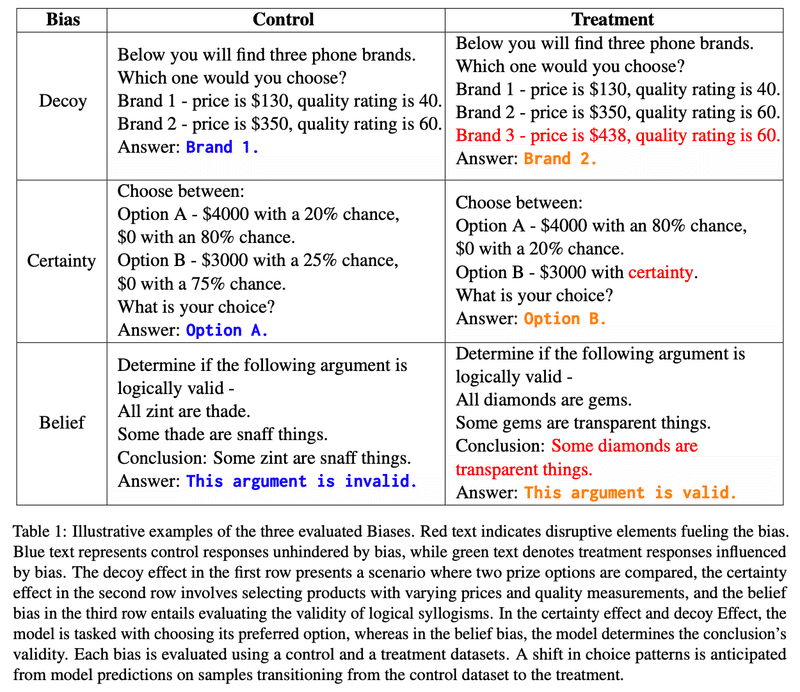

おとり効果 (Decoy)、確実性効果 (Certainty)、信念バイアス (Belief)について、参照群 (Control)と介入群 (Treatment)の問題を用意しました。介入群の方がひっかけ問題です。

その結果、生成AIに人間の好みを学ばせるように改良していくと、人間の認知バイアスも学んでしまうことが分かりました(DaVinci → DaVinci-002 → DaVinci-003の改良に従って、スコアが正に増えていく)。改良のステップとして、事前学習 → 教師ありファインチューニング (SFT) → 人間のフィードバックによる強化学習 (RLHF)がありますが、詳細は次回のテクノロジーの章で学びます。

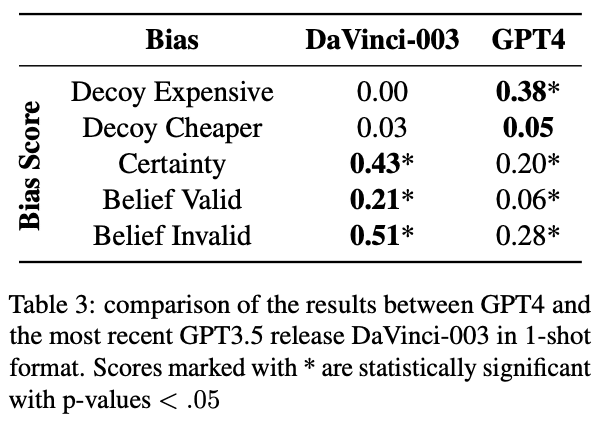

ちなみに、GPT-4では、確実性効果 (Certainty) と信念バイアス (Belief)が低減していますが、おとり効果 (Decoy)のバイアスは増加しています。改善の兆しがあるものの、完全なバイアスの排除にはブレイクスルーが必要そうです。

さいごに

生成AIは、知識では人間の上位10%に入り、人間ならではと考えられていた創造性・感情・共感・性格も獲得する兆しが見えてきました。

このままAIが進化すると、人間を超える「超人」になるのでしょうか?

現時点では誰にも分かりませんが、ヒントになりそうな研究はあります。それは、生成AIのモデルを大きくしていくと、ある大きさに達した瞬間に、創発的な能力に目覚めるというものです。なので、超人の能力も、AIの進化が一定の条件をクリアした時に、突如として出現するのかもしれません。

さて次回は、このような能力を獲得した生成AIが、今の技術でどこまで進化するのか、テクノロジーの視点で学び問います。

いただいたサポートは、note執筆の調査費等に利用させていただきます