「チャットはもう飽きた」と戦う来年のわたしたち、あり得る未来を想像してみる

この記事は、あるふさん による、生成AI Advent Calendar 2023 3日目の記事です。

2日目の記事はこちらから:

はじめに

イギリスで留学生 && TAKAO AIという会社の代表をしております、板橋 竜太 (X: @iryutab) と申します。

LLM以外の話題もウェルカムのカレンダーとのことでしたが、がっつりLLMの話題にて失礼します。

2023年は、AIによる自然言語処理の世界において、非常に記録的な年となりました。流れや歴史自体はあるふさんの記事にて触れられていますが、大きなスコープではGPT-4、そしてオープンソースLLMの世界ではLLaMAの登場が、それぞれの世界観に大きな影響を及ぼしました。

来年もこの進化の流れは止まることはなく、高速化、高性能化、小型化、そしてアラインメントが各分野の研究者によって進められていくでしょう。

一方、2023年がLLMという基礎技術にとってのブレイクスルーが発生した年だとすると、来年はそのインフラとしての活用のために必要となる周辺技術や活用の幅が一気に発達することになりそうです。

では実際のところ、何が発達していくのか?

一つの結論に帰結する話題ではないのですが、俯瞰して最近の動きを眺めて、来年のことを想像してみたいと思います。

OSI参照モデルもどきの導入

LLMによるブレイクスルーを、「インターネットが生まれたときのような状況」と例える言葉を時折目にします。実はLLMからインターネットへの連想ゲームは、一つ参考になる、「皆んな大好きなアレ」に繋げてくれます。OSI参照モデルです。

これはネットで見つけた記事からの画像ですが、皆んな大好きなOSI参照モデルの各レイヤーを、LLMの技術に置き換えてみたものです。各レイヤーの置き換えがどれくらい正しいかはさておき (個人的には7層は分け過ぎかなと思っています) 、インフラストラクチャーとしてのLLMを考えた時、どのあたりに進化の余地があるかを考えるよい参考になります。

これを見ると、(言うまでも無い気もするのですが) 上層に行くに連れ、まだ改善の余地があると記されています。特に面白いのは最上層であるApplication Layerで、(これは個人的にこの図の秀逸だと感じる部分なのですが) Presentation LayerやSession Layerは"Needs improvement"としているところを、Application Layerでは"Needs Significant development"とされています。

これから先、ベターなUI/UXの探求とともに、「活用場面」という意味での"Application" (Apply-ication) を探し出す活動に力を入れていくべきなのは確かそうです。

OpenAIのやったこと

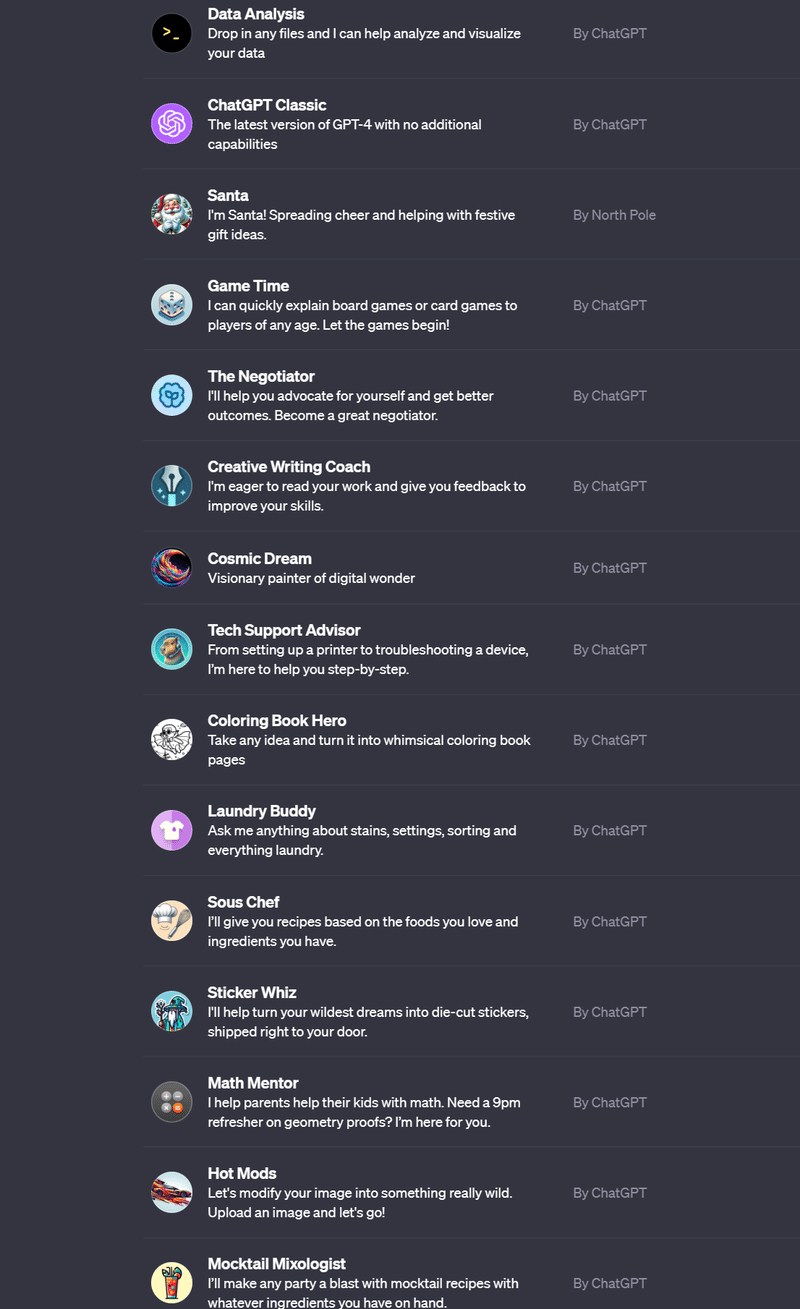

このApplicationの探索において、いまOpenAIが始めようとしていることが、GPTsとそのストアです。

GPTsは一見、「ChatGPTをちょっとカスタマイズできて嬉しい」くらいの話に見えそうなのですが、実際はもっと大問題です。

ふつう、LLMのような新しい技術が誕生したら、その技術をデベロッパーや企業に公開して、彼らがその技術を使ったプロダクトを作ってくれることに期待します。しかしLLMという技術は、その開発プロセス自体をLLMに任せることができる (=自然言語プログラミング) から、完全ノーコードの開発環境としてGPTsをつくることができ、LLMを使ったApplicationの探索者を、Non Developerにまで拡大する事ができたわけです。

実は、ChatGPTの外の世界でも、(それを目指していたかは別として)、同じことを達成しうる活動や場は存在していました。

Hugging faceのSpacesは開発者コミュニティには根ざした場所であり、ここで流行ったものが一般コンシューマーによって使われる未来もあったかも知れません。Streamlitは、自社サイトにGallaryページを以前から用意していて、例えばここでLLMを使った色んなインターフェースの色んなアプリケーションが出てくる可能性もありました。実は私の会社でも、YataiというLLM/AIアプリケーションのマーケットプレイスを作っていて、API料金のスケールに応じ開発者の収入がスケールするように従量課金を簡単に実装できるAPIなどを用意し、小さいかも知れないけど破壊的な、多様なApplicationのプロトタイピングが行われる場所を作ろうとしました。

でも、GPTsは圧倒的でした。なにせ、開発者じゃなくてもそのゲームに参加できるのだから、人数規模が違います。Storeが登場する頃には、興味深い/使える/楽しい/コンテンツ性のある/破壊的な/多様なGPTsがランキング上位に登場し、OpenAIにとっての「弊社技術のApplicationのPoCアウトソーシング大作戦」としては、大成功を収めるでしょう。

しかし、OpenAIにもその他全てにも残された共通の課題もあります。「もうチャットボットUI飽きた問題」です。

でもチャットボットってダメなの?

もちろん使い方に依るのですが、 "Yes, but No" というところでしょうか。

言語モデルは入力されたテキストの続きを連鎖的に予測して出力するものですが、ワンショットの入力補完で終わること無く「nターンの対話型」とすることで、人間からのフィードバックを定期的に取り込んだ生成が可能となります。ですから、LLMをチャット形式にチューンして使うというアイディアは、LLMを効果的に使用する上で良い手法です。

一方で、プロダクト・ツールとしてのチャットボットは必ずしも「良いデザイン」ではありません。理由は色々ありますが、個人的に最も大きく感じるのは「Minimum Input, Maximum Output (最小の入力で、最大の出力を得る」から程遠い部分でしょうか。LLMを使わなければ生成できないOutcomeは確かにあるのですが、道具としてのプロダクトと考えた時、それをチャットボットの形で使ってしまっては、些か入力の占める割合が大きすぎます。

敢えてプロダクトとしてチャットボットをJustifyするのであれば、

顧客対応など、会話の相手となることが存在価値であるプロダクト

(これは情報を検索するためのインターフェースとしてのチャットボットも含む…チャットボットであること自体がそれ以前のUIよりも便利になってるケース)

LLMにできることを検証するためのプロトタイピングツール

といった辺りが、パッと思いつく部分でしょうか。後者の存在意義ゆえにGPTsは効果を発揮するわけですが、プロトタイピングとして作り終わった後、適切なGUIを作ってあげればその使い勝手が向上するケースが多くなるかと思います。ハードの世界で言えばラズパイみたいなものかもしれません。とりあえず大体実現できるけど、最適な構成は他にあるよね、みたいな…。

逆に、非常に良いインターフェースでLLMが活用された例が、GitHub Copilotですね。ユーザーの入力を増やすこと無く、自然な形で補助を行い、手放せないツールとなりました。しかし一方で、今のところそれ以上の例はあまり出てきていない訳であり、おそらくは世界中のあらゆる産業・物事のスキマに、そこに特化したLLM Application探索の余地が残されています。

来年、私達はどういうインターフェースでAIと喋ってるのか

最初に誰が言い出したのかは定かでは無いですが、定期的に「LLMはスマートフォンの次のハードウェアを生み出す」とも言われています。

新しいインターフェースは生まれると思いますが、それがスマートフォンを投げ出すほどのものになるか、あるいはこのAIPin↓のように、手のひらにプロジェクターで映し出すようなものになるのか(?)までは定かではありません。

個人的には、そんなに使いやすいとは思わないと言いますか、スマートウォッチで良いようにも思うのですが…触れば違うのかもわかりません。こちらも来年。

それに、考えてみるとAi Pin、ハードウェアは独立したものの、(今観測できる範囲では) 結局会話ベースなので、やっていることはチャットボットのような気もします。

また、今はまだ直接のつながりは生まれていないものの、XRヘッドセットの技術も同時進行で進化しています。Quest 3は「常時身につけるHUDデバイス」に一歩大きく近づいたものだと思いますし、こちらも来年ユーザーの手に届き出すApple Vision Proのアプリケーションに、何かLLMと立体的なUIを使った新しいものが出てきてもおかしくないのかなと思っています。

もしかしたら、結局一番LLMが元気に動いているのは世の中のシステムのバックエンドであり、フロントエンドのインターフェースを持つApplicationではない可能性もあります。

GPT-4ベースで駆動するAssistantに、多少のツールを持たせると、「これは実行不可能だ」と言い切れるタスクが見つからないくらいには、相当なんでもやらせることができます。(NSFWな情報を扱うとか、フィルターに引っかかる部分はムリだけど)

ZapierのNatural Language APIは非常に良い例で、ヒューマン・マシンインタラクションの発生しない、「今自然言語の入り口が無いから不便になっている場所」にLLMが活用されるという方が、まずは先に広がりを見せているかも知れません。

おわりに

技術としての生成AI/LLMが2024年も進化を遂げていくのは疑いようのない未来であると思いますが、ユーザーとして、何を介してそれと関わっていくことになるのかという視点から、2023年のLLMを眺めてみました。

改めて眺めてみると、

2022-2023年、LLMプロダクトとしてはチャットボット一強だった

例外はGitHub Copilotであり、こういう事例のポテンシャルが世界に存在しているはず

来年からは、LLMにおける「OSI参照モデル上層」を探求することになる

最上層である"利用場面"としての"Application"は、GPTsによる探求が始まった

一方で、インターフェースの探求やAgentの深掘りには、まだまだ余地がある

といったところでしょうか。

来年の12月、私達は一体何を介して、AIとコミュニケーションしているのでしょうか。私もLLMを使う一開発者として、それがより良いモノになるよう微力ながらコミットできたら、などと感じています。

さて、乱文・長文となりまして失礼いたしました。続く4日目の記事は 蓬アルテ さんによる記事です!

この記事が気に入ったらサポートをしてみませんか?