新GPUデータセンター訪問の顛末記

会社で「そうだ、新GPUデータセンターへ行こう!」ということになったので、今回はその顛末記。ちなみに出張報告は不要なので顛末記を書くことにしたけれども、今ではこの顛末記のデータさえあれば生成AIに「出張報告を作成して」と言えば済む。便利な世の中になってきたものです、はい。

(下記のMetaブログ記事によると5万個近いNVIDIA H100を活用して開発中のLlama 3登場も近いようであり、それに間にあって何より、何より)

事の始まり

今回はいきなりな展開なので、まずは背景を説明しておく。実は会社で有志が集って生成AIに関して「何か(具体的には特に決まっていない)」をやってみようという活動があって、その中で新規に構築中のGPUデータセンターを見学してみたいという話になった。

ぶっちゃけ私は生成AIで小説を出版してチマチマとお小遣い稼ぎをするスローライフを目指している身である。あちこちのデータセンターを訪問した経験もあるので、特にGPUデータセンターを訪問する必要はない。そもそも自宅でデータセンター向けのNVIDIA Quadra RTX 8000 (VRAM:48GB)を稼働させているようなヤツなので、行かなくても手に取るように現場をイメージできる。

ただし立ち位置としては「なんでも知ってるおじさん」として、リーダーやサブリーダーを支援することを目指している。いや、もっと正直に言ってしまうと、『場を盛り上げる宴会要員』というところだろうか。そんな立場を目指すヤツが不参加というのは好ましくない。だから今回の話が実現した時には、『参加』一択だった。

(え、「広報部門まで巻き込んで話を大きくしたヤツは誰だ?」って。いや、それはあのその……)

そんな訳で実は少し斜めに構えていることの多い中二病の我が子みたいなスタンスで参加したのだけれども、実際に参加してみたら……それは追々と告白することにしたい。

まずは集合の目印

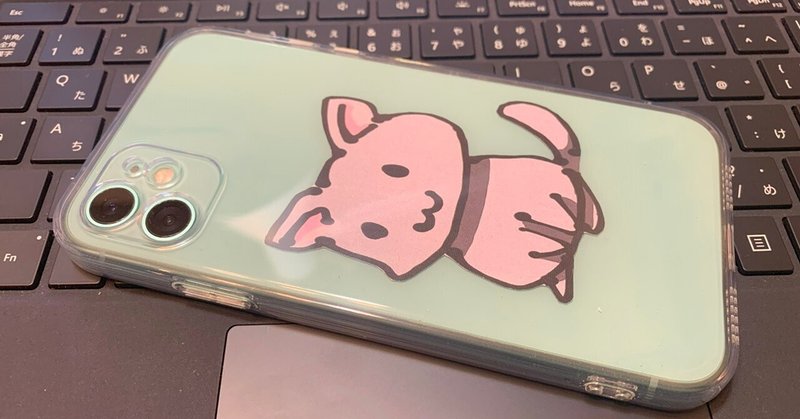

実は今回のデータセンター訪問参加メンバー、今まで顔を合わせたことのない者が多い。合流方法から考える必要がある。そこで利用したのが、冒頭画像のスマホだったりする。

これは私が著者近影とかSNSアイコンとして利用している「ヌコ」であり、中二病のど真ん中にいる我が家のお嬢さまが小学校六年生の頃に描いてくれたものだったりする。彼女は私の契約イラストレーターなので「会社で自分の顔写真をアイコンにするようにとの通達があったけれども、イヤだから似顔絵を描いて」と依頼したら、この謎生物が納品された。

「何このかわいい動物は?」

「ヌコ」

という具合である。なお子供が私をこのようにかわいい動物だと認識しているかどうかは、本人が黙秘権を行使しているので不明である。

ともかくこのアイコン付きスマホは便利で、これさえ持ち歩いていれば、初めて顔合わせする人と落ち合うのに困らない。このアイディアはCopilot様にお伺いを立てることによって得ることが出来た。

(最初は一つしかないということで、駅の某所をオススメされたりして、質問内容を工夫するのに苦労したのは内緒の話だ)

とりあえずこのアイデアはそこそこ受けたようだけれども、宴会要員としての目的は無事に達することは……残念ながら出来なかった。なぜならいつものことだけれども、現地には合流時間ギリギリとなってしまったのだから。

ヤレヤレ、である。

(なお本日時点では冒頭画像の背景を切り取ることにより、さらに洗練されている。契約イラストレーターに背景色の変更を発注していたのだけれども、最近は忙しいらしく「自分で背景を切り抜けばいいじゃん」と最終回答されてしまった。ま、結果オーライで、ともかく安物感は完全に払しょくされた……真正オッサンがこんなにかわいいアイコンをスマホに貼ってて恥ずかしくないのかという問題はあるけれども)

見た目は平凡なデータセンター

データセンター自体は特に特長はない見た目であり、GPUシステムの設置場所も見た目は『見た目は平凡なデータセンター』だった。NVIDIA H100を空冷方式で稼働させるので稼働時の騒音は相当なものになるけれども、今回は稼働していなかったので『そこそこうるさい』程度で済んだ。

なお拙宅のGPUはGPUをフル稼働させる時だけファン婚……じゃなくてファンコン(ファンコントローラー)を手動操作して100%フル回転させているけれども、さすがにそのあたりは負荷に応じて回転数を自動制御しているとのことだ。『そこそこうるさい』というのはGPUがフル稼働していなくても、足回りのGPU間やサーバ間を接続するネットワークは稼働状態にある。その部分だけ回転数が高く、暖かい温風が放出されていた。

ただしベテラン勢はさりげなく目を走らせていたけれども、さすがなのは供給電力装置だった。余裕のある設計で、これならば全GPUをフル稼働させても余裕で耐えることができそうだった。

これは基本的なことだけれども、基本を漏れなく実践してコンピュータ機器類を安定稼働させるというのはけっこうムズカシイ。誰もが知る超大手企業が誇る超大規模データセンターでさえ、機器追加しているうちに供給可能電力を上回る規模にしてしまって誤作動する事案も存在する。そもそも100Vよりも若干低めに供給電力を設定して、少しでも電力代を節約しようとするところも結構多いと聞いている。

データセンター側の案内者も見事なもので、そういうところに目配りした者には対応が微妙に変わっていた。「プロ同士は多くを語らない」というところだろうか。

少し加筆しておくと、「どこにでもないデータセンター」というと、自分的にはMicrosoftやMetaの16,000個を超えるGPUを配備したデータセンターとなる。なお最近話題のLlama 3は約5万個のNVIDIA H100 GPUを活用したGenAIインフラで開発されているらしい。残念ながら不勉強な私は、日本国内に10,000個を超えるGPUで構成されたシステムが存在しているという話は聞いたことがない。

GPUシステムは冷却ファンが面白い

GPUシステムとして本当に面白いのは、いかにGPU間を高速接続させるかという点に尽きる。それによってChatGPTなど生成AIの中核である LLM (Large Language Model) の学習効果が大きく異なってしまうからだ。

が、社畜系の正統エンジニアではなく野良エンジニアである自分には、それよりもNVIDIA DGX H100システムの冷却ファンが興味深かった。

なぜならどうやら80mm(もしかしたら92mm)サイズのファンを 3 x 8 = 24個ほど装備していたからだ。Quadra RTX 8000を自宅に設置する際には40mmファン x 2個から120mmファンまで幅広く試したけれども、結局は80mmファン(4000rpmの爆音型)をファンコンでGPUフル稼働時のみ100%回転させることに落ち着いた。

そういえば東工大Tsubame 4.0はHPE Cray XD6500を採用している。こちらは "各計算ノードは第4世代AMD EPYCプロセッサを2基、NVIDIA H100 TensorコアGPUを4基、768GiBの主記憶、NVIDIA Quantum-2 InfiniBandネットワークインターフェイスを4ポート搭載します" とのことであり、同じGPU数であれば理論的にはDGX H100構成よりも高性能を叩き出せる。ただしこれは世界スパコンTOP500のような指標で見た場合の "性能" であり、LLMを学習させる性能とは必ずしも直結しない。少なくとも現時点ではGPUを使わずに世界4位をキープしている理研Fugakuは、LLM学習では研究段階となっている。まだまだ日進月歩の分野なので、今後の展開を見守るしかない。

さてXD6500に話を戻すと、どうもDGXよりも大きさをコンパクト化してファンも異なる形状にしているようだ。もしかしたら冷却フィンもHPE独自品を採用しているかもしれず、ぜひ一度中身を拝めると嬉しいとおもっていたりする。ちなみにどこぞの企業ではSXM型H100を「重たいねえ」と言いながら笑顔持っているエラい人の画像を社内宣伝に利用しているらしいが、SXM本体は6.7インチ程度のスマホと同サイズのプレート板に過ぎない。残りは冷却フィンであり、「おじいちゃんには重たくて当然」とも言える。個人的には「このプレート1枚でxxx万円」の方がインパクト大きい気がするけれど、まあ社内だから放置しておいても構わないだろう(と、思う)。

頼もしい若者たち

さてここまでは予想した範囲を超えるところはなかった。参加して良かったと思えるほど驚かされたのは、参加した若者たちのレベルや『やる気』である。弊社の未来は明るい……一方で、オッサンもうかうかしていられないという脅威感にまで襲われてしまった。

まず職場に勝手に開設した図書コーナーに、出張前に本の借用または返却に来た子がいた。残念ながら職場移転前の準備作業で声をかける余裕がなかったのだけれども、図書コーナーを開設した価値があったというものだ。そういえば我が家のお嬢さんも理系志望なので東工大に新設された女子枠を目指したい……のだけれども、今一つ『やる気』が十分でない。今のところ調子を崩すたびに父親が介入して立ち直って「ピンチや逆境に強い小野谷」という異名を取っているらしいが、本人は納得していないらしい。「そりゃ日頃から地道に国力増強に邁進して戦力を蓄えて正攻法で戦う銀河英雄伝説ラインハルト皇帝じゃなくて、手元に残っている戦力をフル活用して戦う共和国ヤン・ウェンリー元帥(ミラクル・ヤン)だよねー」と言ったところ、顔を真っ赤にして怒っていた。学校ではさっそく女子枠で入学の決まった子がいるとのことで、ぜひ父親としては東都工業大学……もとい東京工業大学(東京科学大学へ名称変更だっけ?)に合格して貰えると嬉しいと思っている。

それから見学の最中に「GeminiとGPTを比べると…」という若い声が聞こえて来た。うーん、ワシ……いや私はCopilotを少し試している程度で、そもそも「早く生成AIを活用して作家業で副収入を得て、Quadra RTX 8000などの大規模投資で流した血(散財)を回収しろよ」状態である。XD6500のファン形状に気づいたのも若手が質問してくれたからなので、弊社の未来は明るい(おそらく)と感じた次第である。

うん、弊社は今まで銀河帝国だったし、今後も銀河帝国だよな… ですよね、社長。

流した血といえば

そういえば今回のGPUシステム訪問の成果とは直接は関係しないけれども、実は隠れた墓穴を山ほど掘っていた。ここで告白しておこう。……と、いうか、単に訪問後には飲み会が開催されると勘違いしていただけだったのだけれども。

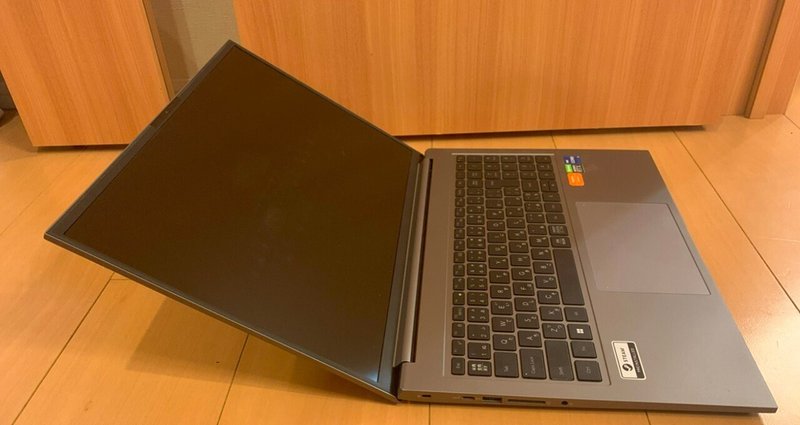

VRAM16GBのGPUを搭載したノートPC

「私は会社でVRAM16GBのGPU搭載マシンを扱う技術者だ。事務職ごときに何か言われる筋合いは……」

「技術者よ、お前の前にいるのは自宅内の総VRAMが160GBを超えている野野良エンジニアだ」

どこかのマンガやアニメで聞いたようなセリフだけれども、実は拙宅にあるのはNVIDIA Quadra RTX 8000やTelsa P40たちだけではない。お出かけ用にVRAM16GB版GeForce RTX 3080を搭載したノートパソコン (ZL7C-R38H) を保有している。

もちろんデフォルト設定の32GBメモリのまま放置しておくなどという中途半端な妥協は一切ない。昨今のLLM事情を鑑みて、主メモリも搭載可能な最大サイズである64GBへと交換済みである。

最近は技術革新が進んだおかげでノートパソコンも軽くなったけれども、さすがに2.1kg超である。カバンが重くなる。しかし宴会要員としてはせっかく話が弾んで実機検証したいことが生じた時に、「明日になったら」というのは残念な事態である。

それで遠路はるばる持参したら……、アッサリと訪問後は解散してしまった。この無念、分かって頂けるだろうか。

生成AI作家メガネ

さて私は技術系ブロガーから生成AI作家への転身を図っている最中だが、『雰囲気』というのも大切だと思っている……と、いうか、家族からは避難ごうごうだったけれども、大正モダンな丸眼鏡を保有している。

「自宅外で利用したら親子の縁を切る」と言われているけれども、外出する機会の少なくなった昨今、自慢できるのはこういう時に限られている。

まあ作家というかパソコンも含めた近距離作業用にレンズ設定したメガネだけれども、これもカバンの中に隠れたままで終わってしまった。別に飲み会はないと分かった段階で掛け替えるというアイデアもあったけれども、それは全く意味のない行為と化してしまった。

なぜならこんなメガネなど比べ物にならないくらい派手な出で立ちの御方がいらっしゃったのだ。交番の警察官のような服装をしていた。もちろん市中では目立つけれども、弊社の正装の一つだから問題はない。

式典などで使用される制服と比較すると、大正ロマンな丸眼鏡など些細なレベルとなってしまう。

それに今もこのメガネを掛けて本note記事を執筆している訳だけれども、あまり外見に拘り過ぎるのも格好良くない。さっさと本記事を書き終えて、次の宿題を片付けることにしよう。

しめくくり

なんだかGPUデータセンターから逸脱する話が多かったと思うけれども、個人的にはそれで良かったと思っている。

GPUシステムの活躍が期待されている生成AIは日進月歩の勢いで技術革新が進んでいる。技術的な詳細を語っても、すぐに陳腐化してしまうからだ。それにITインフラ系の関係者が言うのも何だけれども、結局のところITシステム……コンピューターシステムというのは、何かの目的に使用するための道具に過ぎない。

ITビジネスの関係ならば生成AIというキーワードに遭遇しない日はないだろうけれども、世間的には「何それ?」である。たしかにハードウェアによって制限されている部分も大きいけれども、今の焦点は「企業や個人が生成AIをどのように活用するか」となっている。

現段階の生成AIは大学卒の新人並みの仕事をできるレベルまで来ている。さらに進化が進めば、私のように曖昧な知識しか持っていないオッサンは不要の存在と化してしまう。どうも現時点の雲行きからすると、「誰かがやってくれたら、それを真似すれば良い」という二番手アプローチは使えなくなる可能性もある。ある意味でリスクに挑んだり苦労した者が報われる形になる訳で、それはそれで悪いことではないかもしれない。

とりあえず弊社はNVIDIA DGX H100で構成された新GPUデータセンターを保有することができた。そしてこれからローカルLLM環境では断トツの存在と化しつつあるLlama 2がLlama 3にバージョンアップするが、その時期には間に合った。

このシステムを活用して何とどう戦っていくか……全くもってして、興味深い時代になってしまったものである。

(それにしてもCPUに関するムーアの法則は終焉しそうな雰囲気なのに、技術革新のペースが上がって来たような気がする。頼もしい若者たちの精鋭チームを保有することが雌雄を決するということになるだろうか)

それでは今回は、この辺で。ではまた。

-------

記事作成:小野谷静(オノセー)

この記事が気に入ったらサポートをしてみませんか?