筑波大学オープンコースウェア(OCW)の機械学習の"note"をとった - 重回帰 (2)

用語メモ

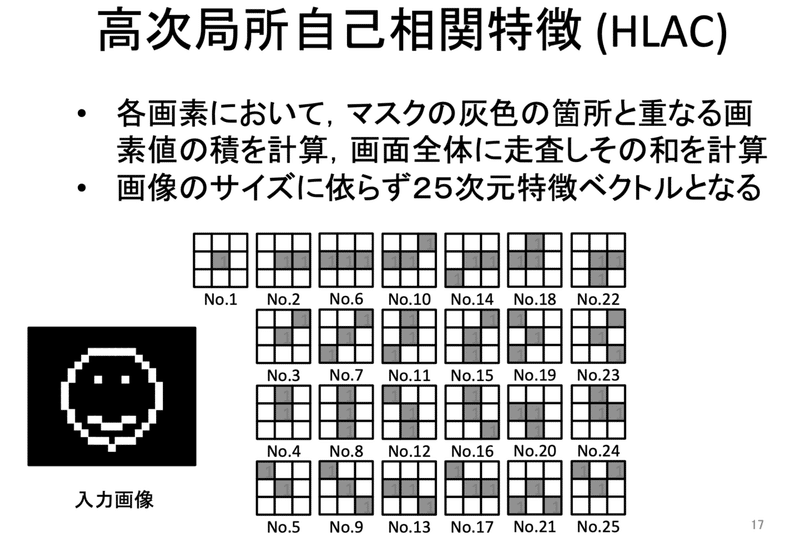

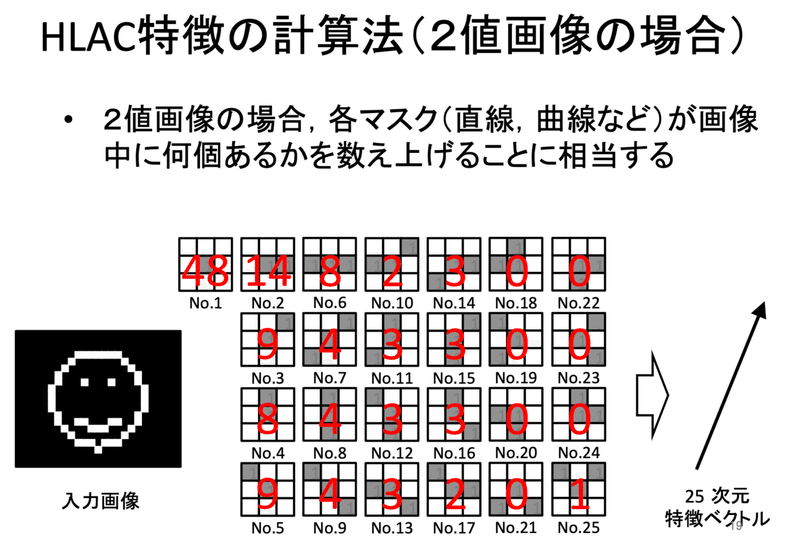

高次局所自己相関特徴(HLAC)

角度や位置などによって認識精度が左右されたくないような特徴量とする。

予め識別対象の物体を表す解像度のパターンを用意しておく。

そのパターンに該当する箇所が何箇所あるか、識別対象の画像に対して左上から網羅的に精査していき、パターンに該当する箇所が何個あったかをカウントする。

パターン画像数=次元数となり、ベクトルの要素はそのパターンに該当するカウント数となる。

引用(講義ポイント)メモ

機械学習についてはデータ > 特徴量、特徴量 > 認識と2STEP構造になっているのに対して、Deep Learning はデータ > 認識まで End-to-End で学習してしまう。

例えば画像データならば、画像を特徴量に変換するのではなく画像そのものを入力する。

そしてどうやって特徴量を設計するのかという部分も含めて学習する。

この授業で Deep Learning を学ぶ前までは Deep Learning の最後から2層分の処理を学ぶ。要は特徴量に変換された後どうやって識別・認識するのかという話。

Deep Learning がやっているのは、データからどうやって特徴量を作るのか(というのを中間層でやっている)。

授業の8割ぐらいは古典的な機械学習の手法を学ぶが、それは Deep Learning から切り離されているわけではなく、ラスト10%ぐらいの出力層でやっていることの理解に非常に役立つ。

この記事が気に入ったらサポートをしてみませんか?