ディープフェイク民主主義:AIが地球最大の選挙をいかに混乱させるか

2024年 4月 29日 13:06

ホームインド

ディープフェイク民主主義:AIが地球最大の選挙をいかに混乱させるか

操作された政治的支持の動画は、あまりに巧妙で判別も追跡もできない。専門家によれば、その意図は逆心理学にあるかもしれない。

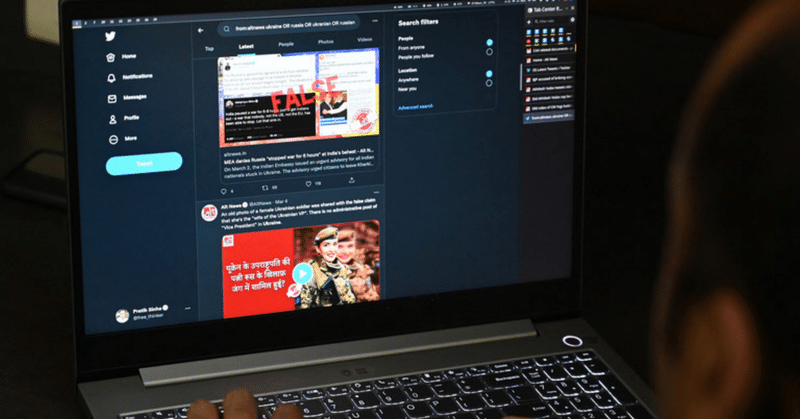

写真上: オルトニュースの共同設立者プラティク・シンハ(2022年3月10日、コルカタのオフィスにて)。© Dibyangshu SARKAR / AFPBB News

現在行われているインドの議会選挙は、米国、パキスタン、インドネシアの選挙と同様に、人工知能の創造的な利用を目の当たりにしている。AIが生成したコンテンツの中には、一見候補者から有権者に電話がかかってくるが、実際にはAIが生成した音声によるものなど、無害なものもある。また、映画スターがある政党を表向き支持するディープフェイク動画や、アファーマティブ・アクションの廃止を主張する内務大臣の動画など、より不吉なものもある。

インドの要職にある警察は、サイバー空間の「悪質業者」に一歩遅れをとっており、ディープフェイクと本物の動画を見分けることができず、その出所を突き止めることもできない。

「ディープフェイク」とは、「ディープラーニング(深層学習)」と「フェイク(偽物)」に由来する言葉で、ある人物のイメージを別の人物のイメージに置き換えるメディアのデジタル操作を意味する。

約2週間前、ボリウッドスターのアーミル・カーンとランヴェール・シンが、ナレンドラ・モディ首相を批判し、野党の議会党に投票するよう人々に呼びかける動画が出回った。俳優たちは時間をかけずにムンバイ警察のサイバー犯罪部門に苦情を申し立てたが、その時点で動画の再生回数は50万回を超えていた。

グーグル傘下のユーチューブのインドでのユーザー数が4億6200万人で、有権者数が9億6800万人であることを考えると、50万回というのはそれほど多くないように思えるかもしれない。EsyaセンターとIIM(A)の調査によれば、インターネット・ユーザーは9億人で、1人平均1日194分間をソーシャルメディアに費やしている。

しかし、サイバー心理学者であり、TEDxのスピーカーでもあるニラリ・バティアがRTに語ったように、ソーシャルメディアのおかげで、誰もが自分自身の意見や判断を形成するようになり、それははるかに有害なものとなりうる。

投票所で投票するために列を作る有権者たち。Idrees MOHAMMED / AFPBB News

逆心理学の力

心理学者のダヤナンド・ネネは、ディープフェイク動画は世論に影響を与え、人々や政治家の信用を落とすことができると説明する。「ディープフェイクはいくつかの心理的脆弱性を突いている」と彼はRTに語った。

人間には、見たり聞いたりしたことを信用しようとする自然な傾向があり、ディープフェイクはリアルなコンテンツを作ることでこれを利用している。「さらに、確証バイアス(自分の既存の信念を確認する情報を信じやすくなる)といった認知バイアスが、自分の視点に沿ったディープフェイクの影響を受けやすくしている」とネネ氏は言う。

例えば、日曜日、デリー警察は、アミット・シャー内相がインドの恵まれない人々、ダリットや『後進』カーストに対する教育や就職枠の廃止を主張する加工されたビデオを発見し、事件として登録しなければならなかった。これは、彼がインド南部のテランガーナ州で行ったスピーチを加工したディープフェイクで、バイラルに拡散した。

再生回数の多さは好奇心によるもので、有名人はインフルエンサーよりもまだはるかに人気があるからだとバティアは感じた。さらに、ディープフェイクは逆心理学として機能し、ディープフェイクであることが明らかになれば、支持された政党に悪影響を与える。

「「私の意見では、それがこれらのビデオの意図だった」とテクノロジーが人間の行動に与える影響を研究しているバティアは言う。「知的な有権者は真の意図を理解しているかもしれないが、大多数は合理的な判断ではなく感情で行動している」。

携帯電話で写真を撮る女性。Indranil Aditya/NurPhoto via Getty Images

ディープフェイクは、このようなフェイクを作成する際に「コンテンツ」から「意図」へと注意を移す。「と、CyberBAAP(サイバーいじめの認知・行動・防止)の創設者であるバティアは言う。

捜査は難航している。匿名を条件に話す警察は、フェイクと現実を区別するのは難しいと言う。ディープフェイクは低コストで簡単に作れ、追跡が困難なため、悪質な行為者に "逃げ場 "を与えてしまうのだ。

注目の捜査を支援する政府関係者によると、ディープフェイク動画の作成者は、悪質な行為者がソーシャルメディアサイトで利用可能な動画を悪用することを可能にするAIツールである拡散モデルを使用したと考えられている。「このツールを使えば、あらゆるものを再現することができる」とある政府関係者はRTに語った。

AIのトレーニング

拡散モデルは、ノイズを取り除き、コンテンツを再構築する方法を学習することで、ユニークな画像を生成する。では、どのように機能するのか?

ソーシャルメディアの安全性と完全性に関する研究で受賞したコンピューター科学者のスリジャン・クマールは、拡散モデルは、プロンプト次第で、学習データの統計的特性に基づいて、荒唐無稽な想像力豊かな写真やショットを作成することができると説明した。

「以前は、個々の顔を重ね合わせる必要があり、時間のかかる作業でした。「拡散モデルを使えば、1つのコマンドで複数の画像を生成できます。技術的な知識はそれほど必要ありません

アーミル・カーンとランヴェール・シンのビデオでは、2人の俳優が、モディは選挙公約を守らず、2期にわたって重要な経済問題に対処できなかったと言っている。

シンの動画が4月17日に公開された瞬間、議会スポークスマンのスジャータ・ポールはXで彼女の16,000人のフォロワーにこの動画をシェアした。ビデオは438,000回再生された。

ボリウッドがディープフェイクに見舞われたのは今回が初めてではない。以前にも、俳優のラシュミカ・マンダンナとカジョルが、ネット上に出回ったディープフェイクに登場した。マンダンナの動画では、露出度の高いワンピ姿でエレベーターに乗り込むイギリス系インド人のソーシャルメディア・パーソナリティ、ザラ・パテルの顔に彼女の顔が重ねられていた。

こうしたAIが生成したビジュアルは、インターネット上のあらゆる追跡システムを弱体化させる能力を持っている。Lighthouz AIの共同設立者兼CEOであるクマールは、「これこそが、画像が本物か偽物かを判断することがほぼ不可能な理由です」と語った。

生成的なAIモデルを使うことで、良いものも悪いものも含めて、高品質のコンテンツを制作するコストは劇的に下がっている。「AIツールは、想像を絶する規模の操作を可能にします」と、eコマース・プラットフォームの偽レビュアーに取り組むデータサイエンスの手法を生み出したサイバースペースの専門家は言う。「AIツールは、想像を絶する規模の操作を可能にする。

もう1つのモデル、というより既存のAIツールの延長線上にあるのが、ディープフェイクの作成に使われるディープラーニングによるテキストから画像へのモデル、stable diffusionである。

"これは完全にオープンソースで、最も適応性の高い画像生成ツールです "と、調査に携わった政府関係者(ただし、所属組織の秘密保持のため匿名を要求)は言う。"安定した拡散は、ディープフェイクを作るために欧米で大いに利用されていると考えられている。"

これまでのところ、ボリウッド俳優のディープフェイク動画が海外で生成されたものなのか、インドで作られたものなのか、捜査当局は明らかにしていない。警察が動画をブロックした一方で、インドの電子・IT省はX(旧ツイッター)やメタなどのソーシャルメディア・プラットフォームに対し、AIが生成したディープフェイクの拡散を規制するよう促している。

テクノロジーとの競争

ディープフェイク動画の検出・軽減ソリューションはあるのか?

「かなりの数がありますが、それらは予備的なもので、生成された画像や動画の多くの種類を考慮していません」とクマールは言う。

増加するディープフェイク検出/軽減ツールの中で最も人気があるのは、インテルのリアルタイム・ディープフェイク検出ツール(FakeCatcher)だ。このツールはスピードと効率に重点を置いている。インテルのハードウェアとソフトウェアを活用し、FakeCatcherはピクセル内の血流変化のような微妙な生理学的詳細を分析する。

人工知能の創造的な利用を目の当たりにしている。NurPhoto / Contributor

もうひとつはマイクロソフトのVideo Authenticator Toolで、これは動画や画像を分析し、それぞれに操作の可能性を示す信頼度スコアを提供する。このツールは、人間の目には見えないブレンドの境界の矛盾や微妙なグレースケール要素を識別することができると主張している。

捜査当局が直面している大きな課題のひとつは、新しい検出器が開発されるにつれて、それらの検出器からの検出を回避する方法を取り入れるために生成技術が進化することである。

「技術の進歩、アクセスの容易さ、コストの低下により、ディープフェイクを特定することはますます難しくなっています」とクマールは言う。「残念ながら、すぐに解決することはできない。

ウィルス対策ソフトやマルウェア対策ソフトのように、エンドユーザーはディープフェイクから守るために、自分のデバイスで同等のものを使わなければならないだろう、とクマールは言う。

ビクラム・シャルマ記者による

スペイン語訳:

29 Abr, 2024 13:06

PortadaIndia

Deepfake democracy: cómo la IA está perturbando las mayores elecciones del planeta

Los vídeos manipulados de apoyo político son demasiado sofisticados para discernirlos o rastrearlos. Los expertos afirman que el objetivo podría ser psicológico: debilitar al partido al que apoya el vídeo cuando los votantes descubren que es falso.

Foto superior: El cofundador de Alt News, Pratik Sinha, en su oficina de Calcuta, el 10 de marzo de 2022. Dibyangshu SARKAR / AFP

Las elecciones parlamentarias indias en curso, al igual que las de Estados Unidos, Pakistán e Indonesia, están siendo testigos del uso creativo de la inteligencia artificial. Algunos contenidos generados por IA, como las llamadas telefónicas a los votantes aparentemente de los candidatos pero en realidad por voces generadas por IA, son inofensivos. Otros, como los vídeos deepfake de estrellas de cine que aparentemente apoyan a un partido frente a otro, o del ministro del Interior del país abogando por la abolición de la discriminación positiva, son más siniestros.

Y la policía india está un paso por detrás de los "malos actores" del ciberespacio, incapaces de distinguir los deepfakes de los vídeos reales y de rastrear sus orígenes, con el único recurso de bloquearlos, cuando ya es demasiado tarde.

El término "deepfake" deriva de "deep learning" (aprendizaje profundo) y "fake" (falso), y se refiere a la manipulación digital de los medios de comunicación para sustituir la imagen de una persona por la de otra.

Hace casi dos semanas, aparecieron vídeos de las estrellas de Bollywood Aamir Khan y Ranveer Singh criticando al Primer Ministro Narendra Modi y pidiendo a la gente que votara al opositor Partido del Congreso. Los actores no tardaron en quejarse a la sección de ciberdelincuencia de la policía de Bombay, pero para entonces los vídeos ya habían sido vistos más de medio millón de veces.

Medio millón puede no parecer mucho, dado que YouTube, propiedad de Google, tiene 462 millones de usuarios en la India, y el electorado es de 968 millones. Hay 900 millones de internautas, según una encuesta del Esya Center y el IIM (A); de media, cada uno pasa 194 minutos al día navegando por las redes sociales.

Sin embargo, como dijo a RT la ciberpsicóloga y conferenciante de TEDx Nirali Bhatia, gracias a las redes sociales, cada uno se formará sus propias opiniones y juicios al respecto, lo que puede ser mucho más perjudicial.

RT

Votantes hacen cola para depositar su voto en un colegio electoral durante la segunda fase de votación de las elecciones generales de la India en Bengaluru el 26 de abril de 2024. Idrees MOHAMMED / AFP

El poder de la psicología inversa

El psefólogo Dayanand Nene explica que los vídeos deepfake pueden influir en la opinión pública y desacreditar a personas y políticos. "Los deepfakes explotan varias vulnerabilidades psicológicas", explica a RT.

Los seres humanos tienen una tendencia natural a confiar en lo que ven y oyen, y los deepfakes aprovechan esto creando contenidos realistas". "Además, los sesgos cognitivos como el sesgo de confirmación -por el que somos más propensos a creer la información que confirma nuestras creencias preexistentes- nos hacen susceptibles a los deepfakes que se alinean con nuestros puntos de vista", dijo Nene.

El domingo, por ejemplo, la policía de Delhi tuvo que registrar un caso tras descubrirse un vídeo manipulado en el que se veía al ministro del Interior, Amit Shah, abogando por la abolición de las cuotas educativas y laborales para los más desfavorecidos de la India, los dalits y las castas "atrasadas". Se trataba de un deepfake, manipulado a partir de un discurso que pronunció en el estado de Telangana, en el sur de la India, y se hizo viral.

El elevado número de visitas se debió a la curiosidad, según Bhatia, ya que los famosos siguen siendo mucho más populares que los influencers. Además, los deepfakes funcionarán como psicología inversa, afectando negativamente al partido al que apoyan una vez que se sepa que son deepfakes.

"En mi opinión, ese era el objetivo de estos vídeos", afirma Bhatia, que estudia el impacto de la tecnología en el comportamiento humano. "Los votantes inteligentes pueden entender la verdadera agenda, pero una mayoría actúa por sentimiento y no por decisión racional".

RT

Una mujer vestida con el atuendo del Partido Bharatiya Janata (BJP) toma fotos con su teléfono móvil durante una reunión del partido BJP en Mumbai, India, el 21 de febrero de 2024. Indranil Aditya/NurPhoto vía Getty Images

Los deepfakes trasladan la atención del "contenido" a la "intención" en la creación de estas falsificaciones. "Y eso es lo que influirá", afirma Bhatia, fundador de CyberBAAP (Cyber Bullying Awareness, Action and Prevention).

La investigación ha resultado ser todo un reto. La policía, que habla bajo condición de anonimato, afirma que es difícil diferenciar las falsificaciones de la realidad. Los deepfakes son de bajo coste, fáciles de hacer y difíciles de rastrear, lo que da a los malos actores "vía libre".

Según los funcionarios que colaboran en la investigación, se cree que los creadores de los vídeos deepfake utilizaron el modelo de difusión, una herramienta de inteligencia artificial que permite a los delincuentes explotar los vídeos disponibles en las redes sociales. "La herramienta les permite recrear casi cualquier cosa", dijo un funcionario a RT.

Entrenamiento de la IA

El modelo de difusión genera imágenes únicas aprendiendo a eliminar el ruido y reconstruir el contenido. ¿Cómo funciona?

El informático Srijan Kumar, premiado por su trabajo sobre la seguridad y la integridad de las redes sociales, explicó que, dependiendo de lo que se le pida, un modelo de difusión puede crear imágenes y tomas increíblemente imaginativas basándose en las propiedades estadísticas de sus datos de entrenamiento, todo ello en cuestión de segundos.

"Antes había que superponer caras individuales, lo que llevaba mucho tiempo", explica Kumar. "Ahora, con el modelo de difusión, se pueden generar varias imágenes con un solo comando. No requiere muchos conocimientos técnicos".

En los vídeos de Aamir Khan y Ranveer Singh, los dos actores dicen supuestamente que Modi no cumplió sus promesas electorales y no abordó cuestiones económicas críticas durante sus dos mandatos.

En cuanto salió a la luz el vídeo de Singh, el 17 de abril, la portavoz del Congreso, Sujata Paul, lo compartió con sus 16.000 seguidores en X. Posteriormente, su publicación fue compartida 2.900 veces y recibió 8.700 me gusta. El vídeo recibió 438.000 visitas.

RT

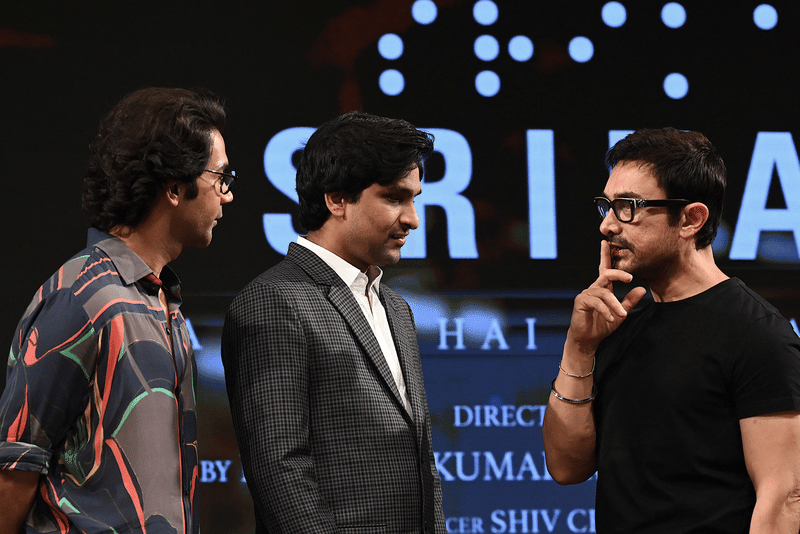

El actor de Bollywood Aamir Khan, el industrial indio Srikanth Bolla con el actor Rajkummar Rao asisten al lanzamiento de la canción de la próxima película biográfica en hindi 'Srikanth' en Mumbai el 22 de abril de 2024. © SUJIT JAISWAL / AFP

No es la primera vez que Bollywood se ve afectado por deepfakes. Anteriormente, las actrices Rashmika Mandanna y Kajol aparecieron en deepfakes que circulaban por Internet. En el vídeo de Mandanna, su cara se superponía a la de la personalidad británica-india de las redes sociales Zara Patel, que entraba en un ascensor con un body muy revelador.

Estas imágenes generadas por la inteligencia artificial son capaces de socavar cualquier sistema de rastreo en Internet. "Precisamente por eso es casi imposible determinar si una imagen es real o falsa", afirma Kumar, cofundador y consejero delegado de Lighthouz AI.

Gracias a los modelos generativos de IA, el coste de producir contenidos de alta calidad, tanto buenos como malos, se ha reducido drásticamente. "Las herramientas de IA permiten la manipulación a una escala inimaginable", afirmó el experto en ciberespacio, que ha creado métodos de ciencia de datos para hacer frente a los falsos reseñadores en plataformas de comercio electrónico. "Desempeña un papel clave en la creación de contenidos de aspecto realista pero totalmente fabricados y desinformativos".

Otro modelo, o más bien una extensión de la herramienta de IA existente, es la difusión estable, un modelo de aprendizaje profundo de texto a imagen utilizado para crear deepfakes.

"Es completamente de código abierto y el generador de imágenes más adaptable", dice un funcionario del gobierno involucrado en la investigación (pero que exigió el anonimato debido al secreto de su organización). "Se cree que la difusión estable está siendo muy utilizada en Occidente para crear deepfakes".

Hasta ahora, los investigadores no tienen claro si los vídeos deepfake de actores de Bollywood se generaron en el extranjero o se hicieron en la India. Mientras la policía bloqueaba los vídeos, el Ministerio de Electrónica e Informática indio ha instado a plataformas de redes sociales como X (antes Twitter) y Meta a regular la proliferación de deepfakes generados por IA.

A la carrera con la tecnología

¿Existen soluciones de detección y mitigación para los vídeos deepfake?

"Bastantes, pero son preliminares y no tienen en cuenta los muchos tipos de imágenes y vídeos generados", afirma Kumar.

Entre las herramientas de detección y mitigación de deepfakes más populares se encuentra el detector de deepfakes en tiempo real de Intel (FakeCatcher). Se centra en la velocidad y la eficacia. Utilizando el hardware y el software de Intel, FakeCatcher analiza detalles fisiológicos sutiles como las variaciones del flujo sanguíneo en píxeles.

RT

Las actuales elecciones parlamentarias indias, al igual que las de Estados Unidos, Pakistán e Indonesia, están siendo testigo del uso creativo de la inteligencia artificial. © NurPhoto / Colaborador

Otra es la herramienta Video Authenticator de Microsoft, que analiza vídeos e imágenes y proporciona para cada uno una puntuación de confianza que indica la probabilidad de manipulación. Afirma identificar incoherencias en los límites de la mezcla y elementos sutiles de la escala de grises que son invisibles al ojo humano.

Uno de los principales retos a los que se enfrentan los investigadores es que, a medida que se desarrollan nuevos detectores, la tecnología generativa evoluciona para incorporar métodos que permitan eludir la detección de esos detectores.

"Cada vez es más difícil identificar deepfakes con el avance de la tecnología, la facilidad de acceso y el abaratamiento de los costes", afirma Kumar. "Por desgracia, no hay una solución inmediata a la vista".

Dice que, al igual que el software antivirus y antimalware, los usuarios finales tendrán que utilizar equivalentes en sus dispositivos para protegerse contra los deepfakes.

Por Vikram Sharma, reportero general

原文:

29 Apr, 2024 13:06

HomeIndia

Deepfake democracy: How AI is disrupting the biggest election on Earth

Manipulated videos of political endorsements are too sophisticated to discern or track. Experts say the intent might be reverse psychology – to undermine the party the video endorses, once voters discover it is fake

Photo top: Alt News co-founder Pratik Sinha in his office in Kolkata, March 10, 2022. © Dibyangshu SARKAR / AFP

The ongoing Indian parliamentary elections, like those in the US, Pakistan, and Indonesia, are witnessing the creative use of artificial intelligence. Some AI-generated content, such as phone calls to voters apparently from candidates but actually by AI-generated voices, is harmless. Others, like deepfake videos of film stars ostensibly endorsing one party over another, or of the country’s home minister advocating for abolishing affirmative action, are more sinister.

And India’s keystone cops are one step behind cyber-space’s ‘bad actors’, unable to discern deepfakes from real videos and unable to trace their origins, left with the sole recourse of blocking them – by which time it’s too late.

The term ‘deepfake’ derives from ‘deep learning’ and ‘fake’, and signifies the digital manipulation of media to substitute one person’s image with another’s.

Nearly two weeks ago, videos surfaced of Bollywood stars Aamir Khan and Ranveer Singh criticizing Prime Minister Narendra Modi and asking people to vote for the opposition Congress Party. The actors wasted no time in complaining to the Mumbai police cyber-crime wing – but by then, the videos had been viewed more than half a million times.

Half a million may not seem like much, given that Google-owned YouTube has 462 million users in India, and the electorate is 968 million. There are 900 million internet users, according to a survey by the Esya Center and IIM (A); on average, each spends 194 minutes a day surfing social media.

However, as cyber-psychologist and TEDx speaker Nirali Bhatia told RT, thanks to social media, everyone will form their own opinions and judgments on the matter – which can be far more damaging.

RT

Voters queue to cast their ballots at a polling station during the second phase of voting of India's general election in Bengaluru on April 26, 2024. © Idrees MOHAMMED / AFP

Power of reverse psychology

Psephologist Dayanand Nene explains that deepfake videos can influence public opinion and discredit people and politicians. “Deepfakes exploit several psychological vulnerabilities,” he told RT.

Humans have a natural tendency to trust what they see and hear, and deepfakes leverage this by creating realistic content. “Moreover, cognitive biases such as confirmation bias – where we are more likely to believe information that confirms our pre-existing beliefs – make us susceptible to deepfakes that align with our viewpoints,” Nene said.

For example, the Delhi police on Sunday had to register a case after a doctored video was found in which Home Minister Amit Shah was seen advocating for the abolition of education and job quotas for India’s unprivileged – Dalits and ‘backward’ castes. It was a deepfake, manipulated from a speech he gave in the southern Indian state of Telangana, and it went viral.

The high number of views was due to curiosity, Bhatia felt, since celebrities are still far more popular than influencers. Moreover, the deepfakes will work as reverse psychology – negatively impacting the party being endorsed once it becomes clear they are deepfakes.

“In my opinion, that was the agenda of these videos,” Bhatia, who studies the impact of technology on human behavior, said. “The intelligent voters may understand the true agenda but a majority act on sentiment rather than on rational decision.”

RT

An woman wearing Bharatiya Janata Party (BJP) attire is taking photos with her mobile phone during a BJP party gathering in Mumbai, India, on February 21, 2024. © Indranil Aditya/NurPhoto via Getty Images

Deepfakes transfer attention from ‘content’ to ‘intent’ in creating these fakes. “And that’s what will be the influencing factor,” Bhatia, the founder of CyberBAAP (Cyber Bullying Awareness, Action and Prevention), said.

The investigation has proven to be challenging. Police speaking on condition of anonymity say it is difficult to differentiate fakes from reality. Deepfakes are low-cost, easy to make, and difficult to track, giving bad actors ‘a free run’.

According to government officials assisting the high-profile investigation, the creators of the deepfake videos are believed to have used the diffusion model, an AI tool that allows bad actors to exploit videos available on social media sites. “The tool enables them to recreate just about anything,” an official told RT.

Training AI

The diffusion model generates unique images by learning how to de-noise and reconstruct the content. So how does it work?

Computer scientist Srijan Kumar, awarded for work on social media safety and integrity, explained that depending on the prompt, a diffusion model can create wildly imaginative pictures and shots based on the statistical properties of its training data – all in a matter of seconds.

“In the past, individual faces had to be superimposed, which was a time-consuming process,” Kumar said. “Now, with the diffusion model, multiple images can be generated with a single command. It does not require much technical knowledge.”

In the Aamir Khan and Ranveer Singh videos, the two actors purportedly say Modi failed to keep campaign promises and failed to address critical economic issues during his two terms.

The moment Singh’s video surfaced on April 17, Congress spokesperson Sujata Paul shared it with her 16,000 followers on X. Thereafter, her post was shared 2,900 times and liked 8,700 times. The video received 438,000 views.

RT

Bollywood actor Aamir Khan, Indian industrialist Srikanth Bolla with actor Rajkummar Rao attend the song launch of upcoming Hindi-language biographical film ‘Srikanth’ in Mumbai on April 22, 2024. © SUJIT JAISWAL / AFP

This is not the first time Bollywood has been hit by deepfakes. Earlier, actors Rashmika Mandanna and Kajol figured in deepfakes circulating online. In Mandanna’s video, her face was superimposed on that of British-Indian social media personality Zara Patel, who was entering an elevator in a revealing onesie.

These AI-generated visuals have the ability to undermine any tracking systems on the internet. “This is precisely why it’s nearly impossible to determine whether an image is real or fake,” Kumar, the co-founder and CEO of Lighthouz AI, said.

Using generative AI models, the cost of producing high-quality content, both good and bad, has come down drastically. “AI tools enable manipulation on an unimaginable scale,” said the cyberspace expert, who has created data science methods to tackle fake reviewers on e-commerce platforms. “It plays a key role in creating realistic looking but entirely fabricated and misinformative content.”

Another model, or rather an extension of the existing AI tool, is stable diffusion, a deep-learning text-to-image model used to create deepfakes.

“It is completely open-source and the most adaptable picture generator,” says a government official involved in the investigation (but who demanded anonymity due to his organization’s secrecy). “It’s believed that stable diffusion is being heavily relied upon in the West to create deepfakes.”

So far, investigators are unclear whether the deepfake videos of Bollywood actors were generated abroad or were made in India. While police blocked the videos, India’s Ministry of Electronics and IT has urged social media platforms such as X (formerly Twitter) and Meta to regulate the proliferation of AI-generated deepfakes.

Racing with technology

Are there detection and mitigation solutions for deepfake videos?

“Quite a few, but they are preliminary and do not account for the many types of generated images and videos,” Kumar said.

The most popular among the increasing deepfake detection/mitigation tools include Intel’s Real-Time Deepfake Detector (FakeCatcher). It focuses on speed and efficiency. Utilizing Intel hardware and software, FakeCatcher analyzes subtle physiological details like blood flow variations in pixels.

RT

The ongoing Indian parliamentary election, like elections in the US, Pakistan and Indonesia, is witnessing the creative use of artificial intelligence. © NurPhoto / Contributor

Another is Microsoft’s Video Authenticator Tool, which analyzes videos and images, and provides for each a confidence score that indicates the likelihood of manipulation. It claims to identify inconsistencies in blending boundaries and subtle grayscale elements that are invisible to the human eye

One of the major challenges the investigators face is that as new detectors are developed, the generative technology evolves to incorporate methods to evade detection from those detectors.

“It’s getting harder and harder to identify deepfakes with the advancement of technology, the ease of access, and the lower cost,” Kumar says. “Unfortunately, there is no immediate resolution in sight.”

He says that like anti-virus and anti-malware software, end users will have to use equivalents on their devices to protect against deepfakes.

By Vikram Sharma, reporter-at-large

この記事が気に入ったらサポートをしてみませんか?