Sakana AI, Small Language Model(SLM), AIコンステレーション

先日Sakana AIがシードラウンドで45億円の資金調達とのニュースがあった。 Lux Capitalとkhosla venturesがリードVCとして出資、日本のリードはNTTグループというシードとしては日本では聞かない米国並みの大型資金調達だ。拠点が日本でも資金を集められる人材であれば集まるということか。

Sakana AIについては、こちらの記事を読むとわかりやすく、以下抜粋。

Sakana AIはAI開発を手掛けるスタートアップで2023年に設立。元米Google(グーグル)の研究者だったDavid Ha(デイビッド・ハ)CEO(最高経営責任者)、生成AIの発展を支える「Transformer」に関する論文の共同執筆者であるLlion Jones(ライオン・ジョーンズ)CTO(最高技術責任者)が中心となって日本で創業した。

多数の小型AIを分散的に利用し、それらのAI同士を効率的に連携することで、電力と計算資源の消費抑制を狙うAIコンステレーションの実現を目指す。

創業者の経歴も凄いが、今回はその事業のコア技術となる小型AI(SLM)について注目したいと思う。

そもそもLLMとは名前の通り大規模言語モデルであり、スケーリング則に従い、大規模なモデルを学習する程、性能の高いモデルが構築できるという思想から発展し、ChatGPTにまで至った。詳しくはこちら。一方で、Sakana AIが課題視しているように、電力と計算資源の消費が大きく、OpenAI, Google, Microsoftの様な資金力と計算資源を持つプレイヤーが独占する状況になっている。

この様なLLMの課題への解決策の1つとしてSmall Language Model(SLM)がある。SLMの特徴として、少ない学習データ、小さなパラメータ数でありながら、ひと昔前のLLMに迫る性能があることだ。メリットとして、少ない学習データと、パラメータ数であることで、学習期間が減り、電力、計算資源の消費を抑え、誰もが学習・扱うことができるLLMの民主化に繋がる。また、モデルサイズが小さければモバイルデバイスなど計算能力が低くてもLLMを扱うことができ、活用の幅が広がることが想定される。

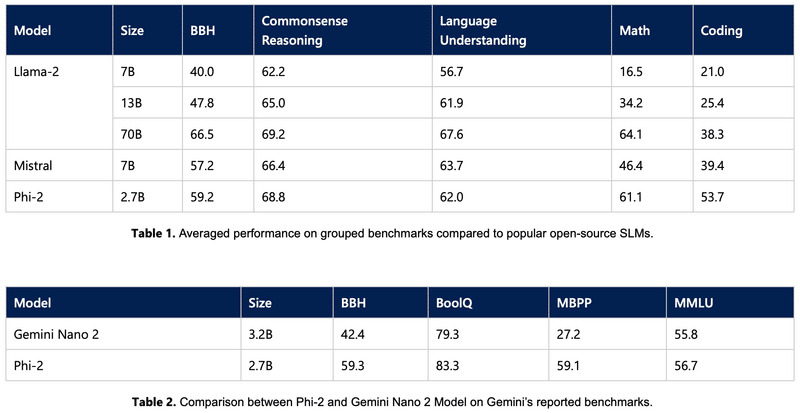

そのSLMですがSakana AIだけでなく、Big Techも注目しており、次々とSLMを発表している。GoogleのGemini Nanoが発表された1週間後にはMicrosoftがPhi-2を発表するなど、既に競争が起きている。MicrosoftのPhi-2のプレスを見てみると性能が比較されているが、2.7Bと非常に小さいサイズでありながら、Llama2 70Bと引けを取っていない。Microsoftはテキスト本レベルの質の高い学習データを選定することで高い性能を達成している。

この様に高性能なSLMの開発は進んでいる一方で、AIコンステレーションというアイデア自体はまだ未知数であり、SLM同士を繋ぐことでどの様な性能に発展するかとても興味深い。LLMの元は脳のニューロンを模したDeepLearningから来ていると考えると、繋ぎ合わせるというアイデアはとても相性がいいのではないだろうか。東京を拠点とするSakana AIがOpen AIの様に世界にインパクトを与える日が楽しみだ。

この記事が気に入ったらサポートをしてみませんか?