【論文解説】LCM-LoRA: 高速で高品質な画像生成を可能にする汎用的な潜在一貫性モデル

はじめに

Latent Diffusion Models (LDMs) は高品質な画像生成を可能にしますが、生成プロセスに多くの時間を要するという問題があります。

この問題に対して、Latent Consistency Models (LCMs) が提案され、事前学習済みの LDMs から蒸留されたモデルを用いて、少ないステップ数で高品質な画像生成を実現しています。

今回は、LCMs をさらに発展させた手法である LCM-LoRA を紹介します。LCM-LoRA は、Stable Diffusion モデルに適用することで、高速かつ高品質な画像生成を可能にする汎用的な手法です。

https://arxiv.org/abs/2311.05556

LCM-LoRA の概要

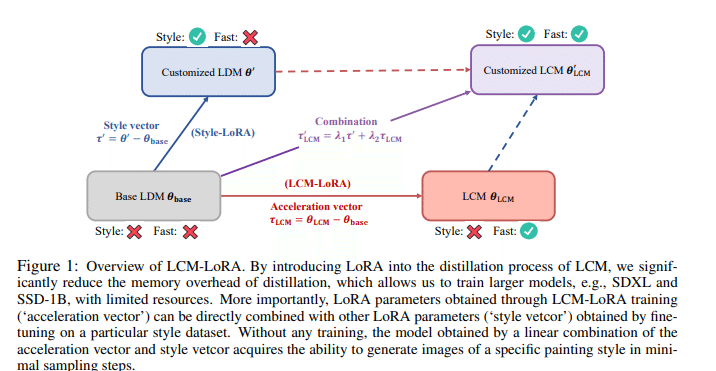

LCM-LoRA は、以下の特徴を持つ汎用的な高速化モジュールです。

LoRA (Low-Rank Adaptation) を用いて LCMs の学習を行い、メモリ消費量を大幅に削減

SD-V1.5, SSD-1B, SDXL などの大規模な Stable Diffusion モデルに適用可能

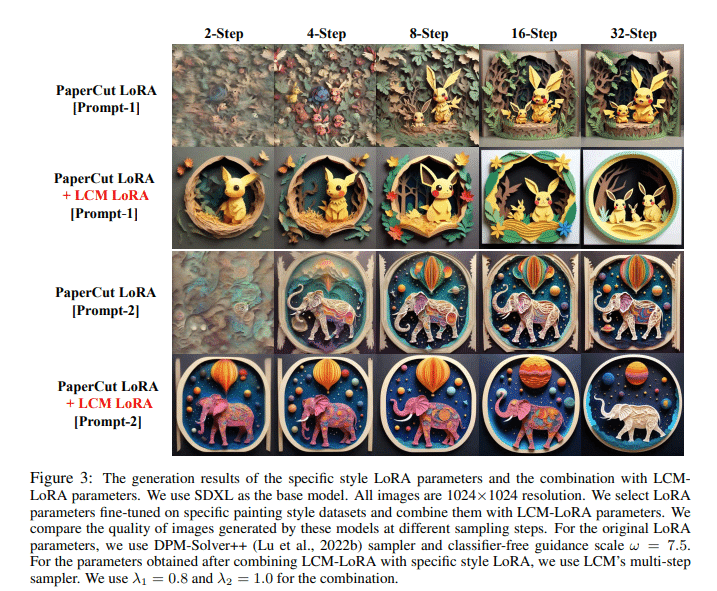

LCM Distillationで得られた LoRA パラメータ(加速ベクトル)を、様々な fine-tuned モデルや LoRA に直接組み込み可能

特定のスタイルデータセットで fine-tuning した LoRA パラメータ(スタイルベクトル)と組み合わせることで、追加学習なしに、最小限のステップで特定のスタイルの画像を生成可能

LoRA Distillationの効果

LoRA Distillationは、LCMs の学習を効率化し、大規模モデルへの適用を可能にします。

LoRA により学習対象のパラメータ数が大幅に減少し、メモリ使用量を抑えられるため、SD-V1.5 よりも大規模なモデルである SSD-1B や SDXL に対して LCM の学習が可能になります。

また、事前学習済みモデルの表現力を維持しつつ、LCM に必要な調整を加えられるため、高速化を達成できます。

Classifier-Free Guidance の効果

LCM-LoRA の蒸留プロセスでは、Classifier-Free Guidance (CFG) を用いることで、生成画像の品質を向上させています。CFG は広く使用されている手法であり、LCM-LoRA においてもその有効性が確認されています。

実験結果と評価

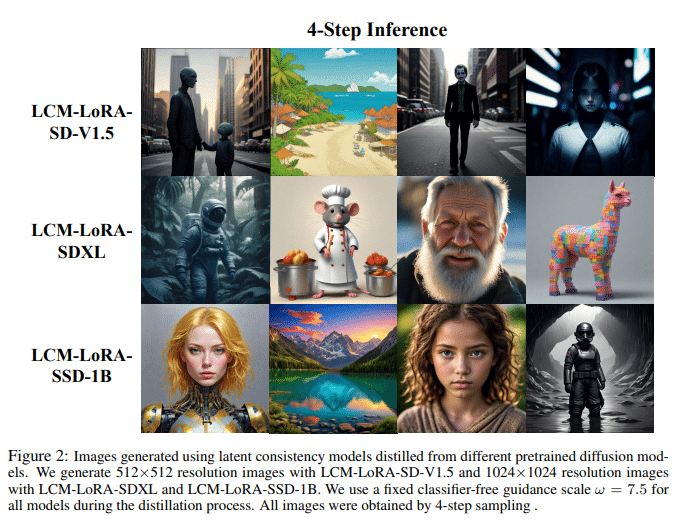

論文では、様々な Stable Diffusion モデルに対して LCM-LoRA を適用し、高品質な画像生成結果を示しています。

SD-V1.5 では 512×512 の解像度で、SSD-1B と SDXL では 1024×1024 の解像度で画像生成を行っています。生成された画像のサンプルを示すことで、LCM-LoRA の性能を定性的に評価しています。

ただし、FID や IS などの定量的評価指標を用いた性能比較は行われていません。

おわりに

LCM-LoRA は Stable Diffusion モデルを高速化する手法で LCMs を LoRA で蒸留します。

その結果、LoRA ならではのポータビリティとコンポーザビリティを手に入れました。

LCM-LoRA は、LCMが成し遂げたProbability Flow ODEの予測をニューラルネットワークベースで可能にしました。

フォローしてください。

https://twitter.com/tamanobi

この記事が気に入ったらサポートをしてみませんか?