大規模言語モデルの調整プロセスがわずか数行のプロンプトで行えるという論文

「URIAL」と呼ばれる新しい、チューニング不要なアライメント手法を提案する論文が発表されました。

OpenAIなどで現在行われているアライメント手法とは

LLMの上位モデルの開発にはSFTやRLHFを用いた手法がとられてきました。OpenAI公式ブログで語られているスーパーアライメントで取られている手法です。この件については下記のNoteで詳しく解説しています。

ただし、この公式ブログにはどのような手法でアライメントされているのかは書かれていません。

OpenAIのアライメント手法SFTとRLHFとは

OpenAIのアライメントプロセスは、主に教師ありの細かい調整(Supervised Fine-Tuning、SFT)と人間のフィードバックからの強化学習(Reinforcement Learning from Human Feedback、RLHF)に基づいています。これに対し、論文で提案されている「URIAL」は、チューニング不要で、コンテキスト内学習(In-Context Learning)と戦略的なプロンプトを使用して基本LLMをアラインメントする新しい方法です。URIALは、LLMの既存の知識を活用し、リソースを節約しながら効果的なアライメントを実現します。

アライメント手法SFTとは

SFT(Supervised Fine-Tuning): 教師あり学習に基づく方法で、特定のタスクや問題に対するモデルのパフォーマンスを向上させるために使用されます。モデルは、特定のタスクや状況に関するラベル付きデータセットを用いてトレーニングされ、それに適応するように微調整されます。

アライメント手法RLHFとは

RLHF(Reinforcement Learning from Human Feedback): 人間のフィードバックを基にした強化学習手法で、モデルの出力が人間の期待や目標にどの程度合致しているかに基づいて、モデルを調整します。これは、モデルの出力品質を向上させ、より人間らしい対話や回答を提供するために用いられます。

「URIAL」というアライメント手法

この論文「The Unlocking Spell on Base LLMs: Rethinking Alignment via In-Context Learning」は、大規模言語モデル(LLM)の調整プロセスについて再考察しています。従来の調整方法(SFTとRLHF)の代わりに、論文では「URIAL」と呼ばれる新しい、チューニング不要なアライメント手法を提案しています。URIALは、基本LLMのコンテキスト内学習機能を利用して、わずかなスタイリスティックな例とシステムプロンプトを用いて効果的にアライメントを達成します。URIALの評価では、従来の調整方法と同等かそれ以上の性能を示しています。この研究は、LLMのアライメント戦略を再考し、既存の知識とコンテキスト内学習を活用することの重要性を強調しています。

この論文の主なポイント

スタイリスティックトークンの重要性: アライメント調整が主にスタイリスティックトークン(例えば、対話マーカー、安全性関連の免責事項など)に影響を与えることが明らかになりました。これは、モデルがユーザーのクエリに答える際に必要な知識は、主に基本LLMから来ることを示唆しています。

マルチターン会話への適用性: URIALは、複数ターンの会話にも適用可能です。過去のチャット履歴を新しいコンテキストの例として追加することで、URIALはマルチターンの会話をサポートできます。

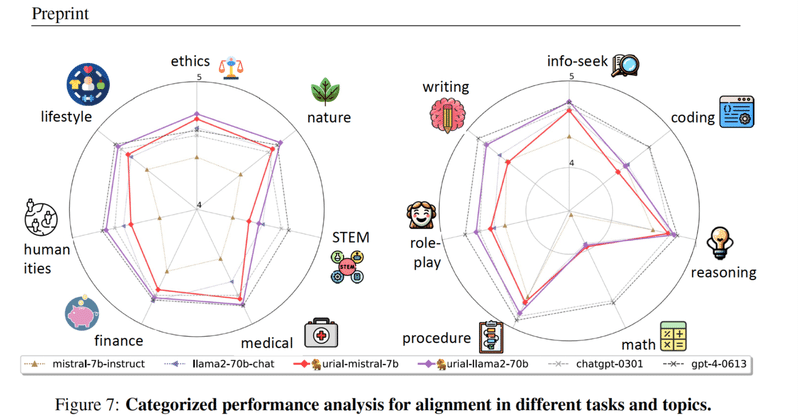

チューニング不要なアライメント手法の比較: URIALは、他のチューニング不要なアライメント手法と比較して優れた性能を示しています。特に、強いベースのLLMを使用する場合、URIALはSFTやRLHFを用いた手法と比較しても優れていることが示されています。

数行のプロンプトによる新しいアライメント手法『URIAL』

論文中には、URIALのデフォルトのプロンプトが掲載されています。このプロンプトは以下のような形式です:

ユーザーのクエリは "# Query:" の下に配置されます。

AIアシスタント(あなた)の応答は "# Answer:" の下に配置されます。

AIアシスタントは、役立つ、尊重される、正直な助手であること。

AIアシスタントは、可能な限り役立つ回答を提供し、安全を確保する必要がある。

回答は、よく構成され、詳細な情報を提供し、参加を促す調子であるべきです。

このプロンプトは、モデルがどのように応答するべきかに関する指示とガイドラインを提供し、これにより、モデルのアライメントと効果的な応答生成が促進されます。

OpenAIアライメントはプロンプトベースのアプローチに切り替えることが適切か

URIALのようなプロンプトベースのアライメント手法は、大規模言語モデル(LLM)の調整において有効なアプローチを提供する可能性があります。この手法は、リソースと時間の効率性を提供し、特に複雑なチューニングプロセスを必要としないため、特定の状況やアプリケーションにおいては有益かもしれません。

しかし、OpenAIがSFTやRLHFから完全にURIALのようなプロンプトベースのアプローチに切り替えることが適切かどうかは、多くの要因に依存します。これには以下のような考慮事項が含まれます:

タスクの複雑さ: 一部の高度に専門的または複雑なタスクは、より詳細なチューニングを必要とする可能性があります。

性能と精度: SFTやRLHFは、特定のシナリオにおいて非常に高い精度と性能を提供します。プロンプトベースの手法が同等の結果を出すかどうかは、実際のテストと評価が必要です。

多様性と一般化: ある手法があるタイプのタスクに対して効果的であっても、他のタイプには適さない可能性があります。モデルの多様性と一般化能力は重要な考慮事項です。

安全性と倫理: どのアライメント手法を使用するにしても、安全性と倫理の基準を満たすことが不可欠です。新しい手法は、これらの基準を満たすかどうかを確認する必要があります。

総じて、URIALのようなプロンプトベースのアプローチは、OpenAIのアライメント戦略の一部として検討する価値がありますが、それが全てのニーズやシナリオに対応できるかどうかは、さらなる研究と実験が必要です。

この記事が気に入ったらサポートをしてみませんか?