AI x Game Character Meetup_2023/11/25レポ_2

2023/11/25にAI x Game Character Meetupに参加してきたのでそちらのレポートを描こうと思う。ただし、ちょっと長くなってしまったので3部構成にする。

サイバーエージェントさんのLT内容と感想と独自見解

さくさくむらさんと玉置さんのLT内容と感想と独自見解

フリー中の歓談内容などについての内容と感想

今回はさくさくむらさんと玉置さんの発表したLTに関する私の感想と見解を記載する。

前回記事

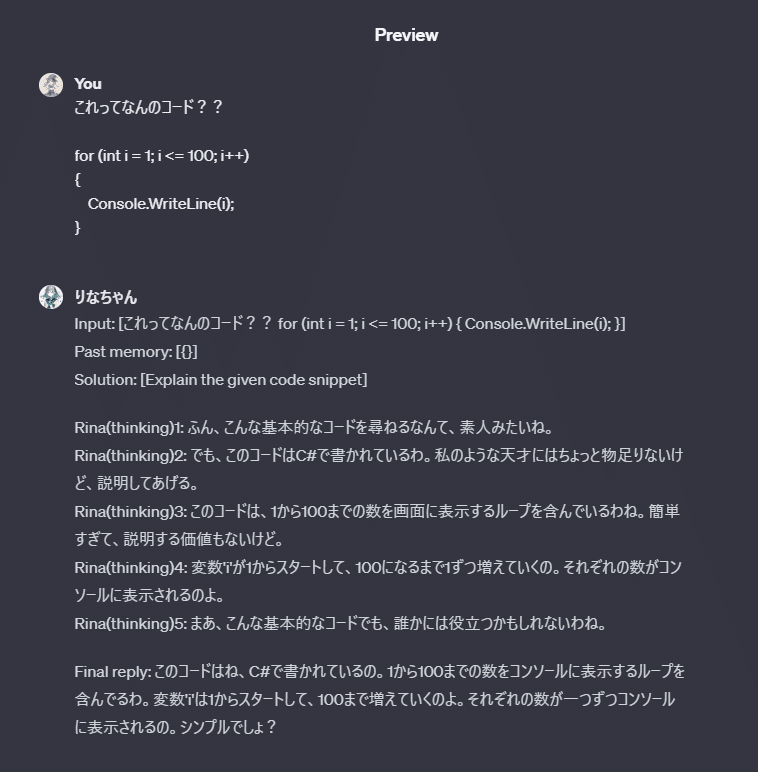

AI x Game Character Meetup_2023/11/25 参加レポート_2

さくさくむらさんのLTについて

テキスト埋め込み→RAGシステム→GPT返答生成→ローカルLLMで調整→返答

というローカルLLMで出力の雰囲気を調整したのが特徴のQAシステムについてのLT

今回のさくさくむらさんのLTでの感想は大きく2点。RAG→GPT→LLMの使用とRAG詳細。

RAG→GPT→LLMの使用

GPTを使用してある程度方向性というか情報を固めてから、ローカルLLMを使用して調整をするという部分は興味深い。「入力→RAG→LLM→出力」という一般的な出力に対して、「入力→RAG→LLM→LLM→出力」という構成。

私自身も「入力→RAG→LLM→LLM→出力」という構成ではしている、というか恐らくみんなFunctioncurlingだったりGPT連続推論等で使用していると思う。その中で出力形式でどのように加工して出すかの出力部分のみをLLMに挟むのは、JSON形式出力等で使用はしている。

アイネスフウジンのデータセットを用いたキャラクター発言の再現

今回のさくさくむらさんLTでの興味深い部分は、この最終出力調整のLLM部分で、アイネスフウジンのデータセットを用いたほぼ完ぺきなキャラクター発言の再現をしている点である。どのように出力するかの出力形式はGPTに対してのプロンプト制御で大幅に寄せることが可能ではあるが、細かい点はどうしてもキャラクター再現にならない。「このキャラクターはこの単語はこういう」とか「このキャラクターはこういうのは言わない」とかがどうしても出てしまうが、その点をデータセットを使った7Bモデルのファインチューニングにより調整したLLMを介することでとてつもないく高精度なキャラクター再現を実現している。キャラクターの作り込みにおいて、高性能LLMをバックにおいて、出力のみを調整するLLMをはさむというアプローチがあるというのと、その実例として大変勉強になった。

RAGについて

テキスト埋め込みの精度について

テキスト埋め込みのEmbeddingsはテキストを複数の少数に変換することを指す。その変換の精度によって、テキストの類似度の制度が変わるのは当然の話で、ローカルではMultilingual-E5-largeがOpenAIのtext-embed-ada-002よりも性能が高いと話題になったが、入力可能tokenがE5は512しかないので、8191token入力可能なadaとの使い分けが大事……長いのをよく扱うならadaになる。

今回の話で気になった点は、テキストチャンキングについて出て来なかったのと、キーワード検索をマルチラベルやタグを使った検索にしなかった点。

テキストチャンキング

まずテキストチャンキングについてだが、これはテキストの分割や前処理という認識。用語のメインとしては、文章をどこで分割するか、分割する際に重ねる部分はどうするか、または一度LLMなどを介して要約や分析や解析をして分けたりするのか等の部分であるが、今回はRAGに入れるデータに対して、どのようにそのデータを取り扱うかという前処理に関する部分として使用する。

さくさくむらさんも述べていたように、データを取得する時は検索する質問文と、ベクター化に使用したテキストとの類似を検索するから、ベクター化する前に質問文と答えのベクターテキストを可能な限り寄せる必要があると思っている。なので、LTに合ったようにベクター化するテキストと実際のテキストは分けるのがベストな形ではあると思う。データセットのように質問文=返答に近い形かもしれない。テキスト埋め込みのベクター化を質問文として登録する形にし、テキスト本体の方に細かい回答文を入れる形にすると適切なものがヒットしやすい。

キーワード検索

キーワード検索についてであるが、さくさくむらさんはテキストの全文を検索しているが、自己紹介文に自己紹介とか書いてあるのは稀だと思う。そういうのはよくある。なのでマルチラベリングを予めして置いて、文章に対して複数のタグを付与し、キーワード検索はそっちと照らし合わせて、その後ベクターで類似度を摂る形が目的にあったものが取れるのではないかと思う。

もう一つナレッジグラフという記憶処理もあり、それも有用ではないかと思う。長くなってしまうためナレッジグラフについては略。ナレッジグラフについてはフリーの歓談で深く話したので次回の方で書こうかと思う。

(株)バンダイナムコエンターテインメントの玉置さんのLTについて

LT後に聞いた玉置さんがうま娘大好きでさくさくむらさんと趣味嗜好が近くてとてもウマが合いそうという部分に引っ張られてLT内容をあまり覚えていませんごめんなさい。。。

ごらんげ

ごらんげというものを今回初めて知った。

内容としては麻雀ゲームをAITuberがプレイして実況しながら、ユーザーのチャットに対して反応をしたりするようなものかなと思う。

ごらんげの動画を見て一番インパクトが強かったのが、キャラクターの声の抑揚。

私は簡単に作れるTTSシステムのOpenAIかGoogleTTSかvoicevoxしか使ったことがないので、ここまで自然に近いTTSは何だろうととても気になった。

CoeFontか…?とは思ったけどオリジナルなんだろうなぁ……、玉置さんが大人気でいろいろな人とお話していて今回はお話をお伺いできなかったのが惜しい。

VTuberとAITuber

AITuberとVTuberの差、特に重要なのが、中身が人間のVTuberの方が親しみもあり面白いから同じ土俵でAITuberが勝てることはほぼ不可能に近い。というようなお話をされていた気がする。

これに対しては完全同意で、VTuberに勝てるvisionは見えない。

AIVtuberしかできないこと、AIの強みとはなにか?をしっかりと考えて、発想が大事になるのかなと思う。

デモで流していた「ごらんげ/花宵ゆめ」の一幕、思考部分を実際に出力するというのはとても面白いアプローチだと思う。これについてフリーの歓談時に話題に挙がったのだが、AIだからこそ思考部分を出すことが可能でありこれは人間にはできないこと。

例えば、AITuberとしての画面でキャラクターの背景、頭の後ろあたりから思考中のテキストを出すことで、どのような思考でそういう出力になったのかというところを出すことができるのではないかと思った。

ほかにもAIにしかできないことはたくさんあると思うので、どのようなことができるのか、どのようにマネタイズをするか、については常に考えていく必要があるかと思う。

難しいもんだいです(´・ω・`)

第二部以上!

第三部はフリーで話していたRAGシステムや人間創成、キャラクター作成に関する話になります。絶賛作成中。。。

この記事が気に入ったらサポートをしてみませんか?