AIとボードゲーム 2022年末

画像:zizou man, CC BY 2.0 https://creativecommons.org/licenses/by/2.0, via Wikimedia Commons

AIとボードゲームに興味のある皆様にはとても興味深い論文がこの1ヶ月の間に立て続けに2本Science誌で発表されました。

一本は「人間の上位プレイヤーレベルで『ディプロマシー/Diplomacy』をプレイすることができるAIを開発した」という論文。開発したのはFacebookが出資しているMeta AIのチーム。

Human-level play in the game of Diplomacy by combining language models with strategic reasoning

Bakhtin, A. et al. Science (2022)

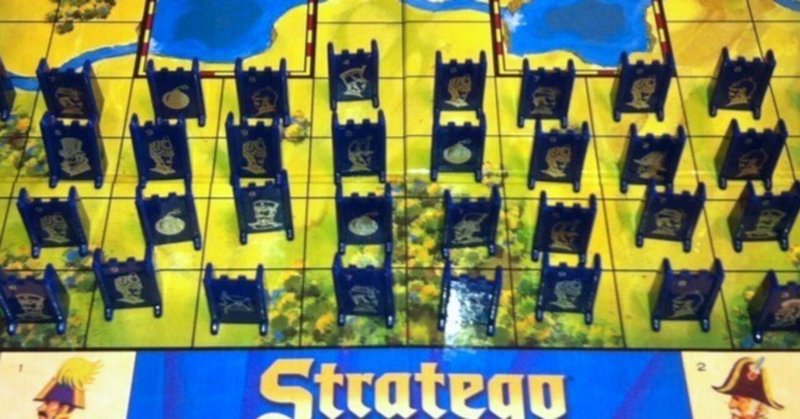

そしてもう一本は「既存のプログラムに圧勝し、人間の上位プレイヤーレベルで『ストラテゴ/Stratego』をプレイすることができるAIを開発した」と言う論文。こちらはAlphabetの子会社であり既に囲碁においてAlphaGoを開発したDeepMind Technologiesによるもの。

Mastering the game of Stratego with model-free multiagent reinforcement learning

Perolat, J. et al. Science (2022)

一応一通り論文に目を通しては見たものの、私はこの分野については素人なので(インターネットミームになっている慣用句としての用法ではなく、本当に素人に毛が生えたようなものなので)、正直手法の新規性や優位性についての評価はできません。が、その上でボードゲーマーの立場から気になる点についていくつか書いてみようと思います。詳しい方は是非コメントで補足や訂正をお願いいたします。

StrategoをプレイするAI

まずは(比較的)わかりやすい『ストラテゴ/Stratego』から。ストラテゴについて今更説明する必要もないと思いますが(などと言いながら後で改めて言及します)、モノポリーやリスクなどと並ぶ“古典的な”(≒ドイツゲーム以前の20世紀のゲーム)の一つであり、基本的には軍人将棋と似たゲームです。初期配置が不明でどの駒がどの能力を持っているかがわからない不完全情報ゲームの攻略、という意味で囲碁よりも更に挑戦的な取り組みである、と言ってよいでしょう。とはいえ、基本的には2人対戦のゼロサム・ゲームではありますから、AlphaGoの延長線上にあるとも言えます。教師なしのモデルフリーの強化学習をベースにしている部分もAlphaGoと一緒。事前情報のない状態からAI同士に対戦させて、負けた方のパラメータを変更していくという形でナッシュ均衡を目指すという手法。先行例のようにゲーム木を探索する方法では探索空間が大きすぎて現実的ではないので、ローカルな平衡点に収束させることを繰り返してナッシュ均衡を目指しているのが特徴でしょうか。選択肢が膨大な状況でも使用可能な学習という意味で先行AIよりも汎用性が高いように見えます。あるいは先行例で実績のある完全情報ゲームでもこのような手法を用いることで、計算量を減らしつつ同等の性能を達成できるならそういう意味でも面白そう……

閑話休題。

興味深いポイントは「教師データを必要としない(人の棋譜などを参考に学習したわけではない)」「AI同士の対戦の中で学習してナッシュ平衡を目指すことで“最善の手”を近似する」「対戦相手のモデルを作らない(例えば相手の駒の配置を推測しない)」といったところでしょうか。AlphaGoなどの既存のAIをより汎用的にして、不完全情報ゲームにおいても現実的に実行可能な学習方法を確立したもの、と理解しています。ただし2人対戦のゼロサムゲームである、という縛りは強力なので、これがマルチ対戦のゼロサムゲームや2人対戦の非ゼロサムゲームにまで拡張できるのか、というのが将来的な課題でしょうか。原理的にはいけそうな気がしますが、ある程度の複雑性を持ったマルチゲームだとプレイヤー数が増えるごとに加速度的に複雑になるでしょうから簡単ではないのでしょうね。直感的にはプレイヤー数が増えるとちょっとしたはずみで変なところに収束してしまうリスクが高まりそうな気がするんですが、その辺りも気になるところです。

論文中でも触れられていますが、学習した結果、AIが弱い駒で突っ込んだり(その結果相手に強い駒であると警戒させる)強い駒を前線から引いたり(その結果相手に弱い駒だと誤認させる)といった「はったり」や「偽装」のように見える手を打つのは面白いところ。もちろんだからといってAIが相手を誤解させるような“意図”を持っているわけではない、ということは言うまでもないことでしょうが(論文中にも同様の注意書きがあります)。また、既存の対戦プログラム(AIというよりはbot)に対してこのAIは圧倒的な勝率(8種類のプログラムに対して97~100%の勝率)を誇っていますが、数少ない負けは「対戦相手が博打的な手を打ってきて、稀に成功してそのまま押し切られることがあるため」であって、これ以上AIを改善しても負けが0になることはないだろう、と予想しています。このあたりは囲碁のような完全情報アブストラクトゲーム(かつ運の要素がない)とは異なるところですね。

DiplomacyをプレイするAI

We present Cicero, an AI agent that achieved human-level performance in the strategy game Diplomacy.

「DiplomacyをプレイするAI、その名はキケロ」ってところでもう最高なんですが。私だってヨーロッパの覇権を賭けてキケロと権謀術策を戦わせたいですよ!

それはさておき、既存の対戦ゲームのAIの発展形として理解できたStrategoのAIとは異なり、Diplomacyは極めて複雑で数値化しにくい(ように見える)ゲームです。またフリーフォームのプレイヤー間交渉の要素もあるため、単純に良い戦略を立てることができればよい、というものでもありません。実際、AI自体も教師なしモデルフリーであったStrategoのAIとは異なり、人間がプレイした棋譜・交渉ログをベースに学習し、手番ごとに対戦相手それぞれの意思決定モデルを構築して最善手を選択する形になっています。そういう意味ではなんとなくオールドスクールな、合目的的に設計されたAIであるように思えます。これに加えて、他のプレイヤーに“自然な”文章で意味のあるメッセージを送ることができる機能が必要で、これは既存の自然言語処理AIをベースにしたものを使っているようです。面白かったのは、こうした言語による交渉を含む“ゲーム”のAIを、囲碁やStrategoのようにAI同士で対戦することによって学習させることは難しい、というところですね。人間の言語をベースにして、交渉をAI同士で学習させると“人間の言語ではない意味不明の言語によって交渉を成立するAIになる”という先行事例があるようで、これめちゃくちゃ面白いので誰か解説してくれないですかね……。

というわけで、人間のプレイログをベースに、盤面と交渉履歴を踏まえて方針を策定し、それに従って自然に見えるメッセージを書いて送る、というAIを作成し、オンラインで人間プレイヤーに混ざってプレイさせたら上位にランクインする成績を残せた、という結果です。この結果をどう評価して良いのかよくわからないのですが、一緒にプレイした人間にもAIだとはわからなかったようで(一人だけ疑ったプレイヤーがいたそうですが)、かなりハイレベルなAIであることは間違いなさそうです。細かい情報がかなりSMに含まれているようなので(例えばメッセージを送るタイミングを決めるモジュールもあるようです)、余裕のある時にはそこまで読んでみたいところ。交渉の部分では稀に変なメッセージを送ってしまうこともあったようですが、実際には人間も勘違いをしたり変なメッセージを送ることもあるわけで、そこまで問題にはならなかったようです。時間制限がもっと緩い(1ターン5分のモードでプレイしていたようです)場合はより自然に振る舞う必要があるのではないか、とのことでした。

こちらのAIについては、戦術・戦略レベルのゲーム的な判断と、対人コミュニケーションという自然言語処理と、2つの要素が絡んでいてなかなか評価が難しいように思います。また、先述のように論文内でも言及がありますが、時間制限がある交渉ゲームでは特に多少変な挙動があったとしても人間プレイヤー側が「AIが優秀な人間プレイヤーである」と想定して行動するために結果的にAIに利することになった側面もあるのではないかと思います。また、マルチプレイヤーゲームでは、目立たない、ヘイトを逸らすと言った要素も重要で、人間的ではないからこそ却って好成績が残せる、という可能性もあるのかも……?また、成績の評価が基本的に一定ターンが経過した状態での補給地の占有率(厳密には各プレイヤーが支配している補給地の数を二乗して、その総和における比率)によって評価するため、そこに絞って最適化したプレイをする方が成績は良くなるだろうな、と思います(人間プレイヤーは必ずしもその目的に最適化できていないと思うので)。

ゲーマーとして思うこと

もちろん面白い、んですが、これが欲しいかと言われるとよくわからない。私にとってゲームというのは勝つためにプレイするというよりは、勝敗が決するまでの過程を楽しむためのものであるし、勝敗というのはプレイヤーそれぞれが勝利を目指すという共通目標を持つことで場の楽しさが最大化するためのツール、だと思っているので、すごく強いAIがあったところで私個人の楽しさには寄与しないだろうと思うわけです。一方で、近年のユーロスタイルのボードゲームには「システムをどこまで攻略できるかをプレイヤー間で競う」という間接的な競争として設計されている側面があって、そういう意味ではAIと競うことでもゲームの楽しみのかなりの部分(上達や発見など)が味わえるのではないかとも思っています……でもそれならもっと複雑なSLGでも良くない?みたいな気もしてしまうわけです。より純粋な競技的ゲーム(囲碁・将棋・チェスのような)に比べてユーロスタイルのボードゲームは強さと楽しさのベクトルがややズレていて、強いプレイヤーがいることが必ずしも場の楽しさに貢献するわけではなくて、むしろ「ゲームに対して同等の理解度を持つプレイヤーが共にプレイする」ことが大事なのではないかと思ったり。この辺り、ゲームシステム(+対戦相手)を知的探索空間と見做してその中での探索行為が楽しさである、と考えると良いのではないでしょうか(これと似た話)。

AIは対戦相手をプレイヤーとして見ているのか

答えは“見ていない”で終わってしまうわけですが。

そもそも相手の状態をモデルとして持たないStratego AIは当然対戦相手をプレイヤーとして見ていません。単純に与えられた盤面があるだけで、盤面の情報から意思決定をしています。Diplomacy AIは手番ごとに対戦相手の意思決定モデルを構築するので一応は対戦相手をプレイヤーと見做していると言えなくもないのでしょうが、見る限り手番ごとにモデルを再構築しているので時間的な連続性はなさそうです。なので対戦相手のパーソナリティ/アイデンティティという評価もおそらくないでしょう(多分。SM読んだら書いてあるのかも?)。当たり前ですがAIは対戦相手を人間と思っていません(そもそも人間という概念すらないわけですけど)。なので基本的にはAIにtheory of mindはない……と言って良いと思うんですけど、AIは対戦相手に対して自分と同様の意思決定モデルを設定してその動きを予測してるんですよね。これってToMなの?(違います

実際のところどちらのAIについても、おそらく時間的に連続した“自分”というプレイヤーも存在しないわけで、こういう疑問を持つこと自体が不適切なのではないかと思うわけですが。

逆に人間は対戦相手を人間と見てしまうので(オンライン対戦で相手がAIであったとしても、あるいはAIであることを知っていたとしても)、対戦相手に連続性を想定してしまうわけです。あいつは前回こう動いたから今度はこうするはずだ、みたいな。あるいはあいつに攻撃されたからやり返してやる、みたいな。こうした連続性を想定することは、基本的に自分の意思決定にバイアスをかけてしまって“正しい”手を見つけづらくしてしまうのではないかな、と個人的には思っています(根拠はないです)。でも実際にゲームをしているとそういう人同士の駆け引きとか流れみたいなものが楽しいところだったりして、勝つことと楽しむことは違うんですよね、と思ったり。あ、また話がずれた。

AIはゲームが強いのか

もちろん強いんですが。囲碁や将棋は当然として、Stratego AIと対戦してもこてんぱんにやられるんじゃないかと思います。でもですね、このAIはこの強さになるために10億回以上(自分自身と)対戦しているわけですよ。それに対して私なら初めてStrategoをプレイしたとしてもルールを読めばそこそこプレイできますからね。でもStrategoのAIは最初にプレイした時はなにもわからないままプレイしているわけで、そこはかなり本質的に(ゲーマーとして、知性として)違うんじゃないかと思うわけです。プロ棋士のように一つのゲームを競技として突き詰めている“強さ”もありますが、様々なゲームの勘所を初見で掴む“強さ”もあって、最近のボードゲーマーにとっては後者の方が強さとして実感できるんじゃないでしょうか。そしてそうした強さの方がAIとして実装するのは難しいし、人間の知性の面白い部分なのではないでしょうか。

速さと早さ

これは結局(計算の)速さと(少ない試行回数で“理解”する)早さの違いとも言えるわけで、圧倒的な計算の速さを以て人間を凌駕したAIもゲームの本質を見抜く早さは持っていないわけです。人間が毎日20局50年対局を繰り返したとしても試行回数は40万にも届かないわけで、AIはその1000倍以上を費やしてようやく人間のトップレベルに比肩できるということは、人間の方が1000倍以上賢いのでは?……などという単純な比較ができるわけではないのですが、何を持って知性を定義してそれを評価するべきなのか、なかなか難しい問題ではないかと思います。

私自身は現在の“AI”はあまりに定義が曖昧でbotや特定のタスクを前提とした解決プログラムまでも含む広い概念になっており逆に意味が消失しつつある(少なくとも一般社会においては)と懸念しています。また、こうした数十億回の試行による機械学習にかかるコスト(人件費やハードウェアのコストだけではなく、電力消費とそれに伴う環境負荷なども含む概念)は無視できるものではなく、これからますます社会的な問題になるのではないかと考えています。

ボードゲームとAI

それにしても何故“ボードゲームをプレイするAI”がここまでホットなのでしょうか?もちろん身体的な要素がほとんどないことは重要です。しかしあるいはそれ以上に「ルールが明確」で「結果が明確に評価できる」ことが重要なのではないでしょうか。要するに「解くべき問題が明確」で「考えるべき空間が限定」されていて「結果の評価系が確立している」ところがAI向き、なのだと思います。一般的に「問題解決能力が重要」と言われたりもしますが、実のところもっと大事で難しいのは「問題を設定すること」と「何を以て解決とするか」なんですよね。現実のどの側面を切り取って問題として設定するか、どうなれば解決したことになるか評価軸を決める、ことこそが重要だし本質的な“知性”であって、それが固まってしまえばその中で解決法を導くのは、言葉は悪いですが“AIでもできる”わけです。単純な計算量と計算速度でシンギュラリティなどと言い出すのは筋が悪いと思うんですが(以下略

そういう意味で、ボードゲームを上手にプレイするAIは作れても、面白いボードゲームをデザインするAIはできないわけで、それこそが人間の知性の面白さではないかと思うのです。

Strategoと軍人将棋

Strategoについて、「軍人将棋と似たゲーム」と書きましたが、実のところ、私は長年「軍人将棋はStrategoを改変して作られたゲーム」だと思っていました。でも違ってたんですね。実は軍人将棋(行軍将棋)を元に海外でアレンジして作られたのがStrategoなんですね。

ということがWikipediaにも書いてある。出典となっている高橋浩徳氏の論文『日本と世界の行軍将棋ー軍人将棋の発祥は日本だったー』で詳細に書かれているのでみんな読むと良いです。面白いですよ。

松田道弘氏が『ボードゲーム』(1981)の中で“外国製のゲームが日本化された”ものだと書いているようで(私も読んだような気がする)、一般に軍人将棋は日本発祥ではないと思われていたようですが、実際には19世紀末には既に商品化されていたそうで、幸田露伴も師団将棋という名前で軍人将棋について語っていたり、朝日新聞に皇孫が行軍将棋を遊んだという記事が載っていたり(その内の1人は当時8歳の昭和天皇だ)、芥川龍之介の作品にも登場したり、と20世紀前半には既に定着していたようである。この行軍将棋が1905年にはドイツの雑誌で紹介され、1909年にフランスで『L'Attaque』として同様のゲームが発売され、『Stratego』が発売されたのは1950年。さらに『Stratego』の版権をミルトン・ブラッドレーが取得して発売したのが1961年、ということで、確かに軍人将棋はStrategoの祖と言えそうである。BGGにも軍人将棋を登録しておいた方が良さそうですね……

私は世情に疎く、寡聞にして高橋浩徳氏のことを知らなかったのだが、他の論文にも興味深いものがあり読んでみたいものである。『ゲームデザイナー、アレックス・ランドルフのゲームとその影響』とか。

ところで軍人将棋/Strategoのシステムはシンプルで使いやすいと思うんですが、意外とモダンユーロゲームに使われている例は少ない気がします。有名所だとKnizia氏の『Lord of the Rings: The Confrontation (2002)』くらい?ちょっと今ぱっと出てこないのですが同系ゲームがあったら教えてください。

ここから先は

¥ 100

この記事が気に入ったらサポートをしてみませんか?