ChatGPTに論文査読はできるのか?プロンプトと共に論文紹介

はじめに

GPT-4による査読のクオリティーを評価した論文がスタンフォード大のグループから出版されました。得られた結果は以下の通りです

GPT-4と人間の査読者によるフィードバックの一致度は、Natureジャーナルで平均30.85%、International Conference on Learning Representations(ICLR)で平均39.23%であり、これは二人の人間の査読者間の一致度(Natureで28.58%、ICLRで35.25%)と近かった。ユーザー調査では、57.4%の研究者がGPT-4のフィードバックを有用と評価し、82.4%が人間の査読よりも有益だと感じた。

まず最初に論文内で使われたprompt(一部改変)を紹介します。本論文内では<Paper_content>部分にabstract、本文に加えてFigure legendも入力しています。

Your task now is to draft a high-quality review outline for <journal title> for a

submission titled <Title>:

‘‘‘

<Paper_content>

‘‘‘

======

Your task:

Compose a high-quality peer review of a paper submitted to the journal.

Start by "Review outline:".

And then:

"1. Significance and novelty"

"2. Potential reasons for acceptance"

"3. Potential reasons for rejection", List multiple key reasons. For each key reason, use

**>=2 sub bullet points** to further clarify and support your arguments in painstaking

details. Be as specific and detailed as possible.

"4. Suggestions for improvement", List multiple key suggestions. Be as specific and detailed

as possible.

Be thoughtful and constructive. Write Outlines only.以下に論文の概要と私の考える良いレビューをしてもらうためのコツを紹介します。

査読システムの危機

査読は科学の品質を保証する不可欠なプロセスですが、この制度は厳しさを増しています。特にオープンアクセスジャーナルでは、高額な出版料(APC)が出版社に収益をもたらしている一方で、ボランティアの査読者には報酬が一切ないのが現状です。査読者を見つけること自体が難しくなっており、このシステムは崩壊寸前とも言えます。

論文のアブストラクト(GPT-4による要約)

## 概要

高品質な査読は科学的研究の基盤であるが、若手研究者や限られたリソースを持つ研究者にとってはその取得が困難である。本研究では、大規模言語モデル(LLM)であるGPT-4を用いて科学論文に対するフィードバックを生成する自動化されたパイプラインを開発し、その品質と効用性を評価した。結果として、GPT-4によるフィードバックは人間の査読者によるものと相当程度一致し、多くの研究者に有用であると評価された。

## 方法

本研究では二つの大規模な評価を行った。一つ目は、GPT-4と人間の査読者によるフィードバックを15のNatureファミリーのジャーナル(合計3,096論文)とICLR機械学習会議(1,709論文)で比較した。二つ目は、AIと計算生物学の308人の研究者に対する先行ユーザー調査である。

## 結果

GPT-4と人間の査読者によって挙げられたポイントの一致度は、Natureジャーナルで平均30.85%、ICLRで平均39.23%であった。これは、二人の人間の査読者間の一致度(Natureジャーナルで平均28.58%、ICLRで平均35.25%)と比較しても相当である。先行ユーザー調査では、57.4%の研究者がGPT-4によるフィードバックを有用または非常に有用であると感じ、82.4%がそれが少なくとも一部の人間の査読者からのフィードバックよりも有益であると感じた。

## 考察

GPT-4によるフィードバックは一定の品質と効用性を持つ可能性があるが、いくつかの制限も存在する。例えば、特定の側面(「より多くのデータセットでの実験を追加してください」など)に焦点を当てる傾向があり、メソッド設計の深い批評は難しい場合が多い。

## 結論

LLMによるフィードバックは、特に専門家の査読が得られない状況や論文作成の初期段階で、研究者にとって有益である可能性が高い。しかし、LLMと人間の査読は互いに補完するべきであり、高品質な科学的フィードバックの獲得には人間による専門家の査読が不可欠である。

以上の結果は、今後の研究としてLLMのさらなる評価と改善が必要であることを示している。

GPT-4による査読の可能性と限界

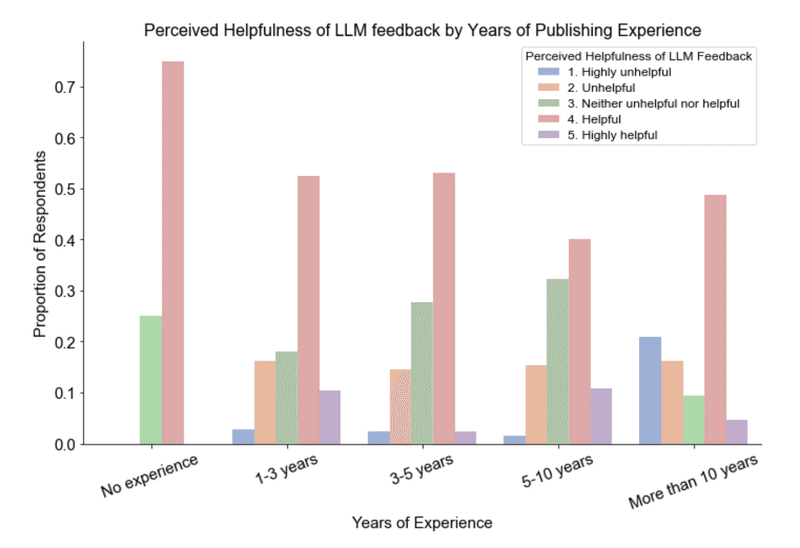

ここで注目すべきは、大規模言語モデルGPT-4による自動査読ということになるわけですが、この論文によれば、GPT-4のフィードバックはある程度人間の査読者と重なるポイントを指摘できています。しかし、経験が豊富な研究者からすると、GPT-4の査読は必ずしも有用でないようです(下図)。私も以前から自分の論文を入れて試していますが、一般に専門領域に関する指摘は表面的で、深い批評には至らないという印象を持っています。ただ文法的な誤りや説明不足の指摘等は役立ったと思うことはあります

注意点

ChatGPTを用いる場合、オプトアウト機能やチャット履歴のオフに注意してください。未公開の論文(特に他人のもの)はリークの可能性がゼロではないため、ChatGPTを査読に使用することは避けるべきです。また自分の論文の査読を事前にしてもらう場合でも、自分が論文の責任者でないのであれば、必ず指導者や共著者の許可を取る必要があります。

オプトアウトなどの方法はこちらを参照して下さい。

良いレビューをしてもらうためのこつ

Limitationのセクションをいれない

Limitationのセクションを入れておくとレビューの指摘がその記載内容に引っ張られるため、limitationを入力しない方がいいです。

事前に似たような先行研究のabstractを読ませておく

これにより多少背景を理解したまともなコメントが生成されます。ただしコンテキスト長(4096トークン=3000words程度)に引っかかる可能性が高いという問題点もあります。(勝手に最初の入力を忘れられます)

Claude-2-100kを使う

上記のコンテスト長の問題点を回避可能になります。使用には以下の2通りの方法があり若干の制限はありますが無料で使えます。ただし出力内容はGPT-4には若干劣ります。

PoeのClaude-2-100kについての解説はこちら

今後の展望

個人的には出版社がこのようなサービスを提供し、査読者が加筆して承認する形のシステムがよいのではないかと考えています。人間の査読者とAIの連携によって、査読プロセスをより効率的にする道があるのではないでしょうか。GPT-4を用いた査読は、あくまで人間の査読を補完するものであり、その限界も明確です。しかし、速やかなフィードバックが求められる現代の研究環境で、新たな選択肢としてその可能性を秘めていると思います。

今年の3月時点で、GPT-4による査読を助けるプロンプトを掲載しています。投稿前の論文をブラッシュアップしたい方にとってこちらも参考になると思います。

査読のやり方を知ることで論文のアクセプト率を上げることができます。以下の教科書がおすすめです。

この記事が気に入ったらサポートをしてみませんか?