Hello1103 Live:VR Experience 環境構築レポート(TouchDesignerによる映像生成編)

VRライブを実現するための技術情報をお届けする連載記事の後編です。

9月度のVRライブをもってフルTouchDesignerで構築された現行システムは開発を完了し、今後の公演に向けて次期バージョンの開発に注力することにしました。

丁度良い機会なので、本稿では現行バージョンでVR映像がどのように生成されているか、その実際のところをご紹介します。

映像信号の流れ

前編で少し触れましたが、「Hello1103 Live:VR Experience」のシステムにおいてステージ上のVJ端末は単なるコントローラで、映像の生成はしていません。

VRゴーグルに映し出される映像は各観客に1台ずつ割り当てられるVR再生機でそれぞれレンダリングされています。信号の流れとしては、

VJマシンからワールド切替や色指定などの制御信号をOSCで送信

↓

受信した制御信号に基づいて各マシンのTouchDesignerが映像を生成し、Oculus Rift Sに送信

↓

ゴーグル内に映像が表示される

となります。

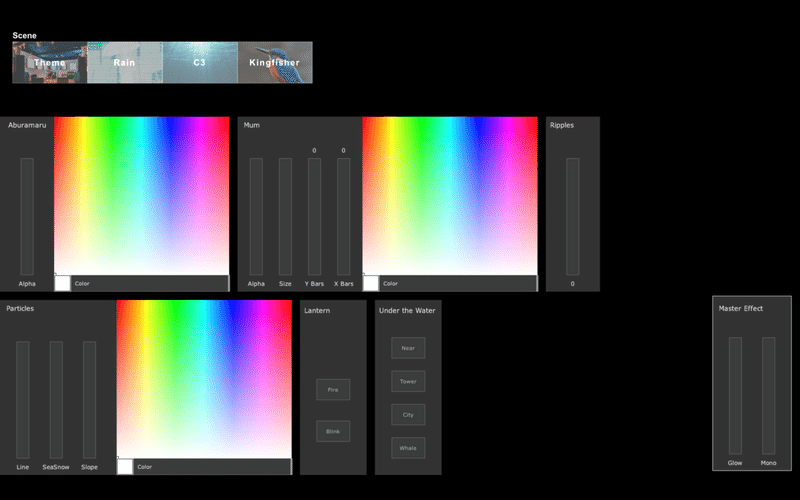

VJコントロールソフト(制御端末側)

上述の制御信号を送るためのコントローラもTouchDesignerで構築されており、所謂VJソフト的なインターフェイスを介してリアルタイムに映像を制御できるよう作られています。

エフェクトのオンオフ、色や動きのパターン変更など各種パラメータ調整のほか、ワールド(楽曲ステージ)切り替えも担当。

客席からは見えづらい部分ですが、ここでのVJ操作はかなりの部分が手動です。

展開ごとに全てのエフェクトを決め打ちにしてしまえば全自動化は可能ですが、それだとライブで一番大事な「熱」を演奏から生み出すことが難しくなってくるので、操作子の粒度をある程度細かくして演奏があまり作業的にならないようにしています。

「まず致命的な操作ミスを起こさない程度に操作子を減らし、その範囲で最大限に表現の枷を外していく」というのが基本方針です。このとき許容される範囲は操作手であるVJ各人の能力やスタイルによって異なってくるため、Hello1103のVJであるyukakoに最適化した本UIが他のVJに馴染まないということはありうるでしょう。

映像のレンダー(再生端末側)

各客席にひとつづつ用意されているVRマシン。Windows PCにVRゴーグル(Oculus Rift S)を繋いだもので、これもプログラムはTouchDesigner製です。

演奏する楽曲によって映像に求められるエフェクトや質感が異なるので、楽曲ごとにジオメトリを分けてワールドを作成し、レンダー設定まで含めて個別に設定できるようになっています。

ここで言う「エフェクト」はVRワールド上に配置した3Dモデルによるキャラクターオブジェクトと、レンダー後の2D映像に干渉するポストプロセスに大別されます。

後者は一般的なVJエフェクトと同様のもの。前者はyukakoが2DのVJで使用しているフッテージを再解釈して3D空間上に配置したもので、観客を取り囲むようにエフェクトを配置できるのでVRらしい派手な効果を生むことができます。

以下の動画で「Hello1103 Live:VR Experience」の内部映像をいくつか見られますが、Hello1103のVRコンテンツでは実写映像を用いることはあまりなく、殆どの内容が所謂ジェネラティブです。

非VRライブのVJでは実写映像もふんだんに用いますが、VRVJの場合は次元がひとつ多いこともあってプリレンダーの映像をそのまま適用できる場面は稀でした。

ただ、どちらの場合でもMIDIノートオンや音声入力をVJのトリガーに用いることは少ないです。「音に反応する」ことと「音楽に反応する」ことは別で、まず音楽そのものの主張と要請を汲むのが肝要かと思います。

ひとつ興味深かったのは、VRエフェクトの作成時、PCのディスプレイで見ると適切な情報量に見えるのにVRゴーグルでみると煩雑すぎて面白くないということが多々ありました。VR内ではシンプルで明快なほうがアリに見える。

ただ、もしかしたら単純にOculus Rift Sの解像度が精緻なエフェクトの表示に耐えられないだけかもしれず、今後VRゴーグルの解像度が8kあたりまで向上したときにはこのあたりの感じ方が逆転するかもしれません。

VR酔いを抑制する

VRアトラクションを作るにあたって心がけたのが、「観客を驚かせたり怖がらせて印象を強めることはしたくない」ということ。また、ライブハウスにはVRに不慣れな方も多く訪れるので、そうした方でもVR酔いをせずに最後まで楽しめるものにしたい。

とはいえ派手さは欲しい。ジェットコースターが一つもない遊園地では寂しいわけです。

これらを両立させるために、激しさや疾走感を与えるエフェクトを要所に集中させ、その前後を動感の少ないエフェクトで挟むことで観客に適度に休んでもらえるよう配慮しました。このあたりの緩急は普段ライブのセットリストを作るときと同じですね。

LiDARスキャンによる3Dモデル作成

一部のワールドではCinema 4Dで作成した3Dモデルをインポートして表示しています。

そのひとつに「会場となるライブハウスを3Dモデルとして書き起こしてワールド内に再現する」というものがあるのですが、会場見取り図だけを頼りに3Dモデルを作っていくのは大変です。

そこで、「iPhone12 ProのLiDARスキャナで会場を3Dスキャンする→スキャンしたモデルを下地として使い、トレースしながら3Dモデルを構築する」という手法を用いました。

3Dでかなり正確なアタリをつけられるので大きな破綻を防げ、また現場の雰囲気も掴みながらスムーズにモデリングを行えるため、大変便利でした。LiDARスキャナによるアタリ作成は他にも応用できそうです。

次回の「Hello1103 Live: VR Experience」は11月開催予定です。

新バージョンを鋭意制作中ですので楽しみにしていてください。

この記事が気に入ったらサポートをしてみませんか?