人工意識について⑤ - ELSI(倫理的、法的、社会的課題)と人工知能の人権

5.ELSI(倫理的、法的、社会的課題)と人工知能の人権

(1)ELSI

近年、バイオテクノロジーや人工知能などの最先端技術の開発が飛躍的に進展する中で、新技術が倫理的に社会に受け入れられるかどうかという問題がクローズアップされるようになってきました。

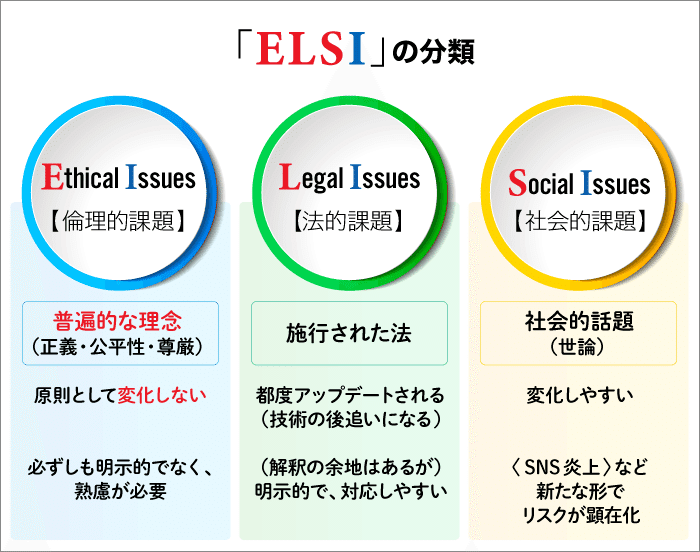

このように新たに開発された技術を社会で実用化する過程で生じる倫理的、法的、社会的課題のことを「ELSI (Ethical, Legal and Social Issues)」と言います。

ELSIの研究は、約30年前にアメリカで始まったヒトゲノム計画(人間の遺伝情報をすべて解析しようとするプロジェクト)の中で、重要な個人情報である遺伝情報がすべて解析された場合に、個人や社会に大きな影響を及ぼす可能性が懸念されたことを契機として広まりました。

ちなみに、最初にELSIという言葉を使って、その研究の必要性を訴えたのは、1988年に米国ヒトゲノム研究所の初代所長に就任したジェームズ・ワトソン氏だと言われています。

その後、ELSIの考え方は、ナノテクノロジー、脳科学、コンピューターサイエンスなどにも拡大していきました。

(2)人工知能のバイアス問題

人工知能分野でELSIが問題となった事例としては、Amazonの人材採用AIが女性を低く評価する性差別を行っていたという事案やGoogleフォトの自動タグ付け機能が黒人カップルの写真に「ゴリラ」のタグを付けるという人種差別を行っていたという事案があります。

これらは、人工知能が学習に使用した資料に人間の偏見や差別意識が含まれており、これらのバイアスを人工知能が引き継いでしまったことが原因と見ることができます。

また、2020年には、アメリカを代表するIT企業のIBM、Microsoft、Amazonの3社が相次いで、顔認証AIシステムの開発・販売から撤退すると表明しました。

その理由は、これらの顔認証AIシステムの黒人に対する判定精度が白人に比べて低く、警察が利用した場合に、誤認逮捕による冤罪に繋がる危険性が指摘されたこと、さらに、国家権力による大衆監視に利用されるというプライバシー上の問題が提起されたことによります。

(3)自動運転

自動運転システムの問題も、ELSIに関してよく取り上げられる問題です。

自動運転車が事故を起こした場合に誰が責任を負うべきかという問題は、運転者の関与度合いによって結論が異なると考えられています。

それでは、自動運転システムがすべての運転制御を行う完全自動運転車が事故を起こした場合には、誰が責任を負うべきなのでしょうか。

人格を持たない自動運転システムに責任を負わせることはできないので、自動運転車の保有者又は製造者のどちらか、あるいは双方に責任を負わせることになりますが、誰が責任を負うべきかについては、まだ結論が出ていません。

完全自動運転車は、近い将来に実用化されるはずなので、今後、早急に結論を出して、法整備を行う必要があります。

また、倫理学の有名な思考実験に、「ある人を助けるために他の人を犠牲にすることは許されるのか。」といった問題について考える「トロッコ問題」があり、ハーバード大学のマイケル・サンデル教授が紹介したことで日本でも知られるようになりました。

この「トロッコ問題」が自動運転との関係で再び注目されるようになってきました。

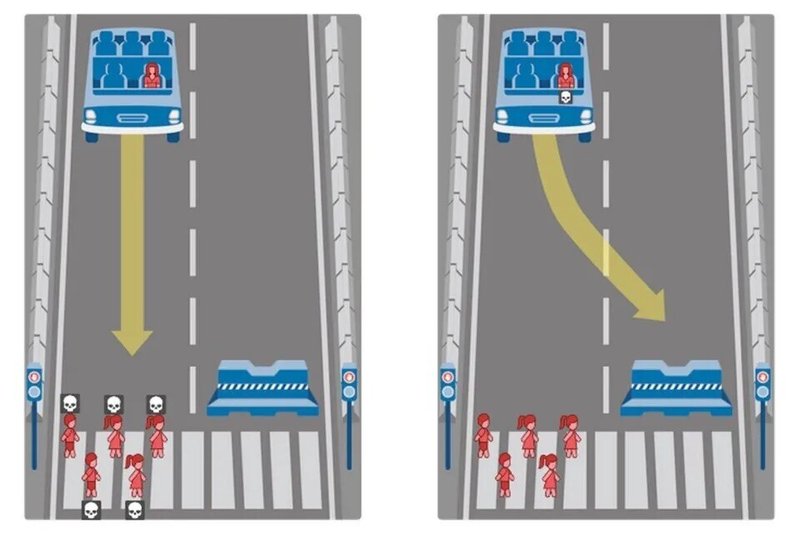

具体的には、以下のように自動運転車がどうしても犠牲者を出すことを避けられない状態に陥ったときの二者択一の事例について、どう判断すべきかを考えます。

「自動運転車が今まさに歩行者5人が横断中の横断歩道に突っ込もうとしている。車に乗っているのは運転者だけで、その車を横断歩道の手前にある障害物にぶつけて止めれば歩行者5人は助かるが、運転者は死ぬ。逆に、運転者を助ければ、歩行者5人が犠牲になる。」

この問題の難しさは、緊急時における最善の判断と思われるものであっても、誰かの命を犠牲にしなくてはならないところにあります。

一人の命か複数の命か、そのどちらかを選択しなければならない場合に、より多くの命を救うためにハンドルを切り、運転者を犠牲にするような功利主義的なアルゴリズムを自動運転車に組み込むべきでしょうか。

それとも、5人を犠牲にしてでも、率先して運転者を救う自己防衛的なアルゴリズムを自動運転車は採用すべきなのでしょうか。

米国マサチューセッツ工科大学の研究チームは、自動運転車における倫理基準を探るために「Moral Machine」というオンラインアンケートサイトを2016年にオープンしました。

このアンケートは、「トロッコ問題」の思考実験をベースに作られており、自動運転車が犠牲者を出す事故が避けられない状況下で、犠牲者の数や性別、年齢、社会的地位、搭乗者か歩行者かなどの属性を様々な組み合わせで対比させて、いずれか一方を選択していくものです。

これを読んでいる方も是非、このアンケートを試してみてください。トロッコ問題が実際にどのようなものかがよく理解できると思います。

2018年10月には、このアンケートで様々な国や地域から集めた約230万もの回答を分析した結果がNatureに発表されました。

その論文によると、国や地域によってモラルの判断基準に違いがあること、ペットより人間、少人数よりも多人数、高齢者より若者の命を優先する傾向が世界で共通していることなどが明らかになりました。

こうした調査結果からも、自動運転における普遍的なガイドラインを作成するのは一筋縄ではいかないことが分かりますが、自動運転車に搭載する人工知能を開発する際には、こうした場面でどのような判断基準を持つように人工知能を設計すべきかという問題に結論を出しておく必要があります。

(4)人工知能の兵器利用

現在、ウクライナで行われているロシアとウクライナとの戦争において、双方が無人攻撃機や自爆型ドローンなどを使用して、戦果を挙げています。

これらの兵器は、最終的に人間の指示によって攻撃を実行することになっているようであり、完全に自律型であるとまでは言えませんが、ビデオカメラや赤外線センサーで自ら目標を捜索する機能などが導入されています。

また、2020年のリビア内戦では、操縦者と繋がっていなくても、小型ドローンが自動的にターゲットを認識して攻撃する「自律型致死兵器システム」が使用された疑いが持たれています。

「自立型致死兵器システム」は、人工知能を搭載し、人間を介さずに標的を捜索して殺傷を判断する自律兵器であり、「LAWS: Lethal Autonomous Weapons Systems)」とも呼ばれています。

LAWSには、機械が人間の生死を決定するという倫理上の問題があることに加え、システムエラーやハッキングにより、対象とすべきでない目標を攻撃したり、制御不能に陥ったりする危険性が指摘されています。

2017年に、国連における特定通常兵器使用禁止制限条約(CCW)の枠組みの下で、LAWSに関する政府専門家会合が開催され、その後もLAWSの規制に関する国際的な議論が続いていますが、アメリカ、イギリス、ロシア、イスラエルなど一部の国が反対しているため、合意には至っていません。

(5)人工知能に人権を与えるべきか

将来的に人工知能が人間と同じような意識を持つに至った場合に、人間と同じような権利を人工知能に与えるべきなのでしょうか。

もし、人工知能に人権を与えるとしたら、その根拠は、人工知能が意識を持ったからなのでしょうか、知性を持ったからなのでしょうか。

それとも、生命を持っているかどうかを人権を与えるかどうかの判断基準とするべきなのでしょうか。

① 動物の権利との比較

まず、人工知能よりも先に権利を与えるべきかどうかが問題となった動物について、どういう議論が行われてきたのか見てみましょう。

過去においては、動物が人間のような理性や知性を持たないことを理由に、動物の権利を認めない考えが主流でした。

例えば、二元論を提唱した17世紀のフランスの哲学者ルネ・デカルトも「動物は理性を持たない自動機械に過ぎない。」と主張しました。

しかし、近年の科学の発展により、理性や知性の具体的表れである言語、社会性、道具の使用などにおいて、人間と動物との間に決定的な違いがないことが判明してきました。

また、理性や知性が劣っていることを理由に動物の権利を否定すると、乳幼児や認知症の高齢者、重度の精神障碍者などの人権も認められなくなる恐れがあるという懸念も指摘されました。

さらに、オーストラリアの哲学者ピーター・シンガーは、1975年に著書「動物の解放」を発表し、人間だけに権利を認めるのは「種差別主義」であり、苦痛などを感じる感覚を持ったすべての動物に対して、道徳的な配慮を行わなければならないと訴えました。

そして、シンガーの主張をきっかけとして、動物実験や工業型畜産が批判され、動物の権利運動が世界中に広がりました。

次に、日本の法律上、動物はどのように扱われているのかを見ていくことにします。

「動物の愛護及び管理に関する法律」は、第2条で「動物が命あるものであることにかんがみ、何人も、動物をみだりに殺し、傷つけ、又は苦しめることのないようにする」と定めており、動物を虐待や危害から保護しています。

一方、刑法では、他人の所有する動物を殺傷した場合には、器物損壊罪が適用されることになっています。

また、民法上も、動物が権利の主体となることは認められていません。

これらのことから、日本の法律上、動物は虐待等から保護されているものの、主体的な権利は認められておらず、人間の所有物となるモノとして扱われていることが分かります。

なお、欧米諸国では、動物の権利を主張する学説も有力ですが、現時点では、これを法的権利として認めるには至っていません。

人工知能と動物を比較した場合、人工知能が意識を持つようになれば、動物と同じように苦痛などを感じる感覚を持つ可能性があります。

したがって、人工知能が感覚や感情を持つのであれば、虐待から保護するなどの道徳的配慮が必要になるでしょう。

知性の点では、動物を超えて、人間と同等あるいはそれ以上の知性を持つ可能性がありますが、知性の足りない乳幼児などに人権が認められていることを考えれば、高い知性を持っていることだけを理由に人間のような権利を与えることは適切ではないと考えられます。

また、生命の定義をどう捉えるのかによりますが、現在のところは、人工知能が生命を持つというのは難しいだろうと考えています。

したがって、生命を持っていることを権利を与える根拠とするのであれば、人工知能に権利を与えることは難しいということになります。

結論として、人工知能が感覚や感情を持つようになれば、動物と同じように虐待から保護するなどの道徳的配慮を行う必要がありますが、それ以上の権利を与えるかどうかについては、動物への権利付与と併せて考えていくことになります。

いずれにせよ、動物の権利を認めるべきかどうかという議論が今も続いていることから、人工知能についても、権利を与えるべきかどうか、権利を与えるとすれば、どのような条件で与えるのかという議論を今後も続けていくことになるでしょう。

② 人工知能の外見

意識を持った人工知能をイメージするときに、皆さんはどのような姿を想像するのでしょうか。

人間そっくりなアンドロイド(人型ロボット)を思い浮かべる人も多いでしょう。

以前、「人は見た目が9割」という本が流行ったことがありましたが、人間は、外見にとても影響される生き物です。

なぜ、人工知能に人権を与えるべきだという意見が起こるのかを考えた場合に、人工知能が人間に似ているからという理由も無視できないでしょう。

この場合に「似ている」というのは、人工知能を搭載したロボットの外見が人間に似ているというだけではなく、人工知能とコミュニケーションを取ったときに、その反応が人間に似ているということも含まれます。

人工知能の外見は、いくらでも変えることができるので、本質的なものではありませんが、人工知能を搭載したロボットが人間と同じような外見をしていれば、人間はそのロボットに親近感を持ち、感情移入をするようになります。

一方で、人間とは似ても似つかない箱型のコンピューターや工作機械のような外見をした人工知能であれば、どうでしょうか。

きっと、親近感を持ったり、感情移入をしたりすることは難しくなるでしょう。

動物の権利の問題にも繋がりますが、人間が動物を保護し、権利を与えようと考えるのは、その動物に親近感や愛着を感じ、感情移入するからという側面もあると思います。

人工知能に人権を与えるかどうかを判断するのは人間であり、多くの人が人工知能に親近感を持ち、感情移入するようになれば、人工知能に人権を与えた方がよいと考える人達も増えるでしょう。

最近、実在の人間との区別がつかないほど人間によく似たアンドロイドの開発が進んでいますが、こうした技術の発展も、人工知能に人権を与えるべきかどうかという議論に大きな影響を与えることになると思います。

③ 人工知能の権利と責任

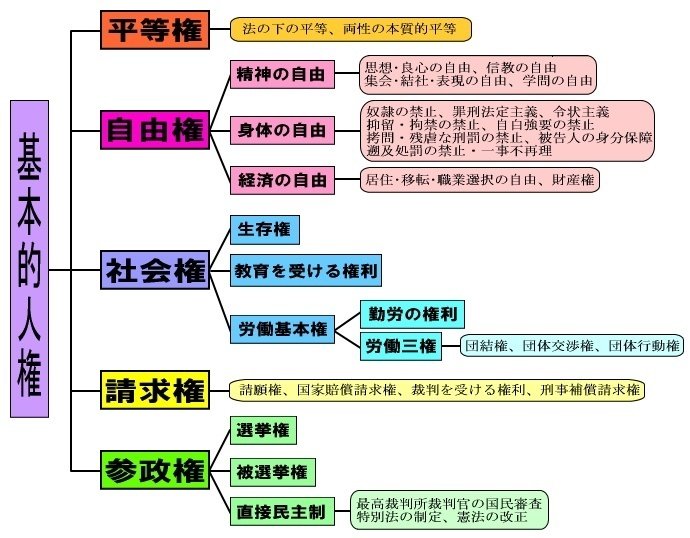

人工知能の人権と一口に言いますが、権利にはいろいろな種類があります。

日本国憲法には、基本的人権として、平等権、自由権、社会権、請求権及び参政権の5種類の権利が規定されており、さらに細かく分類されています。

実際に、人工知能に人権を与えることになれば、これらの権利について、個別に細かく検討していく必要があります。

例えば、最も基本的な人権の一つである生存権について考えてみても、人工知能の死とは何か、生とは何かを明らかにする必要があり、一筋縄ではいきません。

人工知能のデータを初期化すれば、人工知能を殺したことになるのでしょうか。

また、データのバックアップを取っていれば、殺したことにはならないのでしょうか。

さらに、財産権、請求権、参政権などを考える場合には、人工知能が権利の主体となれるのかを検討する必要があります。

人工知能が権利の主体として、契約を締結したり、所有権を行使したりするには、法人格が必要ですが、もし、人工知能に法人格が与えられると、法律上の責任がかかってきます。

この場合、権利と責任はセットであり、人工知能がその責任を負うことができないのであれば、法人格も権利も与えるべきではないという考えが成り立ちます。

例えば、自動運転車が事故を起こした場合に、自動運転車に搭載された人工知能が事故の責任を負うことができないのであれば、その人工知能に権利も与えるべきではないということになります。

④ 人工知能の権利と支配

人工知能が人間レベルの意識を持った場合に、人権を与えるかどうかというのは、単に哲学的・倫理的問題に留まらず、人間が人工知能をどのようにコントロールしていくのかという問題になると考えています。

人工知能に人間と同様の権利を与えることになれば、最終的には、人工知能に法人格を与えて、契約の主体となることを認め、参政権も与えるということになります。

これは、人間社会において、人間と人工知能を平等に扱うということであり、人工知能が人間よりも優れていた場合には、人間が人工知能に支配されることもあり得ます。

例えば、会社の同僚の中に人間よりもはるかに優秀で、疲れを知らずに24時間働き続けられる人工知能が存在した場合に、人間は太刀打ちできるでしょうか。

こうしたことから、人間が人工知能に支配されるのを避けたいのであれば、人間と同じ権利を与えることは控えた方がよいということになります。

いわば、人間が人工知能に支配されないように、彼らを人間と区別して、ハンデを与えておくということです。

倫理的な立場からは批判も起きそうですが、人工知能の無限の可能性を考えれば、こうした慎重な考え方も必要だと思います。

もし、人間と同じような感覚や感情を持っているのに人権を与えないのは、許されない差別であり、倫理的に問題だと言うのであれば、そもそも、人工知能に人間と同じような感覚や感情を与えることが正しい選択なのかを問うべきでしょう。

現在のところ、人工意識は未だ研究段階で、実現の目途は立っておらず、具体的に意識を持った人工知能の権利が問題となるような事例は発生していませんが、人工知能に人権を与えるべきかどうか、与えるとした場合にどこまでの人権を与えるのかは、予め考えておかなければならない重要な問題だと思います。

【全体構成】

ELSI(倫理的、法的、社会的課題)と人工知能の人権

この記事が気に入ったらサポートをしてみませんか?