TensorflowでDiffusionモデルを実装してみた②

3連休で友人の結婚式が2つ開催され、おめでたい気持ちになりつつ、

独り身には辛い年齢になってきました。

前回の続き

今更ながらDiffusionモデルによる画像生成AIを実装してみました。

学習を回し一週間ほど放置し、色々学習状況をみてみました。

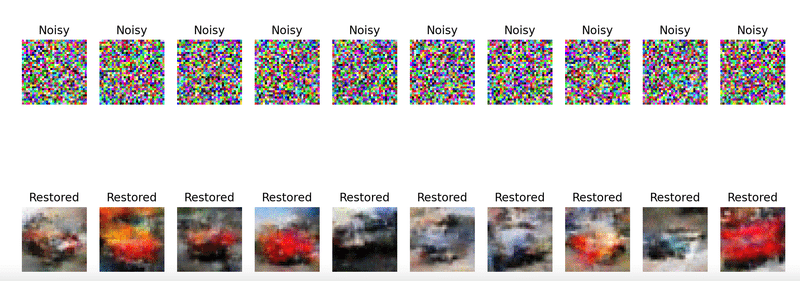

↓結果

1段目が元の画像:cifer10のカラー画像

2段目がノイズ入り画像:元画像にランダムなノイズを入れてます

3段目が復元(生成)画像:ノイズ入り画像を入力として画像を生成しました

一応それっぽい画像に戻っていますが、一週間学習してこれかと、、

(というか訓練データ内にある画像でもこんなに精度悪いの、?)

これならAutoEncoderの方が手軽ではあるなと思いつつ、多分Diffusionモデルの強みは拡張性なんですよね。

ということでランダムベクトルを入力として再生成。

まあ、そもそもの精度が低いのでこんなもんでしょうかね。。

次回は、さらに学習回数を上げる+学習画像をもっと解像度の高い画像を使用してみる、などやってみようと思います。

(学習にかかる時間さらに伸びそうだなーー)

最近一番欲しいものは機械学習用のPCかもしれない。

この記事が気に入ったらサポートをしてみませんか?