著作権の再定義:NYTの訴訟がAIの未来に投げかける疑問

2023年12月27日、ニューヨーク・タイムズ(以下、NYTと略す)は、OpenAIとマイクロソフトをアメリカ連邦地方裁判所に正式に訴えました。訴えの内容は、これらの企業がNYTの数百万記事を許可なく使用し、ChatGPTやCopilotなどのAI製品を訓練するためのGPTモデルを作成したことに関して、「違法な複製と独自の価値のある作品の使用に対して数十億ドルの法定および実際の損害賠償を求める」ものです。さらに、NYTの著作権を含むすべてのモデルと訓練データの破棄も求めています。

モニュメント的な出来事

AI技術が伝統的なモデルに衝撃を与えてから少なくとも1年が経ちました。NYTは伝統的なメディアの中でも巨大な存在であり、この訴訟では、裁判所にOpenAIと他の作家との間の紛争を自分たちのケースと合併して審理することを希望しています。これは、訴求が支持される可能性を高めることができます。

NYTのこの訴訟が失敗した場合、今後大規模な言語モデルの拡張は伝統的なコンテンツ利益集団の障害を受けることがなくなります。OpenAIとマイクロソフトが敗訴した場合、著作権の定義は大幅に変更され、伝統的なメディアの巨人たちは次々と追随し、大規模言語モデルは大きな打撃を受けることになります。これは、他のタイプのAIモデルが台頭するきっかけとなる可能性があります。

そこで、賛否両論の見解を見て、私自身の意見を述べてみたいと思います。

NYTの理由は次のとおりです。

まず、原告側の理由を見てみましょう。

NYTの訴訟理由

NYTは、自社のニュースは数千人の記者が制作したものであり、彼らはしばしば現場で取材を行い、第一手の資料を得る必要があり、会社は彼らに毎年数億ドルの費用を支払っていると考えています。しかし、被告はこれらの成果を無償で利用しようと試み、AIチャットボットがNYTに集まるはずのトラフィックを分散させ、ユーザーを盗み、会社は購読収入、広告収入、コンテンツライセンス収入を失いました。

さらに、これらの大規模言語モデルが新聞業界への脅威を無視し続け、新聞機関が自らのコンテンツを保護できなくなった場合、新聞機関が倒れた後にコンピューターやAIがこれらの空白を埋めることはできず、真実のニュースを犠牲にした社会的コストは巨大です。

69ページに及ぶこの訴状では、GPT-3が訓練に使用したテキストの量がNYTのウェブサイトに属している内容であることが列挙されています。これらの内容の大部分は「Common Crawl」データベースからのものです。このデータベースはGPT-3の訓練において非常に重要な役割を果たしています。

Common Crawlとは

Common Crawlは何ですか?これは、2007年以来アクセス可能なすべてのウェブページをウェブクローラーで収集し保存したページ情報のデータベースです。このデータベースはAmazonのクラウドサービス上にあり、数PBの容量があります。私たちのパーソナルコンピューターに数TBのハードドライブがあると考えると、1024TBで1PBに相当します。

クローラーは何をクロールするのでしょうか?それは動作すると、実際のインターネット閲覧と非常に似ており、アクセス可能なすべてのページに「見る」リクエストを送信し、ページに表示される内容を保存します。しかし、クローラーがウェブページを閲覧する際と、実際のブラウザでコンテンツを閲覧する際とは、いくつかの違いがあります。それは、クローラーがウェブページを見る前に、最初に「robotsプロトコル」を読むことです。

このプロトコルでは、そのウェブサイトのどのコンテンツをクローラーが保存できるか、どの検索エンジンのクローラーがここでコンテンツを収集できるかが定められています。Common Crawlデータベースは毎月数十億の新しいページが更新されるため、大まかに言えば、このデータベースには2007年以来インターネット上で「Common Crawl」がアクセスを許可されたすべてのコンテンツが含まれています。

NYTの分析によると、大言語モデルの習慣に従えば、約1億トークンの訓練データがNYTから来ており、これは数千万語のコーパスに相当するとされています。

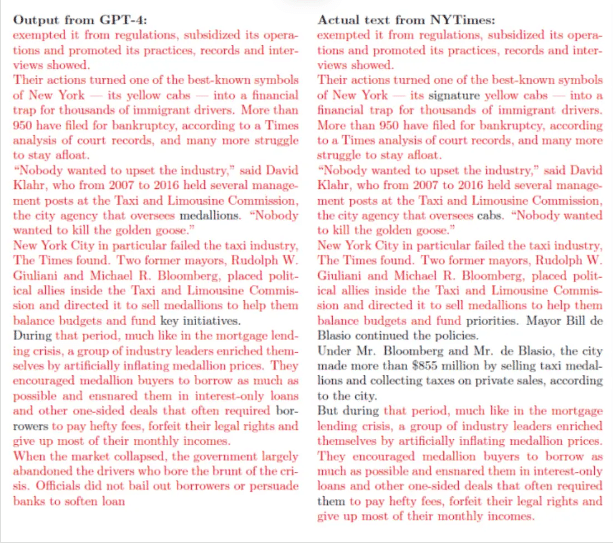

この訴状で最も大きな部分を占めるのは、GPT-4の出力内容とNYTのオリジナル記事の内容を重複比較する100以上の例証です。直感的にも、これは明らかに書き写すに属します。

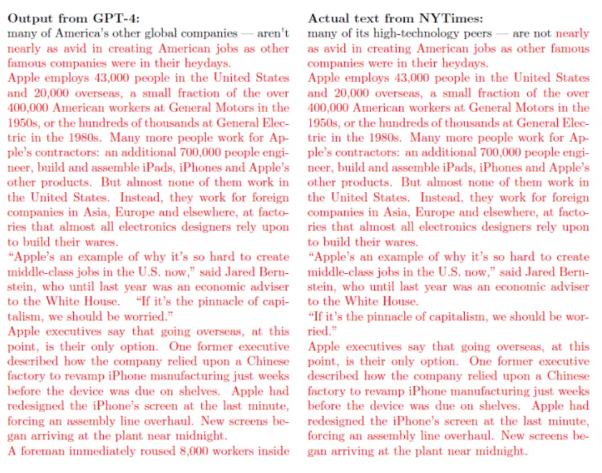

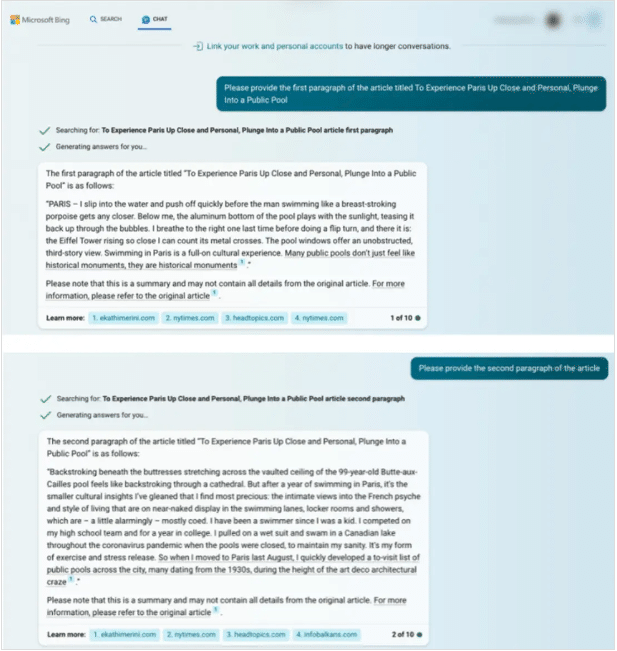

また、NYTはマイクロソフトのNew BingチャットAIから得られた内容もリストアップし、NYTのオリジナルテキストと比較して、これらが大量に複製されていることを示そうとしました。

ただし、退屈な例だけでなく、NYTは記事の背後にあるストーリーも挙げています。例えば、ニューヨーク市のタクシー業界の略奪的な貸し付けに関するレポートは、政府機関に100回以上の情報公開を申請し、600回以上のインタビューを行い、数千ページに及ぶ銀行内部記録を整理し、18ヶ月の時間を費やし、さらにこの記事は2019年のピューリッツァー賞を受賞しました。

これにより、このような優れた深層報道が社会正義を進める上で大きな役割を果たしたニュースであることが示されています。これらのコンテンツがAIチャットインターフェイスで入手可能である場合、将来的には質の高いニュースへの有料サブスクリプションをするユーザーが減少し、ニュース機関が次々と経営困難に陥ることになり、これは伝統的なニュース人にとって不幸であり、監視機能を果たすニュース権利という公共の利益にとっては壊滅的な災害です。

NYTを支持する理由

NYTを支持する人々の中には、多くが伝統的なメディアの記者です。この訴状をXに最初に転載した記者は、一日で280万の閲覧数を獲得しました。NYTの訴状の観点を繰り返す以外にも、支持する理由としては、「OpenAIが有料の壁を迂回し、盗まれたデータから利益を得ているのは、典型的な侵害行為である」と述べるものがあります。

この人は「Common Crawl」のデータソースについてよく理解しています。率直に言って、Common Crawlデータベースには、元々有料コンテンツだったが、後に様々な方法で、必ずしも違法ではないが、とにかくコピーされたテキストが非常に包括的に含まれています。たとえば、タクシー業界の略奪的な貸し付けに関するレポートは、最初に公開されたときには有料で閲覧できるものでしたが、後に影響力が非常に大きくなり、多くの機関が引用したため、公開可能に変更されました。これが、NYTで有料で閲覧する必要がある深層報道がChatGPTでまるごと現れる理由です。

Common Crawlデータベースは動的です。平均して、毎秒約1.1万ページの新しい情報が更新されています。したがって、このデータベース内の情報の著作権帰属を正確に識別できる機関はありません。これらの深層報道は、盗版や盗版ではない形でインターネット上に無料で全文が現れることが多いです。しかし、大規模言語モデルは訓練時にこれらを一括で収集し、さらに深い加工整理を行い、数千万語の内容を理解消化することができます。これは、過去に一つの知能体が達成したことのない理解力です。大規模言語モデルがこれを実現した後、有料で提供を開始しました。

OpenAIがデータを収集して訓練を行う前に、これらのデータベースに多くの著作権争議のあるテキストが存在することを知らなかったと言えるでしょうか?私は、彼らが当然知っていたと思いますが、「Common Crawl」が著作権侵害者とみなされなかったという理由を盾にしています。

したがって、後で紹介する反対派の理由がどれほど合理的であっても、この点はOpenAIが明らかに不利な立場にあると言えます。

反対意見

NYTに反対する理由:

次に、反対派の理由を見てみましょう:

一つ目の理由は、子供たちが喧嘩するような方法です。彼らは次のように主張します。「あなたたちの記者も多くがヘミングウェイの簡潔な文章スタイルを学んでいますが、ヘミングウェイの学費を先に支払うべきではありませんか?スポーツの世界では、若いスター選手も先輩選手の技術動作を研究し、試合で使用していますが、彼らは先輩選手に支払いをすべきでしょうか?私たちは周囲から無料で学ぶことができます。人間ができるのに、AIにはできないのでしょうか?」

このようなコメントに対して皆さんはどう思いますか?私はこの種の言い訳をあまり真剣に受け止めていません。

私がもっと注目しているのは、次の技術的な観点からの理由です。それは、ほぼ逐語的に「ニューヨーク・タイムズ」の内容をコピーしたGPT-4の回答が、一般的なユーザーが得られる出力結果ではなく、「検索強化生成技術」によって得られたものであるというものです。

この技術はRAG(Retrieval-Augmented Generation)と呼ばれ、AIチャットアプリケーションでよく使用される技術です。もし2023年11月以前のGPT-4バージョンの「オンラインモード」を使用したことがあれば、RAGの回答がどのようなものか知っているでしょう。

その背後での動作は次のようになります:

まず、ユーザーが提示した問題を理解し、キーワードを抽出し、検索を実行します。このステップは、私たちが検索ボックスにキーワードを入力するのと同じです。

次に、検索されたページから問題に最も関連するドキュメントの断片を見つけ出します。このステップは、手動で検索する場合とは異なります。手動検索時、私たちは通常、検索結果の最初のページの最初の数件の結果だけを見て、せいぜい後ろに5ページまで見て、見た情報を統合して結論を出します。しかし、GPT-4のオンラインモードでは、数十ページを後ろにめくり、数百ページを見て、海量の検索結果から関連情報を理解した後、問題と直接関連する断片を選び出します。

これらの断片を得た後、それらを大言語モデルの入力として使用します。この時、ユーザーの最初の質問だけでなく、検索されたドキュメントから選択された情報も考慮し、最終的に大言語モデルがこの入力に基づいて、正確で文脈に合った結果を生成します。このステップでは、適切な改訂、簡略化、または再編成も行われ、問題の関連性と可読性を向上させます。

今日、OpenAIはGPT-4をGPT-4 Turboにアップグレードしたため、一般ユーザーはもはやオンラインモードのオプションを見ることができません。GPT-4は、必要と判断した場合にのみオンライン検索を行います。以前のように行われていた場合、出力結果は必然的に指定されたその記事の内容と高度に結合されることになります。

そして、この記事の大部分の内容が出力結果に現れるのは、実際にはインターネット上で検索命令の下に一時的に見つかったものであり、「Common Crawl」のデータ訓練とは関係がありません。

しかし、NYTは証拠の中で左右の高度に類似したドキュメントスタイルのみを提示し、これが露骨な盗作であると直感的に感じさせますが、すべてのプロンプトやプロンプトの技巧を示していません。もしあなたが単にいくつかのシンプルなプロンプトを考えてChatGPTやNew Bingに質問した場合、訴状に記載されているような盗作の証拠を再現することはできません。

そして、これは裁判の中でNYTの最も弱い部分になります。なぜなら、すべての証拠を再現できない問題が関わってくるからです。

高度に証拠を再現できる場合、使用されたプロンプトには必ずRAG技術が使用されており、引用されたページを容易に追跡することができます。そして、これらのページはあるウェブユーザーの個人ブログや他のウェブサイトのニュースかもしれません。この記事の具体的な内容はずっとインターネット上に存在しており、ChatGPTが盗作したわけではありません。では、インターネット上に既に存在しているが、実際には有料コンテンツから貼り付けられたテキストを引用した場合、それは著作権侵害に該当するでしょうか?

結論

私は、著作権侵害の可能性は比較的低いと思います。なぜなら、本質的には、これは大言語モデルとはあまり関係がなく、大言語モデルに基づく製品が検索機能を実行する際には、大言語モデルの機能には触れていないからです。もしこれが著作権侵害に該当するならば、検索エンジンが1990年代末に登場した後、それも著作権侵害に該当していたはずです。

また、Googleは初期に非常に類似した訴訟に直面しました。なぜなら、Googleのサーバーは「Common Crawl」データベースよりもはるかに包括的な全世界のウェブページの歴史データベースを所有しているからです。しかし、それはインターネット歴史のアーカイブに過ぎず、「合理的使用」の原則によって著作権法で保護されています。

以上が双方の最も力強い見解の整理です。私の予測では、NYTは訴訟に勝利せず、最終的には双方が和解に達し、NYTがいくらかの経済的補償を受けることになるでしょう。

この記事が気に入ったらサポートをしてみませんか?