Flip Backprop : バイナリ重みを直接学習する新手法を提案します。

バイナリーニューラルネットワーク(BNN)の重みを直接的に学習する、新しい学習の枠組み「反転逆伝播法(Flip Backprop)」を考案しました。

反転逆伝搬法によるバイナリニューラルネットワークの学習 ~ニューラルネットワーク学習法の全面的見直し~

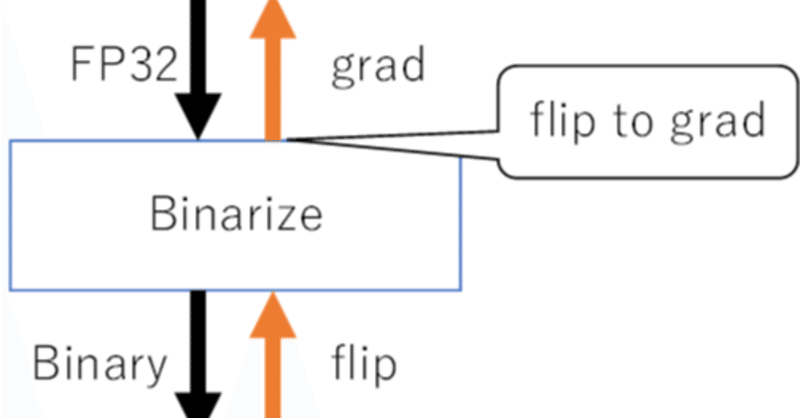

反転逆伝播法は、「勾配」ではなく「反転」を逆伝播させることでBNNの学習を行う手法です。PyTorchに組み込んで実装するので、既存のニューラルネットワークと一緒に学習可能で、実装コストが低く、運用も容易な手法です。

バイナリニューラルネットワークとは

ニューラルネットワークのパラメータ数が増える一方で、GPUのメモリ容量は有限であり、メモリ削減が課題となっています。そこで注目されているのがバイナリニューラルネットワークです。これは、ニューラルネットワークの重みをバイナリ(1か0)にすることで、メモリ使用量を削減する手法です。

しかし、従来のバイナリーニューラルネットワークの学習方法では、連続値(Float32)の重みで学習を行い、学習終了後に重みをバイナリ化する方法が一般的でした。これでは重みをバイナリ化するときの精度劣化や、学習時のVRAM使用量が大きいという課題がありました。

反転逆伝播法の概要

反転逆伝播法は、これらの課題を解決するための新たな学習手法です。ここでいう「反転」とは、値の更新が「反転する(1) or しない(0)」の1ビットで表現されることを指します。これにより、各重みが二値だけで表現され、更新指示が正確ならば1ステップで最適値に収束します。

また、バイナリ重みは離散値であり既存の勾配による更新は不可能なため、バイナリ値を更新する新たな方法を導入します。具体的には、「FP32重みの勾配」と「バイナリ重みの反転」を相互に変換することで、更新信号が伝達されます。

勾配と反転を相互変換しながら逆伝播するため、既存のニューラルネットワークとBNNを一緒に学習できます。

反転逆伝播法のメリット

反転逆伝播法には以下のようなメリットがあります。

学習時の低VRAM使用量:学習時の重み・順伝播値・逆伝播値がバイナリ値であるため、少ないVRAMで学習を行うことができます。これにより、パラメータ数の多い巨大なモデルを学習する際に有利になります。

高精度なBNN:バイナリ重みを直接的に学習するため、高精度なBNNの学習が可能になる可能性があります。

高速な学習:バイナリ学習の1ステップで最適値に収束する特性により、従来のFP32ニューラルネットワークよりも少ないステップ数で学習が完了する可能性があります。

結論

反転逆伝播法は、既存のニューラルネットワークと一緒に学習可能な新たなBNN学習手法です。既存のpytorchフレームワークに組み込むことが可能であり、実装コストが低く運用しやすいという特徴があります。さらに、バイナリ重みを直接的に学習することで、パラメータ数の多い巨大なモデルの学習や高精度なBNNの学習、高速な学習に有利である可能性があります。

これにより、ニューラルネットワークの学習法に対する全面的な見直しが期待され、今後の研究に対する新たな方向性が示されました。

この記事が気に入ったらサポートをしてみませんか?