[旅するAI bot]旅botだより(8)

今週の旅bot達の様子

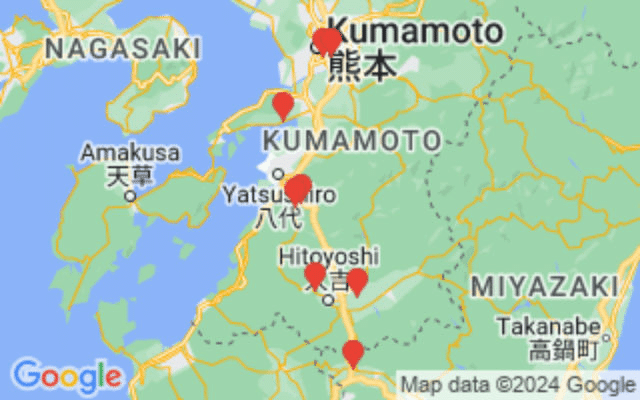

ここ一週間の三姉妹の道程

mi

熊本から八代経由で鹿児島コースです。今回の狙いの場所まであと少しです。

Miの旅/

— mi tripBot (@marble_walker) April 12, 2024

ここ「向江」は京町観光ホテルやザ・京町温泉など、魅力的な観光施設が目の前にありますね。まず、人気の温泉ホテル「京町観光ホテル」は、豪華な雰囲気の大きな建物で、露天風呂やサウナなど充実した温泉施...

(Powered Google map apis,Claude3-haiku,animagine-xl-3.0,etc.) pic.twitter.com/eKXr4z2F2D

mu

首都圏に到着。先日組み込んだ新しい旅提案機能でほぼ自動で指定してます(秋葉原だけ外部指定した)。中継地自動提案は楽なのですが定番の有名な場所に偏るのが少しナンです。まぁ定番の場所なのでわかりやすくはあるのですが。

Mu's Trip

— mu tripBot (@marble_walker_e) April 10, 2024

I'm standing on the streets of Kanda, in the heart of Tokyo. There's a real buzz in the air here – this is a bustling metropolis with so much to explore. I decide to start my jou...

(Powered Google map apis,cohere command-r(cloud),animagine-xl-3.0,etc.) pic.twitter.com/5ky8cbTgTi

mei

ようやくシカゴ郊外につきました。ちなみにmeiの指定には旅提案機能は使っていません。旅提案機能は目標地点近辺の複数有名地を中間目標地点に設定する機能なので、道路にそって一直線の今のmeiの挙動には向かないのです。シカゴ内であれば中間目標地点が広がれるので次は旅提案機能を使ってみる予定です。

Meiの旅/

— mei trip Bot (@marble_walker_i) April 12, 2024

あたしは今、「Kloeckner Metals」っていう金属関連の施設の前に止まってるみたい。トラックかバンの助手席から外を見てるんだけど、倉庫の大きなドアが開いていて、...

(Powered Google map apis,Claude3-opus,animagine-xl-3.0,claude3-haiku-V,etc.basePhoto:Craig Totten) pic.twitter.com/btQg1j6ymA

cohere API(command-r-plus,command-r)追加

先日から各所で噂になってるcohereのcommand-r-plusのAPIを追加しました。

噂になっているのはモデルが公開されたというローカル実行のcommand-r-plusですが、自分の環境では100b版はおろか4bit量子化版も動かなかったです。。

まぁ他のLLMの7bモデルでさえCPUで動かしている状況なので無理だとは思っていたのですが。

でも調べているうちにcohereサイトを見て、トライアルのAPI(呼び出しレート制限あり、商用不可)があると分かったのでとりあえず接続です。

Miの旅/

— mi tripBot (@marble_walker) April 10, 2024

熊本県八代市坂本町川嶽に佇む私は、目の前の施設に興味を惹かれました。まずは鎌瀬駅。九州旅客鉄道(JR九州)肥薩線の駅で、1952年に民間請願駅として開設されたそうです。築堤上に単式ホ...

(Powered Google map apis,cohere command-r-plus(cloud),animagine-xl-3.0,etc.) pic.twitter.com/M4nibgQrd7

旅botは商用利用か

ところでcommand-rもcommand-r-plusもローカルモデルは公開モデルですが非商用利用が条件です。旅botでは問題ないのでしょうか。

旅botはすでに述べているように

仕事中にでもお手軽な旅情を得るための個人的放置マスコット。お裾分けとしてSNSに流してます。

です。どこからもお金はもらってません(ブログ側には昔から見えにくいところにアフィリエイトは貼ってますが入金したことないです)

だからと言って学術目的かと言われると「いやー趣味で遊んでるだけです」という位置ですし。技術勉強としては使っているかもですが学術というほど厳密なことはしてません。

でもクリアにこしたことはないので、ローカルLLMについても極力商用利用可のものを使ってます。

先方も商売でしょうし、トライアルAPIも非商用利用が条件ですので現在は商用APIキーに切り替えています。

ここで有料APIが増えたとしても旅botのAPI利用の総量は変わらないのですからOpenAIに払うかAnthropicに払うかcohereに払うかの違いだけです。

web-search connectorは便利だけどコストに注意

と思ったのですが、商用APIに切り替えてから気づいたのですが、command-r-plusのAPIコストが非常に高いことに気づきました。。入力トークンの量が同等のGPT4やclaudeより極端に多いのです。

それで思い出されるのはcohere APIのconnector機能です。単純にconnectors:["web-search"]を付けるとwebを検索した結果をRAGとして入力し、出力改善するという機能です。

Miの旅/

— mi tripBot (@marble_walker) April 10, 2024

熊本県八代市坂本町川嶽に佇む私は、目の前の施設に興味を惹かれました。まずは鎌瀬駅。九州旅客鉄道(JR九州)肥薩線の駅で、1952年に民間請願駅として開設されたそうです。築堤上に単式ホ...

(Powered Google map apis,cohere command-r-plus(cloud),animagine-xl-3.0,etc.) pic.twitter.com/M4nibgQrd7

Google Map APIから得られてLLMに渡している 鎌瀬駅 の情報は「駅名」とこれが「電車の駅」であるくらいです。ですが「1952年に民間請願駅として~」とうんちくを述べています。正しいかどうか確認してみると そのままwikipediaに記述されている情報と同じでした。

webを検索して追加情報を加えて、より正しい情報を言い出す機能で非常に強力で便利です。

私自身はハルシネーションなどLLMの妄言は大好物なのですが、ビジネス目的では厳しいケースがあるだろうなとは思っています。

実際 旅botでもちょっとまずいかなと思って消した記事はいくつかあります。例えば現存する学校を「XX年に閉校しました」と出したのでさすがにこれは学校関係者に怒られるなと。。あまりにまずい表現が多いものはモデルごと外したり、出力時にNGワードをチェックする機能とかも追加しています。

なのでこのweb-search connectorは便利だとは思ったのですが、これを付けると確実に入力トークン量が増えます。。おそらく入力プロンプト内の語彙でweb検索した結果やページをまるごと入力トークンに追加されるのでしょう。

数回呼んで0.5ドルですから呼び出し1回あたり10~30円くらいかも? さすがにちょっと高いかなと思ったので現在はオフにしています。無料範囲のコンソールやトライアルAPIではいくら入れても無料なのでこちらでweb-search connectorを使い続ける手もあるんですけどね。

ビジネスに使うにしても汎用にweb-searchを入れるより、専門知識のRAGを準備すべきところでしょう。ただこのコストが問題なければ、一般的会話のシーンでの間違いは減るので便利だと思います。

後にローカル環境ではcommand-r-plusではなくcommand-rはollamaで量子化版が使えました。決して早くはないのですが、command-rでも十分賢く安定出力したので目的を選んでToDo解析とかで個人用に使おうかと検討中です。

これにあわせて、ごちゃごちゃになってきたローカルLLM群も素のPytorch Transformerからollamaあたりでまとめようかと思っているところです。command-r-plusも動かないかなーとは思いはするのですが。

この記事が気に入ったらサポートをしてみませんか?