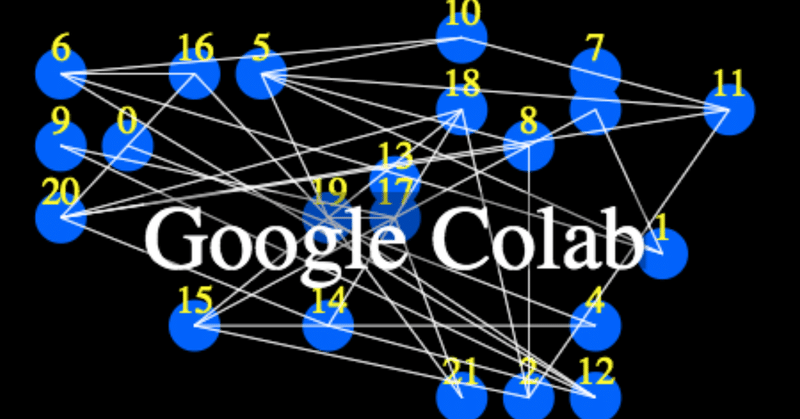

Google Colab

Sakura VPS (cpu : 1G) で 10 時間程かかっていた tensorflow の BERT の pretraining が Google Colab (GPU) で 10 分程だったので驚愕した。しかもなんと無料。これは、感覚としては麻薬かと思った。

GPU の上に TPU があると思うと理解が追いつかなかったが、TPU は有料であることで市場原理(収益化)にかなっているのかなと思えた。

さて、問題のプログラムモデルの成果は、3000 epoch から 15000 epoch にしたところ、probability が 0.051 から 0.059 に変わったが内容的変化を確認する手段を持っていない。プログラムモデルの過程を吐き出すプログラムも必要であるし、プログラム全体の再構成も不可欠である。

1. create_pretraining_data.py

<MASK> について、pretraining と fine-tuning での挙動の理解。

subword として、##ing や ##ed など単語レベルでの検討

2. run_pretraining.py

epoch や batch-size などの特徴量に対する、途中経過を把握したい。

attention の有効性の可視化。

3. Fine-tuning

Estimator の把握。

元データ(入力)から結果(出力)までの物語に面白さがある可能性。

その前に TPU を動かせるようにして、100000 epoch 回した後の probability や、本家 bert の pre-trained model で Fine-tuning の結果を見てみたい。TPU の利用について、参考になりそうなサイト https://medium.com/@oribarel/getting-the-most-out-of-your-google-colab-2b0585f82403

この記事が気に入ったらサポートをしてみませんか?