大型モデルは単なるデータの圧縮に過ぎないのか?

AIコミュニティ内では長い間、ニューラルネットワークの学習プロセスは単にデータセットの圧縮である可能性があるという見方があります。OpenAIも成功の核心は「圧縮」にあると公言しています。

最近、NeurIPS 2023の論文を読んでいて、興味深い論文が2つ見つかりました。そのうちの1つ「White-Box Transformers via Sparse Rate Reduction: Compression Is All There Is?」では、最新の研究結果が示されました:現在のAIシステム、GPT-4を含む、が行っているのは圧縮作業にすぎないというものです。数学的手法でこれを検証しました。

また、NeurIPS 2023の年間ベストペーパーである「Are Emergent Abilities of Large Language Models a Mirage?」も、人々が大型モデルの「創発的行動(emergent behavior)」について話すことを否定しています。この論文は、大型言語モデルの創発的行動は研究者が選んだ測定基準によって生じるものであり、モデルの振る舞いが規模拡大の中で根本的に変化するわけではないという代替的な説明を数学的手法で提供しています。

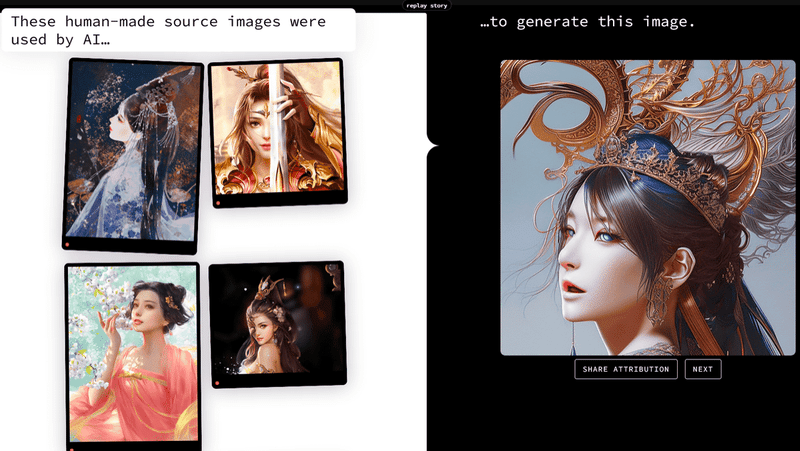

「Stable Attribution(https://www.stableattribution.com/、興味深いウェブサイト!)」というものもDiffusion Modelがデータを圧縮する過程についての「真実」を明らかにしようとしているようです。AIによって描かれた絵をStable Attributionに与えると、それがどの人間の作品を参考にしたかを即座に特定します。例えば、以下、右側のAIが生成した肖像画が左側の4枚の画像を参照しているとStable Attributionは判断します。

Stable Attributionのアルゴリズムの原理は、AIによって生成された画像をデコードし、Stable Diffusionモデルのトレーニングデータセットから類似のケースを見つけることです。そして、Stable Diffusionは公開されているデータセットLAION-5Bを使用しているため、探すのはそれほど難しくありません(この原理は本当に信頼できるのでしょうか?問題をあまりにも単純化しているように思えます。Stable AttributionにAIによって生成された画像以外を与えると、それでも自信を持って参照画像を表示します!)。

現在のAIが単なるデータの圧縮に過ぎないとすれば、その結果として学習されるのはデータの相関性や分布にすぎず、因果関係や論理的推論、抽象的な思考能力を本当に持っていないということになります。したがって、現在のAIはまだAGIではなく、最近では高次元で多様なデータを処理およびモデリングする能力において深層学習が実験的に大きな成功を収めています。しかし、その成功の大部分は、深層ネットワークが圧縮可能な低次元構造を効果的に学習し、その分布を簡潔な(つまり、コンパクトで構造化された)表現に変換する能力に帰因するものです。このような表現は、多くの視覚、分類、認識、セグメンテーション、生成などの下流タスクを支援するために使用されます。しかし、別の視点から見ると、人間の認知における重要な考え方の1つは抽象化であり、数学やデータの面から見るとそれは圧縮です。人間の脳の本質は実際には現実世界の圧縮写像に過ぎません。この点から見ると、人間の脳はChatGPTなどと何ら変わりがないのかもしれません。

この記事が気に入ったらサポートをしてみませんか?