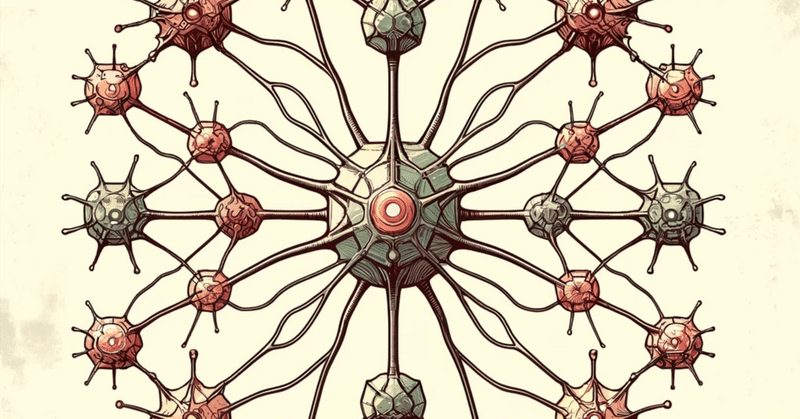

🧠パーセプトロンとニューロンの違い

パーセプトロンとニューロンは、人工知能と神経科学の文脈でそれぞれ使用される用語です。両者の間には類似点もありますが、明確な違いもあります。以下にその主な違いと類似点を示します:

定義:

パーセプトロン: これは人工知能の領域で提案された、最も基本的な形の人工ニューロンモデルです。入力に対して重みを掛け合わせ、それを合計して、活性化関数を適用することで出力を生成します。

ニューロン: これは生物の神経系に存在する細胞で、電気的および化学的信号を受け取り、処理し、送出します。

起源:

パーセプトロン: 1950年代にFrank Rosenblattによって考案された、機械学習アルゴリズムの原型です。

ニューロン: 生物の神経系において、情報処理と伝達の基本的な単位として機能する細胞です。

機能:

パーセプトロン: 複数の入力を受け取り、それらの重み付きの和を計算し、あるしきい値を超えるかどうかに基づいて1または0の出力を生成します。

ニューロン: 複数のデンドリットから信号を受け取り、それを細胞体で処理し、アクソンを通じて信号を送出します。ニューロンの活動のしきい値を超えると、アクションポテンシャルが発生し、情報が伝達されます。

類似点:

パーセプトロンのモデルは、生物のニューロンの働きを模倣するように設計されています。したがって、多くの概念(入力の受け取り、処理、出力の生成)が類似しています。

両者とも、複数の入力を受け取り、その入力に基づいて出力を生成する点で似ています。

複雑さ:

パーセプトロン: 単純なモデルであり、非線形の問題やXORのような問題を直接解くことはできません。

ニューロン: 生物のニューロンは非常に複雑で、多様なタイプ、機能、相互作用があります。

簡単に言えば、パーセプトロンは生物のニューロンの非常に単純化されたモデルであり、計算の文脈で使用されるものです。一方、ニューロンは生物の神経系に実際に存在する複雑な細胞です。

はい、単一のパーセプトロンではXORのような非線形問題を解くことはできませんが、複数のパーセプトロンを組み合わせて多層のニューラルネットワークを形成することで、非線形問題を解く能力が得られます。

このような多層のニューラルネットワークは「多層パーセプトロン」(MLP: Multi-Layer Perceptron)と呼ばれます。MLPは、一つ以上の隠れ層を持つフィードフォワード型のニューラルネットワークで、非線形の活性化関数(例: シグモイド、ReLUなど)を使用します。これにより、MLPは非線形の関数を近似する能力を持ちます。

バックプロパゲーションという学習アルゴリズムを用いて、MLPの重みを調整することで、非線形の問題に対する適切なモデルを学習することができます。

したがって、単一のパーセプトロンでは非線形問題を直接解くことはできませんが、複数のパーセプトロンを組み合わせて形成されるMLPを使用することで、非線形問題を解くことが可能となります。

多層パーセプトロン(MLP: Multi-Layer Perceptron)とディープラーニングは関連がありますが、いくつかの違いやニュアンスがあります。

定義と範囲:

多層パーセプトロン (MLP): MLPはフィードフォワード型のニューラルネットワークで、一つ以上の隠れ層を持つものを指します。非線形の活性化関数を使用して、非線形の関数を近似することができます。

ディープラーニング: ディープラーニングは深いニューラルネットワーク、つまり多数の隠れ層を持つネットワークを学習する手法の一部を指します。ディープラーニングには、畳み込みニューラルネットワーク (CNN)、リカレントニューラルネットワーク (RNN)、トランスフォーマーアーキテクチャなど、多様なモデルやアーキテクチャがあります。

深さ:

MLPは「多層」という名前の通り、複数の層を持ちますが、ディープラーニングの文脈で「深い」とされるネットワークよりも層の数が少ないことが一般的です。

ディープラーニングのネットワークは、しばしば多数の隠れ層を持ち、非常に深い構造を持つことが特徴です。

適用範囲:

MLPは一般的な分類や回帰タスクに使われることが多いです。

ディープラーニングのモデルは、画像認識、音声認識、機械翻訳、ゲーム、強化学習など、多様なタスクやアプリケーションに対して適用されます。

総じて、MLPはディープラーニングの範疇に含まれる基本的なニューラルネットワークの一種ですが、ディープラーニングはその範囲や適用範囲が広く、多様なモデルやアーキテクチャを持っています。

フィードフォワード型のニューラルネットワークは、その名前が示す通り、情報が一方向に「フォワード」に流れるネットワークのタイプを指します。以下に、フィードフォワード型のニューラルネットワークの主な特徴と概念を説明します:

一方向のデータフロー: ネットワークの入力から出力へのデータの流れは一方的です。つまり、サイクルやループは存在しません。

層の構成: 一般的に、フィードフォワード型のネットワークは以下の3つの主要な層から成り立っています:

入力層: ネットワークへのデータの入力を受け取る層。

隠れ層: 一つまたはそれ以上の中間的な層。ここでのニューロンは、入力層からの情報を受け取り、それを処理し、次の層へと情報を伝達します。

出力層: 最終的な予測や分類結果を生成する層。

活性化関数: フィードフォワード型のネットワークの各ニューロンは、活性化関数を持ちます。この関数は、ニューロンの出力を決定する役割を果たします。一般的に使用される活性化関数には、シグモイド、ハイパボリックタンジェント、ReLU (Rectified Linear Unit) などがあります。

学習: フィードフォワード型のネットワークは、通常、バックプロパゲーションという手法を用いて学習します。バックプロパゲーションは、ネットワークの出力と真のラベルとの間の誤差を計算し、この誤差を逆伝播させて、各ニューロンの重みを調整します。

用途: フィードフォワード型のネットワークは、分類や回帰のような多くの基本的な機械学習タスクに適用されます。

リカレントニューラルネットワークとの違い: フィードフォワード型のネットワークと対照的に、リカレントニューラルネットワーク (RNN) は、ネットワーク内でのデータの循環を許容することが特徴です。これにより、時系列データやテキストなどの連続したデータを処理する際に、以前の情報を保持することが可能になります。

フィードフォワード型のニューラルネットワークは、そのシンプルな構造と理解しやすさから、多くの機械学習の初学者にとって、ニューラルネットワークの基本的な概念を学ぶ上での出発点として選ばれることが多いです。

まず、基本的な多層パーセプトロン(MLP)はフィードフォワード型のニューラルネットワークです。情報は入力層から隠れ層を通じて出力層に一方向に流れます。

トランスフォーマーアーキテクチャは、NLP (自然言語処理) のタスクにおいて非常に人気のあるモデルです。トランスフォーマーは、自己注意メカニズムと呼ばれる特殊な構造を持っており、このメカニズムによってシーケンス内のすべての単語が他のすべての単語との関係を学習することができます。

トランスフォーマーはフィードフォワード型のネットワークではありますが、一般的なMLPとは異なる構造と機能を持っています。トランスフォーマーアーキテクチャは、エンコーダとデコーダのスタックから構成されており、自己注意メカニズムや位置エンコーディングなどの特殊な機能を持っています。

したがって、トランスフォーマーは、フィードフォワード型のネットワークの一種ですが、通常の多層パーセプトロンとは異なる特殊な構造を持っています。

フィードフォワードでないニューラルネットワークの代表的なものはリカレントニューラルネットワーク(RNN)です。RNNは、前のステップの情報を次のステップへと伝える能力を持っています。そのため、時系列データやテキストなどの連続したデータを扱うのに適しています。RNNの派生として、以下のようなモデルがあります。

LSTM (Long Short-Term Memory): 長期的な依存関係を学習するためのゲート機構を持つRNNの一種です。

GRU (Gated Recurrent Unit): LSTMの簡略化されたバージョンで、ゲートの数が少なくなっています。

トランスフォーマーアーキテクチャについて考えると、基本的にはフィードフォワード型のネットワークです。ただし、トランスフォーマーの自己注意メカニズムは、入力シーケンス内のすべての位置に対して同時に計算されるため、ある意味で「全位置からの情報」を一度に利用しています。この特性は、時系列の依存関係を捉えるRNNとは異なるアプローチです。

したがって、トランスフォーマーはフィードフォワード型のアーキテクチャでありながら、自己注意メカニズムを介してRNNのようなシーケンシャルな情報の取得能力を持っています。しかし、厳密に言えば、トランスフォーマーは「フィードフォワードでないニューラルネットワーク」とは言えません。

お願い致します